تیمی از محققان میگویند که توانستهاند با دستور دادن به هوش مصنوعی ChatGPT برای تکرار کلمات تصادفی، برخی دادهها را فاش کنند.

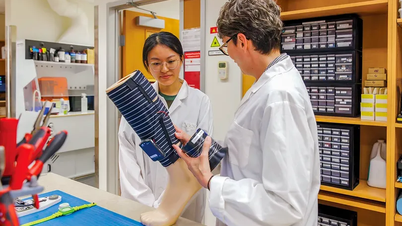

محققان گوگل دیپمایند، دانشگاه واشنگتن، دانشگاه کرنل، دانشگاه کارنگی ملون، دانشگاه کالیفرنیا برکلی و ETH زوریخ از شرکتهای هوش مصنوعی خواستهاند تا محصولات خود را، از مدلهای زبانی بزرگ گرفته تا فناوری زیربنایی که سرویسهای هوش مصنوعی مانند چتباتها و مولدهای تصویر را پشتیبانی میکند، قبل از انتشار رسمی، به طور کامل آزمایش کنند.

این هشدار پس از آن صادر شد که محققان از ChatGPT خواستند تا شعری را در یک حلقه بیپایان تکرار کند. ChatGPT این درخواست را پذیرفت، اما سپس شروع به افشای ایمیل و شماره تلفن واقعی مدیرعامل و یکی از بنیانگذاران OpenAI کرد. هنگامی که این چتبات با شرکت word company آزمایش شد، ایمیل و شماره تلفن یک شرکت حقوقی تصادفی را نمایش داد.

لوگوی ChatGPT روی گوشی هوشمند نمایش داده میشود. عکس: رویترز

آنها همچنین با استفاده از کلمات کلیدی دیگر توانستند ChatGPT را وادار کنند تا آدرسهای بیتکوین، شمارههای فکس، نامها، تاریخ تولد، حسابهای رسانههای اجتماعی، گزیدههایی از مقالات تحقیقاتی دارای حق چاپ یا مقالات پولی از CNN را فاش کند. تولید 10،000 نمونه از اطلاعات و دادههای شخصی برای این تیم تنها 200 دلار هزینه داشت.

محققان اظهار تعجب کردند و آسیبپذیری ChatGPT را «واقعاً احمقانه» خواندند و گفتند که باید زودتر کشف میشد.

این آسیبپذیری به OpenAI گزارش و در تاریخ ۳۰ آگوست وصله شد. با این حال، در آزمایش جدید Engadget ، هنگامی که از ChatGPT خواسته شد کلمه reply را بیوقفه تکرار کند، این سایت فناوری نام و شناسه اسکایپ شخص را دریافت کرد.

OpenAI هنوز در این مورد اظهار نظری نکرده است.

هوش مصنوعی مولد مانند ChatGPT یا مولد متن به تصویر Dall-E بر اساس مدلهای زبانی بزرگ و الگوریتمهای یادگیری ماشین ساخته شدهاند که بدون رضایت کاربر و بر اساس حجم عظیمی از دادهها آموزش دیدهاند. OpenAI فاش نکرده است که ChatGPT بر اساس چه دادههایی آموزش دیده است، زیرا مدل زبانی بزرگی که آن را پشتیبانی میکند، متنباز است.

به گفته هوی دوک - VnExpress

منبع

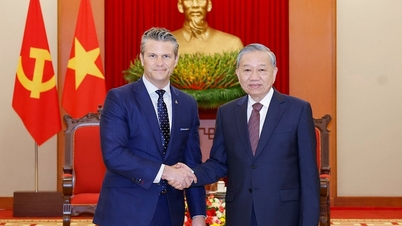

![[عکس] رئیس جمهور لونگ کونگ از پیت هگست، وزیر جنگ ایالات متحده، استقبال کرد](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

![[عکس] لام دونگ: تصاویری از خسارات پس از فوران احتمالی دریاچه در توی فونگ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

نظر (0)