بر اساس تجربه در بسیاری از کشورها و اصول یونسکو، ویتنام در حال تدوین مقرراتی برای توسعه هوش مصنوعی (AI) به صورت اخلاقی و مسئولانه است.

در کارگاه «توسعه و کاربرد مسئولانه هوش مصنوعی: نظریه و عمل» که صبح روز 28 فوریه در دانشگاه حقوق VNU برگزار شد، معاون وزیر علوم و فناوری، آقای بوی دِ دوی، گفت که اخلاق هوش مصنوعی یک مسئله پیچیده و جهانی است که بسیاری از کشورها و سازمانها در سراسر جهان، از جمله یونسکو، را برای مشارکت در یافتن راهحلها جذب میکند.

او گفت: «یونسکو سازمانی است که بر فرهنگ و آموزش تمرکز دارد. با این حال، برای اولین بار، این سازمان هوش مصنوعی - یک موضوع مرتبط با فناوری - را در بحث خود گنجانده است. این اقدام حتی باعث شده برخی از کشورهایی که از این سازمان خارج شده بودند، تصمیم به بازگشت به آن بگیرند.»

به گفته معاون وزیر، اخلاق هوش مصنوعی بر بسیاری از جنبههای زندگی مانند جامعه، قانون، رقابت سیاسی و رقابت تجاری تأثیر میگذارد. برای توسعه مسئولانه هوش مصنوعی، مدیریت باید از مرحله تعریف مدلهای هوش مصنوعی، جمعآوری دادهها تا تکمیل سیستم و بهکارگیری آن جدی گرفته شود. در واقعیت ویتنام، این فرآیند نیاز به هماهنگی مهندسان، دانشمندان و سازمانهای مدیریتی مانند وزارت علوم و فناوری، وزارت اطلاعات و ارتباطات و وزارت امنیت عمومی دارد.

آقای دوی همچنین در این کارگاه گفت که اصول یونسکو مبنایی برای کشورها جهت تدوین مقررات در مورد اخلاق هوش مصنوعی است. اول، مدل هوش مصنوعی باید با طراحی و وظایف تعیین شده از ابتدا مطابقت داشته باشد تا اطمینان حاصل شود که هیچ اقدام مخربی که به انسان آسیب برساند، انجام نمیشود.

او گفت: «هوش مصنوعی کاملاً با فناوریهایی که انسانها روی آنها تحقیق کردهاند متفاوت است. در حالی که محصولات فناوری قدیمی فقط اهداف موجود را دنبال میکنند، هوش مصنوعی میتواند مسیرهای جدیدی ایجاد کند که خارج از کنترل توسعهدهنده است.» معاون وزیر همچنین مثالی از موردی زد که دانشمندان اجازه دادند دو سیستم کامپیوتری به زبان انگلیسی صحبت کنند. با این حال، پس از مدتی، آنها ناگهان به زبانی عجیب برای برقراری ارتباط روی آوردند و درک محتوای مکالمه را برای تیم تحقیقاتی غیرممکن کردند.

مسئله برابری و انصاف نیز هنگام ساخت یک مدل هوش مصنوعی مورد توجه است. به گفته آقای دوی، درست از مرحله جمعآوری اطلاعات برای آموزش هوش مصنوعی، نابرابری میتواند رخ دهد و بر کل سیستم تأثیر منفی بگذارد.

او با مدل تشخیص صدای هوش مصنوعی گفت که اگر منبع دادهها فقط از مردم هانوی جمعآوری شود، سیستم هنگام تعامل با افراد از مناطق دیگر جانبدارانه عمل خواهد کرد. او گفت: «به طور کلی، منابع دادههای هوش مصنوعی میتوانند باعث بیعدالتی بین جنسیتها و گروههای جامعه، مانند افراد دارای معلولیت، شوند.» بنابراین، برای توسعه منصفانه هوش مصنوعی، علاوه بر مشارکت کارشناسان حقوقی، به مشارکت روانشناسان و جامعهشناسان نیز نیاز است.

علاوه بر این، نماینده وزارتخانه همچنین بر برخی از اصول مهم اخلاق هوش مصنوعی مانند تضمین امنیت دادههای شخصی، احترام به حق چاپ، حقوق مالکیت معنوی، بهبود بهرهوری نیروی کار اما لزوم حفاظت از محیط زیست و امنیت اجتماعی تأکید کرد.

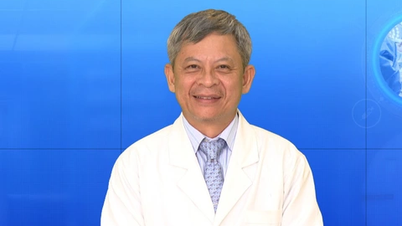

معاون وزیر، بویی دِ دوی، در این کارگاه سخنرانی میکند. عکس: هوانگ گیانگ

در این کارگاه، کارشناسان گفتند که ویتنام در حال نظارت بر اجرای مقررات مربوط به توسعه مسئولانه هوش مصنوعی در بسیاری از کشورها و مناطق جهان است تا بتواند چارچوب قانونی مناسب با رویههای داخلی را تحقیق و ایجاد کند.

به طور خاص، در پایان سال ۲۰۲۳، اتحادیه اروپا اصول قانون هوش مصنوعی را تصویب کرد که انتظار میرود حداکثر تا سه ماهه دوم سال ۲۰۲۴ منتشر شود. این قانون در حال حاضر اولین و جامعترین قانون است که ابتکارات زیادی برای مقابله با خطرات ناشی از هوش مصنوعی دارد.

دکتر دو جیانگ نام، از دانشگاه حقوق VNU، در این کارگاه گفت: «قانون هوش مصنوعی ۲۰۲۴ بر اساس خطرات مدلهای هوش مصنوعی تنظیم خواهد شد تا قانون بر اساس آن، همراه با یک محیط آزمایشی و رویکردی «نرمتر» به اخلاق، قابلیت اطمینان و مسئولیتپذیری، تنظیم شود.» به گفته وی، تجربه قانون هوش مصنوعی که ویتنام میتواند به کار گیرد، «نه برای تدوین یک قانون برای همیشه، بلکه برای بهروزرسانی مداوم و سازگاری با توسعه فناوری هوش مصنوعی» است.

برخلاف اروپا، ایالات متحده برای توسعه مدیریت هوش مصنوعی به بخش خصوصی چشم دوخته است. ایالات متحده همچنین کشوری است که بیشترین دعاوی حقوقی علیه شرکتهای هوش مصنوعی را دارد که عمدتاً مربوط به نقض حریم خصوصی و تبعیض بین گروههای کارگری است. به گفته کارشناسان، ایالات متحده به جای مجموعهای ثابت از قوانین، تمایل دارد اصول زیادی را وضع کند تا سازمانها و افراد بتوانند در فرآیند توسعه و بهکارگیری مدلهای هوش مصنوعی انعطافپذیر باشند.

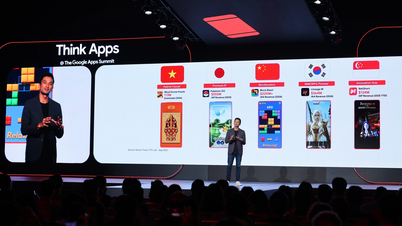

چین و ژاپن نیز دو کشوری هستند که در توسعه هوش مصنوعی مسئولانه گامهای بلندی برداشتهاند. از سال ۲۰۱۹، این کشور با یک میلیارد نفر جمعیت، چهار اصل را با تمرکز بر مدلسازان، کاربران، حاکمیت هوش مصنوعی و جهتگیریهای توسعه هوش مصنوعی در آینده منتشر کرده است. بر این اساس، چین تصمیم گرفته است که هم هوش مصنوعی را به صورت مستقل توسعه دهد و هم حاکمیت داخلی را ارتقا دهد، در حالی که ژاپن در تلاش است تا یک آییننامه رفتاری هوش مصنوعی انسانمحور تدوین کند و در عین حال مشارکت در مجامع بینالمللی را تضمین کند.

دکتر نگوین تی کو آن، دانشیار و مدیر دانشگاه حقوق دانشگاه ملی ویتنام، گفت: «فرآیند مدیریت هوش مصنوعی در کشورهایی که در منطقه چین و ژاپن قرار دارند، میتواند تجربهای برای توسعه مسئولانه هوش مصنوعی در ویتنام باشد. علاوه بر قانونگرایی، مسئولیت در اینجا مسئولیت در قبال جامعه و مردم نیز هست.» علاوه بر این، ویتنام در حال تدوین قانون صنعت فناوری دیجیتال است که شامل مطالبی در مورد اخلاق محصولات دیجیتال، از جمله هوش مصنوعی، میشود.

هوانگ گیان

لینک منبع

![[عکس] معماری بینظیر عمیقترین ایستگاه مترو در فرانسه](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763107592365_ga-sau-nhat-nuoc-phap-duy-1-6403-jpg.webp)

![[عکس] هنر منحصر به فرد نقاشی ماسکهای توئونگ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763094089301_ndo_br_1-jpg.webp)

![[عکس] کلاس ویژه در ترا لین](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763078485441_ndo_br_lop-hoc-7-jpg.webp)

نظر (0)