Jennifer DeStefano a été stupéfaite lorsqu'elle a entendu une voix appelant à l'aide qui ressemblait exactement à celle de sa fille aînée Brianna, 15 ans. Après enquête, tout cela n'était qu'une arnaque avec l'aide de l'IA.

L'après-midi du 20 janvier, le téléphone de Jennifer DeStefano a sonné alors qu'elle sortait de sa voiture, devant le studio de danse où sa fille Aubrey s'entraînait. L'appelant était inconnu, et DeStefano avait prévu de ne pas répondre.

Mais sa fille aînée, Brianna, 15 ans, s'entraînait pour une course de ski. DeStefano craignait qu'il s'agisse d'un appel d'urgence.

« Allô ? » répondit-elle sur haut-parleur en verrouillant sa voiture, en attrapant son sac à main et sa sacoche d'ordinateur et en se dirigeant vers la salle de sport. Soudain, DeStefano entendit des cris et des sanglots.

|

Jennifer DeStefano et ses deux filles. Photo : NVCC. |

« Maman, j'ai des ennuis ! » cria une voix de fille. « Qu'as-tu fait ? Que se passe-t-il ? » demanda aussitôt la mère à son interlocuteur.

Moment de panique

DeStefano a déclaré à CNN que sa voix ressemblait exactement à celle de Brianna, de l'accent à tout. « J'ai cru qu'elle avait glissé de la montagne, ce qui arrive quand on skie. Alors j'ai commencé à paniquer », a raconté DeStefano.

Les cris continuèrent et une voix masculine grave commença à ordonner : « Écoutez. Votre fille est entre mes mains. Si vous appelez la police ou qui que ce soit, je lui injecterai une dose de drogue. Je l'emmènerai au Mexique et vous ne reverrez plus jamais votre fille. »

DeStefano fut instantanément paralysée. Puis elle courut dans le gymnase, tremblante et criant à l'aide. Elle eut l'impression de se noyer.

|

DeStefano a vécu un moment terrifiant lorsqu'une voix qui ressemblait à celle de Brianna a appelé à l'aide au téléphone. Photo : Jennifer DeStefano. |

Une série d'événements chaotiques s'ensuivit. Les ravisseurs réclamèrent rapidement une rançon d'un million de dollars , et DeStefano décida d'appeler la police. Après de nombreuses tentatives pour joindre Brianna, l'enlèvement fut révélé.

Il s'avéra que tout cela n'était qu'une arnaque. Brianna, confuse, appela sa mère pour lui dire qu'elle n'avait aucune idée de ce qui se passait, alors que tout allait bien pour elle.

Mais pour DeStefano, elle n'oubliera jamais cet appel terrifiant de quatre minutes, avec cette voix étrange.

DeStefano pense avoir été victime d'une arnaque par enlèvement virtuel par téléphone utilisant une technologie de deepfake. Grâce à cette technologie d'IA, les ravisseurs effraient la famille de la victime avec un son modifié pour ressembler à la voix de la victime et exigent une rançon.

Le côté obscur de l'IA

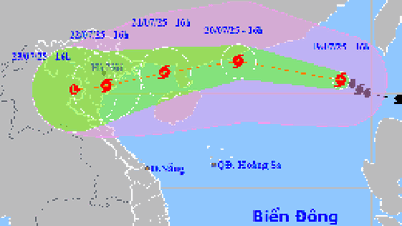

Selon Siobhan Johnson, porte-parole du Federal Bureau of Investigation (FBI), en moyenne, les familles aux États-Unis ont perdu environ 11 000 dollars pour chaque appel frauduleux.

|

En moyenne, les familles américaines perdent environ 11 000 dollars par appel frauduleux. Photo : Matthew Fleming. |

En 2022, les données de la Federal Trade Commission (FTC) des États-Unis ont montré que les Américains ont perdu un total de 2,6 milliards de dollars à cause d'appels frauduleux.

Dans un enregistrement de l'appel de DeStefano fourni à CNN par le département de police de Scottsdale, une mère au studio de danse tente d'expliquer au répartiteur ce qui se passe.

« Une mère vient d'entrer et a reçu un appel téléphonique de sa fille. Un ravisseur lui a dit qu'il voulait un million de dollars. Il ne la laissait pas parler à sa fille », a raconté la personne qui a appelé.

En arrière-plan, on entend DeStefano crier : « Je veux parler à ma fille. » Le répartiteur a immédiatement déterminé qu'il s'agissait d'un canular.

En fait, les appels frauduleux sont monnaie courante aux États-Unis. Il arrive que des personnes âgées soient contactées, prétendant que leurs petits-enfants ont eu un accident et ont besoin d'argent pour une opération chirurgicale.

Le point commun de cette méthode est que les faux ravisseurs utilisent souvent des enregistrements de cris de foule.

Cependant, les autorités fédérales américaines avertissent que ces escroqueries deviennent de plus en plus sophistiquées grâce à la technologie deepfake qui usurpe la voix des victimes pour gagner la confiance de leurs connaissances et les escroquer ensuite.

|

Les escroqueries par extorsion gagnent en sophistication grâce à la technologie deepfake qui imite la voix de la victime pour gagner la confiance de ses connaissances et escroquer de l'argent. Photo : Protocol |

Le développement de programmes d’IA bon marché et accessibles a permis aux escrocs de cloner librement des voix et de créer des conversations qui ressemblent exactement à l’original.

« Cette menace n'est pas seulement hypothétique. Nous voyons des fraudeurs utiliser ces outils comme des armes. Ils peuvent créer un clone vocal relativement fiable avec moins d'une minute d'audio. Pour certains, même quelques secondes suffisent », a déclaré Hany Farid, professeur d' informatique à l'Université de Californie à Berkeley.

Grâce à un logiciel d’IA, l’usurpation d’identité vocale peut être réalisée pour seulement 5 $ par mois et est facilement accessible à tous, a déclaré Farid.

La FTC a également émis un avertissement en mars selon lequel les escrocs pourraient récupérer des fichiers audio à partir des vidéos des réseaux sociaux des victimes.

L'utilisation de l'intelligence artificielle pour insérer des visages ou de fausses voix dans des vidéos, communément appelées deepfakes, devient de plus en plus courante et dangereuse. C'est un réel danger sur Internet.

Outre les vidéos sensibles, les deepfakes peuvent également causer de graves dommages s'ils sont utilisés à des fins politiques . La vidéo du visage morphing de l'ancien président américain Barack Obama, devenue virale en 2018, a montré que des personnalités politiques de premier plan peuvent également en être victimes.

En 2019, c'était au tour de Nancy Pelosi, présidente de la Chambre des représentants des États-Unis, d'en être victime. Une vidéo montée la montrait en état d'ébriété, son discours étant confus.

|

Les deepfakes ne servent pas seulement à combiner des vidéos pornographiques, mais suscitent également des inquiétudes quant aux fausses nouvelles avant des moments importants comme l'élection présidentielle américaine fin 2020. Photo : Cnet. |

Fin 2019, l'État américain de Californie a adopté une loi interdisant la création et le partage de vidéos deepfake. Cette loi stipule expressément que les vidéos modifiées contenant des images, des vidéos ou des voix de politiciens dans les 60 jours précédant une élection sont illégales.

En 2019, deux chercheurs des Nations Unies (ONU), Joseph Bullock et Miguel Luengo-Oroz, ont déclaré que leur modèle d’IA, formé sur des textes de Wikipédia et plus de 7 000 discours de l’Assemblée générale, pouvait facilement falsifier les discours des dirigeants mondiaux.

L’équipe affirme qu’il n’a fallu fournir à l’IA que quelques mots pour générer un texte cohérent et de « haute qualité ».

Par exemple, lorsque les chercheurs ont titré « Le Secrétaire général condamne fermement les attaques terroristes meurtrières à Mogadiscio », l’IA a pu générer un discours exprimant son soutien à la décision de l’ONU.

Lien source

![[Photo] Le président de l'Assemblée nationale, Tran Thanh Man, rend visite à la mère héroïque vietnamienne, Ta Thi Tran](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/7/20/765c0bd057dd44ad83ab89fe0255b783)

Comment (0)