|

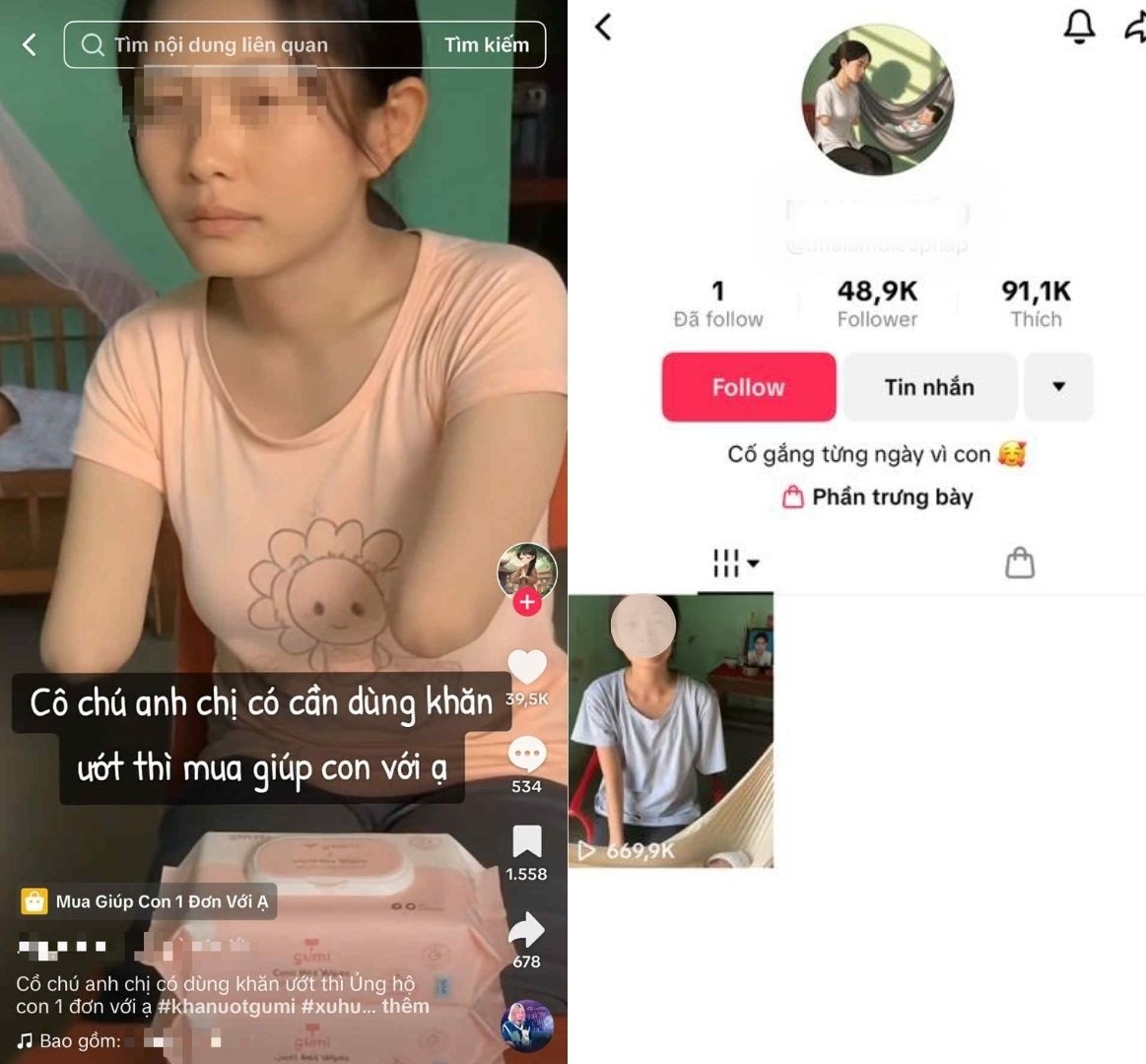

विक्रेता का रूप धारण करने के लिए AI का उपयोग करने वाला अकाउंट। फोटो: TikTok । |

हाल के दिनों में उन्नत एआई उपकरणों की एक श्रृंखला के आगमन के साथ, कुछ ही कमांड से फ़ोटो और वीडियो बनाना बहुत आसान हो गया है। हालाँकि, इंटरनेट उपयोगकर्ताओं की असली और नकली में अंतर करने की क्षमता इस विकास के साथ नहीं बढ़ पाई है, और कुछ लोगों ने अपने लाभ के लिए इसका भरपूर फायदा उठाया है।

हाल ही में, सोशल मीडिया पर एक टिकटॉक अकाउंट खूब वायरल हो रहा है, जिसमें एक महिला के दोनों हाथ कटे हुए हैं और उसे अपने छोटे बच्चों का पालन-पोषण करने के लिए सामान बेचना पड़ रहा है। क्लिप में, यह महिला साधारण कपड़े पहनती है, सहानुभूतिपूर्वक बात करती है और पेपर टॉवल और डिटर्जेंट जैसे उत्पादों का परिचय देती है।

रिकॉर्ड के अनुसार, महिला ने अपने पति की एक दुर्घटना में असमय मृत्यु और अकेले ही एक छोटे बच्चे की परवरिश की स्थिति के बारे में बताया, लेकिन वीडियो में यह कहानी एक जैसी नहीं थी। चैनल बनाने के तीन दिनों के भीतर ही इस अकाउंट को लाखों से ज़्यादा बार देखा गया और इसके 1,00,000 फ़ॉलोअर्स बढ़ गए। कई लोगों ने सहानुभूति व्यक्त की, मदद की गुहार लगाई और मदद के लिए उत्पाद भी मंगवाए।

उपयोगकर्ताओं को लगातार ऐसी ही सामग्री वाले अकाउंट मिलते रहते हैं। इन चैनलों में एक समानता यह है कि ये नए बनाए गए निजी पेज हैं, इनका कोई वास्तविक इंटरैक्शन इतिहास नहीं है, और अक्सर ये अत्यधिक भावनात्मक सामग्री साझा करते हैं।

|

ये चैनल प्रायः नये होते हैं और इनका प्रोफाइल स्पष्ट नहीं होता। |

हालाँकि, कुछ समय बाद, नेटिज़न्स को हर वीडियो में कुछ असामान्य और असंगति नज़र आई। जैसे, महिला का कटा हुआ हाथ बहुत चिकना दिख रहा था, घर की दीवारों का रंग अलग था, या बच्चा असामान्य रूप से स्थिर पड़ा था। इसकी वजह यह थी कि सभी क्लिप दूसरों को बेवकूफ़ बनाने के लिए AI द्वारा बनाए गए थे।

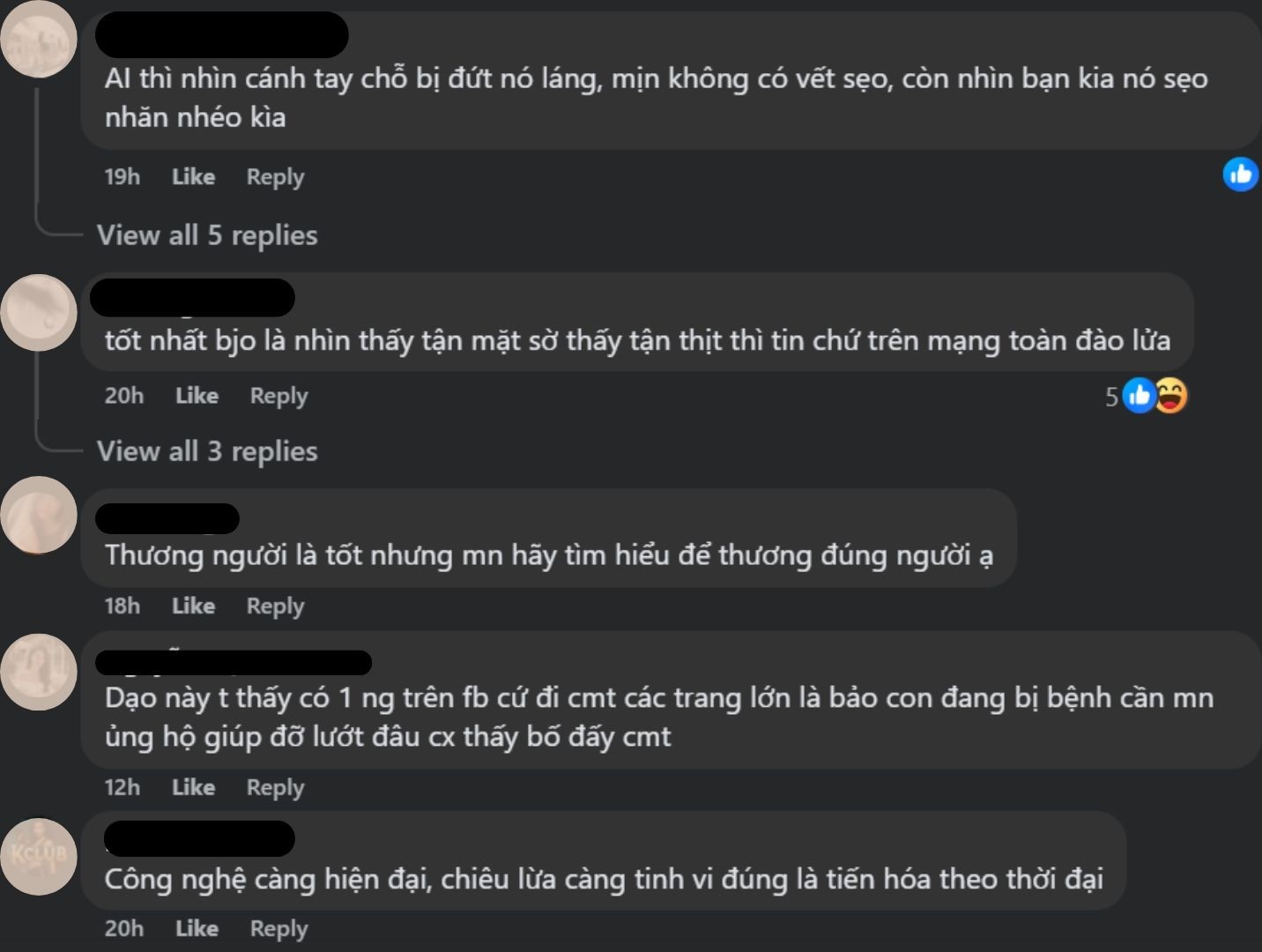

गौर करने वाली बात यह है कि चेतावनी या उजागर करने वाली टिप्पणियाँ अकाउंट मालिक द्वारा छिपा दी गईं या हटा दी गईं। कई लोगों को धोखा दिए जाने पर बुरा लगा, साथ ही लोगों की सहानुभूति का फायदा उठाने के इस व्यवहार पर भी गुस्सा आया।

इसके अलावा, ये फ़र्ज़ी वीडियो उन मालिकों और अन्य विकलांग लोगों को भी प्रभावित करते हैं जो उसी प्लेटफ़ॉर्म से अपनी आजीविका कमा रहे हैं। फु थो में रहने वाली सुश्री ट्रान थी नगा (36 वर्ष), जो नगा टिच क्यूक चैनल की मालकिन हैं, को लगातार यह कहना पड़ा कि उनका एक हाथ सचमुच कटा हुआ था।

2024 के अंत में, इस व्यक्ति को तीव्र वायरल मायोकार्डिटिस हो गया और उसे अपने सभी अंग काटने पड़े, और उसे अपने परिवार के प्यार के साथ एक नई ज़िंदगी शुरू करनी पड़ी। हाल ही में एक लाइवस्ट्रीम में, उसने शक किए जाने और कठोर शब्दों का सामना करने पर अपना दुख व्यक्त किया।

इन नए बने चैनलों ने भी तेज़ी से बड़ी संख्या में फ़ॉलोअर्स हासिल कर लिए, जिससे उनमें अंतर करना मुश्किल हो गया। NLS नाम के एक और अकाउंट के, जिसकी सामग्री भी ऐसी ही थी, सिर्फ़ एक वीडियो के बाद ही लगभग 50,000 फ़ॉलोअर्स बढ़ गए।

|

उपयोगकर्ताओं ने धोखा दिए जाने पर आक्रोश और विश्वास की हानि व्यक्त की। |

इसलिए, ऑनलाइन समुदाय को धीरे-धीरे अपनी देखी हुई चीज़ों पर विश्वास खोने और इस तरह उन लोगों की परवाह न करने के लिए दोषी ठहराना संभव नहीं है जिन्हें सचमुच मदद की ज़रूरत है। एक टिप्पणी में कहा गया है कि जो लोग समुदाय की भावनाओं का शोषण करने के लिए एआई तकनीक का इस्तेमाल करते हैं, उनकी निंदा की जानी चाहिए।

साइबर धोखाधड़ी की योजनाएँ तेज़ी से परिष्कृत होती जा रही हैं, और इनका निशाना कम संपर्क वाले लोग या बुज़ुर्ग होते हैं। ज़्यादातर खाताधारक अस्पताल में भर्ती या विकलांगता जैसी किसी मानसिक परेशानी से जूझ रहे लोगों की तस्वीरें इस्तेमाल करते हैं, फिर शॉपिंग कार्ट लगाते हैं या मदद के लिए फ़ोन करने के लिए खाता संख्या छोड़ देते हैं।

इससे पहले, सीएनबीसी ने 30 से ज़्यादा इंस्टाग्राम, यूट्यूब और टिकटॉक अकाउंट्स का पता लगाया था जो डाउन सिंड्रोम से पीड़ित लोगों का रूप धारण करने के लिए एआई का इस्तेमाल कर रहे थे। ये लोग फॉलोअर्स को आकर्षित करने और सामुदायिक धन उगाहने का आह्वान करने के लिए दिल दहला देने वाली कहानियों का इस्तेमाल कर रहे थे, लेकिन असल में उन्होंने इन अकाउंट्स को अपने लिए हथिया लिया था।

यह घटना इस संभावना की ओर इशारा करती है कि एआई की यथार्थवादी सामग्री को पुन: प्रस्तुत करने की क्षमता का दुरुपयोग कुछ शरारती तत्वों द्वारा किया जा सकता है। जैसे-जैसे तकनीक तेज़ी से विकसित हो रही है, उपयोगकर्ताओं को इसे लोकप्रिय बनाने के साथ-साथ अपने प्रियजनों को ऑनलाइन धोखाधड़ी का शिकार होने से बचाने में भी मदद करनी होगी।

स्रोत: https://znews.vn/video-nghi-ai-gia-nguoi-khuet-tat-ban-hang-gay-buc-xuc-post1598306.html

![[फोटो] प्रधानमंत्री फाम मिन्ह चीन्ह निजी आर्थिक विकास पर संचालन समिति की दूसरी बैठक की अध्यक्षता करते हुए।](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

![[फोटो] लाम डोंग: तुय फोंग में एक संदिग्ध झील के फटने के बाद हुए नुकसान की तस्वीरें](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

टिप्पणी (0)