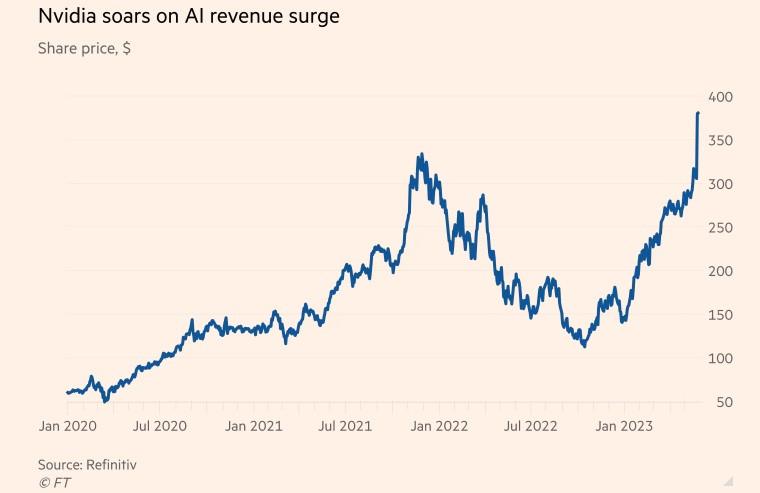

Az Nvidia egykor a videojátékokban használt chipek gyártójaként volt ismert, de az utóbbi években az adatközpontok piacára helyezte át a figyelmét.

Az amerikai chipgyártó cég virágzott a világjárvány alatt, mivel a játékok és a felhőalkalmazások iránti kereslet megnőtt, és a kriptovaluta-bányászati őrület világszerte elterjedt. A január 29-én véget ért pénzügyi év végére az adatközponti chipek üzletága a vállalat bevételének több mint 50%-át tette ki.

Eközben a népszerű chatbot, a ChatGPT idén a következő szintre emelte a generatív mesterséges intelligenciát (MI), nagy mennyiségű meglévő adatot felhasználva új tartalmak létrehozására a költészettől a számítógépes programozásig terjedő témákban.

A Microsoft és az Alphabet, két technológiai óriás, szintén nagy szereplők a mesterséges intelligencia területén, mivel úgy vélik, hogy a generatív technológia megváltoztathatja az emberek munkavégzését. Mindketten versenyt indítottak a mesterséges intelligencia keresőmotorokba és irodai szoftverekbe való integrálásáért azzal a céllal, hogy uralják ezt az iparágat.

A Goldman Sachs becslése szerint az amerikai mesterséges intelligencia befektetések 2030-ra az ország gazdasági teljesítményének körülbelül 1%-át tehetik ki.

Az adatfeldolgozáshoz és a generatív mesterséges intelligencia futtatásához használt szuperszámítógépek grafikus feldolgozóegységekre (GPU-kra) támaszkodnak. A GPU-kat úgy tervezték, hogy a mesterséges intelligencia számítástechnikai megoldásaihoz kapcsolódó specifikus számításokat sokkal hatékonyabban kezeljék, mint más chipgyártók, például az Intel központi feldolgozóegységei. Például az OpenAI ChatGPT-jét több ezer Nvidia GPU hajtja.

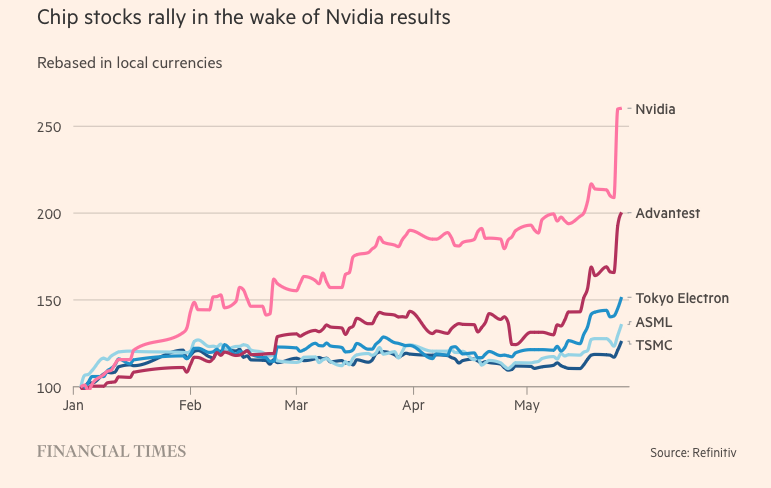

Eközben az Nvidia a GPU-piac mintegy 80%-át birtokolja. Az Nvidia fő versenytársai közé tartozik az Advanced Micro Devices, valamint olyan technológiai cégek saját mesterséges intelligencia chipjei, mint az Amazon, a Google és a Meta Platforms.

A szublimáció titka

A vállalat előretörését a H100 tette lehetővé, amely az Nvidia új, „Hopper” nevű architektúráján alapul – mely nevét az amerikai programozási úttörőről, Grace Hopperről kapta. A mesterséges intelligencia robbanásszerű térnyerése tette a H100-at a Szilícium-völgy legkeresettebb termékévé.

Az adatközpontokban használt szuperméretű chipek 80 milliárd tranzisztorral rendelkeznek, ami ötször annyi szilícium, mint amennyi a legújabb iPhone-okban található. Bár kétszer annyiba kerülnek, mint elődjük, az A100 (amely 2020-ban jelent meg), a H100 felhasználói szerint háromszoros teljesítményt nyújtanak.

A H100 különösen népszerűnek bizonyult a „Big Tech” vállalatok, mint például a Microsoft és az Amazon körében, amelyek teljes adatközpontokat építenek a mesterséges intelligencia alapú munkaterhelésekre összpontosítva, valamint az új generációs mesterséges intelligencia startupok, mint például az OpenAI, az Anthropic, a Stability AI és az Inflection AI körében, mivel nagyobb teljesítményt ígér, ami felgyorsíthatja a termékbevezetéseket vagy csökkentheti a képzési költségeket az idő múlásával.

„Ez az egyik legszűkösebb mérnöki erőforrás” – mondta Brannin McBee, a CoreWeave stratégiai igazgatója és alapítója, egy mesterséges intelligencia alapú felhőalapú startup, amely az elsők között kapott H100 szállítmányokat az év elején.

Más ügyfelek nem olyan szerencsések, mint a CoreWeave, akár hat hónapot is várniuk kell, mire a termék betaníthatja hatalmas adatmodelljeiket. Sok mesterséges intelligencia startup aggódik amiatt, hogy az Nvidia nem lesz képes kielégíteni a piaci igényeket.

Elon Musk több ezer Nvidia chipet rendelt mesterséges intelligencia startupjához, mondván: „A GPU-k jelenleg nehezebben beszerezhetők, mint a gyógyszerek.”

„A számítástechnikai költségek az egekbe szöktek. A kreatív mesterséges intelligencia építéséhez használt szerverhardverekre költött minimális összeg elérte a 250 millió dollárt” – mondta a Tesla vezérigazgatója.

Bár a H100 időszerű, az Nvidia mesterséges intelligencia áttörése két évtizedre nyúlik vissza, inkább szoftveres innovációra, mint hardverre. 2006-ban a vállalat bemutatta a Cuda szoftvert, amely lehetővé teszi a GPU-k gyorsítóként való használatát a grafikai feladatokon kívül.

„Az Nvidia mindenki más előtt meglátta a jövőt, és a programozható GPU-k felé fordult. Meglátták a lehetőséget, nagyot tettek, és következetesen megelőzték versenytársaikat” – mondta Nathan Benaich, az Air Street Capital partnere és mesterséges intelligencia startupokba befektető.

(Reuters, FT szerint)

[hirdetés_2]

Forrás

![[Fotó] Dong Nain áthaladó autópályák](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/12/1762940149627_ndo_br_1-resize-5756-jpg.webp)

![[Fotó] Pham Minh Chinh miniszterelnök részt vesz egy konferencián, ahol áttekintik az erők egyéves bevetését a helyi szintű biztonság és rend védelmében.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/12/1762957553775_dsc-2379-jpg.webp)

![Dong Nai OCOP átmenet: [3. cikk] A turizmus összekapcsolása az OCOP termékfogyasztással](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Hozzászólás (0)