ジェニファー・デステファノさんは、15歳の長女ブリアナさんそっくりの助けを求める声を聞いて愕然とした。調べてみると、それはすべてAIを使った詐欺だった。

1月20日の午後、ジェニファー・デステファノさんの携帯電話が鳴った。娘オーブリーが練習しているダンススタジオの外で車から降りた直後のことだった。発信者は不明で、デステファノさんは電話に出ないつもりだった。

しかし、15歳の長女ブリアナはスキーレースのトレーニング中だった。デステファノさんは緊急通報かもしれないと心配した。

「もしもし?」スピーカーフォンで彼女は答え、車をロックし、ハンドバッグとノートパソコン用バッグを掴んでジムに向かった。突然、デステファノは叫び声とすすり泣きの音を耳にした。

|

ジェニファー・デステファノと二人の娘。写真: NVCC。 |

「お母さん、大変!」と女の子の声が叫んだ。「どうしたの?何が起こっているの?」と母親はすぐに電話の向こうの相手に尋ねた。

パニックの瞬間

デステファノさんはCNNに対し、その声はアクセントからすべてに至るまでブリアナさんそっくりだったと語った。「スキーをしていると、彼女が山から滑り落ちたのかと思いました。それでパニックになりました」とデステファノさんは語った。

叫び声は続き、低い男性の声が命令し始めた。「いいか。お前の娘は俺の手に落ちている。警察か誰かを呼べば、娘に薬を注射してやる。メキシコに連れて行ってやる。お前は二度と娘に会わせることはできない。」

デステファノさんは一瞬で麻痺し、震えながら助けを求めて叫びながら体育館に駆け込んだ。まるで突然溺れそうになったような感覚だった。

|

デステファノさんは、ブリアナそっくりの声が電話で助けを求めてきた時、恐怖の瞬間を体験した。写真:ジェニファー・デステファノ |

その後、混乱が次々と起こりました。誘拐犯はすぐに100万ドルの身代金を要求し、デステファノは警察に通報することを決意しました。ブリアナに連絡を取ろうと何度も試みた後、「誘拐」は発覚しました。

結局、すべては詐欺だった。ブリアナは混乱し、母親に電話をかけ、何の騒ぎなのか全くわからないと伝えた。ブリアナ自身は何も問題がなかったのだ。

しかし、デステファノさんにとって、あの奇妙な声によるあの恐ろしい4分間の電話は決して忘れられないだろう。

デステファノさんは、ディープフェイク技術を使った電話によるバーチャル誘拐詐欺の被害者だと考えています。このAI技術を使うことで、誘拐犯は被害者の声に似せた音声で被害者の家族を脅迫し、身代金を要求します。

AIのダークサイド

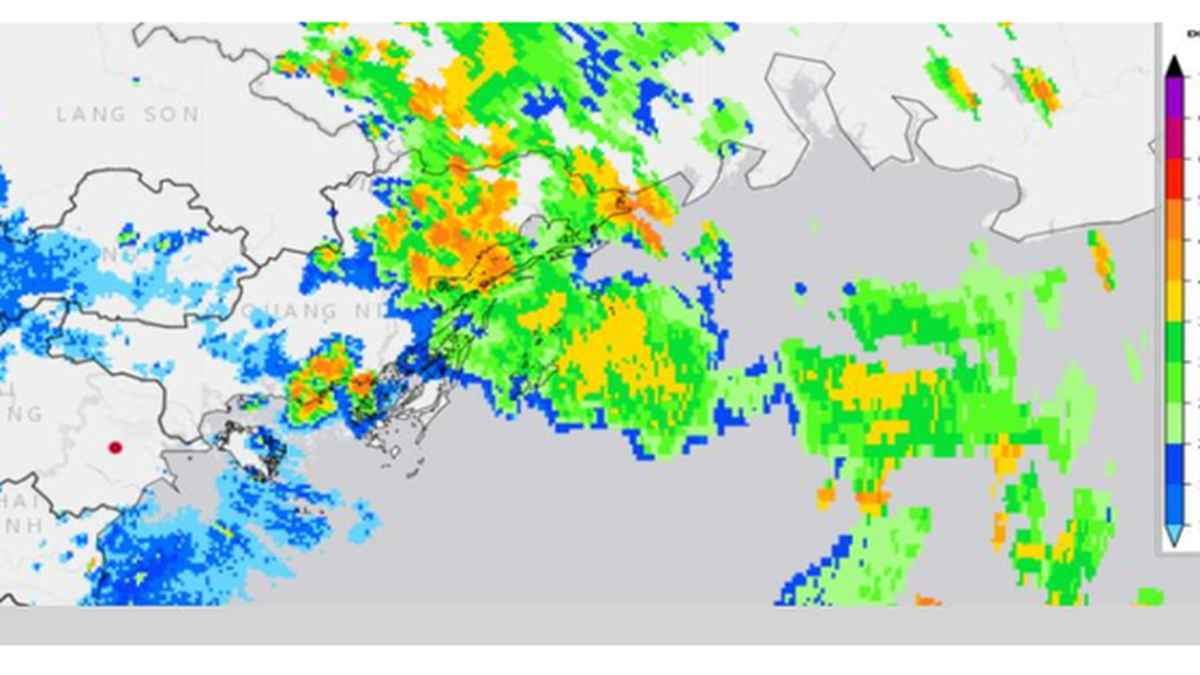

連邦捜査局(FBI)の広報担当者シボーン・ジョンソン氏によれば、米国の家庭は詐欺電話1件につき平均約1万1000ドルを失っているという。

|

米国では、詐欺電話1件につき、平均で約11,000ドルの被害に遭っています。写真:マシュー・フレミング |

2022年、米国連邦取引委員会(FTC)のデータによると、アメリカ人は詐欺電話により総額26億ドルの損失を被った。

スコッツデール警察署がCNNに提供したデステファノさんの通話録音では、ダンススタジオにいた母親がオペレーターに何が起こっているのかを説明しようとしている。

「母親が部屋に入ってきたところ、誰かから電話がかかってきたんです。娘からでした。誘拐犯が100万ドルを要求してきたんです。娘と話すことを許してくれなかったんです」と、電話をかけてきた女性は話した。

背後では、デステファノ氏が「娘と話したい」と叫んでいるのが聞こえる。オペレーターはすぐにこの電話がいたずら電話だと判断した。

実際、なりすまし電話は全米で頻繁に発生しています。中には、高齢者に電話をかけてきて、孫が事故に遭って手術費用が必要だと主張するケースもあります。

この方法の共通の特徴は、偽の誘拐犯が群衆の叫び声の録音をよく使うことです。

しかし、米連邦政府当局は、こうした詐欺はより巧妙化しており、被害者の声を偽装して知人の信頼を得て金銭を騙し取るディープフェイク技術が使われていると警告している。

|

ディープフェイク技術を使った恐喝詐欺は、被害者の声を模倣して知人の信頼を得て金銭を詐取するなど、ますます巧妙化している。写真:プロトコル |

安価で入手しやすい AI プログラムの開発により、詐欺師は自由に音声を複製し、元の音声とまったく同じ会話を作成できるようになりました。

「この脅威は単なる仮説ではありません。詐欺師がこれらのツールを武器として利用しているのを目撃しています。1分未満の音声で、比較的精巧な音声クローンを作成できます。人によっては、数秒でも十分な場合もあります」と、カリフォルニア大学バークレー校のコンピュータサイエンス教授、ハニー・ファリド氏は述べた。

ファリド氏は、AIソフトウェアの助けを借りれば、音声によるなりすましは月額わずか5ドルで誰でも簡単に利用できると述べた。

FTCは3月にも、詐欺師が被害者のソーシャルメディア動画から音声ファイルを盗む可能性があると警告を発した。

人工知能(AI)を用いて動画に顔や偽の声を挿入する行為、いわゆるディープフェイクは、ますます一般的になり、危険性も増しています。これはインターネットにおける真の危険です。

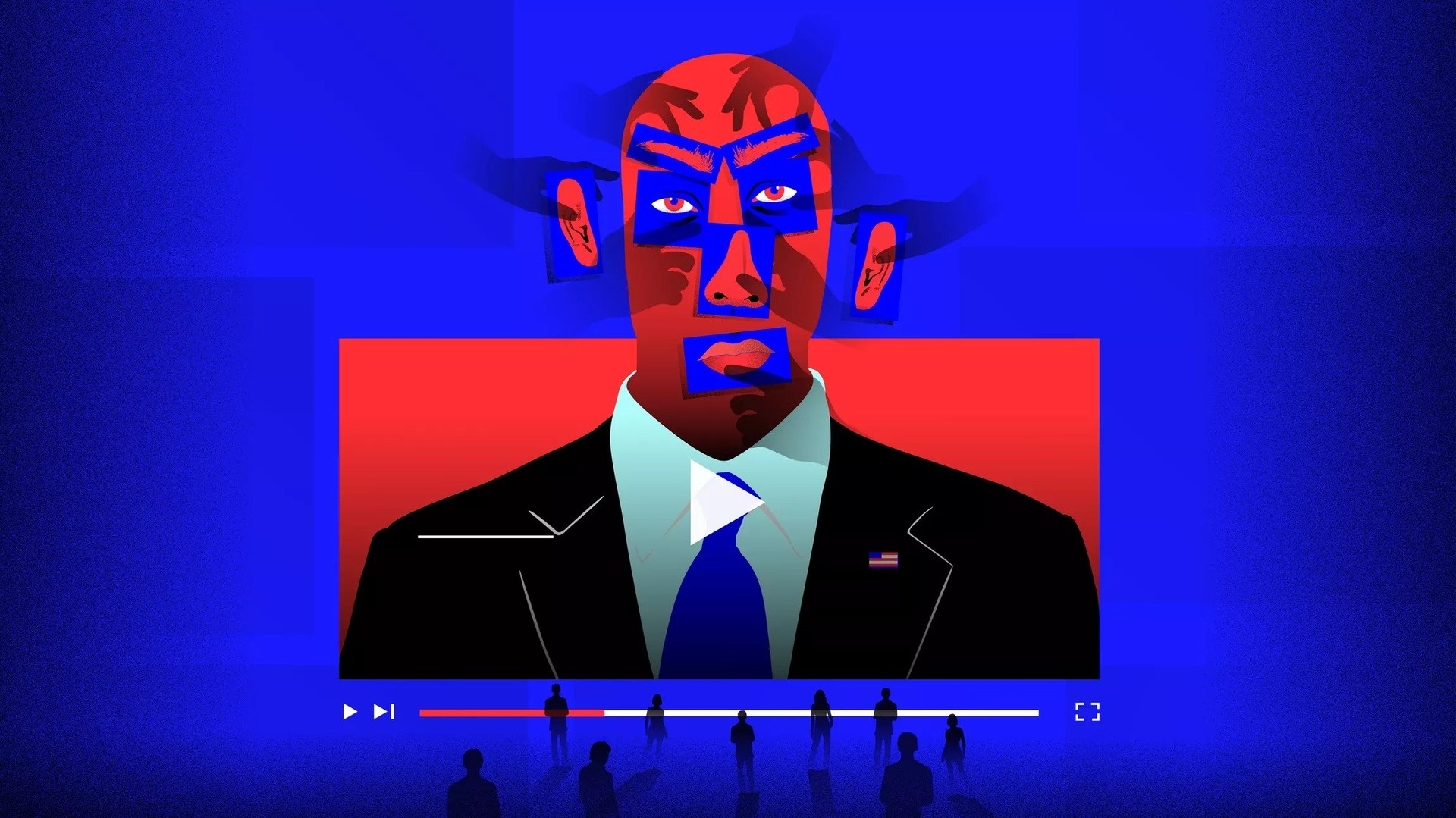

ディープフェイクは、センシティブな動画に加え、 政治目的で利用された場合、深刻な被害をもたらす可能性があります。2018年に拡散した、バラク・オバマ前米国大統領の顔を加工する動画は、政治家も被害者になり得ることを示しました。

2019年、今度はナンシー・ペロシ下院議長が被害者となった。編集された動画には、ペロシ議長が酩酊状態で演説する様子が映っており、その言葉は不明瞭だった。

|

ディープフェイクはポルノ動画を組み合わせるために使用されるだけでなく、2020年後半の米国大統領選挙などの重要な瞬間を前にフェイクニュースに関する懸念も引き起こす。写真: Cnet。 |

2019年後半、米国カリフォルニア州はディープフェイク動画の作成または共有を違法とする法律を可決しました。この法律では、選挙の60日前までに作成された政治家の画像、動画、または音声を含む編集動画は違法であると明記されています。

2019年、国連(UN)の研究者ジョセフ・ブロック氏とミゲル・ルエンゴ・オロス氏は、ウィキペディアのテキストと国連総会の7,000以上のスピーチでトレーニングしたAIモデルは、世界の指導者のスピーチを簡単に偽造できると述べた。

研究チームによれば、一貫性のある「高品質」のテキストを生成するには、AIにいくつかの単語を入力するだけでよかったという。

例えば、研究者が「事務総長、モガディシュでの致命的なテロ攻撃を強く非難」という見出しを付けると、AIは国連の決定への支持を表明するスピーチを生成することができた。

[広告2]

ソースリンク

コメント (0)