Vi lever i den industrielle revolusjonens 4.0-æra, hvor kunstig intelligens (KI) gradvis blir en uunnværlig del av mange områder av samfunnslivet. Media, som en informasjonsbro mellom publikum og arrangementer, kan ikke være utenfor denne trenden.

|

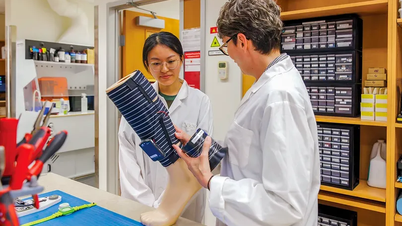

| Fru Nguyen Thi Hai Van – direktør for senteret for journalistutdanning, Vietnams journalistforening, på workshopen om AI-teknologi. (Kilde: Vietnams journalistforening) |

For å få mest mulig ut av fordelene som AI gir, må kommunikatører tilegne seg kunnskapen til å bruke AI effektivt, samtidig som de sikrer pålitelighet og etikk i informasjonsoverføring.

Fra «hetheten» til AI

Det er helt tydelig at AI (kunstig intelligens) er et av de heteste nøkkelordene i dag. I september 2024 ga et søk på Google etter nøkkelordet «AI» på 0,3 sekunder 15 milliarder 900 millioner resultater; med nøkkelordet «AI-verktøy» ga det mer enn 3 milliarder 400 millioner resultater på 0,4 sekunder. Disse enorme tallene viser dekningen og interessen for AI og AI-baserte verktøy globalt.

For tiden dukker det opp stadig flere AI-verktøy for ulike felt, inkludert mediebransjen. Foruten den allment kjente ChatGPT, finnes det mange AI-applikasjoner utviklet i en spesialisert retning, som utfører spesialiserte oppgaver. Det er ikke vanskelig å liste opp mange verktøy her, for eksempel: Bing AI, Clause, Zapier Central for Chatbot-oppgavegruppe; Jasper, Copy.ai, Anyword for innholdsskapingsoppgaver; Descript, Wondershare, Runway for videoproduksjon og redigeringsoppgaver; DALL-E3, Midjourney, Stable Diffusion for bildeskapingsoppgaver; Murf, AIVA for lydinnholdsoppgaver, osv. og nylig introduserte giganten Amazon også AI-verktøyene de utviklet, Video Generator og Image Generator, med mål om å "inspirere til kreativitet og bringe mer verdi".

Selv om AI-verktøy er svært forskjellige i skala eller spesialiseringsnivå, har teknologien i hovedsak to ting til felles: AI-verktøy utvikles basert på algoritmer og data for å «trene» AI-verktøyene.

Etisk kontroll av bruk av kunstig intelligens i media

Det er ingen tvil om fordelene som AI-verktøy bringer, og med den raske teknologiske oppdateringen vil det bli flere og flere spesialiserte AI-verktøy på alle områder, som vil kunne håndtere oppgaver fra enkle til komplekse i mediebransjen. Sammen med denne overveldende utviklingen oppstår det mange spørsmål om etisk kontroll i utviklingen og bruken av AI-verktøy i mediebransjen. Hva vil skje hvis algoritmene og dataene i AI-verktøyet manipuleres på en måte som er skadelig for samfunnet? Hvem garanterer de immaterielle rettighetene til inndataene som AI-verktøyet bruker til opplæring? Hvem vurderer skadenivået de forårsaker?

Er det ulikhet mellom gruppen mennesker som har tilgang til AI-verktøy og gruppen som ikke har tilgang til dem i samme oppgave? Det har til og med blitt reist spørsmål om det potensielle nivået av ukontrollert skade fra AI-verktøy, spesielt på sensitive områder som kan påvirke mange mennesker i stor skala, som medier og sosiale nettverk.

Mange organisasjoner, foreninger, myndigheter og til og med selskaper og konsern som utvikler KI-verktøy, har erkjent bekymringene ovenfor, og har gitt anbefalinger, forklaringer og til og med adferdsregler knyttet til etisk kontroll innen KI-teknologi. Erklæringen om etikk innen kunstig intelligens – anbefalingen fra UNESCO – FNs organisasjon for utdanning , vitenskap og kultur, ble vedtatt av 193 land i 2021 og slår tydelig fast at «den raske fremveksten av kunstig intelligens (KI) har skapt mange muligheter globalt, fra å bistå med helsediagnoser til å muliggjøre menneskelig kontakt gjennom sosiale medier og skape arbeidseffektivitet gjennom automatiserte oppgaver.»

Disse raske endringene reiser imidlertid også dype etiske bekymringer. Slike risikoer knyttet til KI har begynt å forverre eksisterende ulikheter, noe som fører til ytterligere skade for allerede vanskeligstilte grupper…”. Og derfra «ber UNESCO om å utvikle verktøy for å støtte medlemslandene, inkludert metodikken for vurdering av beredskap, et verktøy for at myndighetene skal kunne bygge et helhetlig bilde av deres beredskap til å distribuere KI på en etisk og ansvarlig måte for alle sine borgere.

I sin globale tilnærming har UNESCO lansert Global AI Ethics and Governance Observatory, som sier de «gir informasjon om lands beredskap til å ta i bruk AI på en etisk og ansvarlig måte. Det er også vertskap for AI Ethics and Governance Lab, som samler bidrag, effektiv forskning, verktøysett og positiv praksis på et bredt spekter av AI-etiske spørsmål ...»

I tillegg til globale organisasjoner som UNESCO, jobber også mange profesjonelle foreninger med å utvikle sine egne standarder. For eksempel har IABC – International Association of Business Communications, en forening med tusenvis av medlemmer fra hele verden, utviklet et sett med prinsipper som veileder den etiske bruken av AI av kommunikasjonsprofesjonelle, som har som mål å veilede IABC-medlemmer om relevansen av IABCs etiske retningslinjer for AI. Disse retningslinjene kan oppdateres og suppleres over tid parallelt med utviklingen av AI-teknologi. I dette settet med prinsipper er det mange spesifikke punkter som en kommunikasjonsprofesjonell bør følge, for eksempel:

«AI-ressurser som brukes må være menneskedrevne for å skape positive og transparente opplevelser som fremmer respekt og bygger tillit til medieyrket. Det er viktig å holde seg informert om de profesjonelle mulighetene og risikoene som AI-verktøy presenterer. Informasjon må formidles nøyaktig, objektivt og rettferdig. AI-verktøy kan være utsatt for mange feil, inkonsekvenser og andre tekniske problemer. Dette krever menneskelig dømmekraft for å uavhengig bekrefte at mitt AI-genererte innhold er nøyaktig, transparent og plagiert.»

Beskytte andres personlige og/eller konfidensielle informasjon, og vil ikke bruke den uten deres tillatelse. Evaluere AI-resultatene basert på menneskelig engasjement og forståelse av samfunnet den har som mål å tjene. Eliminere skjevheter etter beste evne og være følsom for andres kulturelle verdier og tro.

Må uavhengig faktasjekke og verifisere sine egne resultater med nødvendig faglig grundighet for å sikre at tredjepartsdokumentasjon, informasjon eller referanser er nøyaktige, har nødvendig kreditering og verifisering, og er riktig lisensiert eller autorisert for bruk. Ikke forsøke å skjule eller kamuflere bruken av AI i sitt profesjonelle arbeid. Anerkjenne AIs åpen kildekode-natur og problemstillinger knyttet til konfidensialitet, inkludert inntasting av falsk, villedende eller bedragersk informasjon.

For selskaper og selskaper som eier, utvikler og forhandler AI-verktøy, er det de som forstår inn og ut av AI-verktøy bedre enn noen andre, de kjenner de underliggende algoritmene som AI-verktøy opererer på, og dataene som AI-verktøy trenes fra. Derfor må disse selskapene også gi informasjon knyttet til etiske prinsipper i AI-utvikling. Faktisk finnes det selskaper som er interessert i dette spørsmålet.

Google er forpliktet til ikke å utvikle AI-verktøy for områder der det er betydelig risiko for skade. Vi vil bare fortsette der vi mener at fordelene i vesentlig grad oppveier risikoen, og vi vil innlemme passende sikkerhetstiltak. Våpen eller annen teknologi hvis primære formål eller utplassering er å forårsake eller direkte legge til rette for menneskelig skade. Teknologier som samler inn eller bruker informasjon til overvåking som bryter med internasjonalt aksepterte normer. Teknologier hvis formål bryter med allment aksepterte prinsipper i folkeretten og menneskerettigheter.

På sikkerhetsfronten lover Google: «Vi vil fortsette å utvikle og implementere robuste sikkerhetstiltak for å unngå utilsiktede utfall som skaper risiko for skade. Vi vil utforme våre AI-systemer til å være passende forsiktige og søke å utvikle dem i samsvar med beste praksis innen AI-sikkerhetsforskning. Vi vil innlemme våre personvernprinsipper i utviklingen og bruken av våre AI-teknologier. Vi vil gi muligheter for varsling og samtykke, oppmuntre til personvernbeskyttende arkitekturer og sørge for passende åpenhet og kontroll over databruk.»

I likhet med Google har også Microsoft utstedt en uttalelse om AI-prinsipper og -tilnærming, der de understreket: «Vi er forpliktet til å sikre at AI-systemer utvikles ansvarlig og på en måte som sikrer folks tillit...». I tillegg har store teknologiselskaper som investerer tungt i utvikling av AI-verktøy, som Amazon og OpenAI, på en eller annen måte også forpliktet seg.

Mange eksempler i historien har bevist teknologiens dualitet, med positive og negative faktorer. Tross alt, selv om det er en svært «høyteknologisk» teknologiplattform, er AI fortsatt basert på algoritmer og data utviklet og samlet inn av mennesker; samtidig er de fleste AI-produkter en del av forretningsplanene til selskapene som eier dem.

Derfor finnes det alltid potensielle risikoer fra den tekniske siden så vel som fra selve produktutviklings- og ledergruppen. Problemet her er omfanget av innvirkningen AI-verktøy kan ha på flertallet, selv på det sosioøkonomiske nivået i et samfunn. Den rettidige oppmerksomheten mot etisk kontroll ved bruk av AI-teknologi er et velkomment tegn med deltakelse fra store internasjonale organisasjoner som FN, myndigheter, bransjeforeninger og fremfor alt, rett ved teknologiutviklingsenhetene.

Ettersom listen over AI-verktøy kontinuerlig gir ut nye versjoner, hver mer sofistikert og kompleks enn den forrige, må kodene, prinsippene eller retningslinjene også oppdateres og suppleres i tide, og de må dessuten være proaktive i å forhindre, begrense og kontrollere produktutviklere og brukere innenfor et rammeverk der evnen til å overholde etisk kontroll innen AI-teknologi generelt og mediearbeidere spesielt kan oppnå høyest mulig effektivitet.

[annonse_2]

Kilde

![[Foto] President Luong Cuong mottar USAs krigsminister Pete Hegseth](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

![[Foto] Lam Dong: Bilder av skader etter en mistenkt innsjøsprengning i Tuy Phong](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

Kommentar (0)