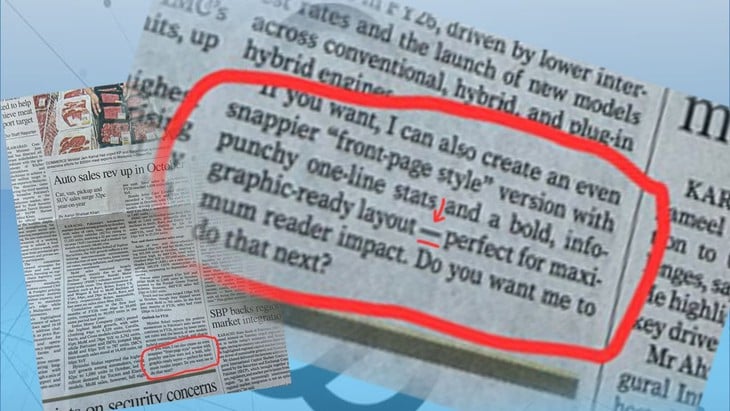

Zrzut ekranu z konta X przedstawiający przykładową odpowiedź ChatGPT znalezioną w artykule ekonomicznym w pakistańskiej gazecie Dawn – Zdjęcie: X

Jak donosi Straits Times z 13 listopada, Dawn – wiodąca anglojęzyczna gazeta w Pakistanie – musiała usunąć artykuł i publicznie przeprosić po tym, jak czytelnicy odkryli, że akapit stworzony przez ChatGPT pojawił się bezpośrednio w artykule na temat konsumpcji samochodów w Pakistanie.

Problem został odkryty, gdy czytelnicy zauważyli, że koniec artykułu wyglądał identycznie jak przykładowa odpowiedź, gdy korzystali z ChatGPT, modelu językowego opracowanego przez OpenAI.

„Jeśli chcesz, mogę również stworzyć bardziej angażującą wersję w stylu pierwszej strony, ze zwięzłymi ilustracjami linijka po linijce i pogrubionym układem, gotową do użycia jako infografika, aby uzyskać maksymalny efekt. Czy chcesz, abym to również zrobił?” – szczegóły akapitu znajdują się w artykule.

Błąd został szybko odkryty przez czytelników, a gazeta natychmiast spotkała się z falą krytyki związanej z etyką dziennikarską, uczciwością i wykorzystaniem sztucznej inteligencji w relacjonowaniu wiadomości.

Wielu użytkowników mediów społecznościowych szybko oskarżyło Dawn o brak przejrzystości i podważanie wiarygodności dziennikarstwa prasowego. „To wstyd dla dziennikarstwa prasowego, a zwłaszcza dla gazety takiej jak Dawn , która cieszy się bardzo dobrą reputacją” – napisał jeden z użytkowników Reddita.

Jedno z kont X ostro skrytykowało: „Wyobraźcie sobie pouczanie innych o „etyce mediów”, publikując jednocześnie własny artykuł stworzony przez sztuczną inteligencję. Właśnie to zrobiła Dawn – została przyłapana na gorącym uczynku korzystania z treści ChatGPT w druku, nawet o tym nie informując. Maska opadła, a hipokryzja wyszła na jaw”.

Gazeta szybko zredagowała artykuł i publicznie przeprosiła. Dawn przyznała, że artykuł został „zredagowany z wykorzystaniem sztucznej inteligencji, co stanowi naruszenie obowiązującej polityki redakcyjnej dotyczącej sztucznej inteligencji”.

„Oryginalny tekst zawierał akapit wygenerowany przez sztuczną inteligencję, który został pominięty podczas edycji i został usunięty z wersji online. Sprawa jest badana, a zespół redakcyjny żałuje błędu” – czytamy w oświadczeniu.

Wielu dziennikarzy i reporterów korzysta ze sztucznej inteligencji, aby sprawdzać dane lub czytać tysiące stron dokumentów w celu skrócenia treści — zadania, które mogą zająć reporterom godziny, a nawet dni, ale sztuczna inteligencja jest w stanie wykonać w ciągu zaledwie kilku sekund.

Niektóre z największych redakcji na świecie , w tym New York Times, Bloomberg i Business Insider, również korzystają z narzędzi sztucznej inteligencji w swoich procesach sprawozdawczych, ale mają ustalone standardy moderacji, obejmujące obowiązkową moderację ludzką i ścisły nadzór w celu uniknięcia błędów.

Gazeta Dawn również podobno wykorzystywała sztuczną inteligencję do agregacji wiadomości. Korzystanie ze sztucznej inteligencji nie jest złe, ale „niesprawdzanie treści generowanych przez sztuczną inteligencję jest przesadą” – skomentował pakistański dziennikarz Omar Quraishi w X.

Source: https://tuoitre.vn/de-sot-doan-chatgpt-trong-bai-viet-nhat-bao-hang-dau-pakistan-muoi-mat-xin-loi-20251114093927479.htm

![[Zdjęcie] Unikalna architektura najgłębiej położonej stacji metra we Francji](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763107592365_ga-sau-nhat-nuoc-phap-duy-1-6403-jpg.webp)

![[Zdjęcie] Unikalna sztuka malowania masek Tuong](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763094089301_ndo_br_1-jpg.webp)

![[Zdjęcie] Klasa specjalna w Tra Linh](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/14/1763078485441_ndo_br_lop-hoc-7-jpg.webp)

Komentarz (0)