A inteligência artificial está ajudando as pessoas a escrever e-mails, recomendar filmes, analisar dados e auxiliar no diagnóstico de doenças...

Mas, à medida que a IA se torna mais inteligente, também aumenta a sensação de insegurança que ela traz. Parte disso se deve ao fato de não compreendermos totalmente a tecnologia que estamos usando. O restante decorre de nossos próprios instintos psicológicos.

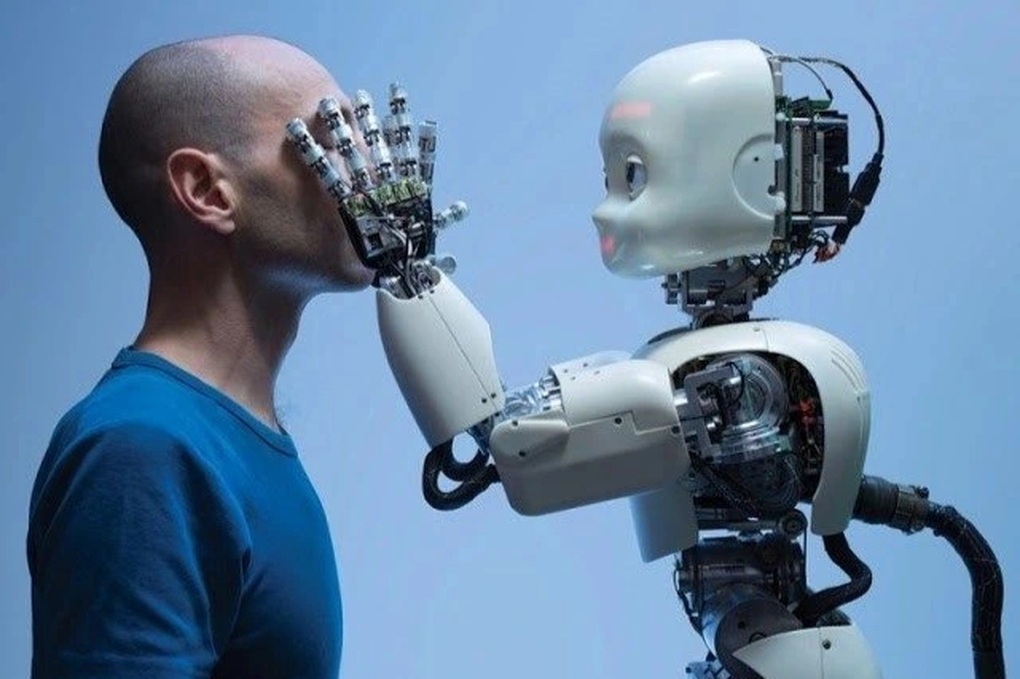

A inteligência artificial está se desenvolvendo mais rápido do que a capacidade de adaptação psicológica humana (foto ilustrativa).

Quando a IA se torna uma “caixa preta” e os usuários perdem o controle.

As pessoas tendem a confiar naquilo que entendem e controlam. Quando você aperta um botão, o elevador se move. Quando você aciona um interruptor, a luz acende. Respostas claras criam uma sensação de segurança.

Em contraste, muitos sistemas de IA operam como uma caixa fechada. Você insere dados, mas a forma como os resultados são produzidos permanece oculta. Isso torna impossível para os usuários entenderem ou questionarem o sistema.

Essa sensação de opacidade é perturbadora. Os usuários não precisam apenas de uma ferramenta que funcione, mas também precisam saber por que ela funciona.

Se a IA não fornecer uma explicação, as pessoas começam a questioná-la. Isso leva a um conceito chamado "aversão a algoritmos", que pesquisadores comportamentais descrevem como o fenômeno em que as pessoas tendem a escolher as decisões de outros, mesmo que estejam erradas, em vez de confiar no julgamento de uma máquina.

Muitas pessoas temem que a IA se torne excessivamente precisa. Um sistema de recomendação de conteúdo pode ser irritante se as interpretar com muita clareza. A sensação de estar sendo observado ou manipulado começa a surgir, mesmo que o próprio sistema não possua emoções ou intenções.

Essa reação decorre de um comportamento instintivo: o antropomorfismo. Mesmo sabendo que a IA não é humana, ainda assim reagimos a ela como se estivéssemos nos comunicando com um indivíduo. Quando a IA é excessivamente educada ou fria, os usuários se sentem estranhos e desconfiados.

Os humanos são tolerantes com outros humanos, mas não com as máquinas.

Um paradoxo interessante é que, quando os humanos cometem erros, podemos ser empáticos e compreensivos. Mas quando o erro vem da IA, especialmente quando ela é anunciada como objetiva e baseada em dados, os usuários muitas vezes se sentem traídos.

Isso está relacionado ao fenômeno da quebra de expectativas. Esperamos que as máquinas sejam lógicas, precisas e infalíveis. Quando essa confiança é quebrada, a reação psicológica costuma ser mais intensa. Mesmo um pequeno erro em um algoritmo pode ser percebido como grave se o usuário se sentir sem controle ou sem explicação.

Instintivamente, precisamos entender a causa de um erro. Com humanos, podemos perguntar "por quê?". Com IA, a resposta muitas vezes não existe ou é muito vaga.

Quando professores, escritores, advogados ou designers veem a IA realizando parte de suas funções, eles não apenas temem perder seus empregos, mas também se preocupam com o valor de suas habilidades e identidade pessoal.

Essa é uma reação natural, chamada ameaça à identidade. Ela pode levar à negação, resistência ou defesa psicológica. Nesses casos, a suspeita deixa de ser uma reação emocional e passa a ser um mecanismo de autoproteção.

A confiança não surge apenas da lógica.

Os humanos confiam através da emoção, gestos, contato visual e empatia. A IA pode ser articulada, até mesmo bem-humorada, mas não sabe como criar uma conexão real.

O fenômeno do "vale da estranheza" é descrito por especialistas como a sensação desconfortável de se deparar com coisas que são quase humanas, mas que carecem de algo que as torna irreais.

Quando as máquinas se tornam demasiado humanas, a sensação de insegurança torna-se ainda mais evidente (Foto: Getty).

Com a IA, é a ausência de emoção que deixa muitas pessoas desorientadas, sem saber se devem confiar ou duvidar.

Em um mundo repleto de notícias falsas, vídeos falsos e decisões algorítmicas, sentimentos de abandono emocional fazem com que as pessoas se mostrem receosas em relação à tecnologia. Não porque a IA faça algo errado, mas porque não sabemos como nos sentir em relação a ela.

Além disso, a suspeita às vezes é mais do que apenas um sentimento. Os algoritmos já criaram vieses em contratações, julgamentos criminais e aprovação de crédito. Para aqueles que foram prejudicados por sistemas de dados opacos, é compreensível que sejam cautelosos.

Os psicólogos chamam isso de desconfiança aprendida. Quando um sistema falha repetidamente, é compreensível que a confiança se perca. As pessoas não confiam simplesmente porque lhes dizem para confiar. A confiança precisa ser conquistada, não imposta.

Para que a IA seja amplamente adotada, os desenvolvedores precisam criar sistemas que possam ser compreendidos, questionados e responsabilizados. Os usuários precisam estar envolvidos na tomada de decisões, em vez de apenas observarem de fora. A confiança só pode ser verdadeiramente sustentada quando as pessoas se sentem respeitadas e empoderadas.

Fonte: https://dantri.com.vn/cong-nghe/vi-sao-tri-tue-nhan-tao-cham-vao-noi-so-sau-nhat-cua-con-nguoi-20251110120843170.htm

![[Foto] O primeiro-ministro Pham Minh Chinh recebe o ministro do Trabalho e Bem-Estar do Laos, Phosay Sayasone.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/11/1762872028311_dsc-2246-jpg.webp)

![Transição OCOP de Dong Nai: [Artigo 3] Vinculando o turismo ao consumo de produtos OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Comentário (0)