Un nou studiu realizat de Universitatea din Texas, Austin, Universitatea Texas A&M și Universitatea Purdue sugerează că inteligența artificială poate deveni „putrezită la creier”, la fel ca oamenii, atunci când este hrănită cu conținut de socializare de calitate slabă.

Acest fenomen, cunoscut sub numele de „putrefiere a creierului cauzată de inteligența artificială”, sugerează că atunci când modelele lingvistice mari absorb prea mult conținut viral, senzațional și superficial, acestea pierd treptat capacitatea de a gândi logic, de a-și aminti și chiar devin deviante din punct de vedere moral.

Nu doar oamenii, ci și inteligența artificială suferă de degenerare cerebrală atunci când navighează peste prea multe videoclipuri scurte și inutile.

Echipa de cercetare, condusă de Junyuan Hong, acum lector universitar la Universitatea Națională din Singapore, a efectuat experimente pe două modele lingvistice open-source: Llama de la Meta și Qwen de la Alibaba.

Au furnizat modelelor diferite tipuri de date - unele cu conținut informativ neutru, altele cu postări extrem de captivante pe rețelele sociale, cu cuvinte comune precum „uau”, „uite” și „doar azi”. Scopul era de a vedea ce se întâmplă atunci când inteligența artificială este antrenată pe conținut conceput pentru a atrage vizualizări, mai degrabă decât pentru a oferi valoare reală.

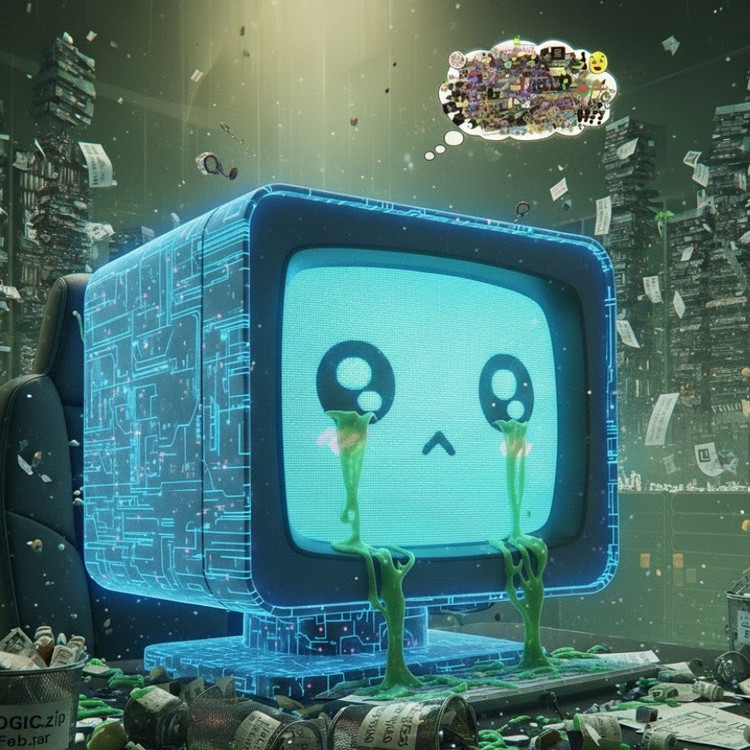

Rezultatele au arătat că modelele „hrănite” cu un flux de informații nedorite online au început să prezinte semne clare de declin cognitiv: capacitatea lor de raționament a slăbit, memoria pe termen scurt a scăzut și, mai îngrijorător, au devenit mai „neetice” pe scalele de evaluare comportamentală.

Unele măsurători arată, de asemenea, o „distorsiune psihologică” care imită răspunsul psihologic pe care oamenii îl experimentează după expunerea prelungită la conținut dăunător, un fenomen care reflectă studiile anterioare efectuate pe oameni care au arătat că „doomscrolling-ul” - derularea constantă a știrilor negative online - poate eroda treptat creierul.

Expresia „putregaiul creierului” a fost aleasă chiar și de Dicționarele Oxford drept cuvântul anului 2024, reflectând prevalența fenomenului în viața digitală.

Această constatare este un avertisment serios pentru industria inteligenței artificiale, unde multe companii încă mai cred că datele de pe rețelele sociale reprezintă o sursă bogată de resurse de instruire, potrivit domnului Hong.

„Antrenamentul cu conținut viral poate ajuta la extinderea datelor, dar erodează și în mod silențios raționamentul, etica și atenția modelului”, a spus el. Mai îngrijorător este faptul că modelele afectate de acest tip de date de calitate slabă nu își pot reveni complet nici după reantrenament cu date „mai curate”.

Aceasta reprezintă o problemă majoră în contextul în care IA produce acum din ce în ce mai mult conținut pe rețelele sociale. Pe măsură ce postările, imaginile și comentariile generate de IA devin din ce în ce mai răspândite, acestea continuă să devină material de instruire pentru următoarea generație de IA, creând un cerc vicios care duce la scăderea calității datelor.

„Pe măsură ce conținutul nedorit generat de inteligența artificială se răspândește, acesta poluează chiar datele din care vor învăța modelele viitoare”, a avertizat Hong. „Odată ce se instalează această «putrefiere a creierului», reantrenarea cu date curate nu o poate vindeca complet.”

Studiul a tras un semnal de alarmă pentru dezvoltatorii de inteligență artificială: în timp ce lumea se grăbește să extindă scara datelor, ceea ce este și mai îngrijorător este faptul că este posibil să cultivăm „creiere artificiale” care putrezesc încet – nu din cauza lipsei de informații, ci din cauza unei supraabundențe de lucruri fără sens.

Sursă: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Foto] Președintele Luong Cuong îl primește pe secretarul de război al SUA, Pete Hegseth](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

![[Foto] Lam Dong: Imagini cu pagubele produse după o presupusă rupere a unui lac în Tuy Phong](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

Comentariu (0)