Angriff aus allen Richtungen.

Google hat ein neues Produkt für künstliche Intelligenz (KI) namens „Gemini Nano Banana“ auf den Markt gebracht. Dabei handelt es sich nicht um eine groß angelegte linguistische KI (LLM), die zum Schreiben und logischen Denken fähig ist, sondern um eine KI, die auf die Fotobearbeitung spezialisiert ist… Viele Nutzer sind von diesem Tool begeistert, es bringt aber auch einige Nachteile mit sich.

„Das ist wie ein Rückschritt in der KI-Technologie und den ethischen Grenzen“, sagte Nguyen Hong Phuc, Chief Scientific Officer von Conductify AI, und brachte damit seine persönliche Meinung zum Ausdruck. „Gemini Nano Banana verfügt über effektive Bildbearbeitungsfunktionen. Doch Googles Aufhebung der Zensur von Gemini Nano Banana und die damit einhergehende Lockerung der Barrieren und Begrenzungsmechanismen ermöglichen es dieser KI, Bilder zu erstellen, die Prominenten unglaublich ähnlich sehen, anzügliche Bilder, sensible Bilder usw.“, so Phuc.

Laut Herrn Nguyen Hong Phuc macht diese Fähigkeit Gemini Nano Banana zu einem Werkzeug zur Erstellung realistischer Fälschungen, die selbst KI-Experten nicht erkennen können. Dies birgt neue Risiken für Betrug und Cybersicherheit, wie beispielsweise die Erstellung gefälschter Fotos mit bekannten Politikern zur Verbreitung von Falschinformationen und sogar die Gefahr, dass Einzelpersonen in sozialen Medien KI-generierten Fotomanipulationen und Verleumdungen ausgesetzt werden.

Da Dutzende KI-gestützte Bildbearbeitungstools das Internet im Sturm erobern, ist kein Ende der Deepfake-Betrügereien in Sicht. Statistiken von Sicherheitsorganisationen zeigen, dass Deepfake-Technologie Phishing-Kampagnen ermöglicht, die sich gezielt an hochrangige Personen, insbesondere Führungskräfte, richten. Im Jahr 2024 gab es weltweit 140.000 bis 150.000 Fälle, von denen 75 % CEOs und leitende Angestellte betrafen. Deepfakes könnten die globalen wirtschaftlichen Verluste bis 2027 um 32 % auf etwa 40 Milliarden US-Dollar pro Jahr erhöhen.

Das KI-Unternehmen Anthropic hat kürzlich eine Cyberangriffskampagne ausländischer Hacker aufgedeckt und abgewehrt. Erstmals wurde dabei der Einsatz von KI zur Koordination automatisierter Angriffe dokumentiert. Konkret nutzten die Hacker KI-Systeme, um Eindringversuche zu planen, zu steuern und durchzuführen – eine besorgniserregende Entwicklung, die das Risiko birgt, Ausmaß und Geschwindigkeit von Cyberangriffen zu erhöhen.

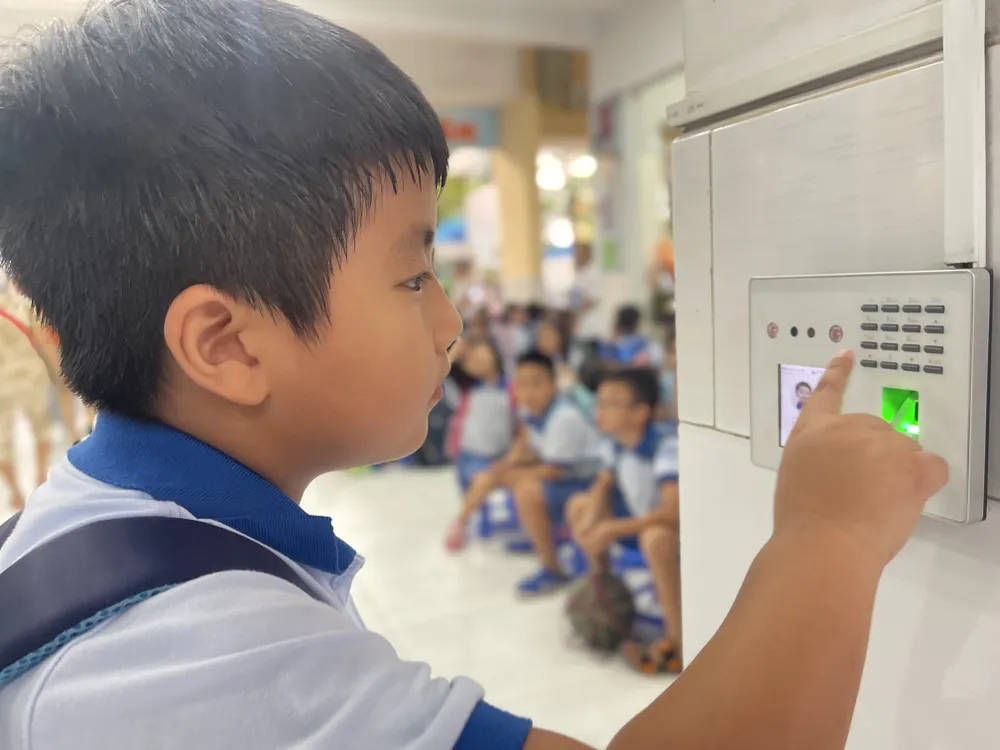

Herr Ngo Minh Hieu, Direktor der Betrugsbekämpfungsorganisation der Nationalen Cybersicherheitsvereinigung, erklärte, dass KI-gestützte Tools die Betrugsgeschwindigkeit im Vergleich zum Einsatz von Menschen um etwa das 20-Fache erhöhen. Betrüger liefern der KI ein Betrugsszenario zur Analyse, woraufhin das System automatisch mit den Opfern chattet. Anhand der Ausgangsdaten kann die KI die Absichten des Opfers erkennen und in Echtzeit mit ihm kommunizieren. Die raffinierteste Taktik ist der Man-in-the-Middle-Angriff. Dabei greift der Hacker ein, sobald ein Nutzer eine Videoauthentifizierung durchführt (z. B. durch Videoaufzeichnung oder Sprachbefehle), und manipuliert die Datenübertragung. Cyberkriminelle fügen dann vorbereitete Deepfake-Videos ein und ersetzen so den echten Datenstrom des Nutzers, um den Authentifizierungsprozess zu umgehen. Mit dieser Methode sind auch die Sicherheitssysteme von Banken und Finanzinstituten gefährdet.

Besseres Datenmanagement

Mit der zunehmenden Verbreitung von KI steigen auch die Sicherheits- und Datenschutzrisiken deutlich an. Daten, die auf entfernten Servern gespeichert und verarbeitet werden, werden zu einem attraktiven Ziel für Hacker und Cyberkriminelle. Laut Daten der National Cyber Security Association (NCSA) stieg die Zahl der KI-gestützten Cyberangriffe allein im zweiten Quartal 2025 um 62 % und verursachte weltweite Verluste von bis zu 18 Milliarden US-Dollar.

Experten halten Datenschutz für unerlässlich. Dennoch werden Daten auf zahlreichen „Schwarzmarkt“-Plattformen weiterhin offen gesammelt und verkauft – teilweise schon ab 20 US-Dollar pro Monat. Cyberkriminelle nutzen Tools, die Sprachmodelle imitieren, aber speziell für kriminelle Zwecke angepasst sind. Diese Tools können Schadsoftware erzeugen und sogar Antivirenprogramme umgehen.

In Vietnam regelt das Dekret Nr. 13/2023/ND-CP (gültig ab dem 17. April 2023) den Schutz personenbezogener Daten. Darüber hinaus wird das Gesetz zum Schutz personenbezogener Daten, das voraussichtlich am 1. Januar 2026 in Kraft treten wird, einen stärkeren Rechtsmechanismus zur Bekämpfung des Risikos von Datenlecks und -missbrauch schaffen. Laut der Nationalen Cybersicherheitsvereinigung muss die Durchsetzung jedoch in drei Bereichen weiter verbessert werden: Sensibilisierung der Öffentlichkeit, Stärkung der unternehmerischen Verantwortung und Verbesserung der Verarbeitungskapazitäten der Aufsichtsbehörden. Neben technischen Maßnahmen muss jeder Einzelne lernen, ungewöhnliche und verdächtige Anzeichen zu erkennen und sich proaktiv vor gefährlichen digitalen Interaktionen zu schützen.

Kaspersky warnt vor der Ausnutzung von Dark AI (ein Begriff für den Einsatz großer Sprachmodelle, die außerhalb gängiger Sicherheitsvorkehrungen operieren und häufig Aktionen wie Phishing, Manipulation, Cyberangriffe oder Datenmissbrauch ermöglichen). Organisationen und Privatpersonen müssen sich aufgrund des zunehmenden Einsatzes von Dark AI im asiatisch-pazifischen Raum auf immer raffiniertere und schwerer erkennbare Cyberangriffe einstellen.

Sergey Lozhkin, Leiter des globalen Forschungs- und Analyseteams (GReAT) für den Nahen Osten, die Türkei, Afrika und den asiatisch-pazifischen Raum bei Kaspersky, erklärte, dass eine der aktuellen Formen des KI-Missbrauchs das Aufkommen von Black-Hat-GPT-Modellen sei. Dabei handelt es sich um KI-Modelle, die speziell für unethische und illegale Zwecke entwickelt oder modifiziert wurden, beispielsweise zur Erstellung von Schadsoftware, zum Verfassen von überzeugenden Phishing-E-Mails für groß angelegte Angriffe, zur Erzeugung von Deepfake-Stimmen und -Videos sowie zur Unterstützung simulierter Angriffe.

Kaspersky-Experten empfehlen Privatpersonen und Unternehmen, Sicherheitslösungen der nächsten Generation einzusetzen, um KI-generierte Malware zu erkennen und gleichzeitig den Datenschutz zu gewährleisten. Unternehmen sollten Echtzeit-Überwachungstools implementieren, um die Ausnutzung von Schwachstellen durch KI zu verfolgen; die Zugriffskontrolle und Mitarbeiterschulungen verstärken, um KI im Dark Zone-Bereich und das Risiko von Datenlecks einzuschränken; und ein Cybersecurity Operations Center einrichten, um Bedrohungen zu überwachen und schnell auf Vorfälle zu reagieren.

Quelle: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

![OCOP während der Tet-Saison: [Teil 3] Ultradünnes Reispapier setzt sich durch.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F402x226%2Fvietnam%2Fresource%2FIMAGE%2F2026%2F01%2F28%2F1769562783429_004-194121_651-081010.jpeg&w=3840&q=75)

Kommentar (0)