2024년 5월, 세계적으로 유명한 기술 대기업들이 GPT-4o를 탑재한 OpenAI, Gemini 1.5 Pro를 탑재한 Google 등 사용자 경험 최적화를 위한 다양한 "초스마트" 기능을 추가한 새로운 버전의 인공지능(AI)을 잇따라 출시했습니다. 하지만 이 기술이 사이버 범죄자들이 다양한 온라인 사기에 악용되고 있다는 사실은 부인할 수 없습니다.

위험 증가

최근 워크숍에서 정보통신부 팜득롱 차관은 사이버 공격이 점점 더 정교하고 복잡해짐에 따라 끊임없이 증가하고 있다는 점을 지적했습니다. 특히 AI의 지원으로 사용자가 직면하는 위험은 기하급수적으로 증가할 것입니다. "사이버 범죄자들은 AI 기술을 이용하여 새로운 악성코드와 새롭고 정교한 피싱 공격을 쉽게 개발하고 있습니다..."라고 팜득롱 차관은 경고했습니다.

정보통신부 산하 정보보안국 보고서에 따르면, AI 관련 사이버 보안 위험으로 인해 전 세계적으로 1,000조 달러(USD) 이상의 피해가 발생했으며, 그중 베트남에서만 8,000억~10,000억 VND(VND)에 달하는 피해가 발생했습니다. 현재 가장 흔한 공격은 사기 목적으로 AI를 이용하여 음성과 얼굴을 위조하는 것입니다. 2025년까지 초당 약 3,000건의 공격, 초당 12건의 악성코드, 그리고 매일 70건의 새로운 취약점과 취약점이 발생할 것으로 예상됩니다.

애플리케이션 보안 지원 전문 기업 BShield의 응우옌 후 지압 이사에 따르면, AI의 발전으로 가짜 이미지와 음성을 만드는 것은 어렵지 않습니다. 사기꾼들은 소셜 네트워크에 게시하는 공개 정보나 온라인 채용 면접, "당국"을 사칭한 전화 통화 등의 수법을 통해 사용자 데이터를 쉽게 수집할 수 있습니다. BShield가 실시한 시뮬레이션에서, 사기꾼들은 화상 통화를 통해 확보한 얼굴을 CCCD에 등록하고, 움직이는 사람의 신체에 이식하여 eKYC 도구를 속여 시스템에서 실제 사람으로 인식할 수 있습니다.

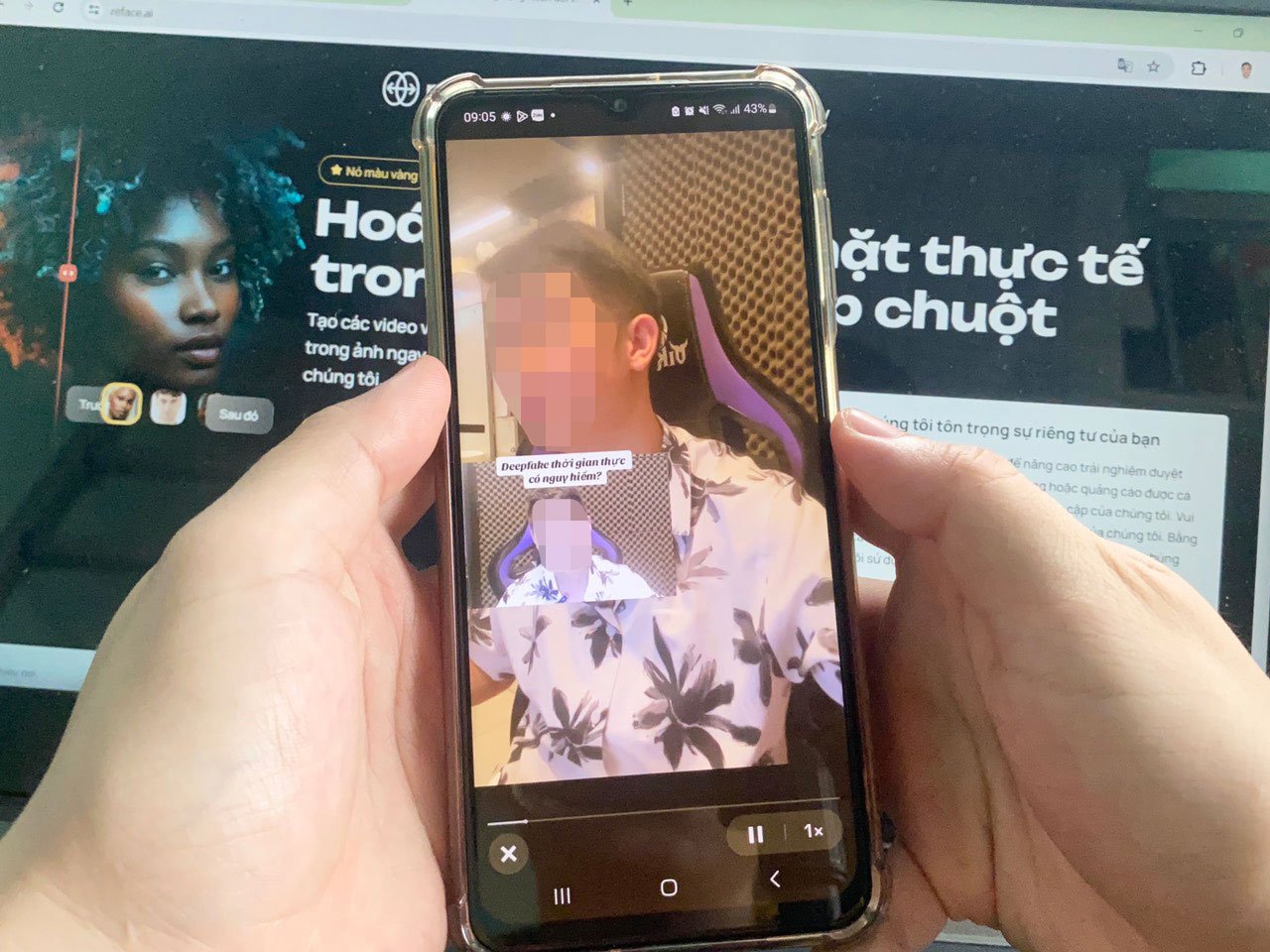

딥페이크 기술을 이용한 사기 수법이 증가하고 있으며, 더욱 정교해지고 있습니다. 사진: 르 틴

사용자 관점에서, 호치민시의 IT 전문가인 응우옌 탄 트룽 씨는 악의적인 해커들이 chatGPT를 악용하여 은행이나 유명 기관의 실제 이메일과 유사한 내용과 문체를 가진 사기성 이메일을 제작할 수 있다는 점을 우려하고 있습니다. 이러한 이메일에는 악성 코드가 첨부될 가능성이 높으며, 사용자가 이를 클릭하면 데이터가 유출되고 자산이 압류될 수 있습니다. 트룽 씨는 "AI 소프트웨어가 점점 더 발전하고 있으며, 실제 사람과 95% 유사한 얼굴과 음성을 가진 가짜 영상을 제작할 수 있습니다. 또한, 동작이 실시간으로 바뀌어 시청자가 이를 감지하기 매우 어렵습니다."라고 말했습니다.

곧 법적 회랑이 완성될 예정입니다.

보안 전문가 Pham Dinh Thang은 첨단 기술 사기 위험을 줄이기 위해 사용자가 AI 관련 지식을 정기적으로 업데이트하고 출처를 알 수 없는 링크를 클릭하지 않아야 한다고 강조했습니다. 기업의 경우 데이터 보안 및 시스템 운영을 위한 예산을 확보해야 합니다. 또한, 기업 담당자는 시스템에서 발생하는 실제 취약점에 접근할 수 있도록 심층적인 교육을 받아야 하며, 이를 통해 사이버 공격 유형을 식별하는 능력을 향상시켜야 합니다.

AI 개발부 사기 방지 프로젝트 책임자인 타 콩 손(Ta Cong Son) 씨는 AI가 고도로 지능적인 지원 기능 덕분에 사용자의 삶과 기업, 기관 및 부서의 운영에 깊이 자리 잡았다고 말했습니다. 특히 AI 기술은 접근성이 뛰어나고 사용하기 쉬워 악의적인 행위자들이 사기 목적으로 이를 쉽게 악용할 수 있는 환경이 조성될 것입니다. 손 씨는 "사기꾼들은 공격 방법을 끊임없이 변경하기 때문에 사용자는 이를 예방하기 위해 정기적으로 정보를 업데이트해야 합니다."라고 조언했습니다.

전문가들에 따르면, 최근 업그레이드된 GPT-4o와 Gemini 1.5 Pro 모델은 AI의 지능에 한계가 없음을 입증했습니다. 따라서 기업들이 AI 사기 방지 도구 및 솔루션을 개발하도록 장려하는 것 외에도, 관리 기관들은 이러한 추세에 발맞추기 위해 AI 관련 법적 절차를 조속히 완료해야 합니다.

국가인구데이터센터 부소장인 응우옌 안 투안 중령은 AI 개발, 생산, 적용 및 활용 과정에서 국내외 서비스 제공업체의 윤리와 책임을 규정하는 문서를 조속히 발행해야 한다고 말했습니다. 동시에 AI 서비스를 사용, 적용, 연결 및 제공하는 시스템에 대한 기술 표준에 대한 구체적인 규정이 마련되어야 합니다. 투안 중령은 "AI 위험에 대처하기 위해 AI 프로젝트를 연구하고 적용해야 합니다. AI는 인간에 의해 만들어지고 지식의 산물이기 때문에 '좋은 AI'와 '나쁜 AI'의 차이가 있을 수 있으며, 따라서 인공지능 자체에 의한 인공지능 개발을 막을 수 있습니다."라고 강조했습니다.

사이버 보안 과제

응우옌 안 투안 중령은 AI가 네트워크 보안에 위협이 되고 있음을 인정했습니다. 따라서 AI가 지원하는 악성 소프트웨어가 문서 파일에 설치될 수 있으며, 사용자가 문서 파일을 업로드하면 이 악성 코드가 시스템에 침투합니다. 또한, 특수 AI 기술을 통해 해커는 시스템을 시뮬레이션하여 보안 취약점을 공격할 수 있습니다. AI는 이미지, 가짜 애플리케이션 이름, 공안부 웹사이트 등을 이용하여 사람들이 다운로드, 설치하고 신분증 번호, 로그인 비밀번호 등의 정보를 제공하도록 수많은 애플리케이션을 만들 수 있습니다. 응우옌 안 투안 중령은 "AI는 또한 자체 소프트웨어를 개발하고, 여러 악성 코드 계열을 혼합한 하이브리드 악성 코드를 개발하며, 더욱 정교한 보안 회피 메커니즘을 갖추고, 유연한 소스 코드를 자동으로 변경할 것"이라고 경고했습니다.

[광고_2]

출처: https://nld.com.vn/toi-pham-mang-co-them-bi-kip-tu-ai-196240601195415035.htm

![[해양뉴스] 재무부, 이란 석유거래를 촉진하는 다양한 네트워크 타깃](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/7/14/43150a0498234eeb8b127905d27f00b6)

댓글 (0)