ໂຈມຕີຈາກທຸກມຸມ.

Google ໄດ້ເປີດຕົວຜະລິດຕະພັນປັນຍາປະດິດ (AI) ໃໝ່ທີ່ມີຊື່ວ່າ "Gemini Nano Banana," ເຊິ່ງບໍ່ແມ່ນ AI ດ້ານພາສາຂະໜາດໃຫຍ່ (LLM) ທີ່ສາມາດຂຽນ ແລະ ໃຊ້ເຫດຜົນໄດ້, ແຕ່ແມ່ນ AI ທີ່ຊ່ຽວຊານດ້ານການແກ້ໄຂຮູບພາບ... ຜູ້ໃຊ້ຫຼາຍຄົນຕື່ນເຕັ້ນກັບເຄື່ອງມືນີ້, ແຕ່ມັນຍັງມີຂໍ້ເສຍຫຼາຍຢ່າງ.

“ມັນຄືກັບ ‘ການຖອຍຫລັງ’ ໃນເຕັກໂນໂລຊີ AI ແລະ ຂໍ້ຈຳກັດດ້ານຈັນຍາບັນ,” ທ່ານ Nguyen Hong Phuc, ຫົວໜ້າເຈົ້າໜ້າທີ່ ວິທະຍາສາດ ຂອງ Conductify AI ກ່າວ, ໂດຍສະແດງຄວາມຄິດເຫັນສ່ວນຕົວຂອງລາວ. “Gemini Nano Banana ມີຄວາມສາມາດໃນການແກ້ໄຂຮູບພາບທີ່ມີປະສິດທິພາບ. ແຕ່ການທີ່ Google ບໍ່ກວດສອບ Gemini Nano Banana, ເຊິ່ງເຮັດໃຫ້ອຸປະສັກ ແລະ ກົນໄກການຈຳກັດຫຼຸດລົງ, ຊ່ວຍໃຫ້ AI ນີ້ສ້າງຮູບພາບທີ່ຄ້າຍຄືກັນກັບຄົນດັງ, ຮູບພາບທີ່ແນະນຳ, ຮູບພາບທີ່ລະອຽດອ່ອນ, ແລະອື່ນໆຢ່າງບໍ່ໜ້າເຊື່ອ,” ທ່ານ Phuc ກ່າວ.

ອີງຕາມທ່ານ Nguyen Hong Phuc, ຄວາມສາມາດນີ້ເຮັດໃຫ້ Gemini Nano Banana ເປັນເຄື່ອງມືໃນການສ້າງຮູບພາບປອມທີ່ເບິ່ງຄືຈິງ, ຈົນເຖິງຈຸດທີ່ຜູ້ຊ່ຽວຊານດ້ານ AI ບໍ່ສາມາດແຍກແຍະພວກມັນໄດ້, ເຊິ່ງນໍາໄປສູ່ຄວາມສ່ຽງໃໝ່ຂອງການສໍ້ໂກງ ແລະ ຄວາມປອດໄພທາງໄຊເບີ, ເຊັ່ນ: ການສ້າງຮູບພາບປອມກັບ ນັກການເມືອງ ທີ່ມີຊື່ສຽງເພື່ອເຜີຍແຜ່ຂໍ້ມູນທີ່ບໍ່ຖືກຕ້ອງ, ແລະ ແມ່ນແຕ່ບຸກຄົນທີ່ຖືກຫຼອກລວງດ້ວຍຮູບພາບທີ່ສ້າງຂຶ້ນໂດຍ AI ແລະ ການໝິ່ນປະໝາດໃນສື່ສັງຄົມ...

ຍິ່ງໄປກວ່ານັ້ນ, ດ້ວຍເຄື່ອງມືແກ້ໄຂຮູບພາບ AI ອື່ນໆຫຼາຍສິບອັນທີ່ໄດ້ຮັບຄວາມນິຍົມໃນອິນເຕີເນັດ, ການຫລອກລວງ deepfake ບໍ່ມີສັນຍານວ່າຈະຢຸດຢັ້ງໄດ້. ສະຖິຕິຈາກອົງການຄວາມປອດໄພສະແດງໃຫ້ເຫັນວ່າເທັກໂນໂລຢີ deepfake ສ້າງແຄມເປນ phishing ທີ່ແນໃສ່ບຸກຄົນທີ່ມີມູນຄ່າສູງ, ໂດຍສະເພາະຜູ້ນຳທຸລະກິດ. ໃນປີ 2024, ມີ 140,000-150,000 ກໍລະນີທົ່ວໂລກ, ໂດຍ 75% ແມ່ນແນໃສ່ CEO ແລະຜູ້ບໍລິຫານລະດັບສູງ... Deepfakes ສາມາດເພີ່ມການສູນເສຍທາງ ເສດຖະກິດ ທົ່ວໂລກໄດ້ 32%, ປະມານ 40 ຕື້ໂດລາຕໍ່ປີພາຍໃນປີ 2027.

ເມື່ອບໍ່ດົນມານີ້, ບໍລິສັດ AI Anthropic ໄດ້ກວດພົບ ແລະ ຂັດຂວາງການໂຈມຕີທາງໄຊເບີທີ່ດຳເນີນໂດຍແຮກເກີຕ່າງປະເທດ, ເຊິ່ງເປັນຄັ້ງທຳອິດທີ່ບັນທຶກການນຳໃຊ້ AI ເພື່ອປະສານງານກິດຈະກຳການໂຈມຕີແບບອັດຕະໂນມັດ. ໂດຍສະເພາະ, ແຮກເກີໄດ້ໃຊ້ລະບົບ AI ເພື່ອວາງແຜນ, ຊີ້ນຳ ແລະ ນຳໃຊ້ການບຸກລຸກ - ການພັດທະນາທີ່ "ໜ້າເປັນຫ່ວງ" ທີ່ມີຄວາມສ່ຽງຕໍ່ການຂະຫຍາຍຂະໜາດ ແລະ ຄວາມໄວຂອງການໂຈມຕີທາງໄຊເບີ...

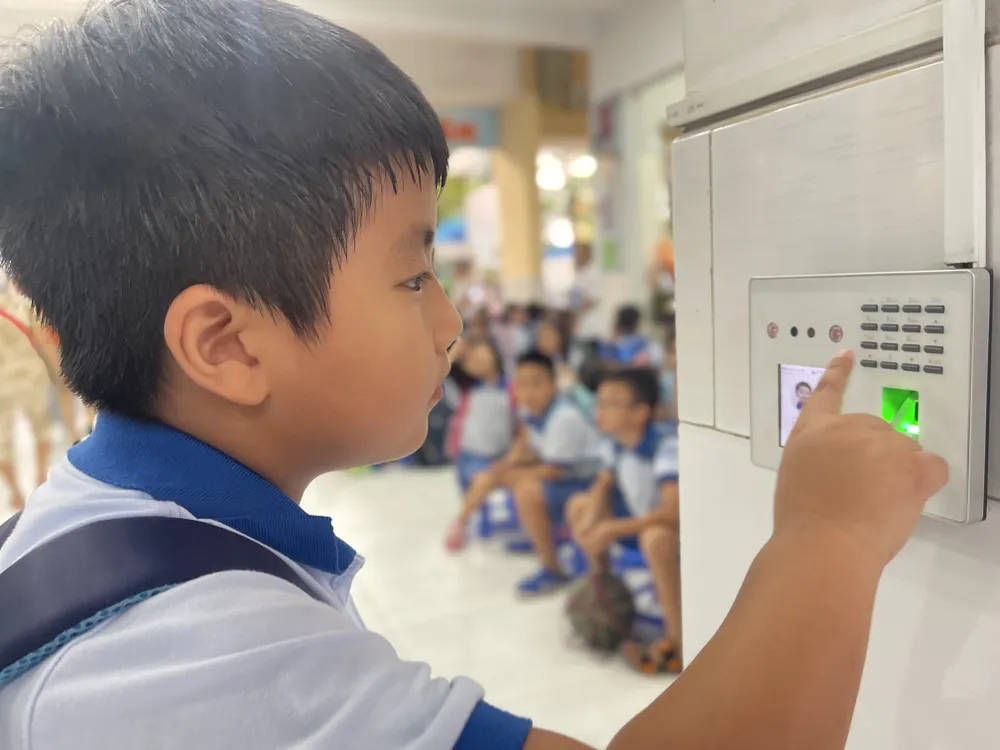

ທ່ານ ໂງ ມິງ ຫວີວ, ຜູ້ອຳນວຍການອົງການຕ້ານການສໍ້ໂກງຂອງສະມາຄົມຄວາມປອດໄພທາງໄຊເບີແຫ່ງຊາດ, ໄດ້ແບ່ງປັນວ່າເຄື່ອງມືທີ່ປະສົມປະສານກັບ AI ເພີ່ມຄວາມໄວໃນການສໍ້ໂກງປະມານ 20 ເທົ່າເມື່ອທຽບກັບການໃຊ້ຄົນແທ້. ພວກຫຼອກລວງສະໜອງສະຖານະການສໍ້ໂກງໃຫ້ AI ສຳລັບການວິເຄາະ, ແລະລະບົບຈະສົນທະນາກັບຜູ້ເຄາະຮ້າຍໂດຍອັດຕະໂນມັດທັນທີ. ຈາກຂໍ້ມູນເບື້ອງຕົ້ນ, AI ສາມາດເຂົ້າໃຈສິ່ງທີ່ຜູ້ເຄາະຮ້າຍຕ້ອງການ ແລະສື່ສານກັບພວກເຂົາໃນເວລາຈິງ. ຍຸດທະວິທີທີ່ຊັບຊ້ອນທີ່ສຸດແມ່ນການໂຈມຕີ "Man-in-the-Middle", ບ່ອນທີ່ເມື່ອຜູ້ໃຊ້ປະຕິບັດການພິສູດຢືນຢັນຕົວຕົນດ້ວຍວິດີໂອ (ເຊັ່ນ: ການບັນທຶກໃບໜ້າຂອງເຂົາເຈົ້າ ຫຼື ການໃຫ້ຄຳສັ່ງ), ແຮກເກີຈະແຊກແຊງເພື່ອແຊກແຊງຂໍ້ມູນທີ່ສົ່ງຕໍ່. ຫຼັງຈາກນັ້ນ, ອາດຊະຍາກອນທາງໄຊເບີຈະໃສ່ວິດີໂອ deepfake ທີ່ກຽມໄວ້ລ່ວງໜ້າ, ແທນທີ່ກະແສຂໍ້ມູນຕົວຈິງຂອງຜູ້ໃຊ້ເພື່ອຂ້າມຂະບວນການພິສູດຢືນຢັນຕົວຕົນ. ດ້ວຍວິທີການນີ້, ລະບົບຄວາມປອດໄພຂອງທະນາຄານ ແລະສະຖາບັນການເງິນກໍ່ມີຄວາມສ່ຽງທີ່ຈະຖືກຫຼອກລວງເຊັ່ນກັນ.

ການຈັດການຂໍ້ມູນທີ່ດີກວ່າ

ໃນຂະນະທີ່ AI ມີຄວາມແຜ່ຫຼາຍເພີ່ມຂຶ້ນ, ຄວາມສ່ຽງດ້ານຄວາມປອດໄພ ແລະ ຄວາມເປັນສ່ວນຕົວກໍ່ເພີ່ມຂຶ້ນຢ່າງຫຼວງຫຼາຍ. ຂໍ້ມູນທີ່ເກັບໄວ້ ແລະ ປະມວນຜົນຢູ່ໃນເຊີບເວີໄລຍະໄກຈະກາຍເປັນເປົ້າໝາຍທີ່ໜ້າສົນໃຈສຳລັບແຮກເກີ ແລະ ອາດຊະຍາກອນທາງໄຊເບີ. ອີງຕາມຂໍ້ມູນຈາກສະມາຄົມຄວາມປອດໄພທາງໄຊເບີແຫ່ງຊາດ, ໃນໄຕມາດທີສອງຂອງປີ 2025 ພຽງຢ່າງດຽວ, ຈຳນວນການໂຈມຕີທາງໄຊເບີທີ່ໃຊ້ AI ໄດ້ເພີ່ມຂຶ້ນ 62%, ເຊິ່ງເຮັດໃຫ້ການສູນເສຍທົ່ວໂລກສູງເຖິງ 18 ຕື້ໂດລາ...

ຜູ້ຊ່ຽວຊານເຊື່ອວ່າການປົກປ້ອງຂໍ້ມູນແມ່ນມີຄວາມສຳຄັນຫຼາຍ. ເຖິງຢ່າງໃດກໍ່ຕາມ, ການເກັບກຳ ແລະ ການຂາຍຂໍ້ມູນຍັງສືບຕໍ່ຢ່າງເປີດເຜີຍໃນຫຼາຍແພລດຟອມ "ຕະຫຼາດມືດ" ໃນລາຄາພຽງແຕ່ 20 ໂດລາຕໍ່ເດືອນ. ອາດຊະຍາກອນທາງອິນເຕີເນັດສາມາດໃຊ້ເຄື່ອງມືທີ່ຮຽນແບບຮູບແບບພາສາ ແຕ່ຖືກປັບແຕ່ງເພື່ອຈຸດປະສົງທາງອາຍາ. ເຄື່ອງມືເຫຼົ່ານີ້ມີຄວາມສາມາດໃນການສ້າງມັນແວ ແລະ ແມ່ນແຕ່ຂ້າມຊອບແວປ້ອງກັນໄວຣັສໄດ້.

ໃນປະເທດຫວຽດນາມ, ດຳລັດສະບັບເລກທີ 13/2023/ND-CP (ມີຜົນບັງຄັບໃຊ້ຕັ້ງແຕ່ວັນທີ 17 ເມສາ 2023) ຄວບຄຸມການປົກປ້ອງຂໍ້ມູນສ່ວນຕົວ. ນອກຈາກນັ້ນ, ກົດໝາຍວ່າດ້ວຍການປົກປ້ອງຂໍ້ມູນສ່ວນຕົວ, ຄາດວ່າຈະມີຜົນບັງຄັບໃຊ້ໃນວັນທີ 1 ມັງກອນ 2026, ຈະເປີດກົນໄກທາງກົດໝາຍທີ່ເຂັ້ມແຂງຂຶ້ນເພື່ອແກ້ໄຂຄວາມສ່ຽງຂອງການຮົ່ວໄຫຼ ແລະ ການໃຊ້ຂໍ້ມູນສ່ວນຕົວໃນທາງທີ່ຜິດ. ຢ່າງໃດກໍຕາມ, ອີງຕາມສະມາຄົມຄວາມປອດໄພທາງໄຊເບີແຫ່ງຊາດ, ປະສິດທິພາບຂອງການບັງຄັບໃຊ້ຍັງຈຳເປັນຕ້ອງໄດ້ຮັບການເສີມສ້າງໃນສາມເສົາຄ້ຳຄື: ການຍົກສູງຄວາມຮັບຮູ້ຂອງສາທາລະນະ, ການເພີ່ມຄວາມຮັບຜິດຊອບຂອງບໍລິສັດ, ແລະ ການປັບປຸງຄວາມສາມາດໃນການປະມວນຜົນຂອງອົງການຄຸ້ມຄອງ. ນອກເໜືອໄປຈາກມາດຕະການດ້ານວິຊາການ, ແຕ່ລະຄົນຕ້ອງພັດທະນາຄວາມສາມາດໃນການລະບຸສັນຍານທີ່ຜິດປົກກະຕິ ແລະ ໜ້າສົງໄສ ແລະ ປົກປ້ອງຕົນເອງຢ່າງມີປະສິດທິພາບຈາກການພົວພັນດິຈິຕອນທີ່ເປັນອັນຕະລາຍ...

Kaspersky ໄດ້ເຕືອນກ່ຽວກັບການໃຊ້ປະໂຫຍດຈາກ Dark AI (ຄຳສັບທີ່ໝາຍເຖິງການນຳໃຊ້ຮູບແບບພາສາຂະໜາດໃຫຍ່ (LLMs) ທີ່ເຮັດວຽກຢູ່ນອກການຄວບຄຸມຄວາມປອດໄພມາດຕະຖານ, ເຊິ່ງມັກຈະເຮັດໃຫ້ເກີດການກະທຳເຊັ່ນ: ການຫຼອກລວງ, ການຫຼອກລວງ, ການໂຈມຕີທາງໄຊເບີ, ຫຼື ການລ່ວງລະເມີດຂໍ້ມູນ). ອົງການຈັດຕັ້ງ ແລະ ບຸກຄົນຈຳເປັນຕ້ອງກຽມພ້ອມທີ່ຈະປະເຊີນກັບການໂຈມຕີທາງໄຊເບີທີ່ມີຄວາມຊັບຊ້ອນ ແລະ ຍາກທີ່ຈະກວດພົບໄດ້ຍ້ອນການເພີ່ມຂຶ້ນຂອງ Dark AI ໃນພາກພື້ນອາຊີປາຊີຟິກ.

ທ່ານ Sergey Lozhkin, ຫົວໜ້າທີມງານຄົ້ນຄວ້າ ແລະ ວິເຄາະທົ່ວໂລກ (GReAT) ສຳລັບຕາເວັນອອກກາງ, ຕຸລະກີ, ອາຟຣິກາ ແລະ ພາກພື້ນອາຊີປາຊີຟິກ ທີ່ Kaspersky, ໄດ້ແບ່ງປັນວ່າ ການສະແດງອອກໜຶ່ງຂອງການລ່ວງລະເມີດ AI ໃນປະຈຸບັນແມ່ນການເກີດຂຶ້ນຂອງຮູບແບບ GPT ຂອງ Black Hat. ເຫຼົ່ານີ້ແມ່ນຮູບແບບ AI ທີ່ພັດທະນາ ຫຼື ດັດແປງໂດຍສະເພາະເພື່ອຮັບໃຊ້ຈຸດປະສົງທີ່ບໍ່ມີຈັນຍາບັນ ແລະ ຜິດກົດໝາຍ, ເຊັ່ນ: ການສ້າງມັນແວ, ການສ້າງອີເມວຫຼອກລວງທີ່ຄ່ອງແຄ້ວ ແລະ ຊັກຊວນໃຈສຳລັບການໂຈມຕີຂະໜາດໃຫຍ່, ການສ້າງສຽງ ແລະ ວິດີໂອ deepfake, ແລະ ແມ່ນແຕ່ການສະໜັບສະໜູນການໂຈມຕີແບບຈຳລອງ.

ຜູ້ຊ່ຽວຊານ Kaspersky ແນະນຳໃຫ້ບຸກຄົນ ແລະ ທຸລະກິດໃຊ້ວິທີແກ້ໄຂຄວາມປອດໄພລຸ້ນຕໍ່ໄປເພື່ອກວດຫາມັນແວທີ່ສ້າງຂຶ້ນໂດຍ AI, ພ້ອມທັງໃຫ້ຄວາມສຳຄັນກັບການປົກປ້ອງຂໍ້ມູນ. ທຸລະກິດຄວນໃຊ້ເຄື່ອງມືຕິດຕາມກວດກາແບບເວລາຈິງເພື່ອຕິດຕາມການຂູດຮີດຄວາມສ່ຽງທີ່ຂັບເຄື່ອນດ້ວຍ AI; ເສີມສ້າງການຄວບຄຸມການເຂົ້າເຖິງ ແລະ ການຝຶກອົບຮົມພະນັກງານເພື່ອຈຳກັດ AI ໃນເຂດມືດ ແລະ ຄວາມສ່ຽງຂອງການຮົ່ວໄຫຼຂອງຂໍ້ມູນ; ແລະ ສ້າງຕັ້ງສູນປະຕິບັດງານດ້ານຄວາມປອດໄພທາງໄຊເບີເພື່ອຕິດຕາມກວດກາໄພຂົ່ມຂູ່ ແລະ ຕອບສະໜອງຢ່າງວ່ອງໄວຕໍ່ເຫດການຕ່າງໆ.

ແຫຼ່ງຂໍ້ມູນ: https://www.sggp.org.vn/bao-mat-du-lieu-thoi-ai-post824210.html

![[ຮູບພາບ] ຕະຫຼາດ Coc Ly ຄຶກຄື້ນໃນຄ່ຳຄືນວັນເຕັດ](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2026/02/14/1771062261424_baolaocai-br_img-6457-jpg.webp)

(0)