|

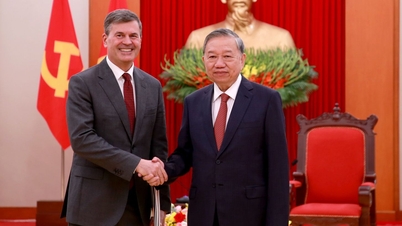

Anthropic tocmai și-a actualizat noua politică. Fotografie: GK Images . |

Pe 28 august, compania de inteligență artificială Anthropic a anunțat lansarea unei actualizări a Termenilor și condițiilor de utilizare și a Politicii de confidențialitate. Utilizatorii pot acum alege să permită ca datele lor să fie utilizate pentru a îmbunătăți Claude și a consolida protecția împotriva abuzurilor precum escrocheriile și fraudele.

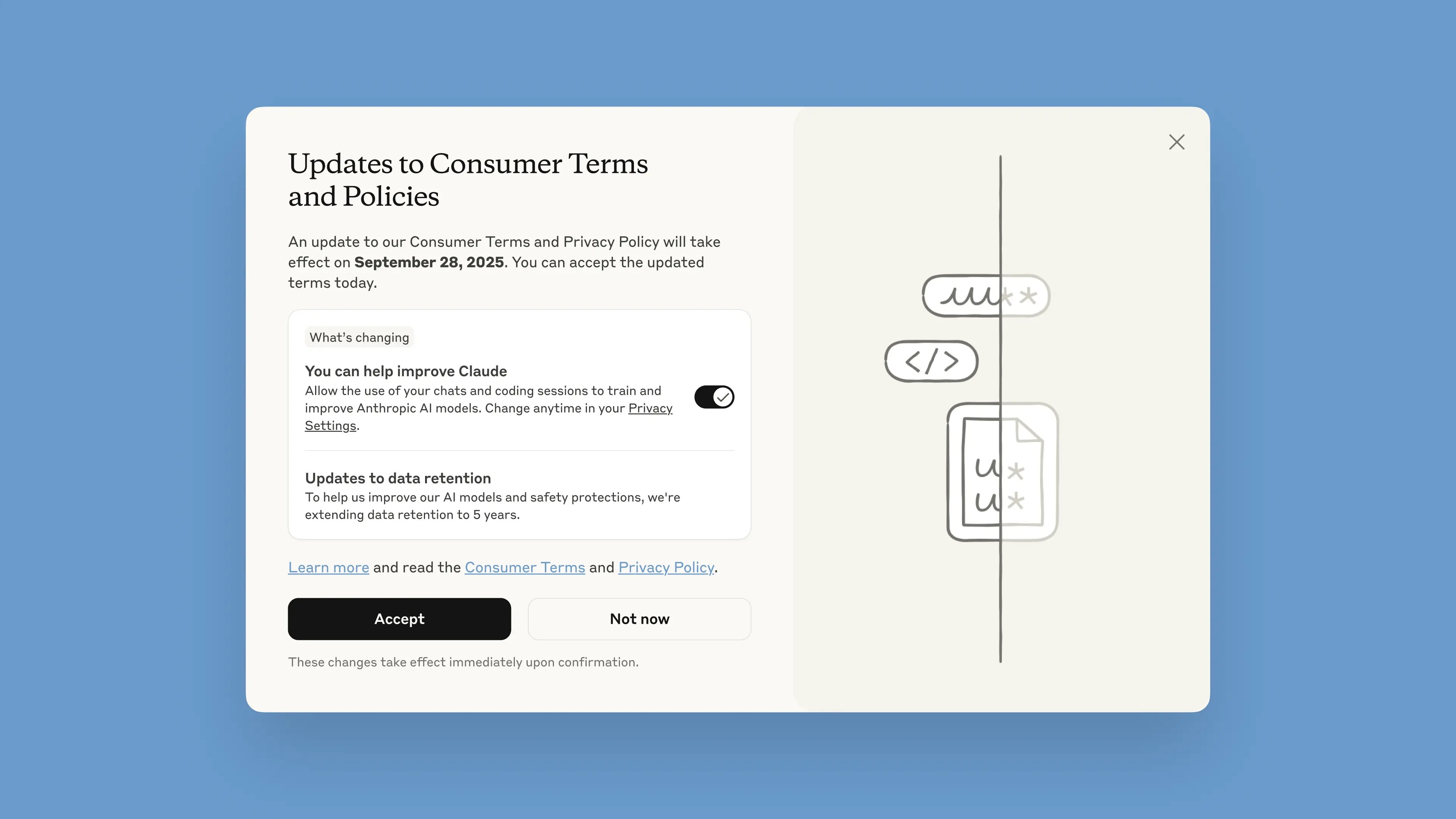

Această notificare va fi implementată în chatbot începând cu 28 august. Utilizatorii au la dispoziție o lună pentru a accepta sau a refuza termenii. Noile politici vor intra în vigoare imediat după acceptare. După 28 septembrie, utilizatorii vor trebui să se înscrie pentru a continua să utilizeze Claude.

Potrivit companiei, actualizările sunt menite să contribuie la furnizarea unor modele de inteligență artificială mai puternice și mai utile. Ajustarea acestei opțiuni este simplă și se poate face oricând în Setările de confidențialitate.

Aceste modificări se aplică planurilor Claude Free, Pro și Max, care includ Claude Code, instrumentul de programare Anthropic. Serviciile acoperite de Termenii Comerciali nu se vor aplica, inclusiv Claude for Work, Claude Gov, Claude for Education sau utilizarea API-urilor, inclusiv prin intermediul unor terțe părți precum Amazon Bedrock și Vertex AI de la Google Cloud.

Prin participare, utilizatorii vor contribui la îmbunătățirea siguranței modelului, sporindu-i capacitatea de a detecta cu precizie conținutul dăunător și reducând riscul de a marca din greșeală conversații inofensive, a precizat Anthropic în postarea sa pe blog. Versiunile viitoare ale Claude vor fi, de asemenea, îmbunătățite cu abilități precum programarea, analiza și raționamentul.

Este important ca utilizatorii să aibă control deplin asupra datelor lor și dacă permit sau nu platformei să le utilizeze într-o fereastră pop-up. Conturile noi pot configura opțional acest lucru în timpul procesului de înregistrare.

|

Fereastră pop-up Termeni noi în chatbot. Fotografie: Anthropic. |

Perioada de păstrare a datelor a fost mărită la cinci ani, ceea ce se aplică conversațiilor sau sesiunilor de codare noi sau continue, precum și răspunsurilor la răspunsurile chatbot-urilor. Datele șterse nu vor fi utilizate pentru antrenarea modelului în viitor. Dacă utilizatorii nu optează pentru furnizarea de date pentru antrenament, aceștia vor continua politica actuală de păstrare de 30 de zile.

Explicând politica, Anthropic a spus că ciclurile de dezvoltare a inteligenței artificiale durează de obicei ani de zile, iar menținerea consecvenței datelor pe tot parcursul procesului de antrenament ajută, de asemenea, modelele să rămână consecvente. Păstrarea mai lungă a datelor îmbunătățește, de asemenea, clasificatorii, sisteme utilizate pentru a identifica comportamentul abuziv, pentru a detecta tipare dăunătoare.

„Pentru a proteja confidențialitatea utilizatorilor, folosim o combinație de instrumente și procese automate pentru a filtra sau masca datele sensibile. Nu vindem datele utilizatorilor către terți”, a scris compania.

Anthropic este adesea citată ca fiind unul dintre liderii în domeniul inteligenței artificiale sigure. Anthropic a dezvoltat o abordare numită IA constituțională, care stabilește principii și linii directoare etice pe care modelele trebuie să le urmeze. Anthropic este, de asemenea, una dintre companiile care a semnat Angajamentele pentru o inteligență artificială sigură cu guvernele SUA, Regatului Unit și G7.

Sursă: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

![[Foto] Secretarul general To Lam îl primește pe directorul Academiei de Administrație Publică și Economie Națională pe lângă Președintele Federației Ruse](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F08%2F1765200203892_a1-bnd-0933-4198-jpg.webp&w=3840&q=75)

Comentariu (0)