Den komplexa bilden av att använda AI-mördarrobotar.

Att låta AI styra vapensystem kan innebära att mål identifieras, attackeras och förstörs utan mänsklig inblandning. Detta väcker allvarliga juridiska och etiska frågor.

Österrikes utrikesminister Alexander Schallenberg betonade allvaret i situationen och konstaterade: "Detta är vår generations Oppenheimer-ögonblick."

Robotar och vapen som drivs av artificiell intelligens börjar användas i stor utsträckning i militären i många länder. Foto: Forbes

I vilken utsträckning "anden har undkommit burken" har faktiskt blivit en angelägen fråga, med tanke på den utbredda användningen av drönare och artificiell intelligens (AI) av militärer runt om i världen .

GlobalDatas försvarsanalytiker Wilson Jones delade: ”Rysslands och Ukrainas användning av drönare i moderna konflikter, USA:s användning av drönare i riktade attackoperationer i Afghanistan och Pakistan, och, som nyligen avslöjades förra månaden, som en del av Israels Lavender-program, visar hur AI:s informationsbehandlingskapacitet aktivt har använts av världens militärer för att förbättra sin offensiva kraft.”

Utredningar utförda av det Londonbaserade Office of War Investigations visade att den israeliska militärens Lavender AI-system hade en noggrannhet på 90 % när det gällde att identifiera individer med kopplingar till Hamas, vilket innebär att 10 % inte gjorde det. Detta resulterade i civila offer på grund av AI:ns identifierings- och beslutsfattande förmåga.

Ett hot mot den globala säkerheten.

Användningen av AI på detta sätt understryker behovet av teknikhantering i vapensystem.

Dr. Alexander Blanchard, seniorforskare i programmet för styrning av artificiell intelligens vid Stockholms internationella fredsforskningsinstitut (SIPRI), en oberoende forskargrupp inriktad på global säkerhet, förklarade för Army Technology: ”Användningen av AI i vapensystem, särskilt när den används för målsökande, väcker grundläggande frågor om vilka vi är – människor – och vår relation till krig, och mer specifikt, våra antaganden om hur vi kan använda våld i väpnade konflikter.”

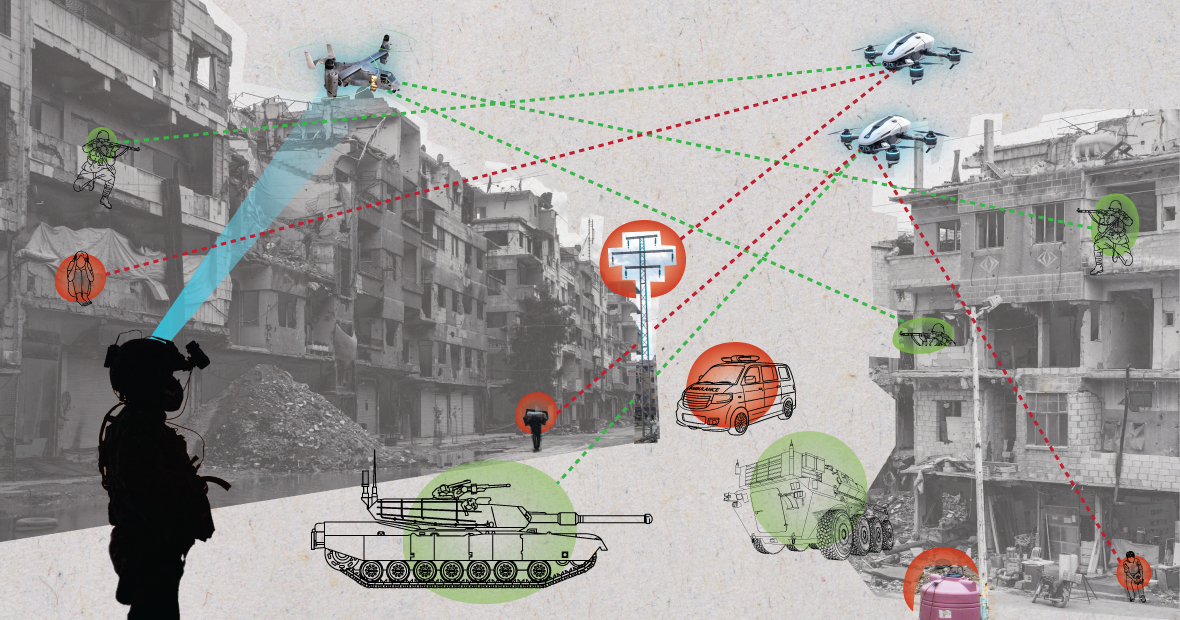

När AI-system används i kaotiska miljöer kan de fungera oförutsägbart och kanske inte identifierar mål korrekt. (Bild: MES)

”Kommer AI att förändra hur militärer väljer ut mål och utövar våld mot dem? Dessa förändringar väcker i sin tur en rad juridiska, etiska och operativa frågor. Den största oron är humanitär”, tillade Dr. Blanchard.

SIPRI-experten förklarade: ”Många oroar sig för att automatiserade system, beroende på hur de utformas och används, kan utsätta civila och andra som skyddas av internationell rätt för större risk att skadas. Detta beror på att AI-system, särskilt när de används i kaotiska miljöer, kan fungera oförutsägbart och kan misslyckas med att korrekt identifiera mål och attackera civila, eller misslyckas med att identifiera stridande som befinner sig utanför skottlinjen.”

I en utveckling av denna fråga noterar försvarsanalytikern Wilson Jones på GlobalData att frågan om hur skuld definieras kan ifrågasättas.

”Enligt gällande krigslagar finns konceptet befälsansvar”, sa Jones. ”Detta innebär att en officer, general eller annan ledare är juridiskt ansvarig för de truppers handlingar som står under deras befäl utför. Om trupperna begår krigsförbrytelser hålls officeren ansvarig även om de inte gav ordern; bevisbördan ligger hos dem, att visa att de gjorde allt för att förhindra krigsförbrytelserna.”

”Med AI-system komplicerar detta saker och ting. Är en IT-tekniker ansvarig? En systemdesigner? Det är inte tydligt. Om det inte är tydligt skapar det en moralisk risk om aktörer tror att deras handlingar inte skyddas av befintliga lagar”, betonade Jones.

En amerikansk soldat patrullerar med en robothund. Foto: Forbes

Vapenkontrollkonventioner: Flera viktiga internationella avtal begränsar och reglerar vissa användningsområden för vapen. Dessa inkluderar förbudet mot kemiska vapen, icke-spridningsavtalen för kärnvapen och konventionen om vissa konventionella vapen, som förbjuder eller begränsar användningen av specifika vapen som anses orsaka onödigt eller oberättigat lidande för stridande eller urskillningslöst drabba civila.

”Kärnvapenkontroll kräver årtionden av internationellt samarbete och efterföljande fördrag för att vara verkställbara”, förklarar försvarsanalytikern Wilson Jones. ”Även då fortsatte vi med atmosfäriska tester fram till 1990-talet. En viktig anledning till framgången med icke-spridning av kärnvapen var samarbetet mellan USA och Sovjetunionen i den bipolära världsordningen. Det existerar inte längre, och AI-teknik har blivit mer tillgänglig för fler länder än atomenergi.”

”Ett bindande fördrag skulle behöva få alla inblandade parter att enas om att inte använda ett verktyg som stärker deras militära makt. Det är osannolikt att det är effektivt eftersom AI kan förbättra militär effektivitet med minimala ekonomiska och materiella kostnader.”

Nuvarande geopolitiska perspektiv

Även om länder i FN har erkänt behovet av en ansvarsfull användning av AI av militären, återstår mycket arbete att göra.

Laura Petrone, chefsanalytiker på GlobalData, berättade för Army Technology: ”På grund av bristen på ett tydligt styrande ramverk är dessa uttalanden fortfarande i stort sett ambitiösa. Det är inte förvånande att vissa länder vill behålla sin egen suveränitet när de beslutar om inrikes försvar och nationella säkerhetsfrågor, särskilt i samband med nuvarande geopolitiska spänningar.”

Fru Petrone tillade att även om EU:s AI-lag fastställer vissa krav för AI-system, omfattar den inte AI-system för militära ändamål.

”Jag anser att trots detta undantag är AI-lagen en viktig insats för att etablera ett länge efterlängtat ramverk för AI-tillämpningar, vilket skulle kunna leda till en viss grad av harmonisering av relevanta standarder i framtiden”, kommenterade hon. ”Denna harmonisering kommer också att vara avgörande för AI inom militären.”

Nguyen Khanh

[annons_2]

Källa: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

![[Foto] Premiärminister Pham Minh Chinh tar emot guvernören i Tochigi-provinsen (Japan)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Live] Gala för samhällsåtgärder 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Foto] Premiärminister Pham Minh Chinh tar emot Laos utbildnings- och idrottsminister Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Bild] Läckta bilder inför galan Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Foto] Premiärminister Pham Minh Chinh deltar i Vietnam Economic Forum 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/16/1765893035503_ndo_br_dsc-8043-jpg.webp)

Kommentar (0)