|

Der Chatbot von OpenAI wird durch neue Technologien ständig verbessert. Foto: New York Times . |

Im September 2024 brachte OpenAI ChatGPT auf den Markt, eine Version der KI, die das o1-Modell integriert und in der Lage ist, Aufgaben im Zusammenhang mit Mathematik, Naturwissenschaften und Computerprogrammierung zu lösen.

Im Gegensatz zur vorherigen Version von ChatGPT benötigt die neue Technologie Zeit, um über Lösungen für komplexe Probleme nachzudenken, bevor sie eine Antwort liefert.

Nach OpenAI haben viele Konkurrenten wie Google, Anthropic und DeepSeek ähnliche Modelle zur Verbesserung der Argumentation eingeführt. Obwohl diese Technologie noch nicht perfekt ist, genießt sie dennoch das Vertrauen vieler Entwickler und dient der Weiterentwicklung von Chatbots.

Wie KI argumentiert

Im Wesentlichen bedeutet logisches Denken, dass Chatbots mehr Zeit damit verbringen können, von Nutzern gestellte Probleme zu lösen.

„Beim logischen Denken geht es darum, wie das System nach Erhalt einer Frage zusätzliche Arbeit verrichtet“, erklärte Dan Klein, Informatikprofessor an der University of California, gegenüber der New York Times .

Ein logisches System kann ein Problem in kleinere, einzelne Schritte zerlegen oder es durch Versuch und Irrtum lösen.

ChatGPT konnte bei seiner Markteinführung Fragen sofort beantworten, indem es Informationen extrahierte und verarbeitete. Im Gegensatz dazu benötigten andere Systeme einige Sekunden (oder sogar Minuten) mehr, um das Problem zu lösen und eine Antwort zu liefern.

|

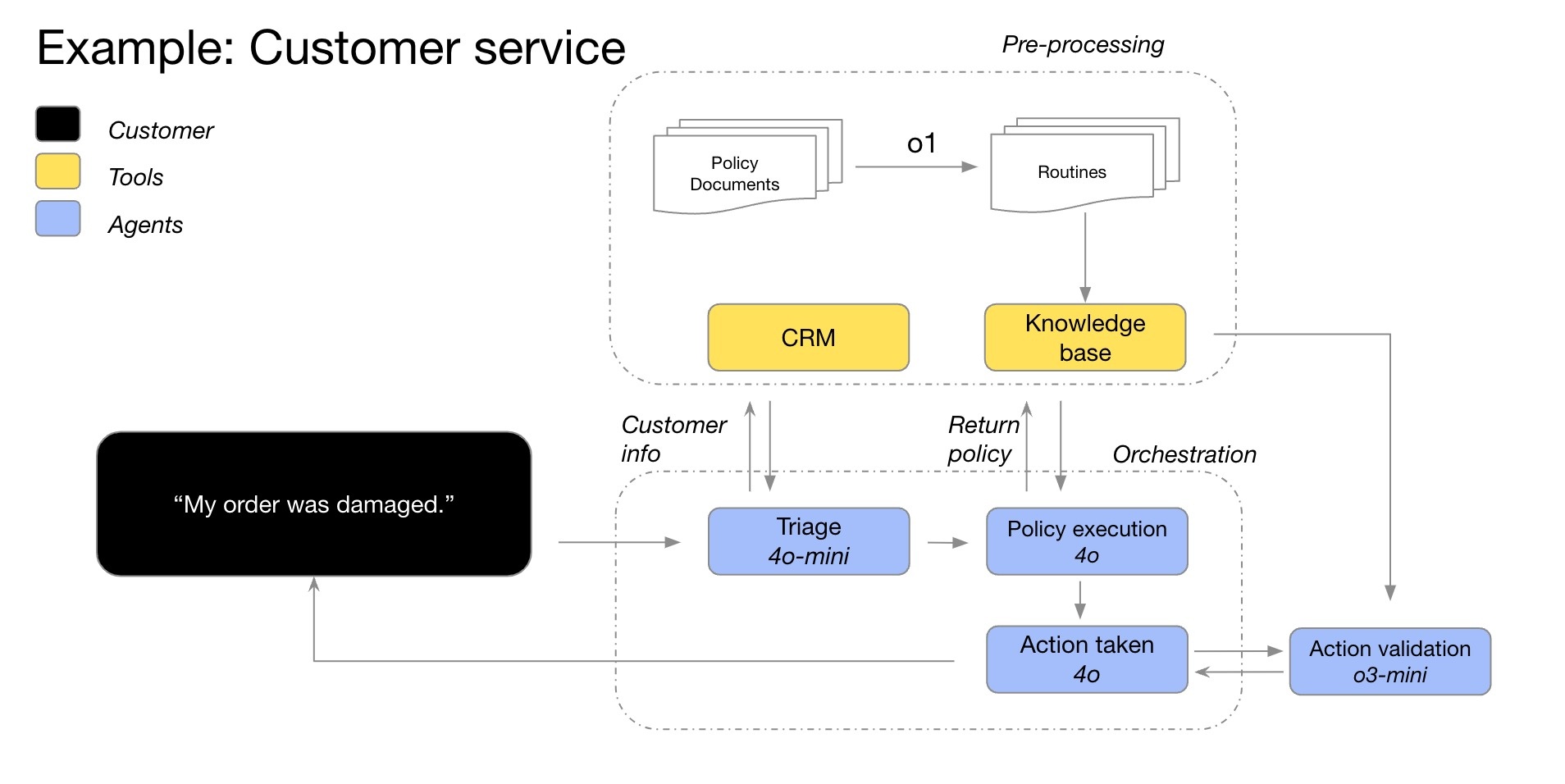

Ein Beispiel für den Denkprozess des O1-Modells in einem Kundenservice-Chatbot. Bild: OpenAI . |

In manchen Fällen ändert das System seinen Lösungsansatz und verbessert so kontinuierlich die Lösung. Darüber hinaus kann das Modell mehrere Lösungen testen, bevor es eine optimale Wahl trifft, oder die Genauigkeit vorheriger Antworten überprüfen.

Im Allgemeinen berücksichtigt das Denksystem alle möglichen Antworten auf die Frage. Dies ist vergleichbar mit Grundschülern, die viele Optionen aufschreiben, bevor sie die passendste Lösung für eine mathematische Aufgabe auswählen.

Laut der New York Times ist KI mittlerweile in der Lage, zu nahezu jedem Thema zu argumentieren. Ihre größte Effektivität wird sie jedoch bei Fragen aus den Bereichen Mathematik, Naturwissenschaften und Computerprogrammierung entfalten.

Wie wird das theoretische System trainiert?

Bei einem typischen Chatbot können Nutzer weiterhin Erklärungen zum Ablauf anfordern oder die Richtigkeit der Antwort überprüfen. Tatsächlich enthalten viele Trainingsdatensätze von ChatGPT bereits Problemlösungsverfahren.

Das Denksystem wird noch fortschrittlicher, wenn es Operationen ohne Benutzereingaben ausführen kann. Dieser Prozess ist komplexer und umfassender. Unternehmen verwenden den Begriff „logisches Denken“, weil das System ähnlich wie Menschen denkt.

Viele Unternehmen, wie beispielsweise OpenAI, erwarten, dass logische Schlussfolgerungssysteme die beste Lösung zur Verbesserung der derzeit verfügbaren Chatbots darstellen. Jahrelang gingen sie davon aus, dass Chatbots umso besser funktionieren, je mehr Informationen sie im Internet lernen.

Bis 2024 werden KI-Systeme nahezu den gesamten im Internet verfügbaren Text verbraucht haben. Das bedeutet, dass Unternehmen neue Lösungen finden müssen, um Chatbots zu verbessern, einschließlich Schlussfolgerungssystemen.

|

Das Startup DeepSeek sorgte einst mit seinem kostengünstigeren Schlussfolgerungsmodell als OpenAI für Furore. Foto: Bloomberg . |

Seit dem letzten Jahr konzentrieren sich Unternehmen wie OpenAI auf Reinforcement-Learning-Verfahren. Dieser Prozess dauert typischerweise mehrere Monate, in denen die KI durch Ausprobieren und Lernen aus Fehlern ihr Verhalten erlernt.

Beispielsweise kann das System durch das Lösen Tausender Probleme die optimale Methode zur Ermittlung der richtigen Antwort identifizieren. Darauf aufbauend entwickeln Forscher ausgeklügelte Feedbackmechanismen, die dem System helfen, zwischen richtigen und falschen Lösungen zu unterscheiden.

„Es ist ähnlich wie beim Hundetraining. Wenn das System gut funktioniert, gibt man ihm ein Leckerli. Andernfalls sagt man: ‚Dieser Hund ist unartig‘“, erklärte Jerry Tworek, Forscher bei OpenAI.

Ist KI die Zukunft?

Laut der New York Times sind Reinforcement-Learning-Verfahren effektiv bei der Bewältigung von Anforderungen in Mathematik, Naturwissenschaften und Informatik. Dies sind Bereiche, in denen richtige oder falsche Antworten klar definiert werden können.

Umgekehrt ist Reinforcement Learning in Bereichen wie Schreiben, Philosophie oder Ethik – Feldern, in denen die Unterscheidung zwischen Gut und Böse schwierig ist – ineffektiv. Dennoch behaupten Forscher, dass diese Technik die Leistung von KI auch bei nicht-mathematischen Fragestellungen verbessern kann.

„Die Systeme werden die Wege lernen, die zu positiven und negativen Ergebnissen führen“, sagte Jared Kaplan, Chief Scientific Officer bei Anthropic.

|

Website von Anthropic, dem Startup-Unternehmen, dem das KI-Modell Claude gehört. Foto: Bloomberg . |

Es ist wichtig zu verstehen, dass Reinforcement Learning und Reasoning-Systeme zwei unterschiedliche Konzepte sind. Reinforcement Learning ist eine Methode zum Aufbau von Reasoning-Systemen. Es handelt sich um die letzte Trainingsphase, die Chatbots das logische Denken ermöglicht.

Da die Forschung noch relativ neu ist, können Wissenschaftler noch nicht mit Sicherheit sagen, ob Chatbot-Logik oder bestärkendes Lernen KI helfen können, wie Menschen zu denken. Es ist anzumerken, dass sich viele aktuelle KI-Trainingstrends anfangs sehr schnell entwickeln und sich dann allmählich verlangsamen.

Darüber hinaus kann die Logik von Chatbots weiterhin Fehler machen. Basierend auf Wahrscheinlichkeiten wählt das System den Prozess, der den gelernten Daten – ob aus dem Internet oder durch bestärkendes Lernen – am ehesten entspricht. Daher können Chatbots immer noch falsche oder unlogische Lösungen wählen.

Quelle: https://znews.vn/ai-ly-luan-nhu-the-nao-post1541477.html

Kommentar (0)