|

چتبات OpenAI دائماً از طریق فناوریهای جدید در حال بهبود است. عکس: نیویورک تایمز . |

در سپتامبر ۲۰۲۴، OpenAI از ChatGPT رونمایی کرد، نسخهای از هوش مصنوعی که مدل o1 را ادغام میکند و قادر به استدلال در وظایف مربوط به ریاضیات، علوم و برنامهنویسی کامپیوتر است.

برخلاف نسخه قبلی ChatGPT، این فناوری جدید قبل از ارائه پاسخ، به زمان نیاز دارد تا در مورد راهحلهای مشکلات پیچیده «فکر» کند.

پس از OpenAI، بسیاری از رقبا مانند گوگل، Anthropic و DeepSeek نیز مدلهای استدلال مشابهی را معرفی کردهاند. اگرچه این مدل کامل نیست، اما هنوز یک فناوری ارتقاء یافته برای چتبات است که بسیاری از توسعهدهندگان به آن اعتماد دارند.

چگونه هوش مصنوعی استدلال میکند

اساساً، استدلال به این معنی است که چتباتها میتوانند زمان بیشتری را صرف حل مسائلی کنند که کاربران مطرح میکنند.

دن کلاین، استاد علوم کامپیوتر در دانشگاه کالیفرنیا، به نیویورک تایمز گفت: «استدلال به این معنی است که سیستم چگونه پس از دریافت یک سوال، کارهای اضافی انجام میدهد.»

یک سیستم منطقی میتواند یک مسئله را به مراحل کوچکتر و مجزا تقسیم کند، یا آن را از طریق آزمون و خطا حل کند.

در ابتدا، ChatGPT میتوانست با استخراج و ترکیب اطلاعات، فوراً به سؤالات پاسخ دهد. در مقابل، سیستمهای استدلال به چند ثانیه (یا حتی چند دقیقه) بیشتر برای حل مسئله و ارائه پاسخ نیاز داشتند.

|

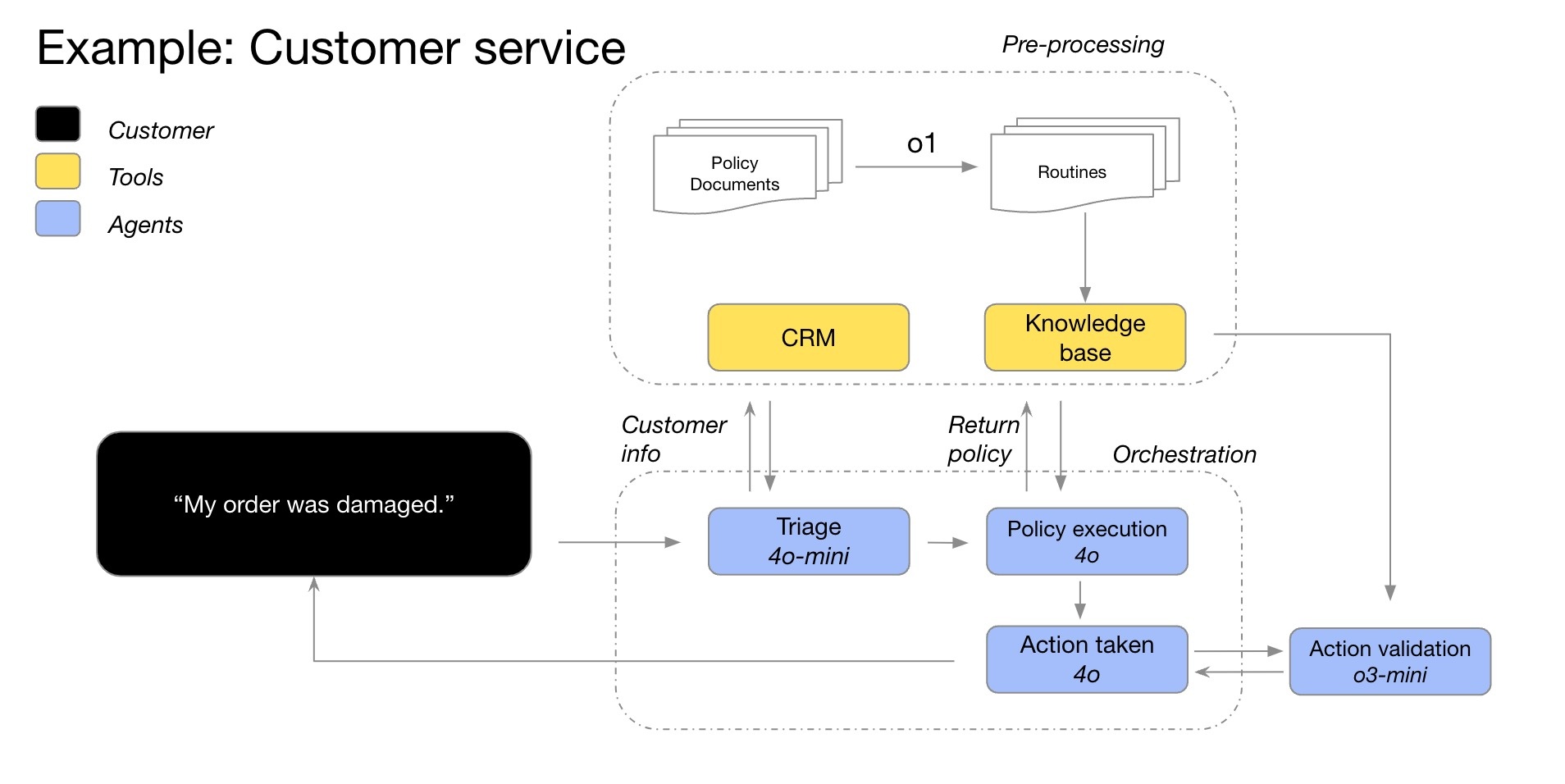

نمونهای از فرآیند استدلال مدل O1 در یک چتبات خدمات مشتری. تصویر: OpenAI . |

در برخی موارد، سیستم استدلال رویکرد خود را به مسئله تغییر میدهد و به طور مداوم راهحل را بهبود میبخشد. علاوه بر این، مدل ممکن است قبل از انتخاب بهینه، چندین راهحل را آزمایش کند یا دقت پاسخهای قبلی را بررسی کند.

به طور کلی، سیستم استدلال، تمام پاسخهای ممکن به سوال را در نظر میگیرد. این شبیه به دانشآموزان دبستانی است که قبل از انتخاب مناسبترین راه حل برای یک مسئله ریاضی، گزینههای زیادی را روی کاغذ مینویسند.

طبق گزارش نیویورک تایمز ، هوش مصنوعی اکنون قادر به استدلال تقریباً در هر موضوعی است. با این حال، در مورد سوالات مربوط به ریاضیات، علوم و برنامهنویسی کامپیوتر بیشترین تأثیر را خواهد داشت.

سیستم نظری چگونه آموزش داده میشود؟

در یک چتبات معمولی، کاربران همچنان میتوانند توضیحاتی در مورد فرآیند درخواست کنند یا صحت پاسخ را تأیید کنند. در واقع، بسیاری از مجموعه دادههای آموزشی ChatGPT از قبل شامل رویههای حل مسئله هستند.

سیستم استدلال وقتی میتواند عملیات را بدون ورودی کاربر انجام دهد، حتی پیشرفتهتر میشود. این فرآیند پیچیدهتر و گستردهتر است. شرکتها از کلمه «استدلال» استفاده میکنند زیرا این سیستم مشابه نحوه تفکر انسانها عمل میکند.

بسیاری از شرکتها، مانند OpenAI، انتظار دارند که سیستمهای استدلال بهترین راهحل برای بهبود چتباتهای موجود باشند. سالها، آنها معتقد بودند که چتباتها هرچه اطلاعات بیشتری در اینترنت آموزش ببینند، عملکرد بهتری دارند.

تا سال ۲۰۲۴، سیستمهای هوش مصنوعی تقریباً تمام متن موجود در اینترنت را مصرف خواهند کرد. این بدان معناست که شرکتها باید راهحلهای جدیدی برای ارتقاء چتباتها، از جمله سیستمهای استدلال، پیدا کنند.

|

استارتاپ DeepSeek زمانی با مدل استدلال خود که هزینههای کمتری نسبت به OpenAI داشت، سر و صدای زیادی به پا کرد. عکس: بلومبرگ . |

از سال گذشته، شرکتهایی مانند OpenAI بر تکنیکهای یادگیری تقویتی تمرکز کردهاند. این فرآیند معمولاً چندین ماه طول میکشد و در طی آن، هوش مصنوعی از طریق آزمون و خطا رفتار را یاد میگیرد.

برای مثال، با حل هزاران مسئله، سیستم میتواند روش بهینه برای رسیدن به پاسخ صحیح را شناسایی کند. از آنجا، محققان مکانیسمهای بازخورد پیچیدهای را ایجاد میکنند که به سیستم کمک میکند تا بین راهحلهای صحیح و نادرست تمایز قائل شود.

جری توورک، محقق OpenAI، میگوید: «این شبیه به نحوه آموزش یک سگ است. اگر سیستم خوب کار کند، به آن خوراکی میدهید. در غیر این صورت، میگویید: 'آن سگ شیطان است'».

آیا هوش مصنوعی آینده است؟

طبق گزارش نیویورک تایمز ، تکنیکهای یادگیری تقویتی در مواجهه با الزامات در ریاضیات، علوم و برنامهنویسی کامپیوتر مؤثر هستند. اینها زمینههایی هستند که در آنها میتوان پاسخهای صحیح یا غلط را به وضوح تعریف کرد.

برعکس، یادگیری تقویتی در نویسندگی، فلسفه یا اخلاق - حوزههایی که تشخیص خوب از بد دشوار است - بیاثر است. با این وجود، محققان ادعا میکنند که این تکنیک حتی با سوالات غیر ریاضی نیز میتواند عملکرد هوش مصنوعی را بهبود بخشد.

جرد کاپلان، مدیر ارشد علمی در آنتروپیک، گفت: «سیستمها مسیرهایی را که منجر به نتایج مثبت و منفی میشوند، یاد خواهند گرفت.»

|

وبسایت آنتروپیک، استارتاپی که مالک مدل هوش مصنوعی کلود است. عکس: بلومبرگ . |

لازم به ذکر است که یادگیری تقویتی و سیستمهای استدلال دو مفهوم متفاوت هستند. به طور خاص، یادگیری تقویتی روشی برای ساخت سیستمهای استدلال است. این مرحله نهایی آموزش برای فعال کردن رباتهای چت برای استدلال است.

از آنجایی که هنوز نسبتاً جدید است، دانشمندان هنوز نمیتوانند با اطمینان بگویند که آیا استدلال چتبات یا یادگیری تقویتی میتواند به هوش مصنوعی کمک کند تا مانند انسانها فکر کند. باید توجه داشت که بسیاری از روندهای فعلی آموزش هوش مصنوعی در ابتدا بسیار سریع توسعه مییابند و سپس به تدریج کند میشوند.

علاوه بر این، استدلال چتباتها هنوز هم میتواند اشتباه کند. بر اساس احتمال، سیستم فرآیندی را انتخاب میکند که بیشترین شباهت را به دادههایی که آموخته است، چه از طریق اینترنت و چه از طریق یادگیری تقویتی، داشته باشد. بنابراین، چتباتها هنوز هم میتوانند راهحلهای نادرست یا غیرمنطقی را انتخاب کنند.

منبع: https://znews.vn/ai-ly-luan-nhu-the-nao-post1541477.html

نظر (0)