تصاویر جعلی هوش مصنوعی چگونه کار میکنند؟

هوش مصنوعی این روزها همه جا هست - حتی در جنگ. برنامههای هوش مصنوعی امسال آنقدر پیشرفت کردهاند که تقریباً هر کسی میتواند از مولدهای هوش مصنوعی برای ایجاد تصاویری استفاده کند که حداقل در نگاه اول واقعگرایانه به نظر برسند.

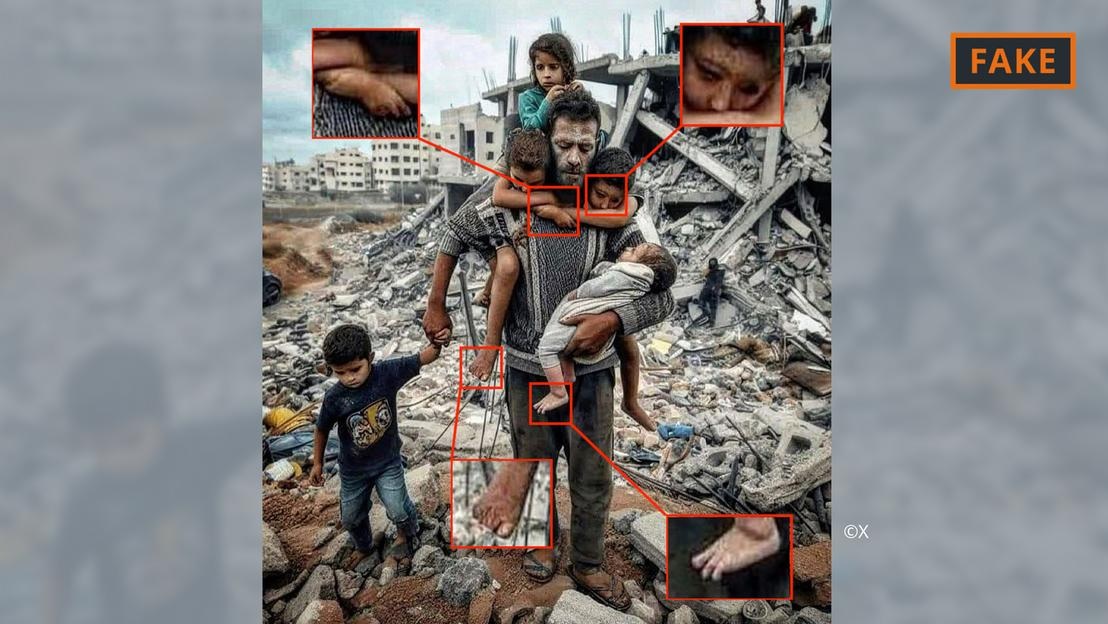

یک عکس جعلی تولید شده توسط هوش مصنوعی از جنگ غزه.

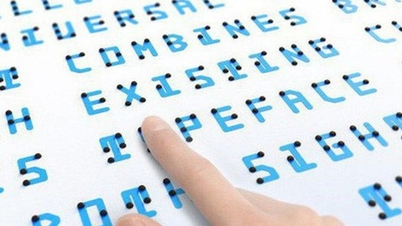

کاربران به سادگی ابزارهایی مانند Midjourney یا Dall-E را با چند دستورالعمل، شامل مشخصات و اطلاعات، برای انجام این کار ارائه میدهند. سپس ابزارهای هوش مصنوعی، متن یا حتی صدا را به تصاویر تبدیل میکنند.

این فرآیند تولید تصویر مبتنی بر چیزی است که به عنوان یادگیری ماشینی شناخته میشود. به عنوان مثال، اگر یک سازنده بخواهد یک مرد ۷۰ ساله را در حال دوچرخهسواری نشان دهد، آنها پایگاه داده خود را برای مطابقت با عبارات با تصاویر جستجو میکنند.

بر اساس اطلاعات موجود، الگوریتم هوش مصنوعی تصویری از دوچرخهسوار مسن تولید میکند. با ورودیهای بیشتر و بهروزرسانیهای فنی، این ابزارها به طور قابل توجهی بهبود یافتهاند و دائماً در حال یادگیری هستند.

همه این موارد در مورد تصاویر مربوط به درگیریهای خاورمیانه اعمال میشود. هانی فرید، متخصص هوش مصنوعی، میگوید در درگیریهایی که «احساسات بسیار بالاست»، اطلاعات نادرست، از جمله انتشار از طریق تصاویر هوش مصنوعی، تأثیر زیادی دارد.

فرید، استاد تحلیل دیجیتال در دانشگاه کالیفرنیا در برکلی، گفت که نبردهای شدید، زمینه مناسبی برای ایجاد و انتشار محتوای جعلی و همچنین دامن زدن به احساسات هستند.

انواع تصاویر هوش مصنوعی از جنگ اسرائیل و حماس

تصاویر و ویدیوهایی که با کمک هوش مصنوعی ایجاد شدهاند، به انتشار اطلاعات نادرست مربوط به جنگ اوکراین دامن زدهاند و این روند در جنگ اسرائیل و حماس همچنان ادامه دارد.

به گفته کارشناسان، تصاویر هوش مصنوعی که در رسانههای اجتماعی درباره جنگ منتشر میشوند، اغلب به دو دسته تقسیم میشوند. یکی بر رنج مردم تمرکز دارد و همدردی را برمیانگیزد. دیگری هوش مصنوعی جعلی است که وقایع را اغراق میکند و در نتیجه باعث تحریک درگیری و تشدید خشونت میشود.

عکس جعلی تولید شده توسط هوش مصنوعی از پدر و فرزند در آوار غزه.

برای مثال، دسته اول شامل عکس بالا از یک پدر و پنج فرزندش در مقابل تلی از آوار است. این عکس چندین بار در X (که قبلاً توییتر بود) و اینستاگرام به اشتراک گذاشته شد و صدها هزار بار دیده شد.

این تصویر توسط جامعه، حداقل در X، به عنوان جعلی علامتگذاری شده است. این تصویر را میتوان از روی خطاها و تناقضات مختلف رایج در تصاویر هوش مصنوعی تشخیص داد (به تصویر بالا مراجعه کنید).

ناهنجاریهای مشابهی را میتوان در تصویر جعلی هوش مصنوعی که در X زیر به صورت ویروسی منتشر شده است، مشاهده کرد که ظاهراً یک خانواده فلسطینی را در حال غذا خوردن با هم در خرابهها نشان میدهد.

عکس جعلی تولید شده توسط هوش مصنوعی از یک مهمانی فلسطینی.

در همین حال، تصویر دیگری که سربازان را در حال تکان دادن پرچم اسرائیل در حال عبور از میان شهرکی پر از خانههای بمباران شده نشان میدهد، در دسته دوم قرار میگیرد که برای دامن زدن به نفرت و خشونت طراحی شده است.

چنین تصاویر هوش مصنوعی از کجا میآیند؟

بیشتر تصاویر تولید شده توسط هوش مصنوعی از درگیریها در پلتفرمهای رسانههای اجتماعی منتشر میشوند، اما در تعدادی از پلتفرمها و سازمانهای دیگر و حتی در برخی سایتهای خبری نیز در دسترس هستند.

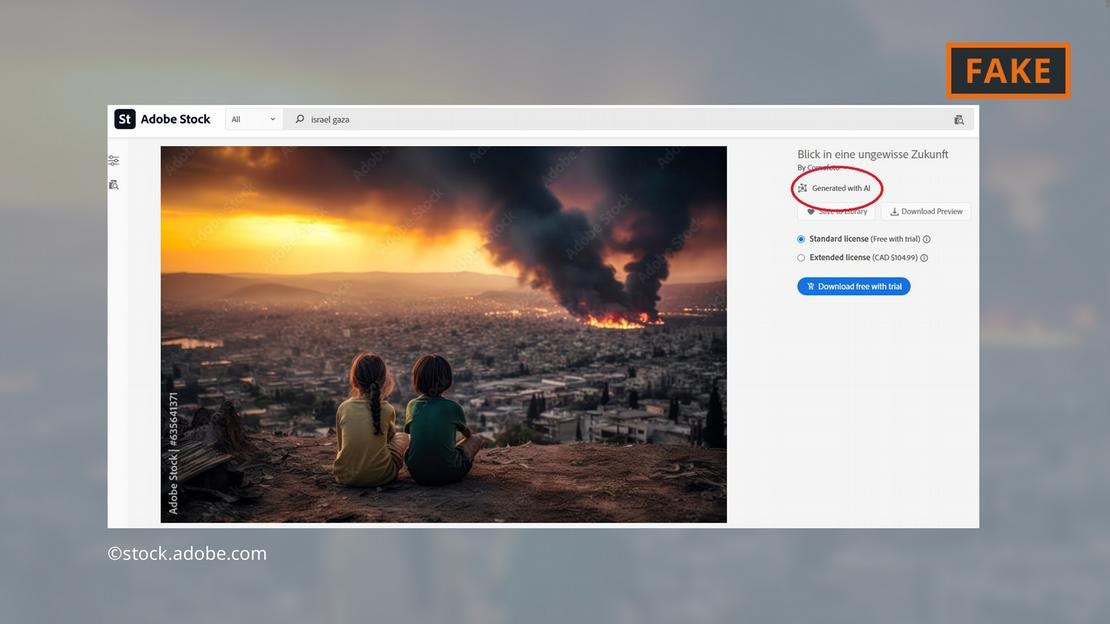

شرکت نرمافزاری ادوبی با افزودن تصاویر تولید شده توسط هوش مصنوعی به مجموعه عکسهای آرشیوی خود تا پایان سال ۲۰۲۲، خبرساز شده است. این تصاویر بر اساس این تصاویر در پایگاه داده برچسبگذاری خواهند شد.

ادوبی همچنین اکنون تصاویر هوش مصنوعی از جنگ خاورمیانه را برای فروش ارائه میدهد - مانند انفجارها، اعتراضات مردم یا دود غلیظ پشت مسجد الاقصی.

شرکت ادوبی تصاویر تولید شده توسط هوش مصنوعی از جنگ غزه را ارائه میدهد.

منتقدان این موضوع را نگرانکننده دانستهاند، زیرا برخی سایتها بدون اینکه به تصاویر برچسب تولید شده توسط هوش مصنوعی بزنند، به استفاده از آنها ادامه دادهاند. به عنوان مثال، تصویر مورد بحث بدون هیچ نشانهای مبنی بر تولید شدن توسط هوش مصنوعی در صفحه «خبر فوری» ظاهر شد.

حتی سرویس تحقیقات پارلمانی اروپا، بازوی علمی پارلمان اروپا، متنی آنلاین در مورد درگیری خاورمیانه را با استفاده از یک تصویر هوش مصنوعی از پایگاه داده ادوبی مصورسازی کرد - بدون اینکه آن را به عنوان تولید شده توسط هوش مصنوعی برچسب گذاری کند.

رصدخانه رسانههای دیجیتال اروپا از روزنامهنگاران و متخصصان رسانه میخواهد که هنگام استفاده از تصاویر هوش مصنوعی بسیار محتاط باشند و توصیه میکند که از استفاده از آنها، به ویژه هنگام پوشش رویدادهای واقعی مانند جنگ غزه، خودداری کنند.

تصاویر هوش مصنوعی چقدر خطرناک هستند؟

محتوا و تصاویر ویروسی هوش مصنوعی مطمئناً باعث میشود کاربران نسبت به هر چیزی که به صورت آنلاین با آن مواجه میشوند، احساس ناراحتی کنند. فرید، محقق دانشگاه کالیفرنیا، برکلی، توضیح میدهد: «اگر وارد این دنیایی شویم که تصاویر، صدا و ویدیو قابل دستکاری باشند ، همه چیز مشکوک میشود. بنابراین شما اعتماد خود را به همه چیز، از جمله حقیقت، از دست میدهید.»

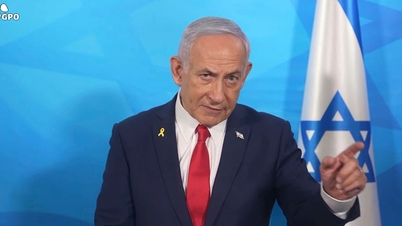

این دقیقاً همان اتفاقی است که در مورد زیر افتاد: تصویری از آنچه که گمان میرود جسد سوخته یک نوزاد اسرائیلی باشد، توسط بنیامین نتانیاهو، نخست وزیر اسرائیل، و چند سیاستمدار دیگر در رسانههای اجتماعی به اشتراک گذاشته شد.

جکسون هینکل، اینفلوئنسر ضد اسرائیلی، بعداً ادعا کرد که این تصویر با استفاده از هوش مصنوعی ساخته شده است. اظهارات هینکل بیش از 20 میلیون بار در رسانههای اجتماعی مشاهده شد و منجر به بحثهای داغی در این پلتفرم شد.

در نهایت، سازمانها و ابزارهای تأیید هویت متعددی اعلام کردند که تصویر واقعی بوده و ادعای هینکل نادرست است. با این حال، واضح است که هیچ ابزاری نمیتواند به کاربران کمک کند تا به راحتی اعتماد از دست رفته خود را بازیابند!

هوانگ های (طبق گزارش دویچه وله)

منبع

نظر (0)