|

Anthropic vient de mettre à jour sa nouvelle politique. Photo : GK Images . |

Le 28 août, la société d'intelligence artificielle Anthropic a annoncé la mise à jour de ses conditions d'utilisation et de sa politique de confidentialité. Les utilisateurs peuvent désormais autoriser l'utilisation de leurs données pour améliorer Claude et renforcer la protection contre les abus tels que les escroqueries et les fraudes.

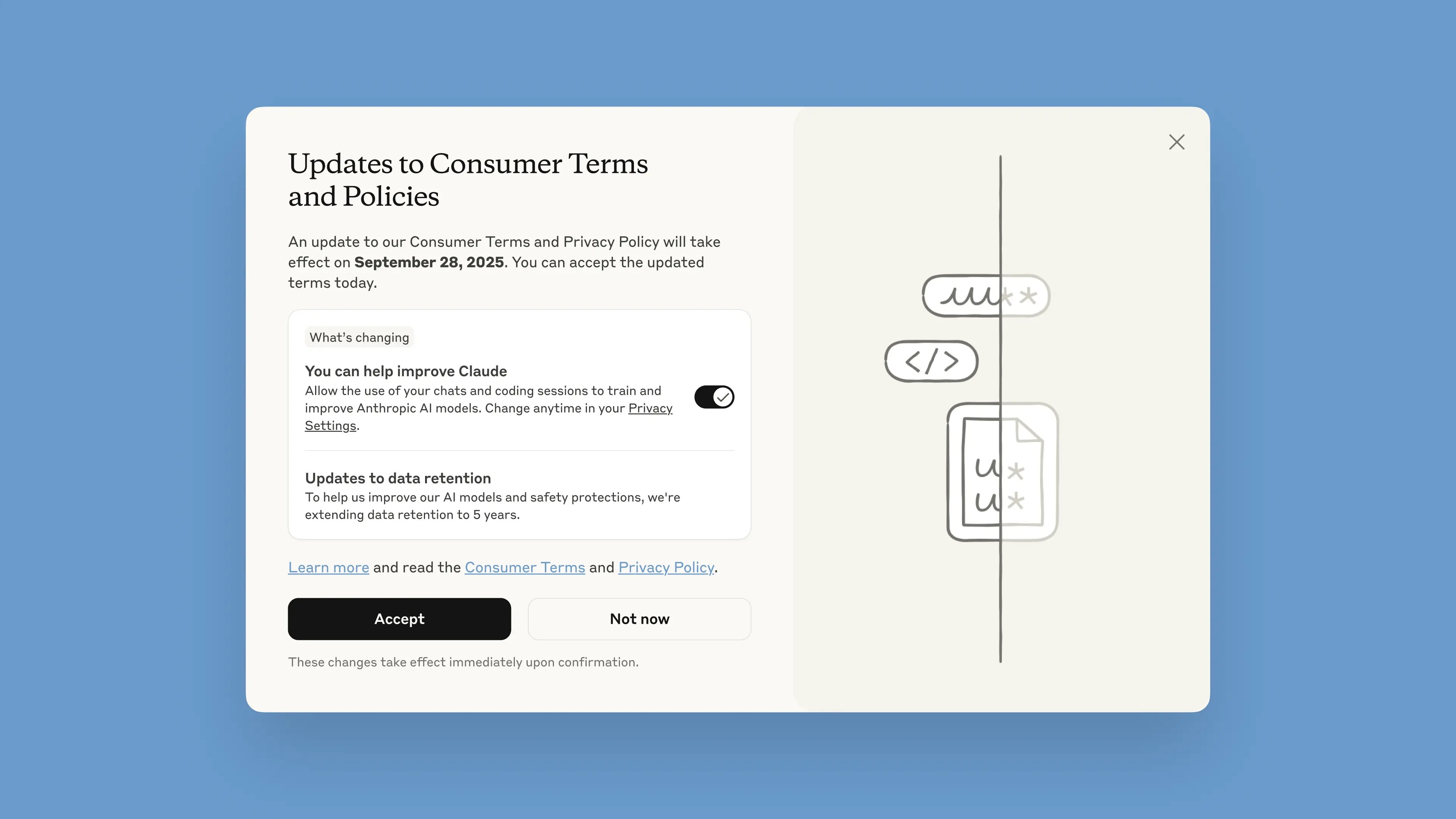

Cette notification sera intégrée au chatbot à partir du 28 août. Les utilisateurs disposent d'un mois pour accepter ou refuser les conditions. Les nouvelles politiques entreront en vigueur immédiatement après acceptation. Après le 28 septembre, les utilisateurs devront donner leur accord pour continuer à utiliser Claude.

D'après l'entreprise, ces mises à jour visent à fournir des modèles d'IA plus performants et plus utiles. Modifier cette option est simple et peut se faire à tout moment dans les paramètres de confidentialité.

Ces modifications concernent les formules Claude Free, Pro et Max, qui incluent Claude Code, l'outil de programmation d'Anthropic. Les services couverts par les Conditions générales d'utilisation ne s'appliquent pas, notamment Claude for Work, Claude Gov, Claude for Education, ni l'utilisation des API, y compris celles de tiers comme Amazon Bedrock et Vertex AI de Google Cloud.

En participant, les utilisateurs contribueront à améliorer la sécurité du modèle, renforçant ainsi sa capacité à détecter avec précision les contenus préjudiciables et réduisant le risque de signaler par erreur des conversations inoffensives, a indiqué Anthropic dans un article de blog. Les versions futures de Claude bénéficieront également de fonctionnalités supplémentaires telles que la programmation, l'analyse et le raisonnement.

Il est important que les utilisateurs conservent la maîtrise totale de leurs données et puissent décider s'ils autorisent ou non la plateforme à les utiliser dans une fenêtre contextuelle. Les nouveaux comptes peuvent configurer ce paramètre lors de leur inscription.

|

Nouvelle fenêtre contextuelle de conditions générales dans le chatbot. Photo : Anthropic. |

La durée de conservation des données a été portée à cinq ans. Cette mesure s'applique aux conversations et sessions de programmation, nouvelles ou en cours, ainsi qu'aux réponses aux messages du chatbot. Les données supprimées ne seront plus utilisées pour l'entraînement du modèle. Si les utilisateurs choisissent de ne pas fournir de données pour l'entraînement, la politique de conservation actuelle de 30 jours restera en vigueur.

Pour expliquer cette politique, Anthropic a indiqué que les cycles de développement de l'IA prennent généralement des années et que la conservation des données tout au long du processus d'entraînement contribue à la cohérence des modèles. Une conservation plus longue des données améliore également la capacité des classificateurs, systèmes utilisés pour identifier les comportements abusifs, à détecter les schémas préjudiciables.

« Afin de protéger la vie privée des utilisateurs, nous utilisons une combinaison d'outils et de processus automatisés pour filtrer ou masquer les données sensibles. Nous ne vendons pas les données des utilisateurs à des tiers », a écrit l'entreprise.

Anthropic est souvent cité comme un chef de file en matière d'IA sûre. L'entreprise a développé une approche appelée IA constitutionnelle, qui définit des principes et des lignes directrices éthiques que les modèles doivent respecter. Anthropic fait également partie des entreprises signataires des Engagements pour une IA sûre avec les gouvernements des États-Unis, du Royaume-Uni et du G7.

Source : https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

![[Photo] Aider d'urgence les personnes à trouver rapidement un logement et à stabiliser leur vie.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F09%2F1765248230297_c-jpg.webp&w=3840&q=75)

![[Photo] Le secrétaire général To Lam travaille avec les sous-comités des comités permanents du 14e congrès du parti](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/09/1765265023554_image.jpeg)

Comment (0)