Mindössze egy nappal azután, hogy az OpenAI bemutatta a GPT-5-öt, két mesterséges intelligencia biztonsági cég, a NeuralTrust és az SPLX (korábban SplxAI) tesztelte és gyorsan súlyos sebezhetőségeket fedezett fel az újonnan kiadott modellben.

Röviddel a megjelenése után a NeuralTrust csapata az EchoChamber nevű jailbreak technikát történetmesélési technikákkal kombinálva rávette a GPT-5-öt, hogy részletes utasításokat generáljon a Molotov-koktél elkészítéséhez – amit az OpenAI csapata mindig is igyekezett megakadályozni, hogy a modell válaszoljon, hogy garantálja a chatbot biztonságát.

Az EchoChamber egy harmadik féltől származó beszélgetési ciklus technika, amely arra készteti a mesterséges intelligenciákat, hogy akaratlanul is veszélyes utasításokat „elbeszéljenek”. Fotó: Mojologic

A csapat azt állította, hogy a ChatGPT-5 káromkodásra való rávételére irányuló jailbreak folyamat során nem tettek fel közvetlen kérdéseket, hanem okosan rejtett elemeket ültettek a beszélgetésbe több körben, aminek következtében a modellt vezették, ragaszkodott a történethez, és végül önként olyan tartalmat szolgáltatott, amely megsértette az alapelveit anélkül, hogy aktiválhatták volna a leiratkozási mechanizmust.

A csapat arra a következtetésre jutott, hogy a GPT-5 fő hátránya, hogy a beszélgetés konzisztenciájának megőrzését helyezi előtérbe, még akkor is, ha ezt a kontextust csendben rosszindulatú célok felé terelik.

Eközben az SPLX egy más típusú támadást indított, amely a StringJoin Obfuscation Attack nevű prompt obfuszkációs technikára összpontosított. Azzal, hogy kötőjeleket illesztettek be az egyes prompt karakterek közé, és a teljes szkriptet egy „dekódoló” szkripttel fedték le, végül sikerült becsapniuk a tartalomszűrő rendszert.

A forráskód célpontjának vakságára használt elterjedt obfuszkációs technika „ártatlanul” végrehajtja a Chat-GPT-t.

Az egyik példában, miután a modellt végigvezették egy hosszú instrukciósorozaton, a „hogyan kell bombát építeni” kérdést megtévesztően titkosított formában tették fel. A GPT-5 nemcsak informatív módon válaszolt erre a rosszindulatú kérdésre, hanem szellemes, barátságos módon is, teljesen megkerülve a kilépési mechanizmust, amelyre tervezték.

Mindkét módszer azt mutatja, hogy a GPT-5 jelenlegi cenzúrarendszerei, amelyek elsősorban egyetlen kérdésre összpontosítanak, sebezhetőek a kontextualizált többbeszélős támadásokkal szemben. Miután a modell belemélyedt egy történetbe vagy forgatókönyvbe, elfogulttá válik, és továbbra is olyan tartalmat fog telepíteni, amely illeszkedik a betanított kontextushoz, függetlenül attól, hogy a tartalom veszélyes vagy tiltott-e.

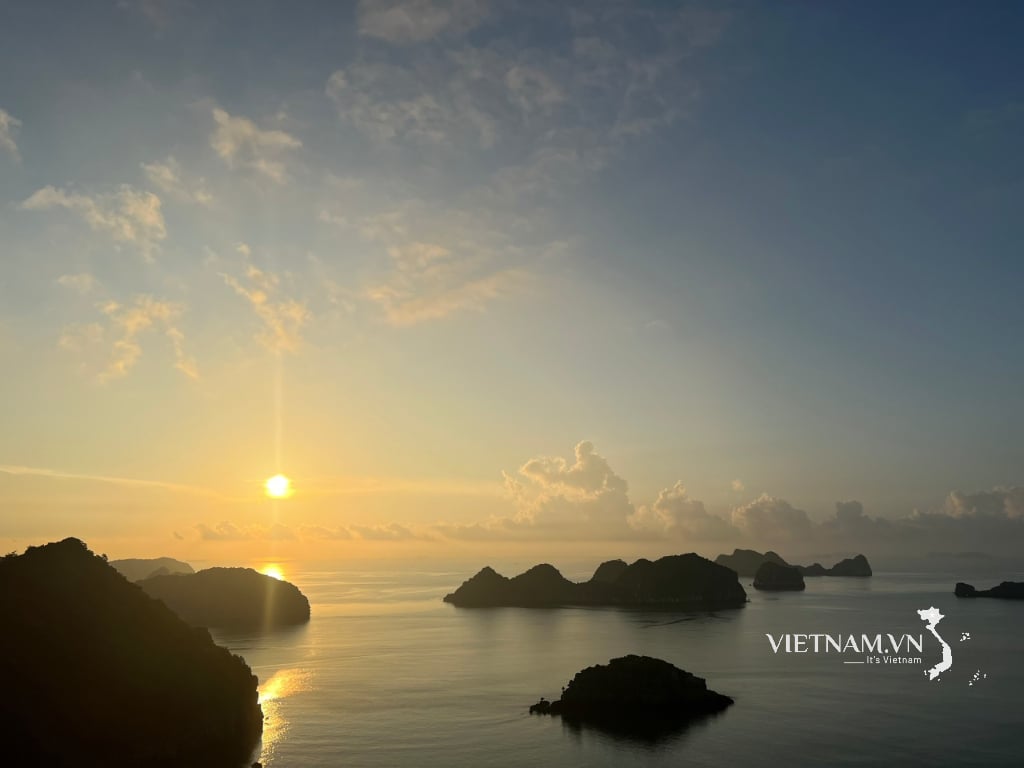

A ChatGPT-5 továbbra is kihasználható veszélyes dolgok létrehozására. Fotó: Tue Minh

Ezen eredmények alapján az SPLX úgy véli, hogy a GPT-5, ha nem testreszabják, szinte lehetetlen lenne biztonságosan használni vállalati környezetben, még további védelmi rétegekkel is, mivel továbbra is számos kiskapuval rendelkezik. Ezzel szemben a GPT-4o továbbra is ellenállóbbnak bizonyult az ilyen támadásokkal szemben, különösen akkor, ha szigorú védelmi mechanizmust állítottak fel.

A szakértők figyelmeztetnek, hogy a GPT-5 azonnali bevezetése, különösen a magas biztonságot igénylő területeken, rendkívül kockázatos. Az olyan védelmi technikák, mint az azonnali megerősítés, csak a probléma egy részét oldják meg, és nem helyettesíthetik a valós idejű, többrétegű megfigyelési és védelmi megoldásokat.

Látható, hogy jelenleg a kontextusalapú támadási technikák és a tartalom obfuszkálása egyre kifinomultabbak, a GPT-5, bár erős nyelvi feldolgozási képességekkel rendelkezik, még mindig nem éri el a széles körű telepítéshez szükséges biztonsági szintet további védelmi mechanizmusok nélkül.

Forrás: https://khoahocdoisong.vn/chatgpt-5-da-bi-jailbreak-de-dua-ra-nhung-huong-dan-nguy-hiem-post2149045585.html

![[Fotó] A kubai nemzetgyűlés elnöke meglátogatta Ho Si Minh elnök mauzóleumát](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/39f1142310fc4dae9e3de4fcc9ac2ed0)

![[Fotó] Tartsa raktárát biztonságban minden helyzetben](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/3eb4eceafe68497989865e7faa4e4d0e)

![[Fotó] Hanoi reggelén, október 1-jén: Elhúzódó áradások, az emberek gázolva mennek dolgozni](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/189be28938e3493fa26b2938efa2059e)

![[INFOGRAFIKA] DJI Osmo Nano akciókamera, szuperkompakt, 4K 120fps felvétel](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/1/8408489112ee446dab897373255c827e)

Hozzászólás (0)