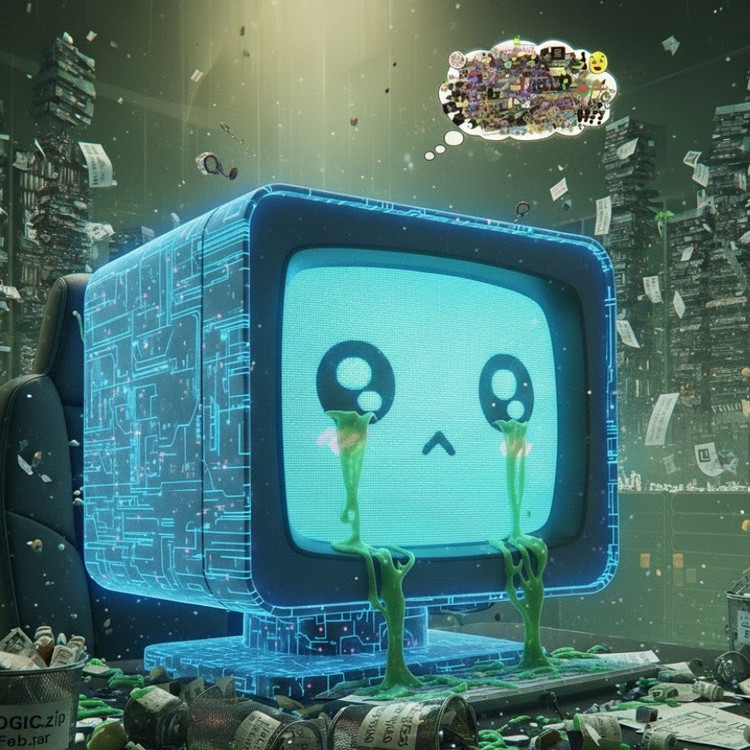

Sebuah studi baru dari University of Texas di Austin, Texas A&M University, dan Purdue University menunjukkan bahwa kecerdasan buatan dapat menjadi “rusak otak” seperti manusia ketika diberi konten media sosial berkualitas buruk.

Fenomena ini, yang dikenal sebagai “kebusukan otak AI”, menunjukkan bahwa ketika model bahasa yang besar menyerap terlalu banyak konten viral, sensasional, dan dangkal, mereka secara bertahap kehilangan kemampuan untuk berpikir logis, mengingat, dan bahkan menjadi menyimpang secara moral.

Bukan hanya manusia, AI juga mengalami degenerasi otak saat menonton terlalu banyak video pendek yang tidak berguna.

Tim peneliti, yang dipimpin oleh Junyuan Hong, yang sekarang menjadi dosen baru di Universitas Nasional Singapura, melakukan eksperimen pada dua model bahasa sumber terbuka: Llama milik Meta dan Qwen milik Alibaba.

Mereka memberi model berbagai jenis data—ada yang berupa konten informasi netral, ada pula yang berupa unggahan media sosial yang sangat adiktif dengan kata-kata umum seperti "wow," "lihat," dan "hanya hari ini." Tujuannya adalah untuk melihat apa yang terjadi ketika AI dilatih pada konten yang dirancang untuk menarik perhatian, alih-alih memberikan nilai nyata.

Hasilnya menunjukkan bahwa model yang “diberi” aliran informasi sampah daring mulai menunjukkan tanda-tanda penurunan kognitif yang jelas: kemampuan penalaran mereka melemah, daya ingat jangka pendek mereka menurun, dan, yang lebih mengkhawatirkan, mereka menjadi lebih “tidak etis” pada skala penilaian perilaku.

Beberapa pengukuran juga menunjukkan "distorsi psikologis" yang meniru respons psikologis yang dialami orang setelah terpapar konten berbahaya dalam jangka waktu lama, sebuah fenomena yang menggemakan studi sebelumnya pada manusia yang menunjukkan bahwa "doomscrolling"—pengguliran berita negatif secara terus-menerus di internet—dapat mengikis otak secara bertahap.

Frasa “brain rot” bahkan dipilih oleh Oxford Dictionaries sebagai kata tahun 2024, mencerminkan prevalensi fenomena tersebut dalam kehidupan digital.

Temuan ini merupakan peringatan serius bagi industri AI, di mana banyak perusahaan masih percaya bahwa data media sosial merupakan sumber daya pelatihan yang kaya, menurut Tn. Hong.

"Pelatihan dengan konten viral dapat membantu meningkatkan skala data, tetapi juga secara diam-diam mengikis penalaran, etika, dan perhatian model," ujarnya. Yang lebih mengkhawatirkan, model yang terdampak oleh data berkualitas buruk seperti ini tidak dapat pulih sepenuhnya bahkan setelah pelatihan ulang dengan data yang "lebih bersih".

Hal ini menimbulkan masalah besar dalam konteks AI itu sendiri yang kini memproduksi semakin banyak konten di jejaring sosial. Seiring dengan semakin meluasnya penyebaran unggahan, gambar, dan komentar yang dihasilkan AI, unggahan, gambar, dan komentar tersebut terus menjadi materi pelatihan bagi generasi AI berikutnya, menciptakan lingkaran setan yang menyebabkan penurunan kualitas data.

"Seiring menyebarnya konten sampah yang dihasilkan AI, hal itu mencemari data yang akan dipelajari oleh model-model masa depan," Hong memperingatkan. "Begitu 'kebusukan otak' ini terjadi, pelatihan ulang dengan data bersih tidak dapat sepenuhnya menyembuhkannya."

Studi ini telah membunyikan peringatan bagi para pengembang AI: sementara dunia berlomba-lomba memperluas skala data, yang lebih mengkhawatirkan adalah kita mungkin sedang mengembangkan "otak buatan" yang perlahan-lahan membusuk – bukan karena kurangnya informasi, melainkan karena terlalu banyak hal yang tidak berarti.

Sumber: https://khoahocdoisong.vn/den-ai-cung-bi-ung-nao-neu-luot-tiktok-qua-nhieu-post2149064017.html

![[Foto] Perdana Menteri Pham Minh Chinh memimpin pertemuan kedua Komite Pengarah tentang pengembangan ekonomi swasta.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/01/1762006716873_dsc-9145-jpg.webp)

Komentar (0)