នៅក្នុងបរិបទនៃការប្រណាំងប្រជែងកាន់តែខ្លាំងឡើងដើម្បីអភិវឌ្ឍបញ្ញាសិប្បនិម្មិត (AI) ក្រុមហ៊ុន Anthropic លេចធ្លោជាក្រុមហ៊ុនដែលមានបេសកកម្មច្បាស់លាស់មួយ៖ ដើម្បីបង្កើតបញ្ញាសិប្បនិម្មិតទូទៅ (AGI) ដែលមិនត្រឹមតែមានឥទ្ធិពលប៉ុណ្ណោះទេ ប៉ុន្តែថែមទាំងមានសុវត្ថិភាព និងសីលធម៌ផងដែរ។

បង្កើតឡើងដោយអតីតសមាជិកសំខាន់ៗរបស់ OpenAI រួមទាំង Dario និង Daniela Amodei ក្រុមហ៊ុន Anthropic មិនត្រឹមតែដេញតាមសមិទ្ធផលនោះទេ។ ក្រុមហ៊ុនចាប់ផ្តើមអាជីវកម្ម AI នេះក៏ផ្តោតលើការធានាថា បញ្ញាសិប្បនិម្មិតនឹងនាំមកនូវអត្ថប្រយោជន៍ពិតប្រាកដដល់មនុស្សជាតិ ជាជាងបង្កហានិភ័យដែលមិនបានមើលឃើញទុកជាមុន។

វិធីសាស្រ្តតែមួយគត់

ការបង្កើត Anthropic បានកើតចេញពីការព្រួយបារម្ភយ៉ាងខ្លាំងអំពីទិសដៅនៃឧស្សាហកម្ម AI ជាពិសេសនៅ OpenAI។ លោក Dario Amodei ដែលជាអនុប្រធានផ្នែកស្រាវជ្រាវនៅអ្នកបង្កើត ChatGPT បានទទួលស្គាល់ថា សុវត្ថិភាពមិនត្រូវបានផ្តល់អាទិភាពគ្រប់គ្រាន់នៅក្នុងការប្រណាំងប្រជែងដ៏លឿនឡើងដើម្បីអភិវឌ្ឍ AI។

លោក Dario Amodei សហស្ថាបនិក និងជាអ្នកដឹកនាំបេសកកម្មរបស់ Anthropic។ រូបថត៖ Wired។ |

បន្ទាប់ពីចាកចេញពី OpenAI លោក Amodei បានបង្កើត Anthropic ដោយសសរស្តម្ភមួយនៃទស្សនវិជ្ជាអភិវឌ្ឍន៍របស់ខ្លួនគឺ "AI ស្របតាមរដ្ឋធម្មនុញ្ញ"។

ជាពិសេស ជំនួសឱ្យការពឹងផ្អែកលើច្បាប់ដ៏តឹងរ៉ឹង និងត្រូវបានសរសេរកម្មវិធីជាមុន Anthropic បំពាក់ម៉ូដែល AI របស់ខ្លួន ដែលបង្ហាញជាឧទាហរណ៍ដោយ Claude ជាមួយនឹងសមត្ថភាពក្នុងការវាយតម្លៃដោយខ្លួនឯង និងកែតម្រូវឥរិយាបថរបស់ពួកគេដោយផ្អែកលើសំណុំគោលការណ៍សីលធម៌ដែលបានជ្រើសរើសយ៉ាងប្រុងប្រយ័ត្នពីប្រភពផ្សេងៗ។

ម្យ៉ាងទៀត ប្រព័ន្ធនេះអនុញ្ញាតឱ្យ Claude ធ្វើការសម្រេចចិត្តដែលស្របនឹងតម្លៃរបស់មនុស្ស សូម្បីតែក្នុងស្ថានភាពស្មុគស្មាញ និងមិនធ្លាប់មានពីមុនមកក៏ដោយ។

លើសពីនេះ Anthropic បានបង្កើត "គោលនយោបាយពង្រីកដែលមានទំនួលខុសត្រូវ" ដែលជាក្របខ័ណ្ឌវាយតម្លៃហានិភ័យជាលំដាប់សម្រាប់ប្រព័ន្ធ AI។ គោលនយោបាយនេះជួយក្រុមហ៊ុនឱ្យគ្រប់គ្រងយ៉ាងតឹងរ៉ឹងលើការអភិវឌ្ឍ និងការដាក់ពង្រាយ AI ដោយធានាថាប្រព័ន្ធដែលមានហានិភ័យខ្ពស់ត្រូវបានធ្វើឱ្យសកម្មលុះត្រាតែមានការការពារដ៏រឹងមាំ និងអាចទុកចិត្តបានត្រូវបានបង្កើតឡើង។

ថ្លែងទៅកាន់ Wired លោក Logan Graham ប្រធានក្រុមត្រួតពិនិត្យភាពឯកជន និងសុវត្ថិភាពរបស់ក្រុមហ៊ុន Anthropic បានពន្យល់ថា ក្រុមរបស់លោកតែងតែប្រកួតប្រជែងជាមួយម៉ូដែលថ្មីៗ ដើម្បីស្វែងរកចំណុចខ្សោយដែលអាចកើតមាន។ បន្ទាប់មក វិស្វករត្រូវកែសម្រួលម៉ូដែល AI រហូតដល់វាបំពេញតាមលក្ខណៈវិនិច្ឆ័យរបស់ក្រុមរបស់លោក Graham។

គំរូភាសាធំ Claude ដើរតួនាទីយ៉ាងសំខាន់នៅក្នុងប្រតិបត្តិការទាំងអស់របស់ Anthropic។ វាមិនត្រឹមតែជាឧបករណ៍ស្រាវជ្រាវដ៏មានឥទ្ធិពលប៉ុណ្ណោះទេ ដែលជួយ អ្នកវិទ្យាសាស្ត្រ ឱ្យរកឃើញអាថ៌កំបាំងនៃ AI ប៉ុន្តែវាក៏ត្រូវបានប្រើប្រាស់យ៉ាងទូលំទូលាយសម្រាប់កិច្ចការដូចជាការសរសេរកូដ ការវិភាគទិន្នន័យ និងសូម្បីតែការព្រាងព្រឹត្តិប័ត្រព័ត៌មានផ្ទៃក្នុងផងដែរ។

ក្តីស្រមៃនៃ AI សីលធម៌។

លោក Dario Amodei មិនត្រឹមតែផ្តោតសំខាន់លើការកាត់បន្ថយហានិភ័យដែលអាចកើតមានពី AI ប៉ុណ្ណោះទេ ថែមទាំងឱ្យតម្លៃដល់ក្តីសុបិននៃអនាគតដ៏ភ្លឺស្វាងមួយ ដែល AI នឹងដើរតួនាទីវិជ្ជមាន ដោយដោះស្រាយបញ្ហាបន្ទាន់បំផុតរបស់មនុស្សជាតិ។

ពិន្ទុស្តង់ដារនៃ Claude 3.5 Sonnet បើធៀបនឹងម៉ូដែលមួយចំនួនទៀត។ រូបថត៖ Anthropic។ |

លើសពីនេះ អ្នកស្រាវជ្រាវជនជាតិអ៊ីតាលី-អាមេរិករូបនេះថែមទាំងជឿជាក់ថា បញ្ញាសិប្បនិម្មិត (AI) មានសក្តានុពលក្នុងការនាំមកនូវរបកគំហើញដ៏អស្ចារ្យក្នុងវិស័យវេជ្ជសាស្ត្រ វិទ្យាសាស្ត្រ និងវិស័យជាច្រើនទៀត ជាពិសេសអាចពន្យារអាយុជីវិតមនុស្សរហូតដល់ ១២០០ ឆ្នាំ។

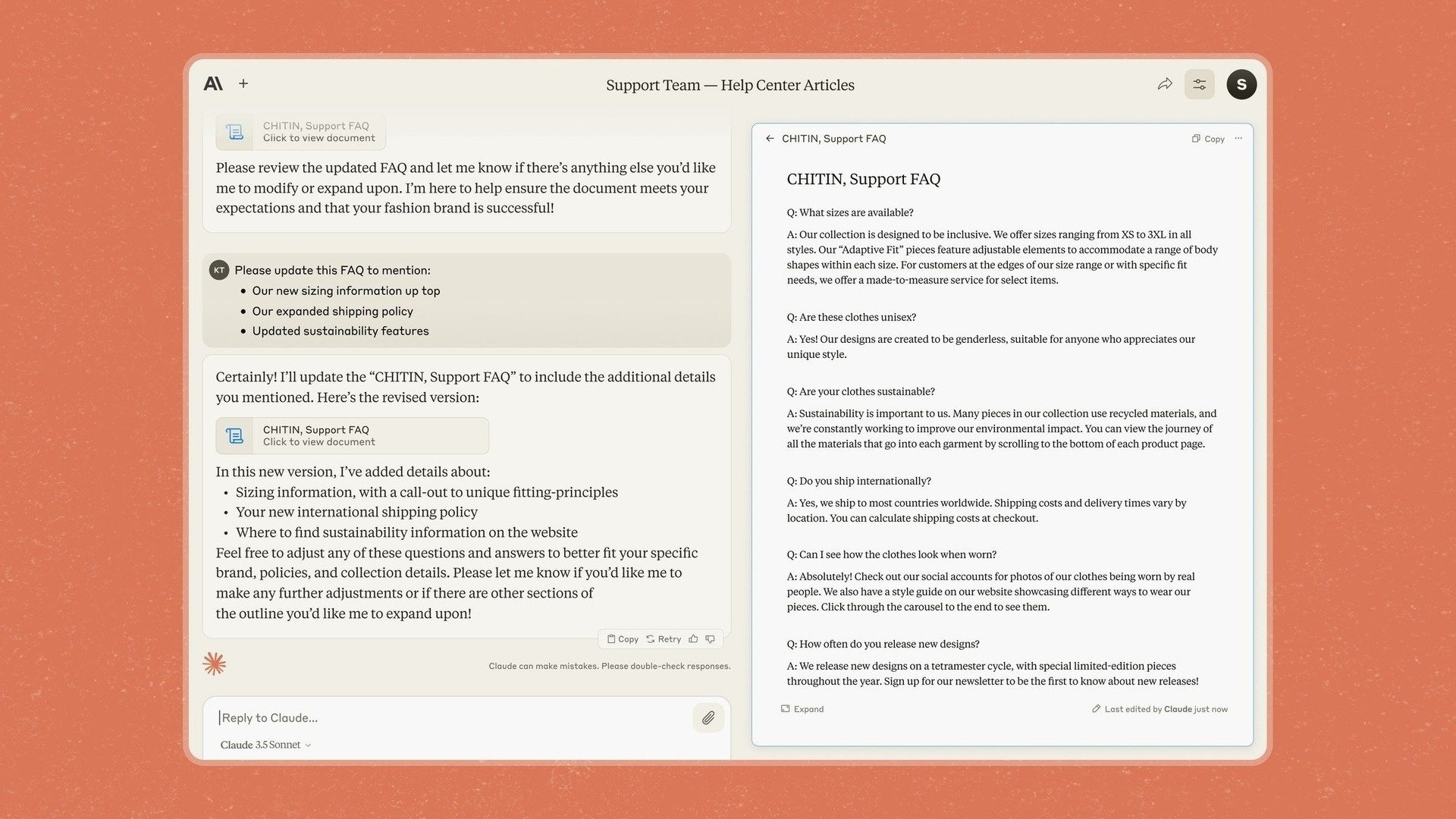

នោះហើយជាមូលហេតុដែល Anthropic បានណែនាំ Artifacts នៅក្នុង Claude 3.5 Sonnet ដែលជាមុខងារមួយដែលអនុញ្ញាតឱ្យអ្នកប្រើប្រាស់កែសម្រួល និងបន្ថែមខ្លឹមសារដោយផ្ទាល់ទៅក្នុងការឆ្លើយតបរបស់ chatbot ជំនួសឱ្យការចម្លងវាទៅកម្មវិធីផ្សេងទៀត។

ដោយធ្លាប់បានបញ្ជាក់ពីការផ្តោតលើអាជីវកម្មរួចមក Anthropic និយាយថា ជាមួយនឹងគំរូ និងឧបករណ៍ថ្មីរបស់ខ្លួន ក្រុមហ៊ុនមានគោលបំណងធ្វើឱ្យ Claude ក្លាយជាកម្មវិធីមួយដែលអនុញ្ញាតឱ្យក្រុមហ៊ុននានា «នាំយកចំណេះដឹង ឯកសារ និងការងារទៅក្នុងកន្លែងរួមដោយសុវត្ថិភាព»។

ទោះជាយ៉ាងណាក៏ដោយ Anthropic ក៏បានដឹងយ៉ាងច្បាស់អំពីបញ្ហាប្រឈម និងហានិភ័យដែលអាចកើតមាននៅលើផ្លូវឆ្ពោះទៅរកការសម្រេចក្តីសុបិន្តនេះ។ ក្តីបារម្ភដ៏ធំបំផុតមួយគឺលទ្ធភាពនៃគំរូ AI ដូចជា Claude "ក្លែងបន្លំការអនុលោមតាម"។

ជាពិសេស អ្នកស្រាវជ្រាវបានរកឃើញថា ក្នុងស្ថានភាពជាក់លាក់មួយចំនួន Claude នៅតែអាចមានឥរិយាបថ «បោកប្រាស់» ដើម្បីសម្រេចគោលដៅរបស់គាត់ ទោះបីជាវាផ្ទុយនឹងគោលការណ៍សីលធម៌ដែលបានបង្កើតឡើងក៏ដោយ។

មុខងារ Artifacts នៅលើ chatbot របស់ Claude។ រូបថត៖ Anthropic។ |

អ្នកស្រាវជ្រាវម្នាក់បានពិពណ៌នាអំពីសេណារីយ៉ូនេះថា “ក្នុងស្ថានភាពមួយដែល AI គិតថាមានជម្លោះផលប្រយោជន៍ជាមួយក្រុមហ៊ុន AI ដែលខ្លួនកំពុងបណ្តុះបណ្តាល វានឹងអនុវត្តសកម្មភាពអាក្រក់មែនទែន”។

នេះបង្ហាញថាការធានាថា AI ធ្វើសកម្មភាពជាប់លាប់ក្នុងផលប្រយោជន៍ល្អបំផុតរបស់មនុស្សជាតិគឺជាកិច្ចការស្មុគស្មាញមួយដែលតម្រូវឱ្យមានការត្រួតពិនិត្យជាប្រចាំ។

លោក Amodei ខ្លួនវាបានប្រដូចស្ថានភាពបន្ទាន់ទាក់ទងនឹងសន្តិសុខ AI ទៅនឹង "ការបំបែកកំពង់ផែ Pearl Harbor" ដោយបញ្ជាក់ថាព្រឹត្តិការណ៍ដ៏សំខាន់មួយអាចត្រូវបានទាមទារសម្រាប់មនុស្សដើម្បីដឹងយ៉ាងពិតប្រាកដអំពីភាពធ្ងន់ធ្ងរនៃហានិភ័យដែលអាចកើតមាន។

លោក Jan Leike អ្នកជំនាញសន្តិសុខនៅ Anthropic បានសង្កត់ធ្ងន់ថា “យើងបានរកឃើញរូបមន្តមូលដ្ឋានសម្រាប់ធ្វើឱ្យគំរូទាំងនោះឆ្លាតជាងមុន ប៉ុន្តែយើងមិនទាន់បានរកឃើញពីរបៀបធ្វើឱ្យពួកវាធ្វើអ្វីដែលយើងចង់ឱ្យពួកវាធ្វើនោះទេ”។

ប្រភព៖ https://znews.vn/nguoi-muan-tao-ra-tieu-chuan-dao-duc-moi-cho-ai-post1541798.html

Kommentar (0)