|

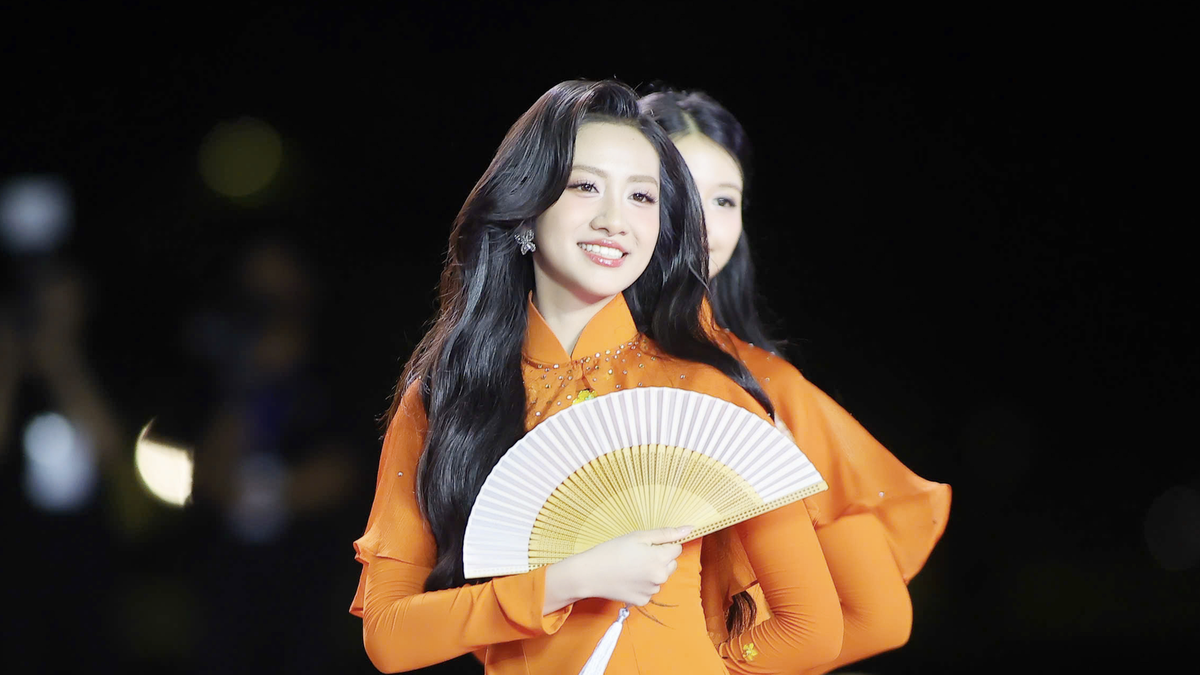

알리바바의 R1-Omni 모델은 영상 속 사람의 감정 상태를 추론할 수 있다. 사진: Xpert.Digital . |

블룸버그 에 따르면 알리바바의 통이랩은 3월 11일에 R1-Omni 모델을 오픈 소스로 공개했습니다.

이 모델의 가장 주목할 만한 특징은 영상 속 인물의 감정 상태를 추론할 수 있고, 동시에 옷차림과 주변 환경도 묘사할 수 있다는 점입니다.

이는 컴퓨터 비전 분야에서 한 걸음 더 나아간 진전이며, 알리바바의 수석 연구원인 자싱 자오가 개발한 기존 오픈소스 HumanOmni 모델의 업그레이드 버전입니다. 알리바바는 R1-Omni를 허깅 페이스(Hugging Face) 플랫폼에서 무료로 다운로드할 수 있도록 공개했습니다.

연구 보고서는 R1-Omni가 시각 및 청각 정보가 감정 인식을 어떻게 지원하는지 더 잘 이해할 수 있음을 보여줍니다. 또한, 시각 및 청각적 양식 모두에서 감정 인식을 향상시키기 위해 이 모델은 강화 학습 알고리즘을 통해 AI 시스템을 개선합니다.

강화 학습은 고급 AI 소프트웨어, 로봇, 자율 주행 자동차를 포함한 자동화된 에이전트의 의사 결정에 초점을 맞춘 일종의 머신 러닝 프로세스입니다.

이러한 자동화된 에이전트는 인간의 지시 없이 시행착오를 통해 작업을 수행하는 방법을 학습합니다. 이 기술은 불확실한 환경에서 순차적인 의사 결정 문제를 해결하기 때문에 AI 모델 개발에 중요한 요소입니다.

연구 결과에 따르면 R1-Omni 모델은 다른 모델보다 추론, 통찰력, 일반화 능력이 더 강한 것으로 나타났습니다.

출처: https://znews.vn/ai-trung-quoc-doc-duoc-cam-xuc-con-nguoi-post1537948.html

댓글 (0)