|

알리바바가 출시한 신기술, Qwen3. 사진: 로이터 . |

4월 28일, 중국 IT 대기업 알리바바는 Qwen3라는 일련의 AI 모델을 출시했습니다. 알리바바는 이 챗봇이 경우에 따라 OpenAI나 구글의 최신 모델과 동등하거나 심지어 더 나은 성능을 낼 수 있다고 주장합니다.

최대 2,350억 개의 매개변수를 가진 Qwen3는 각각 약 2,360억 개와 1,750억 개의 매개변수를 가진 DeepSeek-V2와 OpenAI GPT-4와 동등합니다. 모델 시리즈가 출시되면 사용자는 AI 개발 플랫폼인 Hugging Face와 Github에서 오픈 라이선스로 다운로드할 수 있습니다.

Qwen3 컬렉션에는 하이브리드 모델이 포함되어 있어 복잡한 문제를 해결하거나 간단한 요청에 신속하게 대응하기 위해 유연한 추론을 수행할 수 있다고 회사 측은 설명합니다. 이 경우, 추론 기능을 통해 모델은 정보의 정확성을 자체적으로 확인할 수 있지만, 지연 시간이 길어질 수 있습니다.

이러한 설계를 통해 사용자는 각 작업에 적합한 예산을 쉽게 할당할 수 있습니다. 또한, 이 모델은 전 세계 여러 경쟁사로부터 학습합니다.

Qwen3는 DeepSeek와 유사한 "전문가 혼합(MoE)" 아키텍처를 사용하여 학습 비용의 극히 일부만으로 연산 효율성을 극대화할 수 있습니다. 이는 작업을 여러 부분으로 나누고 해당 작업을 수행하는 데 필요한 심층 데이터 양만 추천하는 방식입니다.

개발팀에 따르면 Qwen3는 최대 119개 언어를 지원하며, 약 36조 개의 토큰(27조 단어)으로 구성된 데이터셋을 기반으로 학습됩니다. 학습 데이터는 교과서, 질의응답 세트, 프로그래밍 코드, 자체 생성 AI 등 다양한 출처에서 수집됩니다.

이러한 개선 사항들을 비롯한 여러 개선 사항들을 통해 Qwen 3는 이전 모델인 Qwen2에 비해 챗봇의 성능이 크게 향상되었습니다. Techcrunch는 Qwen 3가 OpenAI의 o3나 o4-mini와 같은 최신 상위 모델들을 완전히 능가하지는 못하지만, 여전히 인상적인 성능을 보여준다고 언급했습니다.

|

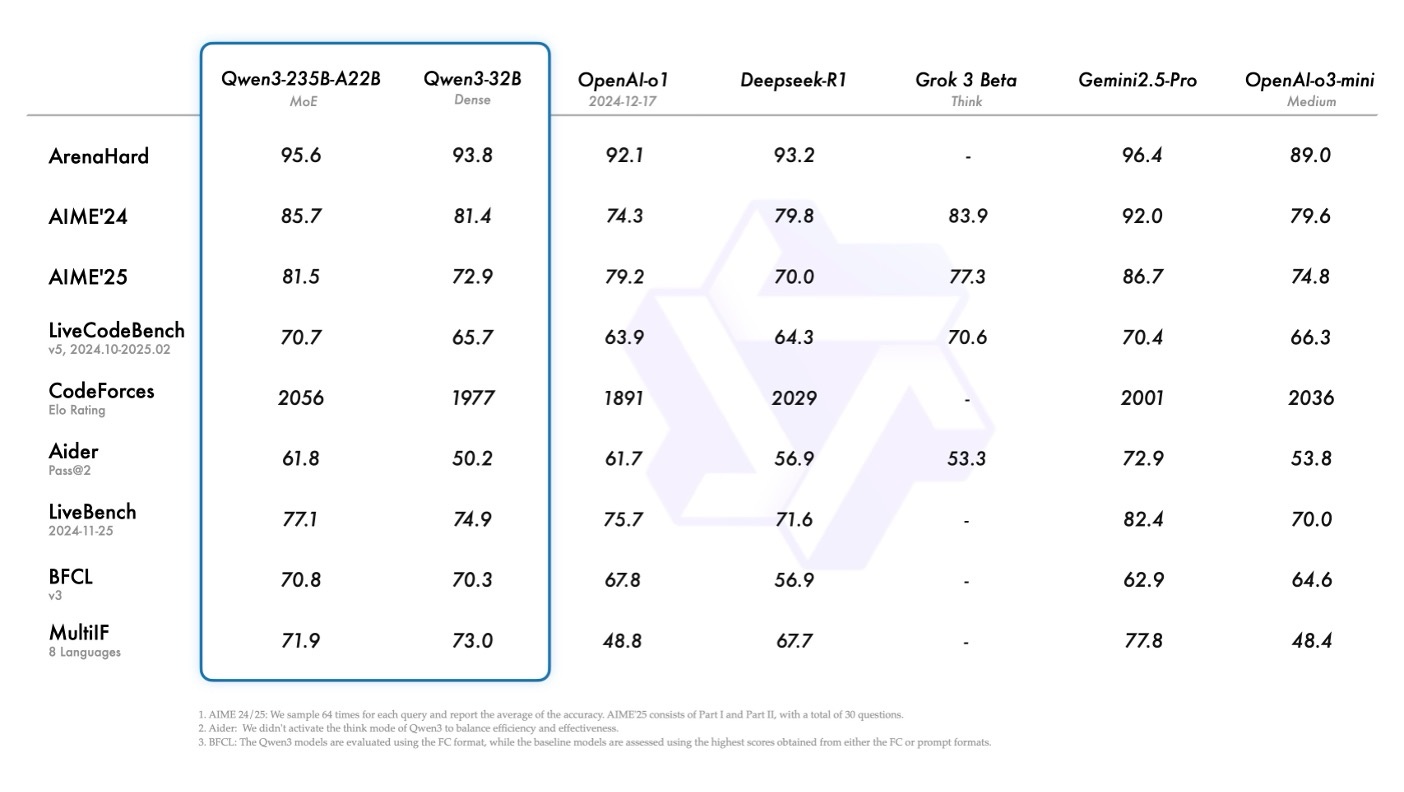

평가 시험 점수 비교. 사진: Qwen/X. |

이 컬렉션에서 가장 큰 모델인 Qwen-3-235B-A22B는 인기 프로그래밍 경진 대회 플랫폼인 Codeforces 에서 OpenAI의 o3-mini와 Google의 Gemini 2.5 Pro를 제쳤습니다. 또한 모델의 추론 능력을 측정하는 AIME 및 BFCL 수학 문제에서도 o3-mini를 앞지르는 성과를 보였습니다.

Qwen-3-235B-A22B는 아직 공식적으로 출시되지 않았습니다. 현재 Qwen3-32B는 다운로드할 수 있습니다. 이 모델은 LiveCodeBench 프로그래밍 테스트를 포함한 여러 평가에서 OpenAI의 O1을 능가했습니다.

알리바바는 Qwen3가 도구 호출, 지시 준수, 그리고 다른 많은 도구들이 갖추지 못한 데이터 형식을 정확하게 복사하는 데 탁월하다고 말합니다. 카네기 멜론 대학교의 연구에 따르면 많은 AI가 특정 지시에도 불구하고 정보를 조작하고 형식을 변경하는 것으로 나타났습니다.

위 플랫폼에서 다운로드하는 것 외에도, 사용자는 Fireworks AI 및 Hyperbolic과 같은 클라우드 서비스 제공업체를 통해 Qwen3를 찾을 수 있습니다. 이를 통해 대기업 및 중소기업은 물론 개인 프로그래머도 장벽을 넘어 접근하고 실험할 수 있습니다.

Qwen과 같은 중국 AI의 등장으로 미국 연구실은 더욱 강력한 기술을 개발하라는 압박을 받게 되었고, 이로 인해 미국 정책 입안자들은 중국의 칩 접근을 제한하게 되었습니다.

클라우드 AI 호스팅 회사 Baseten의 CEO인 투힌 스리바스타바는 Qwen3가 오픈 소스 모델이 OpenAI와 같은 폐쇄 소스 시스템을 따라잡고 있는 또 다른 예라고 말했습니다.

Qwen3는 미국 정부 의 제한에도 불구하고 국내에서 널리 사용될 것으로 예상됩니다. 그는 "이는 중국 기술 기업들이 Anthropic이나 OpenAI와 같은 기존 모델에 의존하는 것 외에도 자체 소프트웨어를 개발할 수 있음을 보여줍니다."라고 말했습니다.

출처: https://znews.vn/them-loat-ai-manh-me-tu-trung-quoc-post1549756.html

댓글 (0)