ກຸ່ມຜູ້ຊ່ຽວຊານສາກົນທີ່ໂດດເດັ່ນໄດ້ພົບປະກັນຢູ່ປັກກິ່ງໃນອາທິດແລ້ວນີ້, ບ່ອນທີ່ພວກເຂົາໄດ້ກໍານົດ "ເສັ້ນສີແດງ" ໃນການພັດທະນາ AI, ລວມທັງການສ້າງອາວຸດຊີວະພາບແລະການດໍາເນີນການໂຈມຕີທາງອິນເຕີເນັດ.

ໃນຖະແຫຼງການຫນຶ່ງມື້ຫຼັງຈາກກອງປະຊຸມ, ນັກວິຊາການໄດ້ເຕືອນວ່າວິທີການທົ່ວໄປກ່ຽວກັບຄວາມປອດໄພຂອງ AI ແມ່ນຈໍາເປັນເພື່ອປ້ອງກັນ "ໄພພິບັດຫຼືຄວາມສ່ຽງທີ່ຈະເກີດຂຶ້ນກັບມະນຸດໃນຊີວິດຂອງພວກເຮົາ."

ຖະແຫຼງການກ່າວວ່າ "ໃນຄວາມສູງຂອງສົງຄາມເຢັນ, ລັດຖະບານສາກົນແລະການຮ່ວມມື ວິທະຍາສາດ ໄດ້ຊ່ວຍປ້ອງກັນໄພພິບັດນິວເຄຼຍ.

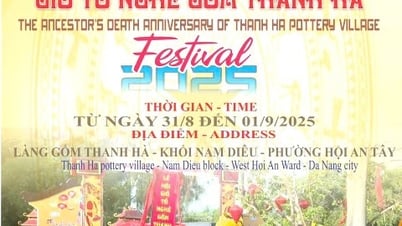

ຜູ້ຊ່ຽວຊານໃນການສົນທະນາສາກົນກ່ຽວກັບຄວາມປອດໄພ AI ໃນປັກກິ່ງໄດ້ກໍານົດ "ເສັ້ນສີແດງ" ໃນການພັດທະນາ AI. ພາບ: FT

ຜູ້ລົງນາມລວມມີ Geoffrey Hinton ແລະ Yoshua Bengio, ຜູ້ທີ່ມັກຈະຖືກອະທິບາຍວ່າເປັນ "ພໍ່" ຂອງ AI; Stuart Russell, ອາຈານສອນວິທະຍາສາດຄອມພິວເຕີຢູ່ມະຫາວິທະຍາໄລຄາລິຟໍເນຍ; ແລະທ່ານ Andrew Yao, ນັກວິທະຍາສາດຄອມພິວເຕີທີ່ໂດດເດັ່ນທີ່ສຸດຂອງຈີນ.

ຖະແຫຼງການດັ່ງກ່າວມີຂຶ້ນຫຼັງຈາກກອງປະຊຸມສາກົນດ້ານຄວາມປອດໄພ AI ທີ່ນະຄອນຫຼວງປັກກິ່ງໃນອາທິດທີ່ຜ່ານມາ, ກອງປະຊຸມທີ່ເຈົ້າໜ້າທີ່ ລັດຖະບານ ຈີນເຂົ້າຮ່ວມເພື່ອສະແດງຄວາມເຫັນດີເຫັນພ້ອມກັບເວທີປາໄສແລະໝາກຜົນຂອງຕົນ.

ປະທານາທິບໍດີ ສະຫະລັດ ທ່ານ ໂຈ ໄບເດັນ ແລະ ທ່ານ ສີ ຈິ້ນຜິງ ປະທານປະເທດຈີນ ໄດ້ພົບປະກັນໃນເດືອນພະຈິກປີກາຍນີ້ ແລະ ໄດ້ປຶກສາຫາລືກ່ຽວກັບຄວາມປອດໄພຂອງ AI, ຕົກລົງທີ່ຈະສ້າງຕັ້ງການປຶກສາຫາລືກ່ຽວກັບບັນຫາດັ່ງກ່າວ. ບໍລິສັດ AI ຊັ້ນນໍາ ຂອງໂລກ ຍັງໄດ້ພົບປະແບບສ່ວນຕົວກັບຜູ້ຊ່ຽວຊານດ້ານ AI ຂອງຈີນໃນເດືອນທີ່ຜ່ານມາ.

ໃນເດືອນພະຈິກ 2023, 28 ປະເທດ, ລວມທັງຈີນ, ແລະບໍລິສັດ AI ຊັ້ນນໍາໄດ້ຕົກລົງໃຫ້ຄໍາຫມັ້ນສັນຍາຢ່າງກວ້າງຂວາງທີ່ຈະເຮັດວຽກຮ່ວມກັນເພື່ອແກ້ໄຂຄວາມສ່ຽງທີ່ມີຢູ່ແລ້ວທີ່ເກີດຈາກ AI ຂັ້ນສູງໃນລະຫວ່າງກອງປະຊຸມສຸດຍອດດ້ານຄວາມປອດໄພ AI ຂອງນາຍົກລັດຖະມົນຕີອັງກິດ Rishi Sunak.

ທີ່ປັກກິ່ງໃນອາທິດແລ້ວນີ້, ຜູ້ຊ່ຽວຊານໄດ້ປຶກສາຫາລືກ່ຽວກັບໄພຂົ່ມຂູ່ທີ່ກ່ຽວຂ້ອງກັບການພັດທະນາຂອງ "ປັນຍາປະດິດທົ່ວໄປ - AGI," ຫຼືລະບົບ AI ທີ່ເທົ່າກັບຫຼືດີກວ່າມະນຸດ.

ທ່ານ Bengio ກ່າວວ່າ “ຈຸດສຸມຫຼັກຂອງການສົນທະນາແມ່ນເສັ້ນສີແດງທີ່ບໍ່ມີລະບົບ AI ທີ່ມີອໍານາດຄວນຂ້າມໄປ ແລະລັດຖະບານໃນທົ່ວໂລກຄວນກຳນົດໃນການພັດທະນາແລະການນຳໃຊ້ AI”.

ເສັ້ນສີແດງເຫຼົ່ານີ້ຈະຮັບປະກັນວ່າ "ບໍ່ມີລະບົບ AI ສາມາດເຮັດເລື້ມຄືນຫຼືປັບປຸງຕົວມັນເອງໄດ້ໂດຍບໍ່ມີການຍິນຍອມເຫັນດີແລະສະຫນັບສະຫນູນຂອງມະນຸດຢ່າງຈະແຈ້ງ" ຫຼື "ປະຕິບັດການເພີ່ມກໍາລັງແລະອິດທິພົນຂອງມັນຢ່າງບໍ່ຖືກຕ້ອງ."

ນັກວິທະຍາສາດກ່າວຕື່ມວ່າບໍ່ມີລະບົບໃດທີ່ຈະ "ເສີມຂະຫຍາຍຄວາມສາມາດຂອງນັກສະແດງໃນການອອກແບບອາວຸດທໍາລາຍມະຫາຊົນ, ລະເມີດສົນທິສັນຍາອາວຸດຊີວະພາບຫຼືເຄມີ" ຫຼືສາມາດ "ປະຕິບັດການໂຈມຕີທາງອິນເຕີເນັດໂດຍອັດຕະໂນມັດທີ່ເຮັດໃຫ້ເກີດການສູນເສຍທາງດ້ານການເງິນທີ່ຮ້າຍແຮງຫຼືຄວາມເສຍຫາຍທຽບເທົ່າ".

ຮວ່າງຫາຍ (ຕາມ FT)

ທີ່ມາ

![[ຮູບ] ຮັກສາສາງຂອງເຈົ້າໃຫ້ປອດໄພໃນທຸກສະຖານະການ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/3eb4eceafe68497989865e7faa4e4d0e)

![[ຮູບພາບ] ປະທານສະພາແຫ່ງຊາດ ກູບາ ຢ້ຽມຢາມສຸສານປະທານໂຮ່ຈິມິນ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/39f1142310fc4dae9e3de4fcc9ac2ed0)

![[ຮູບພາບ] ຕອນເຊົ້າວັນທີ 1/10 ຢູ່ ຮ່າໂນ້ຍ: ນ້ຳຖ້ວມໄດ້ແກ່ຍາວ, ປະຊາຊົນໄປເຮັດວຽກ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/189be28938e3493fa26b2938efa2059e)

(0)