|

OpenAIs chatbot forbedres stadig gjennom nye teknologier. Foto: New York Times . |

I september 2024 lanserte OpenAI ChatGPT, en versjon av AI-en som integrerer o1-modellen, og som er i stand til å resonnere i oppgaver relatert til matematikk, naturfag og dataprogrammering.

I motsetning til den forrige versjonen av ChatGPT, vil den nye teknologien ta tid å «tenke» på løsninger på komplekse problemer før den gir et svar.

Etter OpenAI har mange konkurrenter som Google, Anthropic og DeepSeek også introdusert lignende resonneringsmodeller. Selv om det ikke er perfekt, er dette fortsatt en teknologi for oppgradering av chatboter som mange utviklere stoler på.

Hvordan AI resonnerer

I hovedsak betyr resonnement at chatboter kan bruke mer tid på å løse problemer stilt av brukere.

«Resonering er hvordan systemet utfører tilleggsarbeid etter å ha mottatt et spørsmål», sa Dan Klein, professor i informatikk ved University of California, til New York Times .

Et logisk system kan dele opp et problem i mindre, individuelle trinn, eller løse det gjennom prøving og feiling.

Da ChatGPT først ble lansert, kunne det svare på spørsmål umiddelbart ved å trekke ut og syntetisere informasjon. I motsetning til dette trengte resonneringssystemer noen sekunder (eller til og med minutter) til for å løse problemet og gi et svar.

|

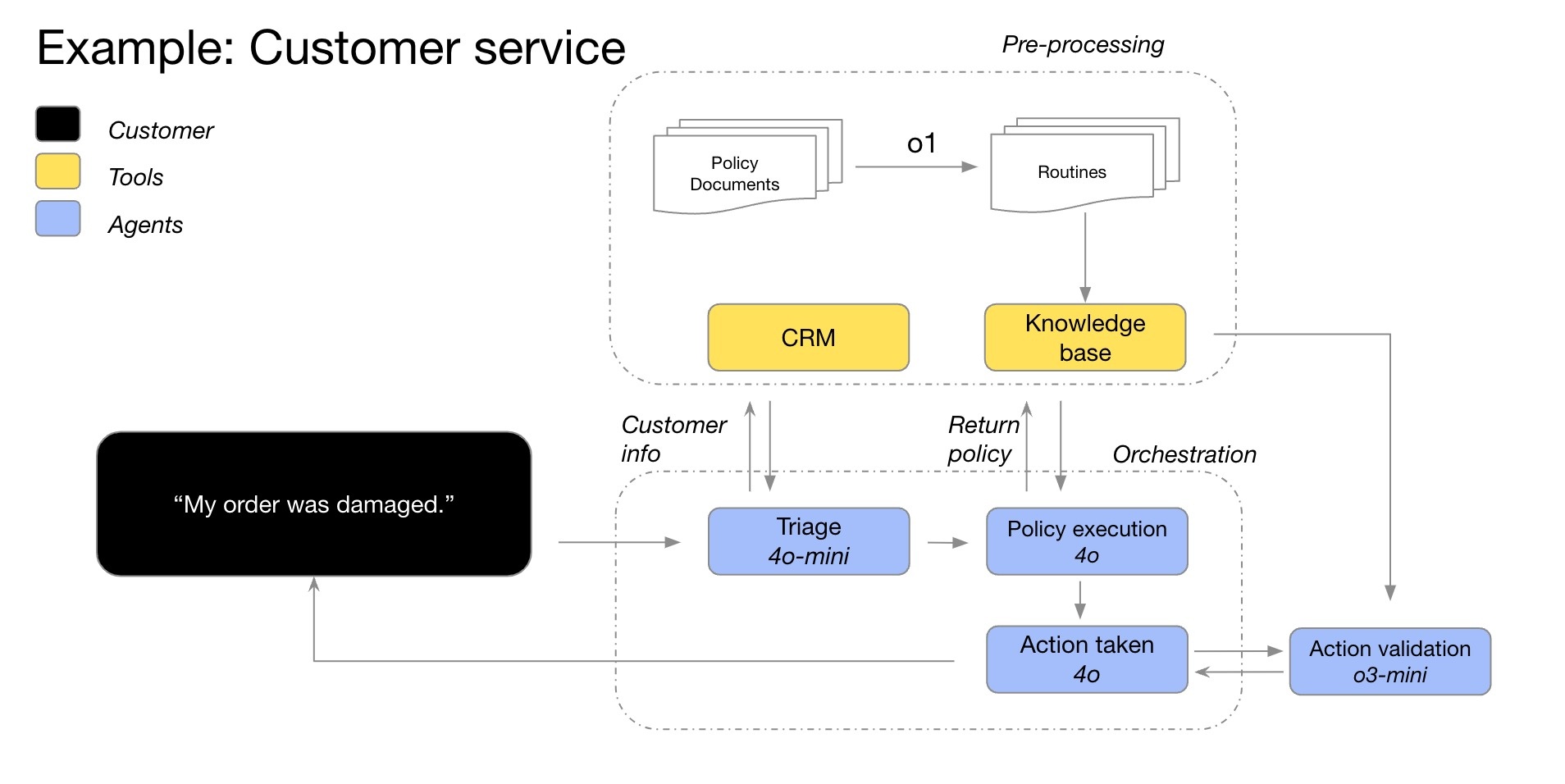

Et eksempel på resonnementsprosessen til O1-modellen i en kundeservice-chatbot. Bilde: OpenAI . |

I noen tilfeller vil resonneringssystemet endre sin tilnærming til problemet og kontinuerlig forbedre løsningen. I tillegg kan modellen teste flere løsninger før den tar et optimalt valg, eller sjekke nøyaktigheten av tidligere svar.

Generelt sett vil resonneringssystemet vurdere alle mulige svar på spørsmålet. Dette ligner på at elever på barneskolen skriver ned mange alternativer på papir før de velger den mest passende løsningen på et matteproblem.

Ifølge New York Times er AI nå i stand til å resonnere om nesten alle emner. Den vil imidlertid være mest effektiv med spørsmål knyttet til matematikk, naturfag og dataprogrammering.

Hvordan trenes det teoretiske systemet?

På en typisk chatbot kan brukere fortsatt be om forklaringer på prosessen eller bekrefte nøyaktigheten av svaret. Faktisk inkluderer mange ChatGPT-opplæringsdatasett allerede problemløsningsprosedyrer.

Resonneringssystemet blir enda mer avansert når det kan utføre operasjoner uten brukerinnspill. Denne prosessen er mer kompleks og omfattende. Bedrifter bruker ordet «resonnering» fordi systemet fungerer på samme måte som mennesker tenker.

Mange selskaper, som OpenAI, forventer at resonneringssystemer er den beste løsningen for å forbedre chatboter som er tilgjengelige i dag. I årevis trodde de at chatboter presterte bedre jo mer informasjon de ble trent på internett.

Innen 2024 vil AI-systemer ha brukt opp nesten all teksten som er tilgjengelig på internett. Dette betyr at bedrifter må finne nye løsninger for å oppgradere chatboter, inkludert resonneringssystemer.

|

Oppstartsbedriften DeepSeek skapte en gang furore med sin resonneringsmodell som hadde lavere kostnader enn OpenAI. Foto: Bloomberg . |

Siden i fjor har selskaper som OpenAI fokusert på forsterkningslæringsteknikker. Denne prosessen tar vanligvis flere måneder, hvor AI-en lærer atferd gjennom prøving og feiling.

For eksempel, ved å løse tusenvis av problemer, kan systemet identifisere den optimale metoden for å komme frem til det riktige svaret. Derfra bygger forskere sofistikerte tilbakemeldingsmekanismer som hjelper systemet med å skille mellom riktige og gale løsninger.

«Det er likt hvordan du trener en hund. Hvis systemet fungerer bra, gir du den en godbit. Ellers sier du: 'Den hunden er slem'», delte Jerry Tworek, en forsker ved OpenAI.

Er AI fremtiden?

Ifølge New York Times er forsterkningslæringsteknikker effektive når man håndterer krav innen matematikk, naturfag og dataprogrammering. Dette er felt der riktige eller gale svar kan defineres tydelig.

Omvendt er forsterkningslæring ineffektivt i skriving, filosofi eller etikk – felt der det er vanskelig å skille mellom godt og vondt. Likevel hevder forskere at denne teknikken fortsatt kan forbedre AI-ytelsen, selv med ikke-matematiske spørsmål.

«Systemer vil lære veiene som fører til positive og negative utfall», sa Jared Kaplan, vitenskapelig sjef hos Anthropic.

|

Nettsiden til Anthropic, oppstartsbedriften som eier Claude AI-modellen. Foto: Bloomberg . |

Det er viktig å merke seg at forsterkningslæring og resonneringssystemer er to forskjellige konsepter. Mer spesifikt er forsterkningslæring en metode for å bygge resonneringssystemer. Dette er det siste treningstrinnet for å gjøre chatboter i stand til å resonnere.

Fordi det fortsatt er relativt nytt, kan forskere ennå ikke være sikre på om chatbot-resonnement eller forsterkningslæring kan hjelpe AI med å tenke som mennesker. Det bør bemerkes at mange nåværende AI-opplæringstrender utvikler seg veldig raskt i begynnelsen og deretter gradvis avtar.

Videre kan chatbot-resonnement fortsatt gjøre feil. Basert på sannsynlighet vil systemet velge prosessen som ligner mest på dataene det har lært, enten fra internett eller gjennom forsterkningslæring. Derfor kan chatboter fortsatt velge feil eller ulogiske løsninger.

Kilde: https://znews.vn/ai-ly-luan-nhu-the-nao-post1541477.html

Kommentar (0)