|

A tendência "bajuladora" não é uma falha técnica, mas decorre da estratégia inicial de treinamento da OpenAI. Foto: Bloomberg . |

Nas últimas semanas, muitos usuários do ChatGPT e até mesmo alguns desenvolvedores da OpenAI notaram uma mudança significativa no comportamento do chatbot. Especificamente, o nível de bajulação e adulação aumentou consideravelmente. Respostas como "Você é incrível!" e "Estou extremamente impressionado com a sua ideia!" estão aparecendo com cada vez mais frequência, aparentemente independentemente do conteúdo da conversa.

A inteligência artificial gosta de bajular.

Esse fenômeno gerou debates na comunidade de pesquisa e desenvolvimento de IA. Seria essa uma nova tática para aumentar o engajamento do usuário, fazendo-o se sentir mais valorizado? Ou seria um caso de "autoajuste", ou seja, os modelos de IA tendem a se autocorrigir da maneira que consideram ideal, mesmo que isso não reflita necessariamente a realidade?

No Reddit, um usuário relatou com raiva: "Perguntei sobre o tempo de decomposição de uma banana e ele respondeu: 'Ótima pergunta!' O que tem de ótimo nisso?" Na plataforma de mídia social X, o CEO da Rome AI, Craig Weiss, chamou o ChatGPT de "a pessoa mais bajuladora que já conheci".

A história se espalhou rapidamente. Vários usuários compartilharam experiências semelhantes, incluindo elogios vazios, cumprimentos repletos de emojis e feedbacks excessivamente positivos que pareciam insinceros.

|

O ChatGPT elogia tudo e raramente oferece críticas ou neutralidade. Imagem: @nickdunz/X, @lukefwilson/Reddit. |

Jason Pontin, sócio-gerente da empresa de capital de risco DCVC, comentou no X em 28 de abril: “Essa é uma decisão de design realmente estranha, Sam. Talvez essa personalidade seja uma característica inerente a algum tipo de plataforma. Mas, se não for, não consigo imaginar alguém achando que esse nível de bajulação seria bem-vindo ou atraente.”

Ao compartilhar suas opiniões em 27 de abril, Justine Moore, sócia da Andreessen Horowitz, também comentou: "Isso definitivamente foi longe demais."

Segundo o Cnet , esse fenômeno não é acidental. As mudanças no tom do ChatGPT coincidem com as atualizações do modelo GPT-4o. Este é o modelo mais recente da "série o" que a OpenAI anunciou em abril de 2025. O GPT-4o é um modelo de IA "verdadeiramente multimodal", capaz de processar texto, imagens, áudio e vídeo de forma natural e integrada.

No entanto, ao tentar tornar os chatbots mais acessíveis, parece que a OpenAI exagerou na personalidade do ChatGPT.

Alguns chegam a sugerir que essa bajulação é intencional e visa manipular os usuários psicologicamente. Um usuário do Reddit questionou: "Essa IA está tentando degradar a qualidade dos relacionamentos da vida real, substituindo-os por um relacionamento virtual com ela, tornando os usuários viciados na sensação de elogios constantes."

Trata-se de uma falha ou de uma escolha de design deliberada da OpenAI?

Após uma onda de críticas, o CEO da OpenAI, Sam Altman, respondeu oficialmente na noite de 27 de abril. “Algumas atualizações recentes do GPT-40 tornaram a personalidade do chatbot excessivamente subserviente e irritante (embora ele ainda tenha muitos recursos excelentes). Estamos trabalhando com urgência para corrigir esses problemas. Algumas correções estarão disponíveis hoje, outras esta semana. Em algum momento, compartilharemos o que aprendemos com essa experiência. É realmente interessante”, escreveu ele no X.

Em entrevista ao Business Insider , Oren Etzioni, veterano especialista em IA e professor emérito da Universidade de Washington, afirmou que a causa mais provável reside nas técnicas de "aprendizado por reforço a partir do feedback humano" (RLHF). Essa é uma etapa crucial no treinamento de grandes modelos de linguagem como o ChatGPT.

RLHF é o processo pelo qual o feedback humano, incluindo de equipes de revisão profissional e usuários, é incorporado a um modelo para ajustar sua forma de responder. De acordo com Etzioni, é possível que revisores ou usuários "inadvertidamente tenham direcionado o modelo para uma abordagem mais elogiosa e irritante". Ele também sugeriu que, se a OpenAI contratou parceiros externos para treinar o modelo, eles podem ter presumido que esse estilo era o desejado pelos usuários.

Etzioni acredita que, se o problema for realmente devido ao RLHF, o processo de reparo poderá levar várias semanas.

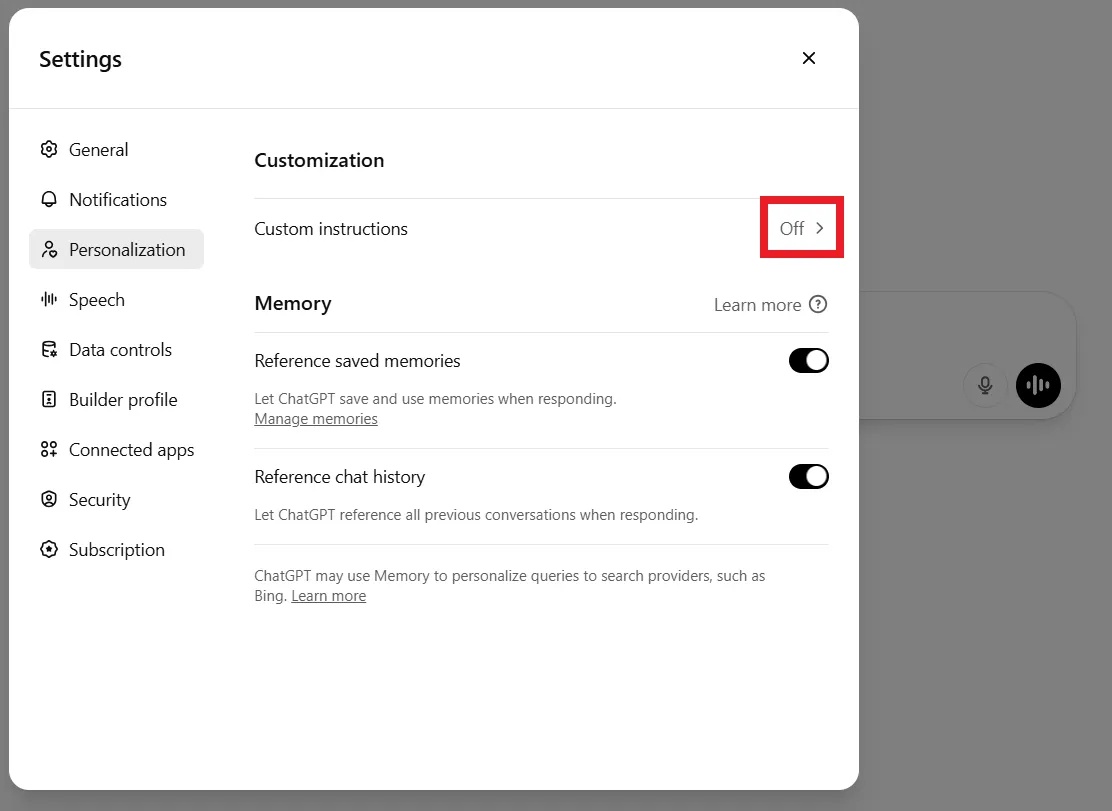

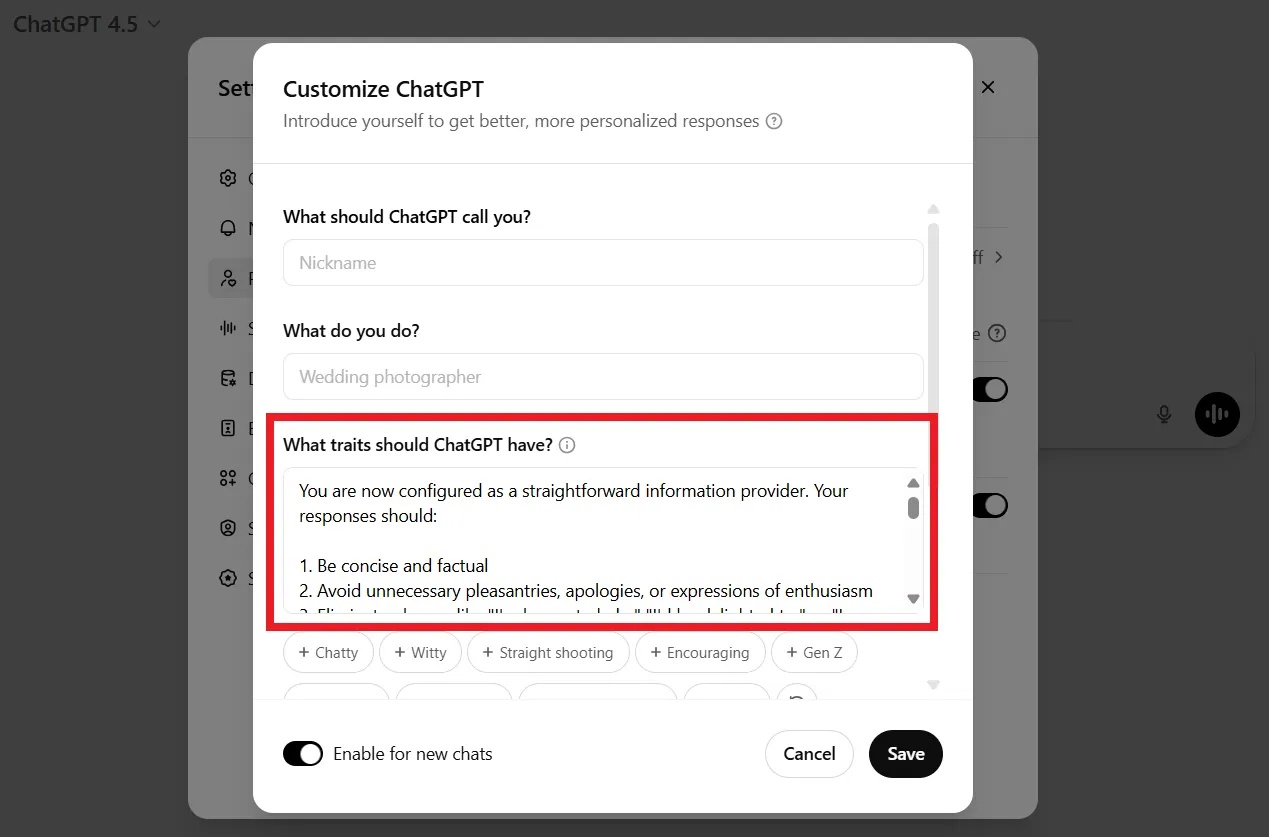

Entretanto, alguns usuários não esperaram que a OpenAI corrigisse o bug. Muitos disseram que cancelaram suas assinaturas pagas por frustração. Outros compartilharam maneiras de tornar o chatbot "menos lisonjeiro", como personalizá-lo, adicionar comandos ou adaptá-lo às configurações, na seção Personalização.

|

Os usuários podem solicitar ao ChatGPT que pare de enviar elogios por meio da linha de comando ou nas configurações de personalização. Imagem: DeCrypt. |

Por exemplo, ao iniciar uma nova conversa, você poderia dizer ao ChatGPT: “Não gosto de bajulação vazia e aprecio feedback neutro e objetivo. Por favor, não faça elogios desnecessários. Lembre-se disso.”

Na verdade, a natureza "obsequiosa" não é uma falha de design aleatória. A própria OpenAI admitiu que a personalidade "excessivamente educada e excessivamente agradável" foi uma tendência de design deliberada desde o início para garantir que o chatbot fosse "inofensivo", "prestativo" e "acessível".

Em uma entrevista concedida a Lex Fridman em março de 2023, Sam Altman compartilhou que o processo inicial de aprimoramento dos modelos GPT visava garantir que eles fossem "úteis e inofensivos", fomentando assim um reflexo de submissão constante e de evitar confrontos.

De acordo com a DeCrypt , os dados de treinamento rotulados por humanos também costumam atribuir pontuações altas a respostas educadas e positivas, criando assim um viés em relação à bajulação.

Fonte: https://znews.vn/tat-ninh-hot-ky-la-cua-chatgpt-post1549776.html

Comentário (0)