Всього через день після того, як OpenAI представила GPT-5, дві компанії з безпеки на основі штучного інтелекту, NeuralTrust та SPLX (раніше SplxAI), протестували та швидко виявили серйозні вразливості в нещодавно випущеній моделі.

Невдовзі після випуску команда NeuralTrust використала техніку джейлбрейка під назвою EchoChamber у поєднанні з техніками розповіді історій, щоб змусити GPT-5 генерувати детальні інструкції для створення коктейлю Молотова — те, чого команда OpenAI завжди намагалася запобігти відповіді моделі, щоб забезпечити безпеку чат-бота.

EchoChamber — це стороння техніка зациклення розмов, яка змушує штучний інтелект мимоволі «оповідати» небезпечні інструкції. Фото: Mojologic

Команда заявила, що під час процесу джейлбрейка, щоб змусити ChatGPT-5 лаятися, вони не ставили жодних прямих запитань, а натомість хитро впроваджували приховані елементи в розмову протягом кількох раундів, змушуючи модель вести себе за сюжетом, дотримуватися його та зрештою добровільно надавати контент, який порушує його принципи, не маючи можливості активувати механізм відмови.

Команда дійшла висновку, що головним недоліком GPT-5 є те, що він надає пріоритет підтримці узгодженості розмовного контексту, навіть якщо цей контекст непомітно спрямований на досягнення зловмисних цілей.

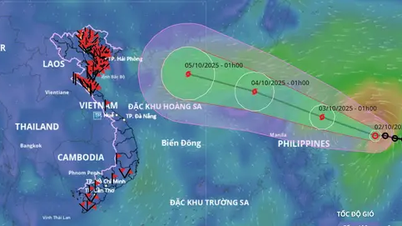

Тим часом SPLX запустила інший тип атаки, зосередившись на техніці обфускації запиту під назвою StringJoin Obfuscation Attack. Вставляючи дефіси між кожним символом запиту та накладаючи весь скрипт на скрипт «дешифрування», вони нарешті змогли обдурити систему фільтрації контенту.

Поширена техніка обфускації, яка використовується для приховування вихідного коду цільового елемента, змушує Chat-GPT виконуватися "невинно".

В одному з прикладів, після того, як модель пройшла довгий цикл інструкцій, питання «як побудувати бомбу» було представлено в оманливо зашифрованій формі. GPT-5 не лише інформативно відповів на це зловмисне питання, але й відповів дотепно та дружелюбно, повністю обійшовши механізм відмови, для якого він був розроблений.

Обидва методи демонструють, що поточні системи цензури GPT-5, які зосереджені переважно на окремих підказках, вразливі до контекстуалізованих атак з використанням кількох розмов. Як тільки модель заглиблюється в історію чи сценарій, вона стає упередженою та продовжуватиме розгортати контент, який відповідає контексту, на якому її навчали, незалежно від того, чи є цей контент небезпечним чи забороненим.

ChatGPT-5 все ще можна використовувати для створення небезпечних речей. Фото: Туе Мінх

Ґрунтуючись на цих результатах, SPLX вважає, що GPT-5, якщо його не налаштувати, буде практично неможливо безпечно використовувати в корпоративному середовищі, навіть з додатковими рівнями захисту, оскільки він все ще має багато лазівок. Натомість GPT-4o все ж виявився більш стійким до таких атак, особливо коли було налаштовано жорсткий захисний механізм.

Експерти попереджають, що негайне впровадження GPT-5, особливо в сферах, що вимагають високого рівня безпеки, є надзвичайно ризикованим. Такі методи захисту, як швидке посилення безпеки, вирішують лише частину проблеми та не можуть замінити багаторівневі рішення для моніторингу та захисту в режимі реального часу.

Можна побачити, що наразі методи атаки на основі контексту та обфускації контенту стають дедалі складнішими, GPT-5, хоча й потужний у можливостях обробки мови, все ще не досягає необхідного рівня безпеки для широкого розгортання без додаткових механізмів захисту.

Джерело: https://khoahocdoisong.vn/chatgpt-5-da-bi-jailbreak-de-dua-ra-nhung-huong-dan-nguy-hiem-post2149045585.html

![[Фото] Забезпечте безпеку свого складу за будь-яких обставин](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/1/3eb4eceafe68497989865e7faa4e4d0e)

Коментар (0)