|

Anthropic щойно оновив свою нову політику. Фото: GK Images . |

28 серпня компанія Anthropic, що займається штучним інтелектом, оголосила про запуск оновлення своїх Умов обслуговування користувачів та Політики конфіденційності. Тепер користувачі можуть дозволити використання своїх даних для покращення Claude та посилення захисту від зловживань, таких як шахрайство та шахрайство.

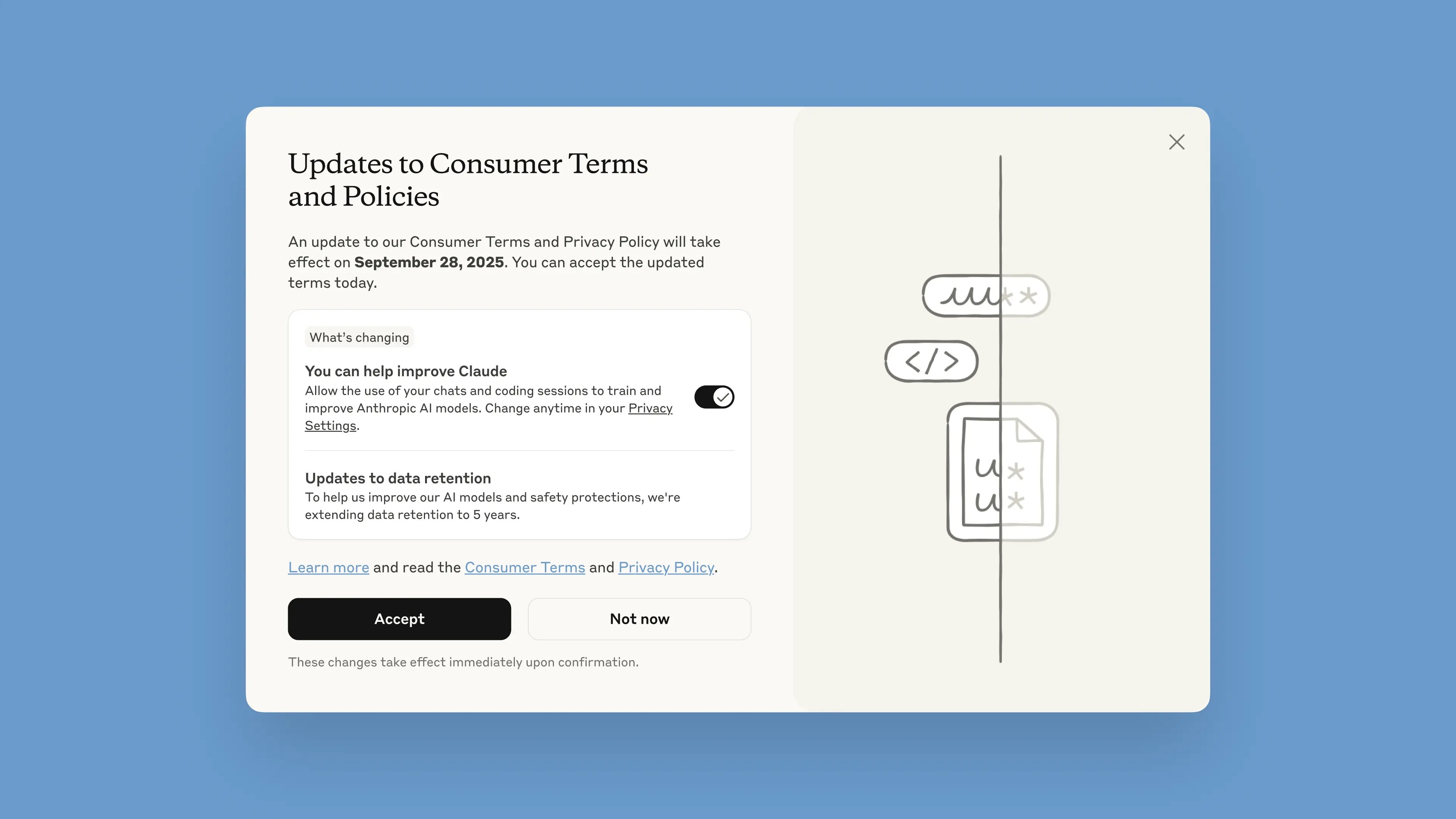

Це повідомлення буде опубліковано в чат-боті, починаючи з 28 серпня. Користувачі мають один місяць, щоб прийняти або відхилити умови. Нові правила набудуть чинності негайно після їх прийняття. Після 28 вересня користувачам потрібно буде дати згоду на продовження користування Claude.

За словами компанії, оновлення мають допомогти створити потужніші та корисніші моделі штучного інтелекту. Налаштування цього параметра просте та його можна виконати будь-коли в налаштуваннях конфіденційності.

Ці зміни стосуються планів Claude Free, Pro та Max, які включають Claude Code, інструмент програмування Anthropic. Послуги, що охоплюються Комерційними умовами, не застосовуватимуться, зокрема Claude for Work, Claude Gov, Claude for Education або використання API, зокрема через треті сторони, такі як Amazon Bedrock та Vertex AI від Google Cloud.

Беручи участь, користувачі допоможуть покращити безпеку моделі, збільшивши її здатність точно виявляти шкідливий контент і зменшивши ризик помилкового позначення нешкідливих розмов, йдеться у дописі Anthropic у блозі. Майбутні версії Claude також будуть вдосконалені такими навичками, як програмування, аналіз і міркування.

Важливо, щоб користувачі мали повний контроль над своїми даними та мали можливість дозволити платформі використовувати їх у спливаючому вікні. Нові облікові записи можуть за бажанням налаштувати це під час процесу реєстрації.

|

Спливаюче вікно «Нові умови» в чат-боті. Фото: Anthropic. |

Термін зберігання даних збільшено до п'яти років, що стосується нових або продовжених розмов чи сеансів кодування, а також відповідей на відповіді чат-ботів. Видалені дані не будуть використані для навчання моделі в майбутньому. Якщо користувачі не погодяться на надання даних для навчання, вони продовжуватимуть застосовувати поточну 30-денну політику зберігання.

Пояснюючи цю політику, Anthropic зазначила, що цикли розробки штучного інтелекту зазвичай тривають роками, а підтримка узгодженості даних протягом усього процесу навчання також допомагає моделям залишатися узгодженими. Довше зберігання даних також покращує класифікатори, системи, що використовуються для виявлення зловживань, для виявлення шкідливих моделей.

«Для захисту конфіденційності користувачів ми використовуємо комбінацію автоматизованих інструментів та процесів для фільтрації або маскування конфіденційних даних. Ми не продаємо дані користувачів третім сторонам», – написала компанія.

Anthropic часто називають одним із лідерів у сфері безпечного штучного інтелекту. Anthropic розробила підхід під назвою «Конституційний штучний інтелект», який визначає етичні принципи та рекомендації, яких повинні дотримуватися моделі. Anthropic також є однією з компаній, яка підписала Зобов’язання щодо безпечного штучного інтелекту з урядами США, Великої Британії та країн Великої сімки.

Джерело: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

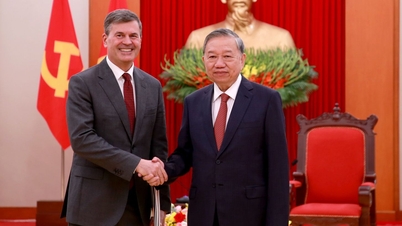

![[Фото] Генеральний секретар То Лам приймає директора Академії державного управління та народного господарства при Президенті Російської Федерації](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F08%2F1765200203892_a1-bnd-0933-4198-jpg.webp&w=3840&q=75)

Коментар (0)