|

قامت أنثروبيك بتحديث سياستها الجديدة. الصورة: GK Images . |

في 28 أغسطس، أعلنت شركة الذكاء الاصطناعي أنثروبيك عن تحديث شروط خدمة المستخدم وسياسة الخصوصية. أصبح بإمكان المستخدمين الآن اختيار استخدام بياناتهم لتحسين تطبيق كلود وتعزيز الحماية من الانتهاكات، مثل الاحتيال والنصب.

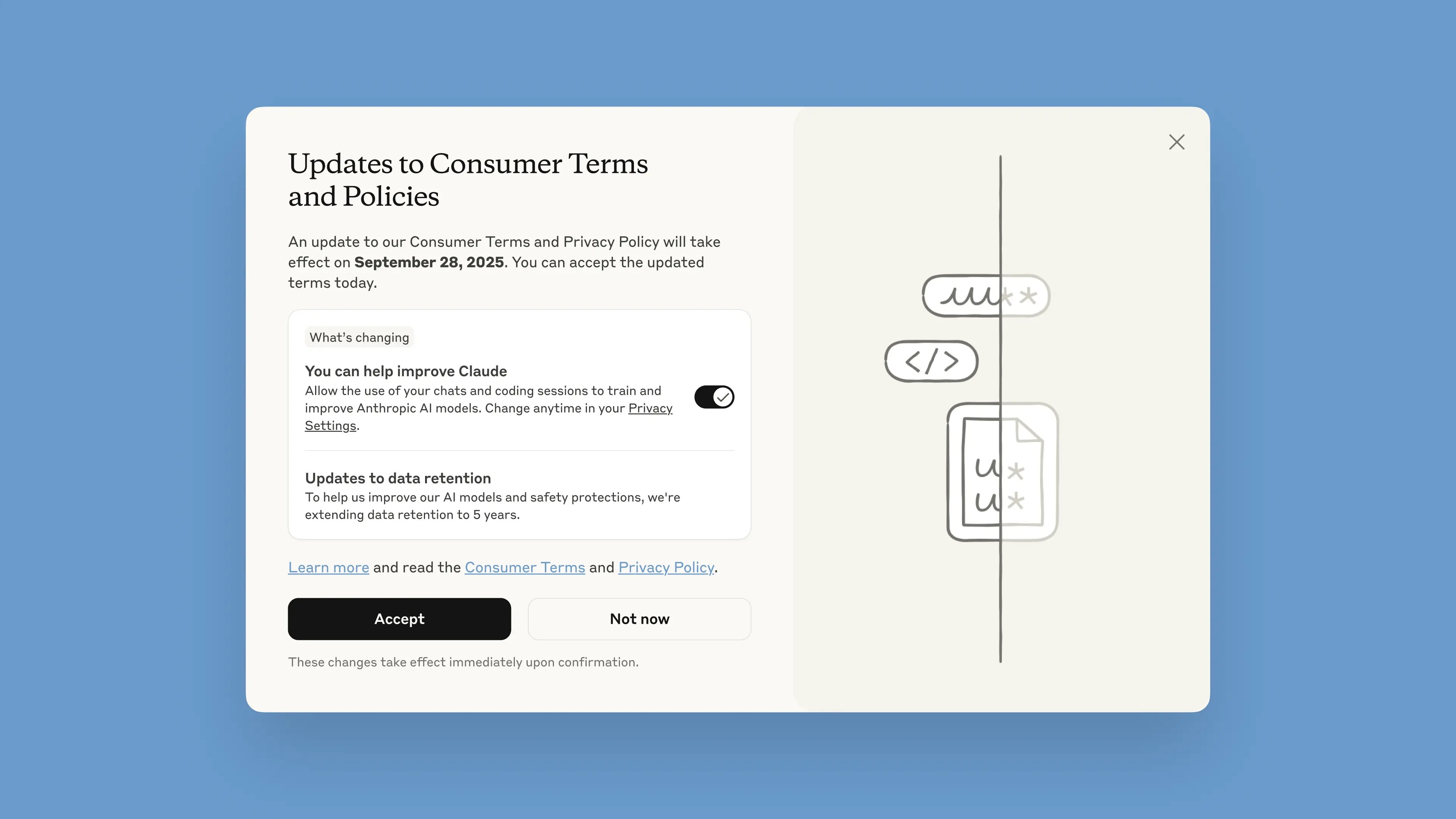

سيتم نشر هذا الإشعار عبر روبوت المحادثة ابتداءً من 28 أغسطس. أمام المستخدمين شهر واحد لقبول الشروط أو رفضها. ستسري السياسات الجديدة فور قبولها. بعد 28 سبتمبر، سيُطلب من المستخدمين الاشتراك لمواصلة استخدام كلود.

وفقًا للشركة، تهدف التحديثات إلى تقديم نماذج ذكاء اصطناعي أكثر قوةً وفائدة. تعديل هذا الخيار سهل، ويمكن تنفيذه في أي وقت من خلال إعدادات الخصوصية.

تنطبق هذه التغييرات على باقات Claude Free وPro وMax، والتي تشمل Claude Code، أداة البرمجة من Anthropic. لن تُطبق الخدمات المشمولة بالشروط التجارية، بما في ذلك Claude for Work وClaude Gov وClaude for Education، أو استخدام واجهات برمجة التطبيقات، بما في ذلك من خلال جهات خارجية مثل Amazon Bedrock وVertex AI من Google Cloud.

من خلال المشاركة، سيساهم المستخدمون في تحسين سلامة النموذج، مما يزيد من قدرته على الكشف الدقيق عن المحتوى الضار، ويقلل من خطر الإبلاغ عن المحادثات غير الضارة عن طريق الخطأ، وفقًا لما ذكرته أنثروبيك في منشورها على مدونتها. كما سيتم تعزيز الإصدارات المستقبلية من كلود بمهارات مثل البرمجة والتحليل والاستدلال.

من المهم أن يتمتع المستخدمون بالتحكم الكامل في بياناتهم، وتحديد ما إذا كانوا يسمحون للمنصة باستخدامها في نافذة منبثقة أم لا. يمكن للحسابات الجديدة إعداد ذلك اختياريًا أثناء عملية التسجيل.

|

نافذة منبثقة للشروط الجديدة في روبوت المحادثة. الصورة: أنثروبيك. |

تم زيادة مدة الاحتفاظ بالبيانات إلى خمس سنوات، وهي تُطبق على المحادثات أو جلسات البرمجة الجديدة أو المستمرة، بالإضافة إلى الردود على ردود روبوتات الدردشة. لن تُستخدم البيانات المحذوفة لتدريب النموذج مستقبلًا. في حال عدم موافقة المستخدمين على توفير البيانات للتدريب، سيستمرون في تطبيق سياسة الاحتفاظ الحالية لمدة 30 يومًا.

في شرحها للسياسة، أوضحت أنثروبيك أن دورات تطوير الذكاء الاصطناعي تستغرق عادةً سنوات، وأن الحفاظ على اتساق البيانات طوال عملية التدريب يُساعد النماذج على الحفاظ على اتساقها. كما يُحسّن الاحتفاظ بالبيانات لفترة أطول من كفاءة المُصنِّفين، وهي أنظمة تُستخدم لتحديد السلوكيات المُسيئة، واكتشاف الأنماط الضارة.

لحماية خصوصية المستخدم، نستخدم مجموعة من الأدوات والعمليات الآلية لتصفية أو إخفاء البيانات الحساسة. لا نبيع بيانات المستخدم لأطراف ثالثة، وفقًا لما ذكرته الشركة.

غالبًا ما تُعتبر أنثروبيك من الشركات الرائدة في مجال الذكاء الاصطناعي الآمن. وقد طورت أنثروبيك نهجًا يُسمى الذكاء الاصطناعي الدستوري، والذي يحدد المبادئ والإرشادات الأخلاقية التي يجب على النماذج اتباعها. كما تُعد أنثروبيك من الشركات التي وقّعت على التزامات الذكاء الاصطناعي الآمن مع حكومات الولايات المتحدة والمملكة المتحدة ومجموعة الدول السبع.

المصدر: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

![[صورة] مساعدة الناس بشكل عاجل في الحصول على مكان للعيش واستقرار حياتهم قريبًا](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F09%2F1765248230297_c-jpg.webp&w=3840&q=75)

![[صورة] الأمين العام تو لام يعمل مع اللجان الدائمة للمؤتمر الحزبي الرابع عشر واللجان الفرعية](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/09/1765265023554_image.jpeg)

تعليق (0)