গত সপ্তাহে বেইজিংয়ে একদল বিশিষ্ট আন্তর্জাতিক বিশেষজ্ঞের বৈঠক হয়, যেখানে তারা জৈবিক অস্ত্র তৈরি এবং সাইবার আক্রমণ পরিচালনা সহ AI উন্নয়নে "লাল রেখা" চিহ্নিত করে।

সভার কয়েকদিন পর এক বিবৃতিতে, শিক্ষাবিদরা সতর্ক করে দিয়েছিলেন যে "আমাদের জীবদ্দশায় মানবতার জন্য বিপর্যয়কর বা এমনকি অস্তিত্বগত ঝুঁকি" প্রতিরোধ করার জন্য AI সুরক্ষার জন্য একটি সাধারণ পদ্ধতির প্রয়োজন।

"ঠান্ডা যুদ্ধের তুঙ্গে থাকাকালীন, আন্তর্জাতিক সরকার এবং বৈজ্ঞানিক সহযোগিতা পারমাণবিক বিপর্যয় রোধে সহায়তা করেছিল। অভূতপূর্ব প্রযুক্তি থেকে উদ্ভূত বিপর্যয় রোধে মানবজাতিকে আবারও একসাথে কাজ করতে হবে," বিবৃতিতে বলা হয়েছে।

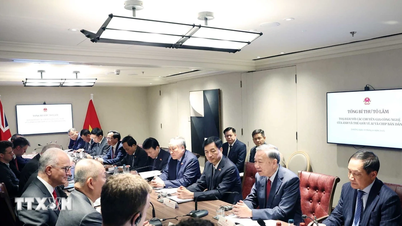

বেইজিংয়ে অনুষ্ঠিত আন্তর্জাতিক এআই নিরাপত্তা সংলাপে বিশেষজ্ঞরা এআই উন্নয়নে "লাল রেখা" চিহ্নিত করেছেন। ছবি: এফটি

স্বাক্ষরকারীদের মধ্যে রয়েছেন জিওফ্রে হিন্টন এবং ইয়োশুয়া বেঙ্গিও, যাদের প্রায়শই কৃত্রিম বুদ্ধিমত্তার "পিতা" হিসেবে বর্ণনা করা হয়; ক্যালিফোর্নিয়া বিশ্ববিদ্যালয়ের কম্পিউটার বিজ্ঞানের অধ্যাপক স্টুয়ার্ট রাসেল; এবং চীনের অন্যতম বিশিষ্ট কম্পিউটার বিজ্ঞানী অ্যান্ড্রু ইয়াও।

গত সপ্তাহে বেইজিংয়ে আন্তর্জাতিক এআই নিরাপত্তা সংলাপের পর এই বিবৃতিটি এসেছে। এই বৈঠকে চীনা সরকারি কর্মকর্তারা ফোরাম এবং এর ফলাফলের প্রতি তাদের অনুমোদন প্রকাশ করেছিলেন।

মার্কিন প্রেসিডেন্ট জো বাইডেন এবং চীনের প্রেসিডেন্ট শি জিনপিং গত বছরের নভেম্বরে দেখা করেছিলেন এবং এআই নিরাপত্তা নিয়ে আলোচনা করেছিলেন, এই বিষয়ে একটি সংলাপ স্থাপনে সম্মত হয়েছিলেন। সাম্প্রতিক মাসগুলিতে শীর্ষস্থানীয় বিশ্বব্যাপী এআই কোম্পানিগুলিও চীনা এআই বিশেষজ্ঞদের সাথে ব্যক্তিগতভাবে বৈঠক করেছে।

২০২৩ সালের নভেম্বরে, যুক্তরাজ্যের চ্যান্সেলর ঋষি সুনাকের এআই নিরাপত্তা শীর্ষ সম্মেলনে চীন সহ ২৮টি দেশ এবং নেতৃস্থানীয় এআই কোম্পানিগুলি উন্নত এআই থেকে উদ্ভূত অস্তিত্বগত ঝুঁকি মোকাবেলায় একসাথে কাজ করার জন্য একটি বিস্তৃত প্রতিশ্রুতিতে সম্মত হয়েছিল।

গত সপ্তাহে বেইজিংয়ে, বিশেষজ্ঞরা "কৃত্রিম সাধারণ বুদ্ধিমত্তা - AGI" বা মানুষের সমান বা তার চেয়ে উচ্চতর AI সিস্টেমের বিকাশের সাথে সম্পর্কিত হুমকি নিয়ে আলোচনা করেছেন।

"আলোচনার মূল কেন্দ্রবিন্দু ছিল সেই লাল রেখা যা কোনও শক্তিশালী এআই সিস্টেম অতিক্রম করা উচিত নয় এবং বিশ্বজুড়ে সরকারগুলির এআই-এর বিকাশ এবং স্থাপনার ক্ষেত্রে আরোপ করা উচিত," বেনজিও বলেন।

এই লাল রেখাগুলি নিশ্চিত করবে যে "কোনও AI সিস্টেম স্পষ্ট মানব সম্মতি এবং সমর্থন ছাড়া নিজেকে প্রতিলিপি বা উন্নত করতে পারবে না" অথবা "এমন পদক্ষেপ নিতে পারবে যা অযথা তার শক্তি এবং প্রভাব বৃদ্ধি করে।"

বিজ্ঞানীরা আরও বলেন, কোনও ব্যবস্থাই "গণবিধ্বংসী অস্ত্র ডিজাইন করার, জৈবিক বা রাসায়নিক অস্ত্র কনভেনশন লঙ্ঘন করার, অথবা স্বয়ংক্রিয়ভাবে সাইবার আক্রমণ চালানোর ক্ষমতা উল্লেখযোগ্যভাবে বৃদ্ধি করতে পারবে না যার ফলে গুরুতর আর্থিক ক্ষতি বা সমতুল্য ক্ষতি হতে পারে"।

হোয়াং হাই (এফটি অনুসারে)

[বিজ্ঞাপন_২]

উৎস

![[ছবি] জুয়ান দাই উপসাগরে "জাহাজ কবরস্থান"](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/08/1762577162805_ndo_br_tb5-jpg.webp)

![[ভিডিও] দর্শনার্থীদের স্বাগত জানাতে হিউ মনুমেন্টগুলি আবার খুলে দেওয়া হয়েছে](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/05/1762301089171_dung01-05-43-09still013-jpg.webp)

মন্তব্য (0)