|

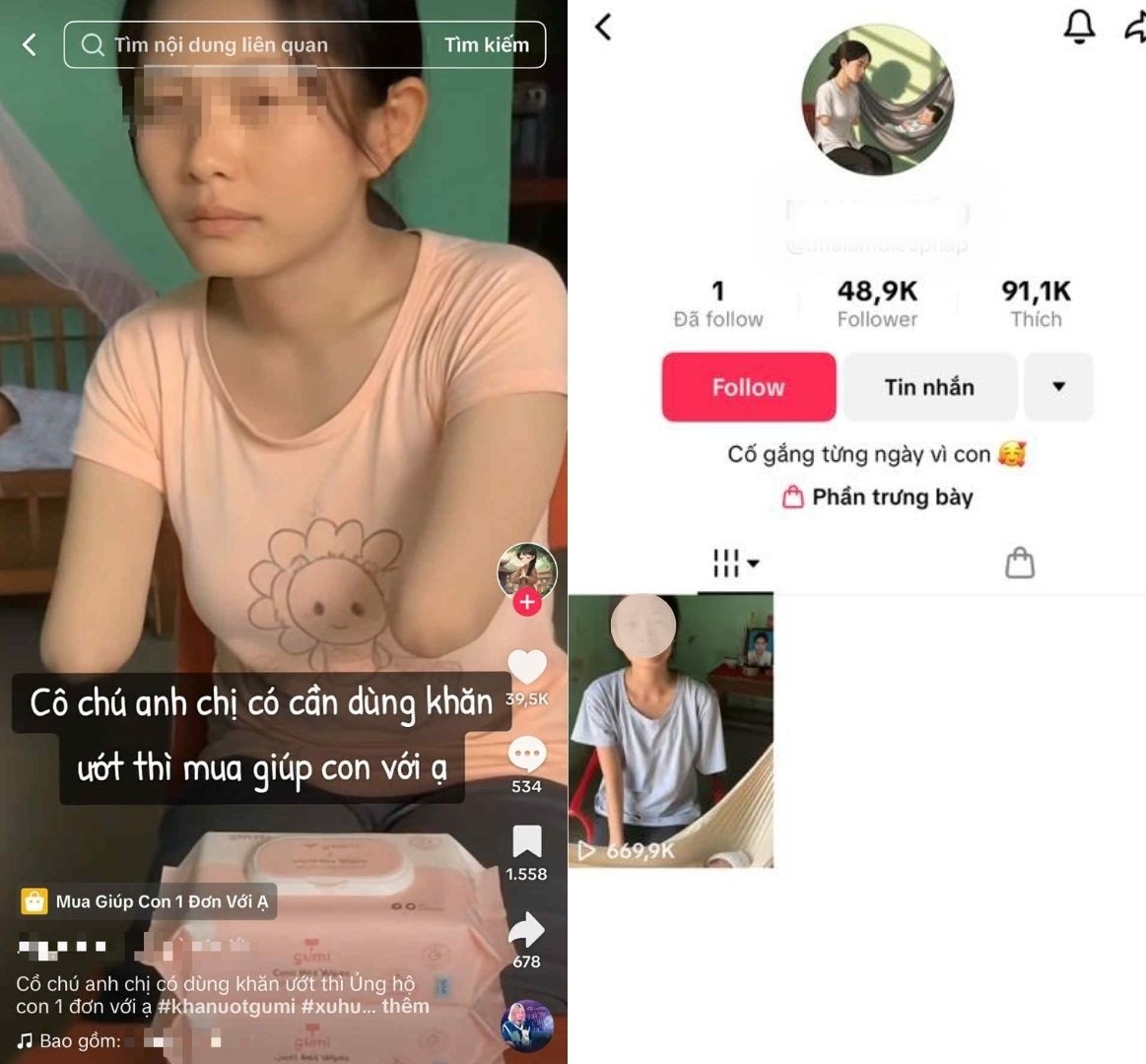

বিক্রেতার ছদ্মবেশে AI ব্যবহার করে অ্যাকাউন্ট। ছবি: TikTok । |

সাম্প্রতিক সময়ে উন্নত AI সরঞ্জামের একটি সিরিজের আবির্ভাবের সাথে সাথে, মাত্র কয়েকটি কমান্ডের সাহায্যে ছবি এবং ভিডিও তৈরি করা অনেক সহজ হয়ে গেছে। তবে, ইন্টারনেট ব্যবহারকারীদের আসল এবং নকলের মধ্যে পার্থক্য করার ক্ষমতা সেই বিকাশের সাথে তাল মিলিয়ে চলতে পারেনি, এবং কিছু বিষয় লাভের জন্য এটিকে কাজে লাগিয়েছে।

সম্প্রতি, একটি টিকটক অ্যাকাউন্ট সোশ্যাল মিডিয়ায় ছড়িয়ে পড়েছে, যেখানে এক মহিলার উভয় হাত কেটে ফেলার এবং তার ছোট বাচ্চাদের ভরণপোষণের জন্য জিনিসপত্র বিক্রি করার ভিডিও দেখানো হয়েছে। ক্লিপগুলিতে, এই ব্যক্তিটি সাধারণ পোশাক পরেন, কাগজের তোয়ালে এবং ডিটারজেন্টের মতো পণ্যগুলি চালু করার জন্য সহানুভূতির সাথে কথা বলেন।

রেকর্ড অনুসারে, মহিলাটি তার স্বামীর দুর্ঘটনার কারণে অকাল মৃত্যু, একা একটি ছোট সন্তানকে লালন-পালন করার পরিস্থিতি শেয়ার করেছিলেন, কিন্তু ভিডিওগুলির মাধ্যমে গল্পটি সামঞ্জস্যপূর্ণ ছিল না। অ্যাকাউন্টটি লক্ষ লক্ষেরও বেশি ভিউ এবং ইন্টারঅ্যাকশন পেয়েছে, চ্যানেলটি তৈরির 3 দিনের মধ্যে 100,000 অনুসারী বৃদ্ধি পেয়েছে। অনেকেই সহানুভূতি প্রকাশ করেছেন, সহায়তার আহ্বান জানিয়েছেন এবং এমনকি সাহায্যের জন্য পণ্য অর্ডার করেছেন।

ব্যবহারকারীরা একই রকম কন্টেন্ট সহ অ্যাকাউন্টগুলি আবিষ্কার করতে থাকে। এই চ্যানেলগুলির মধ্যে যা মিল রয়েছে তা হল এগুলি নতুন তৈরি ব্যক্তিগত পৃষ্ঠা, তাদের কোনও বাস্তব মিথস্ক্রিয়া ইতিহাস নেই এবং প্রায়শই অতিরিক্ত আবেগপূর্ণ কন্টেন্ট শেয়ার করে।

|

এই চ্যানেলগুলি প্রায়শই নতুন এবং তাদের স্পষ্ট প্রোফাইল থাকে না। |

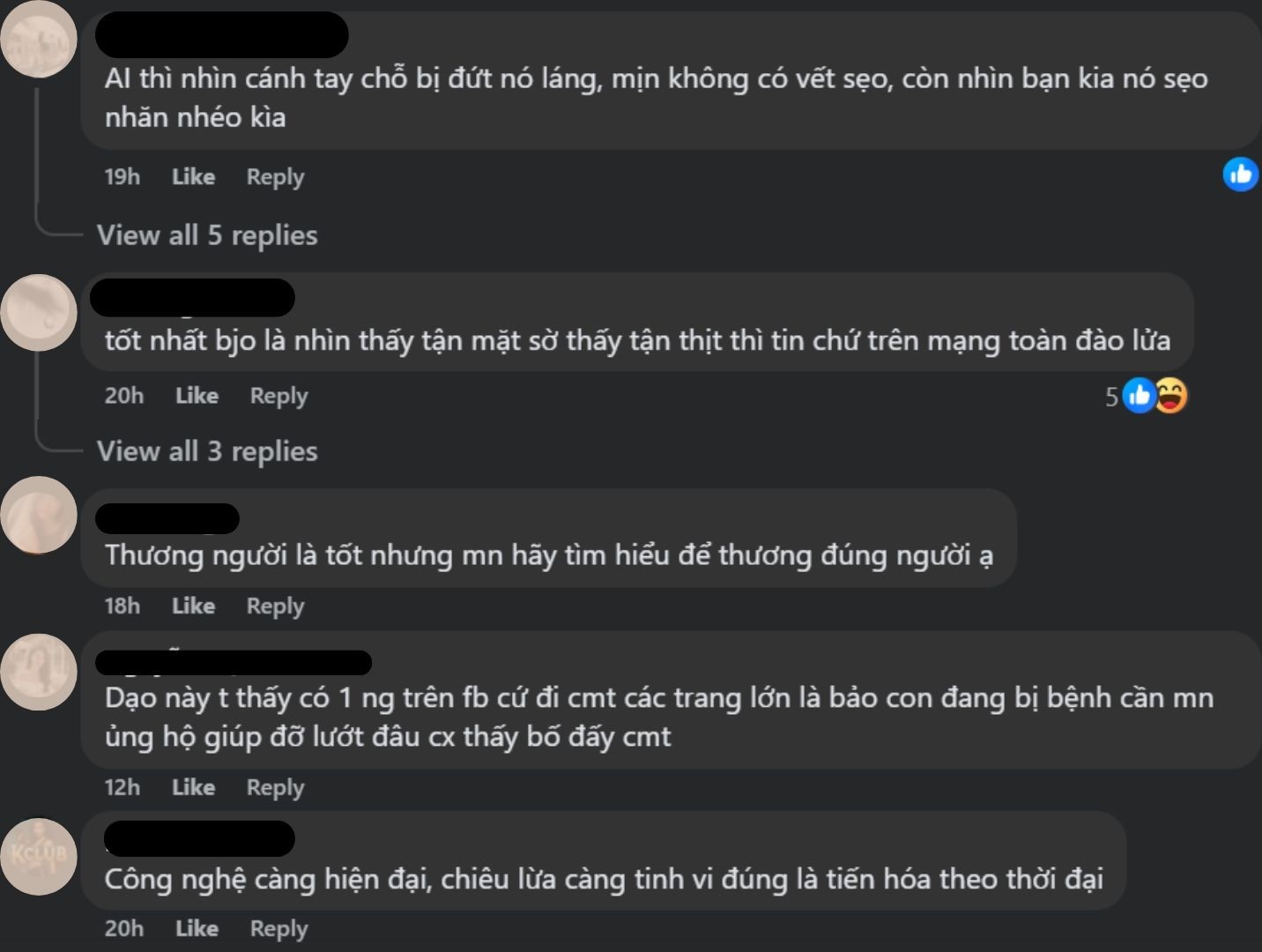

তবে, কিছুক্ষণ পর, নেটিজেনরা প্রতিটি ভিডিওতে অস্বাভাবিক এবং অসঙ্গত কিছু লক্ষ্য করলেন। উদাহরণস্বরূপ, মহিলার কাটা হাতটি খুব মসৃণ দেখাচ্ছিল, বাড়ির দেয়ালের রঙ আলাদা ছিল, অথবা শিশুটি অস্বাভাবিকভাবে স্থির অবস্থায় পড়ে ছিল। কারণ ছিল সমস্ত ক্লিপগুলি অন্যদের বোকা বানানোর জন্য AI দ্বারা তৈরি করা হয়েছিল।

এটি লক্ষণীয় যে সতর্কতামূলক বা প্রকাশক মন্তব্যগুলি অ্যাকাউন্ট মালিক দ্বারা লুকানো বা মুছে ফেলা হয়েছিল। অনেক মানুষ প্রতারিত হওয়ার জন্য বিরক্ত বোধ করেছিল, পাশাপাশি জনগণের সহানুভূতি থেকে লাভবান হওয়ার আচরণে ক্ষুব্ধ হয়েছিল।

এছাড়াও, এই ভুয়া ভিডিওগুলি মালিক এবং অন্যান্য প্রতিবন্ধী ব্যক্তিদের উপরও প্রভাব ফেলে যারা একই প্ল্যাটফর্মে জীবিকা নির্বাহ করে। নগা টিচ কুক চ্যানেলের মালিক ফু থোতে মিসেস ট্রান থি এনগা (৩৬ বছর বয়সী) কে ক্রমাগত বলতে হয়েছিল যে তার সত্যিই একটি হাত কেটে ফেলা হয়েছে।

২০২৪ সালের শেষের দিকে, এই ব্যক্তি তীব্র ভাইরাল মায়োকার্ডাইটিসে আক্রান্ত হন এবং তার সমস্ত অঙ্গ-প্রত্যঙ্গ কেটে ফেলতে বাধ্য হন, পরিবারের ভালোবাসায় নতুন করে জীবন শুরু করেন। সাম্প্রতিক একটি লাইভস্ট্রিমে, তিনি সন্দেহ করা এবং কঠোর কথাবার্তা পাওয়ার জন্য তার দুঃখ প্রকাশ করেন।

এই নতুন তৈরি চ্যানেলগুলি দ্রুত প্রচুর সংখ্যক ফলোয়ার অর্জন করে, যার ফলে পার্থক্য করা কঠিন হয়ে পড়ে। NLS নামে একই রকম কন্টেন্ট সহ আরেকটি অ্যাকাউন্ট মাত্র একটি ভিডিওর পরে প্রায় ৫০,০০০ ফলোয়ার বৃদ্ধি পায়।

|

প্রতারিত হওয়ার পর ব্যবহারকারীরা ক্ষোভ এবং আস্থা হারানোর কথা প্রকাশ করেছেন। |

অতএব, অনলাইন সম্প্রদায়কে দোষারোপ করা সম্ভব নয় যে তারা ধীরে ধীরে যা দেখে তার উপর বিশ্বাস হারিয়ে ফেলছে, এবং এর ফলে যাদের সত্যিকার অর্থে সাহায্যের প্রয়োজন তাদের আর যত্ন নিচ্ছে না। একজন মন্তব্য করেছেন যে যারা সম্প্রদায়ের আবেগকে কাজে লাগানোর জন্য AI প্রযুক্তি ব্যবহার করেন তাদের নিন্দা করা উচিত।

সাইবার জালিয়াতির স্কিমগুলি ক্রমশ জটিল হয়ে উঠছে, যাদের সাথে খুব কম যোগাযোগ আছে বা বয়স্ক ব্যক্তিরা লক্ষ্যবস্তু। বেশিরভাগ অ্যাকাউন্টধারীরা হাসপাতালে ভর্তি বা অক্ষমতার মতো মানসিক আঘাতে ভুগছেন এমন ব্যক্তিদের ছবি ব্যবহার করেন, তারপর শপিং কার্ট সংযুক্ত করেন বা সহায়তার জন্য কল করার জন্য অ্যাকাউন্ট নম্বর রেখে যান।

এর আগে, সিএনবিসি ৩০টিরও বেশি ইনস্টাগ্রাম, ইউটিউব এবং টিকটক অ্যাকাউন্ট আবিষ্কার করেছিল, যেখানে ডাউন সিনড্রোমে আক্রান্ত ব্যক্তিদের ছদ্মবেশ ধারণ করে এআই ব্যবহার করা হয়েছিল। এই ব্যক্তিরা অনুসারীদের আকর্ষণ করতে এবং সম্প্রদায়ের তহবিল সংগ্রহের আহ্বান জানাতে হৃদয়বিদারক গল্প ব্যবহার করেছিলেন, কিন্তু বাস্তবে, তারা নিজেরাই অ্যাকাউন্টগুলি দখল করেছিলেন।

এই ঘটনাটি সতর্ক করে যে, বাস্তবসম্মত কন্টেন্ট পুনরুৎপাদনের ক্ষেত্রে AI-এর ক্ষমতা খারাপ ব্যক্তিদের দ্বারা শোষিত হতে পারে। প্রযুক্তি দ্রুত বিকশিত হওয়ার সাথে সাথে, ব্যবহারকারীদের এটিকে জনপ্রিয় করতে হবে, পাশাপাশি তাদের প্রিয়জনদের অনলাইন প্রতারণার শিকার হওয়া এড়াতে সাহায্য করতে হবে।

সূত্র: https://znews.vn/video-nghi-ai-gia-nguoi-khuet-tat-ban-hang-gay-buc-xuc-post1598306.html

মন্তব্য (0)