Jak fungují falešné obrázky s umělou inteligencí?

Umělá inteligence je dnes všude – dokonce i ve válce. Aplikace umělé inteligence se letos natolik zlepšily, že téměř kdokoli může použít generátory umělé inteligence k vytváření obrázků, které vypadají realisticky, alespoň na první pohled.

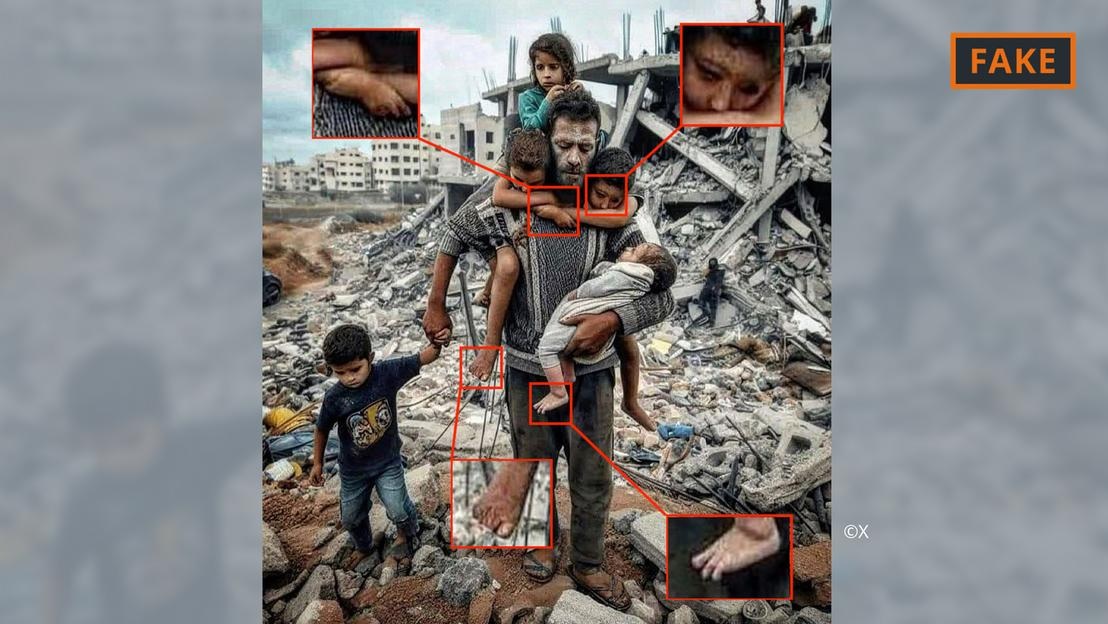

Falešná fotografie války v Gaze vygenerovaná umělou inteligencí.

Uživatelé jednoduše poskytnou nástrojům jako Midjourney nebo Dall-E několik pokynů, včetně specifikací a informací. Nástroje umělé inteligence pak převedou textové, nebo dokonce hlasové, pokyny do obrázků.

Tento proces generování obrázků je založen na takzvaném strojovém učení. Pokud například tvůrce požádá o zobrazení 70letého muže jedoucího na kole, prohledá svou databázi a vyhledá odpovídající výrazy k obrázkům.

Na základě dostupných informací algoritmus umělé inteligence vygeneruje obrázek staršího cyklisty. Díky stále většímu množství vstupů a technických aktualizací se tyto nástroje výrazně zlepšily a neustále se učí.

To vše se vztahuje na snímky související s konfliktem na Blízkém východě. V konfliktu, kde „jsou emoce tak silné“, mají dezinformace, včetně šíření prostřednictvím snímků vytvořených umělou inteligencí, obrovský dopad, říká expert na umělou inteligenci Hany Farid.

Farid, profesor digitální analytiky na Kalifornské univerzitě v Berkeley, uvedl, že nelítostné bitvy jsou ideální živnou půdou pro vytváření a šíření falešného obsahu a také pro podněcování emocí.

Typy obrazů války mezi Izraelem a Hamásem od umělé inteligence

Obrázky a videa vytvořené s pomocí umělé inteligence přiživují dezinformace týkající se války na Ukrajině a to se nadále děje i ve válce mezi Izraelem a Hamásem.

Podle odborníků se obrázky z umělé inteligence, které kolují na sociálních sítích a týkají se války, často dělí do dvou kategorií. Jedna se zaměřuje na utrpení lidí a vyvolává soucit. Druhou je falešná umělá inteligence, která události zveličuje, a tím podněcuje konflikty a stupňuje násilí.

Falešná fotografie otce a dítěte v troskách v Gaze vygenerovaná umělou inteligencí.

Například do první kategorie patří výše uvedená fotografie otce a jeho pěti dětí před hromadou sutin. Byla několikrát sdílena na X (dříve Twitter) a Instagramu a zhlédnuta stovky tisíckrát.

Tento obrázek byl komunitou, alespoň na X, označen jako falešný. Lze jej rozpoznat podle různých chyb a nesrovnalostí, které jsou běžné pro obrázky vytvořené umělou inteligencí (viz obrázek výše).

Podobné anomálie lze vidět i na falešném obrázku vytvořeném umělou inteligencí, který se stal virálním na X níže a který údajně ukazuje palestinskou rodinu, jak společně jí na troskách.

Falešná fotografie palestinské strany vygenerovaná umělou inteligencí.

Mezitím další snímek zachycující vojáky mávající izraelskými vlajkami, jak procházejí osadou plnou vybombardovaných domů, spadá do druhé kategorie, jejímž cílem je podněcovat nenávist a násilí.

Odkud se takové obrázky s umělou inteligencí berou?

Většina obrázků konfliktů generovaných umělou inteligencí je zveřejněna na platformách sociálních médií, ale jsou k dispozici i na řadě dalších platforem a organizací a dokonce i na některých zpravodajských webech.

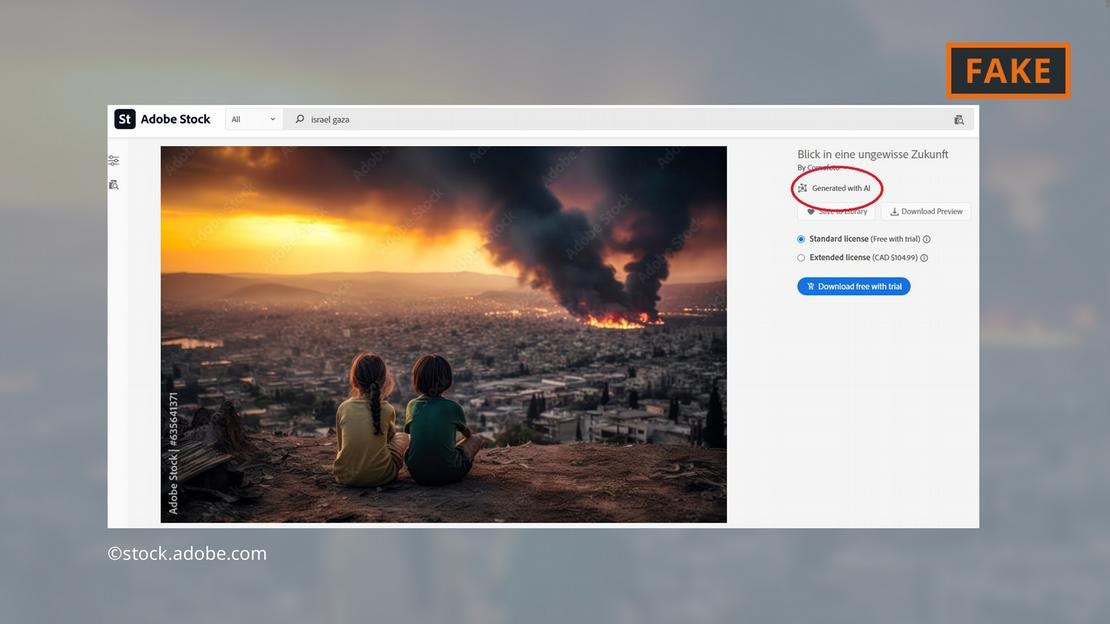

Softwarová společnost Adobe se dostala na titulní stránky novin tím, že do konce roku 2022 přidala do své nabídky fotografií obrázky generované umělou inteligencí. V databázi budou odpovídajícím způsobem označeny.

Společnost Adobe nyní také nabízí k prodeji snímky války na Blízkém východě vytvořené umělou inteligencí – například exploze, protestující lidi nebo oblaka kouře za mešitou Al-Aksá.

Společnost Adobe nabízí snímky bojů v Gaze generované umělou inteligencí.

Kritici to shledali znepokojivým, protože některé weby nadále používaly obrázky, aniž by je označily jako generované umělou inteligencí. Dotyčný obrázek se například objevil na stránce „Newsbreak“ bez jakéhokoli náznaku, že byl generován umělou inteligencí.

Dokonce i výzkumná služba Evropského parlamentu, vědecká složka Evropského parlamentu, ilustrovala online text o konfliktu na Blízkém východě obrázkem z databáze Adobe vytvořeným umělou inteligencí – aniž by jej označila za generovaný umělou inteligencí.

Evropská observatoř digitálních médií naléhavě vyzývá novináře a mediální profesionály, aby byli při používání snímků z umělé inteligence extrémně opatrní, a nedoporučuje je používat, zejména při informování o skutečných událostech, jako je válka v Gaze.

Jak nebezpečné jsou obrázky s umělou inteligencí?

Virální obsah a obrázky s umělou inteligencí nutně vyvolávají v uživatelích nepříjemné pocity ohledně všeho, s čím se online setkávají. „Pokud se dostaneme do světa, kde lze manipulovat s obrázky, zvukem a videem, vše se stane podezřelým,“ vysvětluje výzkumník z Kalifornské univerzity v Berkeley, Farid. „Takže ztratíte důvěru ve všechno, včetně pravdy.“

Přesně to se stalo v následujícím případě: Izraelský premiér Benjamin Netanjahu a několik dalších politiků sdíleli na sociálních sítích obrázek něčeho, co je pravděpodobně ohořelé tělo izraelského dítěte.

Protiizraelský influencer Jackson Hinkle později prohlásil, že obrázek byl vytvořen pomocí umělé inteligence. Hinkleho prohlášení bylo na sociálních sítích zhlédnuto více než 20 milionůkrát a vedlo k bouřlivé debatě na platformě.

Nakonec řada organizací a ověřovacích nástrojů prohlásila, že obrázek je skutečný a Hinkleho tvrzení je nepravdivé. Je však jasné, že žádný nástroj nemůže uživatelům snadno pomoci znovu získat ztracenou důvěru!

Hoang Hai (podle DW)

Zdroj

![[Fotografie] Lam Dong: Snímky škod po údajném protržení jezera v Tuy Phongu](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762078736805_8e7f5424f473782d2162-5118-jpg.webp)

![[Fotografie] Prezident Luong Cuong přijal ministra války USA Peta Hegsetha](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/02/1762089839868_ndo_br_1-jpg.webp)

Komentář (0)