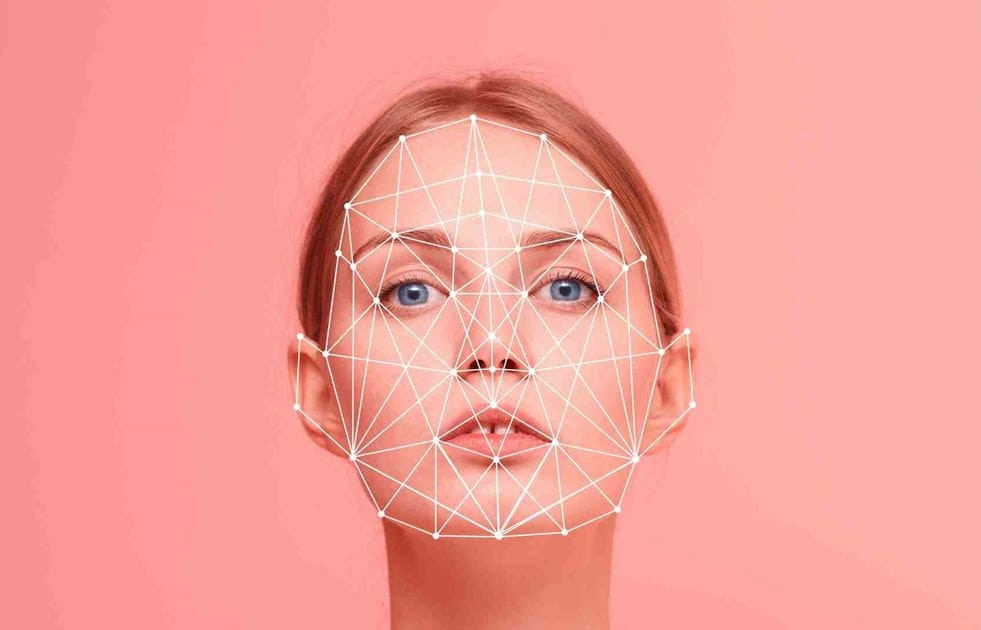

Deepfake je termín vzniklý spojením slov „Deep Learning“ a „Fake“. Jednoduše řečeno, jedná se o technologii pro simulaci a vytváření falešných zvukových, obrazových nebo dokonce video produktů.

Vzhledem k explozivnímu rozvoji umělé inteligence (AI) se problém deepfake stal stále populárnějším a vytvářel vlny falešných informací šířících se v tisku. Proto je proaktivní ověřování původu obrázků a videí naléhavým problémem pro přední světové společnosti vyrábějící fotoaparáty.

Očekává se, že společnosti Sony, Canon a Nikon uvedou na trh digitální fotoaparáty, které budou podporovat digitální podpisy přímo na svých bezzrcadlových fotoaparátech (nebo digitálních digitálních zrcadlovkách). Snaha o implementaci digitálních podpisů do fotoaparátů je nesmírně důležitým opatřením, které vytváří důkazy o původu a integritě snímků.

Tyto digitální podpisy budou obsahovat informace o datu, čase, místě, fotografovi a budou chráněny proti neoprávněné manipulaci. To je obzvláště důležité pro fotožurnalisty a další profesionály, jejichž práce vyžaduje ověřování.

Tři giganti v odvětví fotoaparátů se dohodli na globálním standardu pro digitální podpisy kompatibilním s online ověřovacím nástrojem Verify. Nástroj, který spustila koalice globálních zpravodajských organizací, technologických společností a výrobců fotoaparátů, umožní bezplatné ověření pravosti jakéhokoli obrázku. Pokud jsou obrázky vytvořeny nebo upraveny pomocí umělé inteligence, Verify je označí jako „Bez ověření obsahu“.

Důležitost technologií proti deepfake pramení z rychlého nárůstu deepfakes slavných osobností, jako je bývalý americký prezident Donald Trump a japonský premiér Fumio Kišida.

Vědci z Univerzity Tsinghua v Číně navíc vyvinuli nový generativní model umělé inteligence, který dokáže generovat přibližně 700 000 obrázků denně.

Kromě výrobců fotoaparátů se do boje proti deepfakes zapojují i další technologické společnosti. Google vydal nástroj pro digitální vodoznakování obrázků generovaných umělou inteligencí, zatímco Intel vyvinul technologii, která analyzuje změny odstínu pleti na fotografiích a pomáhá určit jejich autenticitu. Hitachi také pracuje na technologii pro prevenci online podvodů s identitou.

Očekává se, že nová technologie bude k dispozici začátkem roku 2024. Společnost Sony plánuje technologii propagovat v médiích a již provedla terénní testy v říjnu 2023. Společnost Canon spolupracuje se společnostmi Thomson Reuters a Starling Data Preservation Lab (výzkumným ústavem založeným Stanfordskou univerzitou a Jižní Kalifornskou univerzitou) na dalším zdokonalení technologie.

Výrobci fotoaparátů doufají, že nová technologie pomůže obnovit důvěru veřejnosti v obrazy, které následně utvářejí naše vnímání světa.

(podle OL)

Facebooku zaplatil 5 000 dolarů za šíření deepfake investičního podvodného videa.

Nový malware ovládá chytré telefony, deepfake videa jsou stále sofistikovanější

Deepfake videa jsou stále sofistikovanější a realističtější.

Co dělat, abyste se vyhnuli pasti deepfake videohovorů, které podvádějí s převody peněz?

Deepfake je zneužíván k vkládání obličejů obětí do porno videí.

Zdroj

![[Foto] Premiér Pham Minh Chinh přijal předsedu Japonsko-vietnamské asociace přátelství v regionu Kansai](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762176259003_ndo_br_dsc-9224-jpg.webp)

![[Fotografie] Lam Dong: Detail nelegálního jezera s rozbitou zdí](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762166057849_a5018a8dcbd5478b1ec4-jpg.webp)

![[Foto] Generální tajemník To Lam přijal singapurského velvyslance Jayu Ratnama](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762171461424_a1-bnd-5309-9100-jpg.webp)

![[Foto] Podzimní veletrh 2025 a působivé rekordy](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/03/1762180761230_ndo_br_tk-hcmt-15-jpg.webp)

Komentář (0)