Η ραγδαία και απροσδόκητη ανάπτυξη του ChatGPT - ενός chatbot τεχνητής νοημοσύνης (AI) με ανώτερες λειτουργίες - έχει αλλάξει σε κάποιο βαθμό την ανθρώπινη ζωή, ειδικά στον τρόπο εργασίας. Ωστόσο, οι κίνδυνοι που σχετίζονται με αυτήν την τεχνολογία έχουν εγείρει πολλές ανησυχίες για τις αρχές σε πολλές χώρες, ιδίως ανησυχίες σχετικά με τα δεδομένα των χρηστών.

Στο πλαίσιο ότι ο κόσμος εξακολουθεί να μην διαθέτει ένα ισχυρό νέο νομικό πλαίσιο για την αποτελεσματική διαχείριση της Τεχνητής Νοημοσύνης και τη διασφάλιση υψηλής αξιοπιστίας για τους χρήστες, πολλές χώρες έχουν αρχίσει να λαμβάνουν μέτρα για τη ρύθμιση της χρήσης του ChatGPT και της Τεχνητής Νοημοσύνης γενικότερα, με στόχο την ελαχιστοποίηση των κινδύνων που συνεπάγεται αυτή η τεχνολογία.

Πολλές χώρες «αναλαμβάνουν δράση» με την Τεχνητή Νοημοσύνη

Η Ιταλία βρίσκεται στην πρώτη γραμμή της έκδοσης απόφασης απαγόρευσης του ChatGPT.

Στις 31 Μαρτίου, οι ιταλικές αρχές εξέδωσαν προσωρινή απαγόρευση στην εφαρμογή ChatGPT λόγω ανησυχιών για την προστασία της ιδιωτικής ζωής και της αδυναμίας της εφαρμογής να επαληθεύσει χρήστες ηλικίας 13 ετών και άνω, όπως απαιτείται από την Ιταλία. Ταυτόχρονα, η Ιταλία δήλωσε επίσης ότι θα ξεκινήσει έρευνα σχετικά με τον τρόπο με τον οποίο το OpenAI χρησιμοποιεί τα δεδομένα των χρηστών.

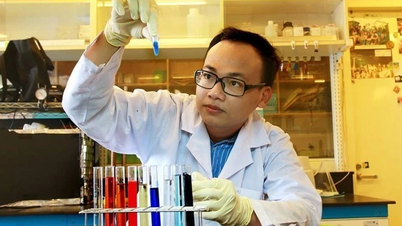

Μετά την απαγόρευση του ChatGPT από την Ιταλία, πολλές χώρες έχουν λάβει μέτρα κατά της εφαρμογής. (Φωτογραφία: Reuters).

Η ιταλική αρχή προστασίας δεδομένων έδωσε στην OpenAI - την εταιρεία που δημιούργησε το ChatGPT - προθεσμία έως τα τέλη Απριλίου για να συμμορφωθεί με τις απαιτήσεις προστασίας δεδομένων και απορρήτου πριν από την επανέναρξη των κανονικών λειτουργιών στη χώρα.

Αμέσως μετά την απόφαση της Ιταλίας, πολλές χώρες άρχισαν να «ακολουθούν» αυτήν τη χώρα στο μπλοκάρισμα του ChatGPT λόγω ανησυχιών που σχετίζονται με ζητήματα ασφάλειας και απορρήτου δεδομένων.

Οι γαλλικές και ιρλανδικές ρυθμιστικές αρχές απορρήτου και ασφάλειας επικοινώνησαν με τους ιταλούς ομολόγους τους για να μάθουν για τη βάση της απαγόρευσης. Η γαλλική αρχή προστασίας δεδομένων προσωπικού χαρακτήρα CNIL δήλωσε στις 11 Απριλίου ότι διερευνά αρκετές καταγγελίες σχετικά με το ChatGPT.

Ο Γερμανός επίτροπος προστασίας δεδομένων δήλωσε ότι το Βερολίνο είναι πιθανό να «ακολουθήσει τα βήματα της Ιταλίας» μπλοκάροντας το ChatGPT.

Αξίζει να σημειωθεί ότι η Ευρωπαϊκή Αρχή Προστασίας Δεδομένων (EDPB) συγκρότησε μια ομάδα εργασίας για το ChatGPT στις 13 Απριλίου, αναφέροντας: «Τα κράτη μέλη του EDPB συζήτησαν την πρόσφατη δράση επιβολής της ιταλικής αρχής προστασίας δεδομένων κατά του OpenAI σχετικά με την υπηρεσία ChatGPT. Το EDPB αποφάσισε να συγκροτήσει μια ομάδα εργασίας για την προώθηση της συνεργασίας και την ανταλλαγή πληροφοριών σχετικά με πιθανές δράσεις επιβολής».

Επιπλέον, οι νομοθέτες της Ευρωπαϊκής Ένωσης (ΕΕ) συζητούν επίσης τον Νόμο της ΕΕ για την Τεχνητή Νοημοσύνη, ο οποίος θα ρυθμίζει οποιονδήποτε παρέχει προϊόντα ή υπηρεσίες χρησιμοποιώντας Τεχνητή Νοημοσύνη, συμπεριλαμβανομένων συστημάτων που παράγουν περιεχόμενο, προβλέψεις, συστάσεις ή αποφάσεις που επηρεάζουν το περιβάλλον. Η ΕΕ πρότεινε επίσης την ταξινόμηση διαφορετικών εργαλείων Τεχνητής Νοημοσύνης ανάλογα με το επίπεδο κινδύνου τους, από χαμηλό έως μη αποδεκτό.

Η ισπανική υπηρεσία προστασίας δεδομένων AEPD ανακοίνωσε ότι διεξάγει προκαταρκτική έρευνα σχετικά με τις παραβιάσεις δεδομένων της ChatGPT.

Στην Αυστραλία, το Υπουργείο Επιστήμης και Τεχνολογίας ανακοίνωσε στις 12 Απριλίου ότι η κυβέρνηση ζήτησε από το επιστημονικό συμβουλευτικό της όργανο συμβουλές σχετικά με τον τρόπο αντιμετώπισης της Τεχνητής Νοημοσύνης και εξετάζει τα επόμενα βήματα.

Η κίνηση αυτή εγείρει ερωτήματα σχετικά με την ασφάλεια της Τεχνητής Νοημοσύνης και τι μπορούν να κάνουν οι κυβερνήσεις για να μετριάσουν τους κινδύνους της. Μια έκθεση του Μαρτίου από την εταιρεία συμβούλων KPMG και την Αυστραλιανή Ένωση Βιομηχανίας Πληροφοριών διαπίστωσε ότι τα δύο τρίτα των Αυστραλών δήλωσαν ότι δεν υπήρχαν επαρκείς νόμοι ή κανονισμοί για την αποτροπή της κακής χρήσης της Τεχνητής Νοημοσύνης, ενώ λιγότεροι από τους μισούς πίστευαν ότι η Τεχνητή Νοημοσύνη χρησιμοποιείται με ασφάλεια στον χώρο εργασίας.

Πολλές χώρες έχουν αρχίσει να λαμβάνουν μέτρα για τη ρύθμιση της τεχνολογίας τεχνητής νοημοσύνης. (Φωτογραφία: Reuters).

Στο Ηνωμένο Βασίλειο, η κυβέρνηση έχει δηλώσει ότι σκοπεύει να κατανείμει την ευθύνη για τη ρύθμιση της Τεχνητής Νοημοσύνης μεταξύ των φορέων που είναι αρμόδιοι για τα ανθρώπινα δικαιώματα, την υγεία και την ασφάλεια και τον ανταγωνισμό, αντί να δημιουργήσει μια νέα ρυθμιστική αρχή.

Πρόσφατα, ο ηγέτης της πλειοψηφίας των Δημοκρατικών στη Γερουσία των ΗΠΑ, Τσακ Σούμερ, συνέταξε και εξέδωσε ένα νέο κανονιστικό πλαίσιο για την Τεχνητή Νοημοσύνη που θα μπορούσε να αποτρέψει καταστροφικές ζημιές στη χώρα. Η πρόταση του κ. Σούμερ απαιτεί από τις εταιρείες να επιτρέπουν σε ανεξάρτητους εμπειρογνώμονες να εξετάζουν και να δοκιμάζουν την τεχνολογία Τεχνητής Νοημοσύνης πριν από την κυκλοφορία ή την ενημέρωση της.

Νωρίτερα στις 11 Απριλίου, το Υπουργείο Εμπορίου των ΗΠΑ δήλωσε ότι ζητά δημόσια σχόλια σχετικά με τα μέτρα λογοδοσίας της Τεχνητής Νοημοσύνης.

Εν τω μεταξύ, το Κέντρο Τεχνητής Νοημοσύνης και Ψηφιακής Πολιτικής στις ΗΠΑ ζήτησε από την Επιτροπή Εμπορίου να εμποδίσει την OpenAI να κυκλοφορήσει νέες εμπορικές εκδόσεις του GPT-4, υποστηρίζοντας ότι η τεχνολογία είναι «προκατειλημμένη, παραπλανητική και θέτει σε κίνδυνο την ιδιωτικότητα και τη δημόσια ασφάλεια».

Εν τω μεταξύ, στην Ιαπωνία, ο Υπουργός Ψηφιακού Μετασχηματισμού Τάρο Κόνο δήλωσε ότι επιθυμεί η επερχόμενη σύνοδος των υπουργών Ψηφιακής Ανάπτυξης της G7, η οποία έχει προγραμματιστεί για τα τέλη Απριλίου, να συζητήσει τις τεχνολογίες Τεχνητής Νοημοσύνης, συμπεριλαμβανομένου του ChatGPT, και να παραδώσει ένα ενιαίο μήνυμα της G7.

Η Κίνα ανακοίνωσε πρόσφατα σχέδια μέτρων για τη ρύθμιση των υπηρεσιών τεχνητής νοημοσύνης, λέγοντας ότι οι εταιρείες που διαθέτουν τεχνολογία τεχνητής νοημοσύνης πρέπει να υποβάλλουν αξιολογήσεις ασφαλείας στις αρχές πριν από την κυκλοφορία των υπηρεσιών στην αγορά.

Οι ειδικοί προειδοποιούν για τους κινδύνους που προκαλεί η τεχνητή νοημοσύνη

Ορισμένοι ειδικοί λένε ότι η Τεχνητή Νοημοσύνη θα μπορούσε να οδηγήσει σε «πυρηνική καταστροφή». (Φωτογραφία: Reuters).

Μια έρευνα που δημοσιεύθηκε από το Ινστιτούτο Τεχνητής Νοημοσύνης του Πανεπιστημίου Στάνφορντ στις αρχές Απριλίου διαπίστωσε ότι το 36% των ερευνητών πιστεύει ότι η Τεχνητή Νοημοσύνη θα μπορούσε να οδηγήσει σε μια «καταστροφή σε πυρηνικό επίπεδο», υπογραμμίζοντας περαιτέρω τις υπάρχουσες ανησυχίες σχετικά με την ταχεία ανάπτυξη της τεχνολογίας.

Εν τω μεταξύ, το 73% της Τεχνητής Νοημοσύνης θα οδηγήσει σε «επαναστατική κοινωνική αλλαγή».

Η έκθεση αναφέρει ότι ενώ αυτές οι τεχνολογίες προσφέρουν δυνατότητες που ήταν αδιανόητες πριν από μια δεκαετία, είναι επίσης επιρρεπείς σε ψευδαισθήσεις, προκαταλήψεις και κατάχρηση για κακόβουλους σκοπούς, δημιουργώντας ηθικές προκλήσεις για τους χρήστες αυτών των υπηρεσιών.

Η έκθεση σημείωσε επίσης ότι ο αριθμός των «περιστατικών και των αντιπαραθέσεων» που σχετίζονται με την Τεχνητή Νοημοσύνη έχει αυξηθεί 26 φορές την τελευταία δεκαετία.

Τον περασμένο μήνα, ο δισεκατομμυριούχος Έλον Μασκ και ο συνιδρυτής της Apple, Στιβ Βόζνιακ, ήταν μεταξύ χιλιάδων τεχνολογικών ειδικών που υπέγραψαν μια επιστολή ζητώντας παύση στην εκπαίδευση συστημάτων τεχνητής νοημοσύνης (AI) πιο ισχυρών από το chatbot GPT-4 της Open AI, λέγοντας ότι «τα ισχυρά συστήματα τεχνητής νοημοσύνης θα πρέπει να αναπτυχθούν μόνο όταν είμαστε βέβαιοι ότι ο αντίκτυπός τους θα είναι θετικός και οι κίνδυνοι τους θα είναι διαχειρίσιμοι».

Yongkang (Reuters, AL Jazeera, ABC)

[διαφήμιση_2]

Πηγή

![[Φωτογραφία] Λήξη του 1ου Συνεδρίου των Αντιπροσώπων του Κόμματος των Κεντρικών Κομματικών Οργανισμών](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/24/b419f67738854f85bad6dbefa40f3040)

![[Φωτογραφία] Ο Αρχισυντάκτης της εφημερίδας Nhan Dan Le Quoc Minh δέχθηκε την αντιπροσωπεία εργασίας της εφημερίδας Pasaxon](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/23/da79369d8d2849318c3fe8e792f4ce16)

![[Φωτογραφία] Επίσημη έναρξη του 1ου Συνεδρίου των Αντιπροσώπων του Κόμματος των Κεντρικών Κομματικών Οργανισμών](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/24/82a89e250d4d43cbb6fcb312f21c5dd4)

Σχόλιο (0)