|

شرکت آنتروپیک به تازگی سیاست جدید خود را بهروزرسانی کرده است. عکس: GK Images . |

در ۲۸ آگوست، شرکت هوش مصنوعی آنتروپیک (Anthropic) از بهروزرسانی شرایط خدمات کاربری و سیاست حفظ حریم خصوصی خود خبر داد. کاربران اکنون میتوانند انتخاب کنند که آیا دادههایشان برای بهبود کلود (Claude) و تقویت محافظت در برابر سوءاستفادههایی مانند کلاهبرداری و تقلب استفاده شود یا خیر.

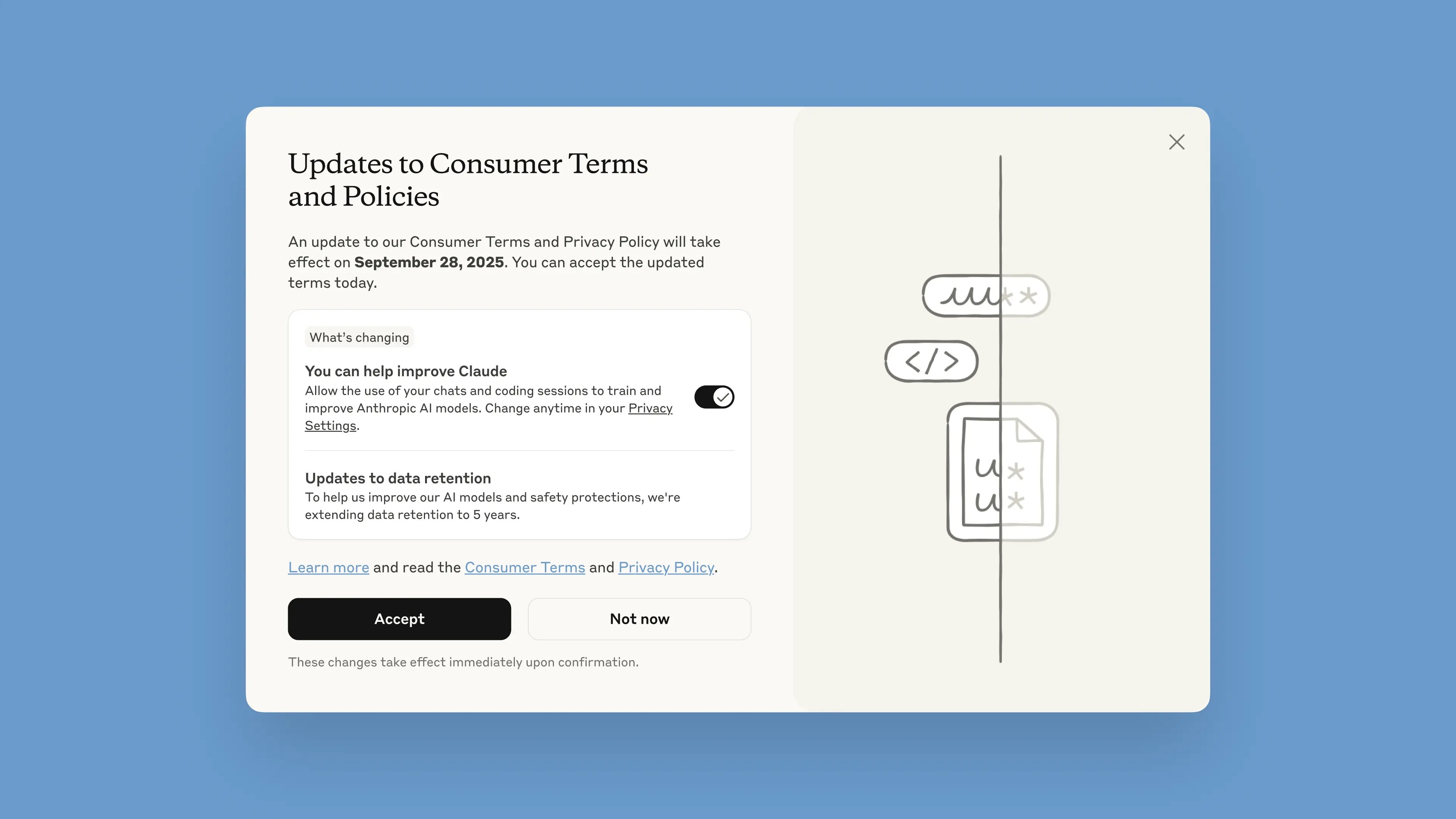

این اطلاعیه از ۲۸ آگوست در این چتبات منتشر خواهد شد. کاربران یک ماه فرصت دارند تا شرایط را بپذیرند یا رد کنند. سیاستهای جدید بلافاصله پس از پذیرش اعمال میشوند. پس از ۲۸ سپتامبر، کاربران برای ادامه استفاده از کلود ملزم به انتخاب خواهند بود.

طبق گفته این شرکت، این بهروزرسانیها برای کمک به ارائه مدلهای هوش مصنوعی قدرتمندتر و مفیدتر در نظر گرفته شدهاند. تنظیم این گزینه ساده است و میتوان آن را در هر زمانی در تنظیمات حریم خصوصی انجام داد.

این تغییرات شامل طرحهای Claude Free، Pro و Max میشود که شامل Claude Code، ابزار برنامهنویسی Anthropic، نیز میشود. سرویسهای تحت پوشش شرایط تجاری، شامل Claude for Work، Claude Gov، Claude for Education یا استفاده از APIها، از جمله از طریق اشخاص ثالث مانند Amazon Bedrock و Vertex AI گوگل کلود، اعمال نخواهند شد.

شرکت آنتروپیک در پست وبلاگ خود گفت: با مشارکت، کاربران به بهبود ایمنی مدل کمک میکنند، توانایی آن را در تشخیص دقیق محتوای مضر افزایش میدهند و خطر علامتگذاری اشتباه مکالمات بیضرر را کاهش میدهند. نسخههای آینده کلود نیز با مهارتهایی مانند برنامهنویسی، تجزیه و تحلیل و استدلال ارتقا خواهند یافت.

مهم است که کاربران کنترل کاملی بر دادههای خود داشته باشند و اینکه آیا به پلتفرم اجازه میدهند از آنها در یک پنجره بازشو استفاده کند یا خیر. حسابهای جدید میتوانند این مورد را به صورت اختیاری در طول فرآیند ثبت نام تنظیم کنند.

|

پنجره بازشو «شرایط جدید» در چتبات. عکس: آنتروپیک. |

دوره نگهداری دادهها به پنج سال افزایش یافته است که شامل مکالمات یا جلسات کدنویسی جدید یا ادامهدار و همچنین پاسخها به پاسخهای چتبات میشود. دادههای حذفشده در آینده برای آموزش مدل استفاده نخواهند شد. اگر کاربران با ارائه دادهها برای آموزش موافقت نکنند، سیاست نگهداری ۳۰ روزه فعلی ادامه خواهد یافت.

آنتروپیک در توضیح این سیاست گفت که چرخههای توسعه هوش مصنوعی معمولاً سالها طول میکشد و حفظ ثبات دادهها در طول فرآیند آموزش نیز به مدلها کمک میکند تا ثابت بمانند. نگهداری طولانیتر دادهها همچنین طبقهبندیکنندهها، سیستمهایی که برای شناسایی رفتارهای سوءاستفادهگرانه و تشخیص الگوهای مضر استفاده میشوند را بهبود میبخشد.

این شرکت نوشت: «برای محافظت از حریم خصوصی کاربران، ما از ترکیبی از ابزارها و فرآیندهای خودکار برای فیلتر کردن یا پنهان کردن دادههای حساس استفاده میکنیم. ما دادههای کاربران را به اشخاص ثالث نمیفروشیم.»

شرکت آنتروپیک اغلب به عنوان یکی از رهبران هوش مصنوعی ایمن شناخته میشود. آنتروپیک رویکردی به نام هوش مصنوعی مبتنی بر قانون اساسی (Constitutional AI) را توسعه داده است که اصول و دستورالعملهای اخلاقی را که مدلها باید از آنها پیروی کنند، تعیین میکند. آنتروپیک همچنین یکی از شرکتهایی است که تعهدات هوش مصنوعی ایمن را با دولتهای ایالات متحده، بریتانیا و گروه هفت امضا کرده است.

منبع: https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

نظر (0)