|

Anthropic ទើបតែបានធ្វើបច្ចុប្បន្នភាពគោលនយោបាយថ្មីរបស់ខ្លួន។ រូបថត៖ GK Images ។ |

នៅថ្ងៃទី 28 ខែសីហា ក្រុមហ៊ុន AI Anthropic បានប្រកាសពីការចាប់ផ្តើមអាប់ដេតចំពោះលក្ខខណ្ឌប្រើប្រាស់ និងគោលការណ៍ឯកជនភាពរបស់អ្នកប្រើប្រាស់របស់ខ្លួន។ ឥឡូវនេះ អ្នកប្រើប្រាស់អាចជ្រើសរើសអនុញ្ញាតឱ្យប្រើទិន្នន័យរបស់ពួកគេដើម្បីកែលម្អ Claude និងពង្រឹងការការពារប្រឆាំងនឹងការរំលោភបំពានដូចជាការបោកប្រាស់ និងការក្លែងបន្លំជាដើម។

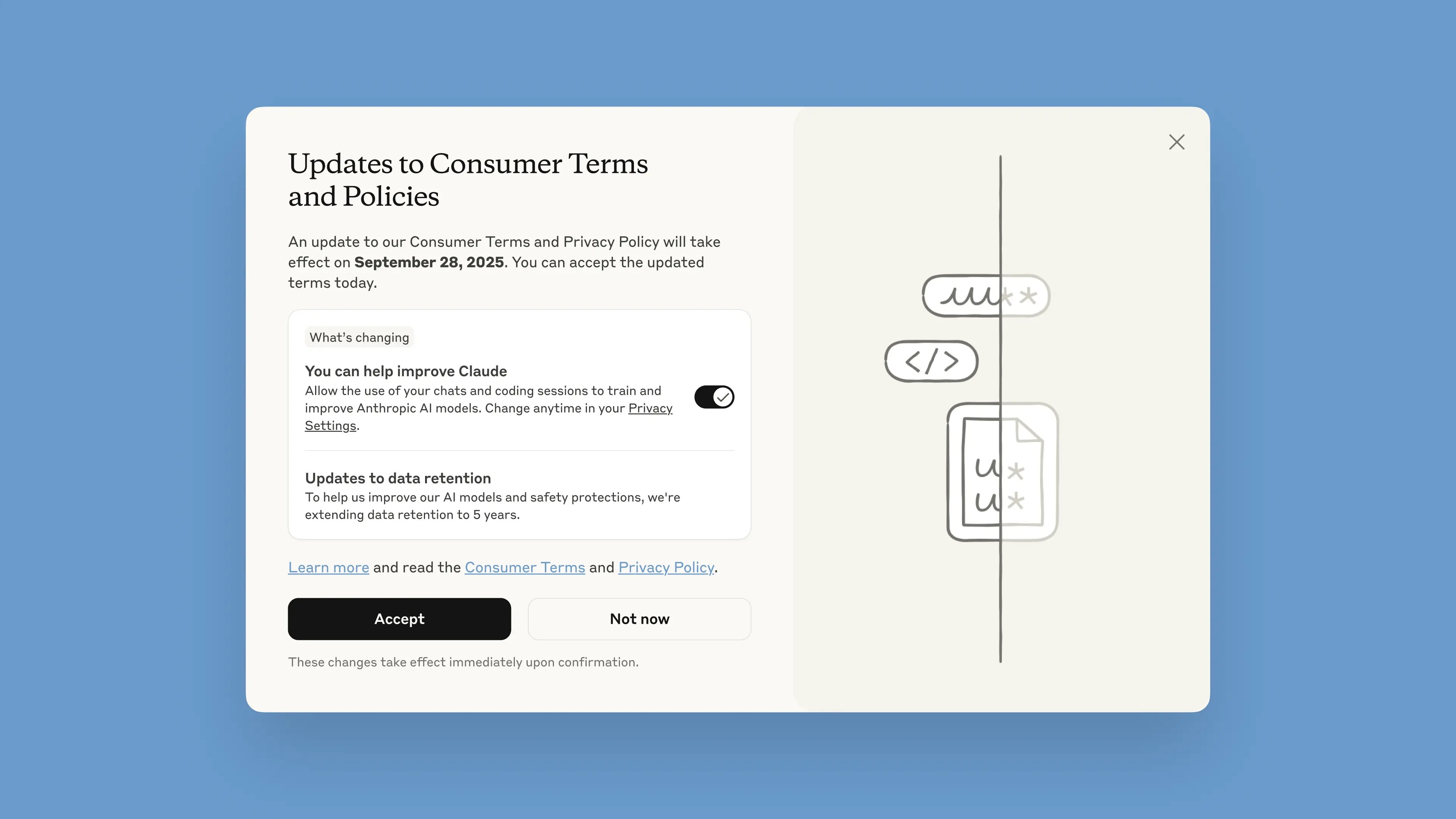

ការជូនដំណឹងនេះនឹងត្រូវបានផ្សព្វផ្សាយនៅក្នុង chatbot ចាប់ពីថ្ងៃទី 28 ខែសីហា។ អ្នកប្រើប្រាស់មានពេលមួយខែដើម្បីទទួលយក ឬបដិសេធលក្ខខណ្ឌ។ គោលនយោបាយថ្មីនឹងចូលជាធរមានភ្លាមៗនៅពេលទទួលយក។ បន្ទាប់ពីថ្ងៃទី 28 ខែកញ្ញា អ្នកប្រើប្រាស់នឹងត្រូវបានតម្រូវឱ្យជ្រើសរើសដើម្បីបន្តប្រើប្រាស់ Claude ។

យោងតាមក្រុមហ៊ុន ការអាប់ដេតនេះមានគោលបំណងជួយផ្តល់នូវម៉ូដែល AI ដែលមានថាមពល និងមានប្រយោជន៍ជាងមុន។ ការកែតម្រូវជម្រើសនេះគឺសាមញ្ញ ហើយអាចធ្វើបានគ្រប់ពេលនៅក្នុងការកំណត់ឯកជនភាព។

ការផ្លាស់ប្តូរទាំងនេះអនុវត្តចំពោះផែនការ Claude Free, Pro និង Max ដែលរួមមាន Claude Code ឧបករណ៍សរសេរកម្មវិធីរបស់ Anthropic ។ សេវាកម្មដែលគ្របដណ្តប់ដោយលក្ខខណ្ឌពាណិជ្ជកម្មនឹងមិនអនុវត្ត រួមទាំង Claude for Work, Claude Gov, Claude for Education ឬការប្រើប្រាស់ APIs រួមទាំងតាមរយៈភាគីទីបីដូចជា Amazon Bedrock និង Vertex AI របស់ Google Cloud ជាដើម។

Anthropic បាននិយាយនៅក្នុងប្លុករបស់ខ្លួនថាតាមរយៈការចូលរួម អ្នកប្រើប្រាស់នឹងជួយកែលម្អសុវត្ថិភាពរបស់ម៉ូដែលនេះ បង្កើនសមត្ថភាពរបស់វាក្នុងការរកឃើញមាតិកាដែលបង្កគ្រោះថ្នាក់ និងកាត់បន្ថយហានិភ័យនៃការដាក់ទង់ដោយច្រឡំនូវការសន្ទនាដែលមិនបង្កគ្រោះថ្នាក់។ កំណែនាពេលអនាគតរបស់ Claude ក៏នឹងត្រូវបានពង្រឹងជាមួយនឹងជំនាញដូចជាការសរសេរកម្មវិធី ការវិភាគ និងហេតុផលផងដែរ។

វាមានសារៈសំខាន់ដែលអ្នកប្រើប្រាស់មានការគ្រប់គ្រងពេញលេញលើទិន្នន័យរបស់ពួកគេ ហើយថាតើពួកគេអនុញ្ញាតឱ្យវេទិកាប្រើប្រាស់វានៅក្នុងបង្អួចដែលលេចឡើងឬអត់។ គណនីថ្មីអាចកំណត់វាជាជម្រើសក្នុងអំឡុងពេលដំណើរការចុះឈ្មោះ។

|

បង្អួចលេចឡើងលក្ខខណ្ឌថ្មីនៅក្នុង chatbot ។ រូបថត៖ Anthropic ។ |

រយៈពេលរក្សាទុកទិន្នន័យត្រូវបានកើនឡើងដល់ប្រាំឆ្នាំ ដែលអនុវត្តចំពោះការសន្ទនាថ្មី ឬបន្ត ឬវគ្គសរសេរកូដ ក៏ដូចជាការឆ្លើយតបទៅនឹងការឆ្លើយតបរបស់ chatbot ។ ទិន្នន័យដែលបានលុបនឹងមិនត្រូវបានប្រើដើម្បីបណ្តុះបណ្តាលគំរូនាពេលអនាគតទេ។ ប្រសិនបើអ្នកប្រើប្រាស់មិនជ្រើសរើសក្នុងការផ្តល់ទិន្នន័យសម្រាប់ការបណ្តុះបណ្តាលទេ ពួកគេនឹងបន្តជាមួយនឹងគោលការណ៍រក្សារយៈពេល 30 ថ្ងៃបច្ចុប្បន្ន។

ដោយពន្យល់ពីគោលការណ៍នេះ Anthropic បាននិយាយថា វដ្តនៃការអភិវឌ្ឍន៍ AI ជាធម្មតាចំណាយពេលច្រើនឆ្នាំ ហើយការរក្សាទិន្នន័យឱ្យជាប់លាប់ពេញមួយដំណើរការបណ្តុះបណ្តាលក៏ជួយឱ្យម៉ូដែលរក្សាភាពស្របគ្នាផងដែរ។ ការរក្សាទុកទិន្នន័យយូរជាងនេះក៏ធ្វើអោយប្រសើរឡើងនូវអ្នកចាត់ថ្នាក់ ប្រព័ន្ធដែលប្រើដើម្បីកំណត់អត្តសញ្ញាណអាកប្បកិរិយាបំពាន ដើម្បីរកមើលគំរូដែលបង្កគ្រោះថ្នាក់។

ក្រុមហ៊ុនបានសរសេរថា "ដើម្បីការពារភាពឯកជនរបស់អ្នកប្រើប្រាស់ យើងប្រើការរួមបញ្ចូលគ្នានៃឧបករណ៍ស្វ័យប្រវត្តិ និងដំណើរការដើម្បីត្រង ឬបិទបាំងទិន្នន័យរសើប។ យើងមិនលក់ទិន្នន័យអ្នកប្រើប្រាស់ទៅឱ្យភាគីទីបីទេ" ។

Anthropic ជារឿយៗត្រូវបានលើកឡើងថាជាអ្នកដឹកនាំម្នាក់នៅក្នុង AI សុវត្ថិភាព។ Anthropic បានបង្កើតវិធីសាស្រ្តមួយហៅថា AI រដ្ឋធម្មនុញ្ញ ដែលកំណត់គោលការណ៍សីលធម៌ និងគោលការណ៍ណែនាំដែលគំរូត្រូវតែអនុវត្តតាម។ Anthropic ក៏ជាក្រុមហ៊ុនមួយក្នុងចំណោមក្រុមហ៊ុនដែលបានចុះហត្ថលេខាលើកិច្ចសន្យាសុវត្ថិភាព AI ជាមួយ រដ្ឋាភិបាល សហរដ្ឋអាមេរិក ចក្រភពអង់គ្លេស និង G7។

ប្រភព៖ https://znews.vn/cong-ty-ai-ra-han-cuoi-cho-nguoi-dung-post1580997.html

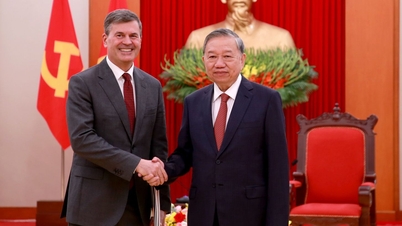

![[រូបថត] អគ្គលេខាធិកា To Lam ទទួលនាយកបណ្ឌិត្យសភារដ្ឋបាលសាធារណៈ និងសេដ្ឋកិច្ចជាតិ ក្រោមប្រធានសហព័ន្ធរុស្ស៊ី](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F08%2F1765200203892_a1-bnd-0933-4198-jpg.webp&w=3840&q=75)

Kommentar (0)