|

OpenAI는 2018년 이후 처음으로 공개형 AI 모델인 GPT-OSS를 출시했습니다. 가장 큰 특징은 이 모델이 무료로 공개되어 사용자가 일반 컴퓨터에 다운로드하여 사용자 정의하고 배포할 수 있다는 것입니다. 사진: OpenAI . |

|

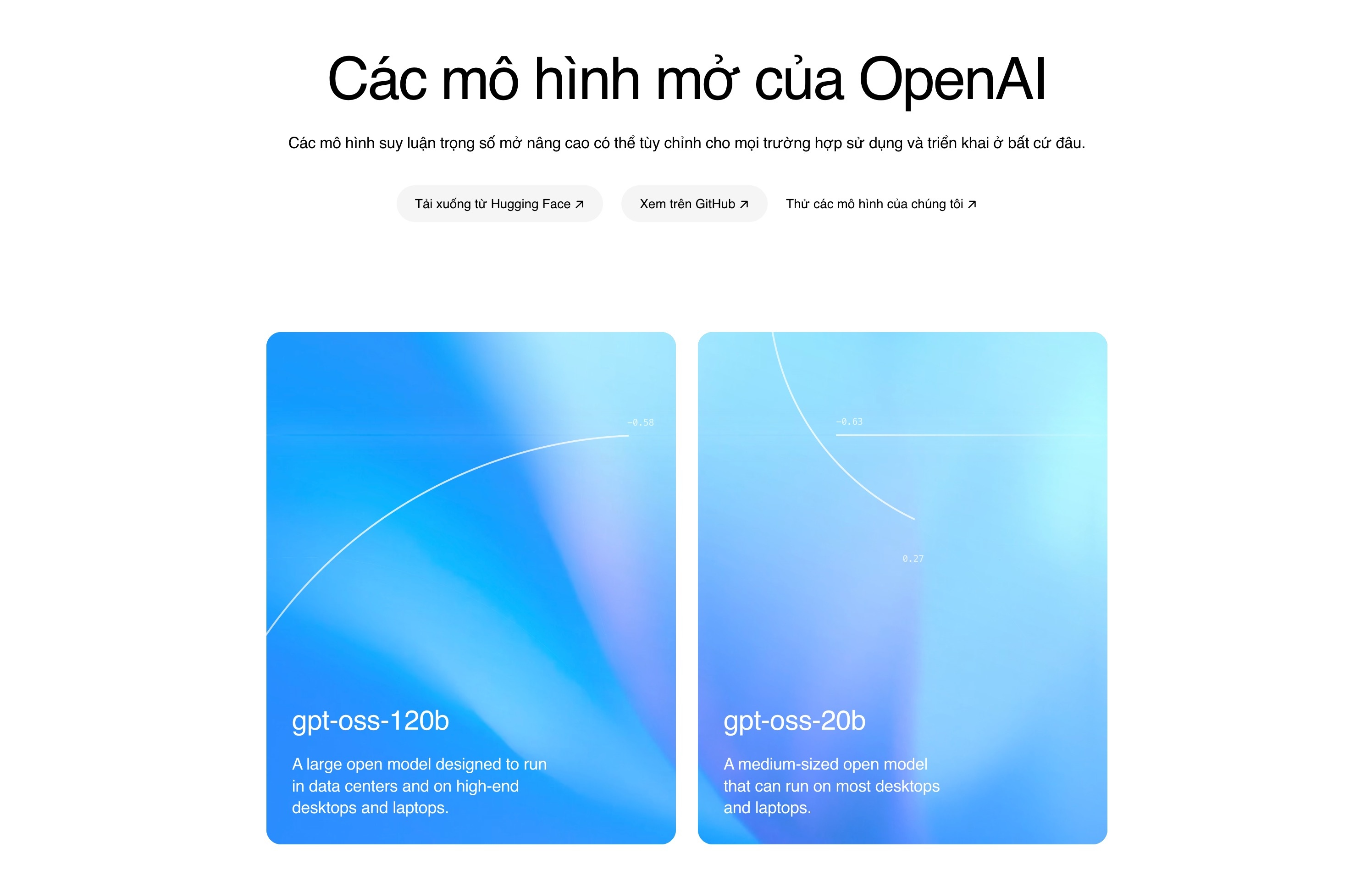

GPT-OSS는 두 가지 버전으로 제공됩니다. 하나는 200억 개의 매개변수를 가진 버전(GPT-OSS-20b)으로, 최소 16GB RAM의 컴퓨터에서 실행될 수 있습니다. 반면, 1,200억 개의 매개변수를 가진 버전(GPT-OSS-120b)은 80GB 메모리의 Nvidia GPU에서 실행될 수 있습니다. OpenAI에 따르면, 1,200억 개의 매개변수를 가진 버전은 o4-mini 모델과 동일하며, 200억 개의 매개변수를 가진 버전은 o3-mini 모델과 유사한 성능을 보입니다. |

|

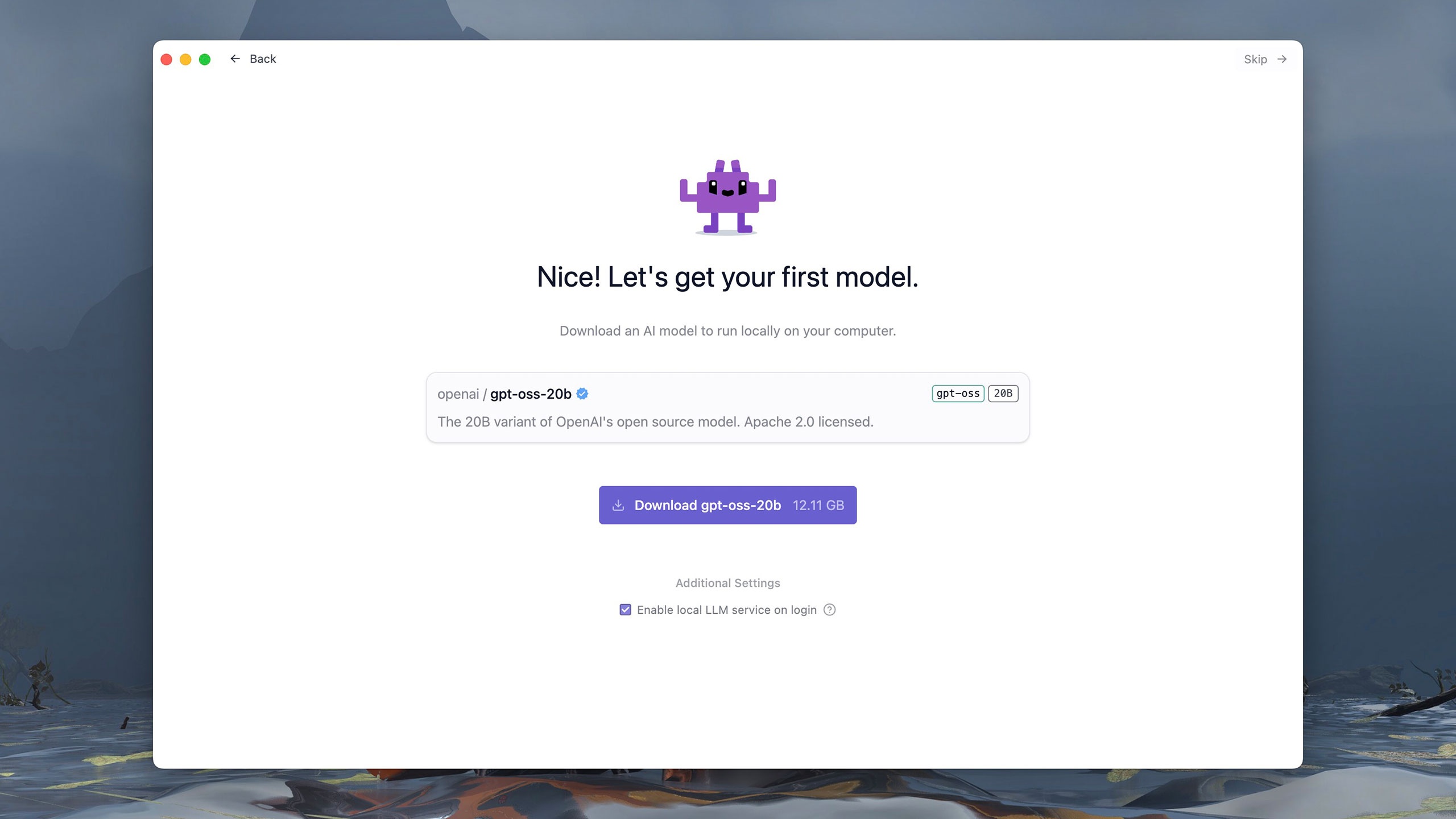

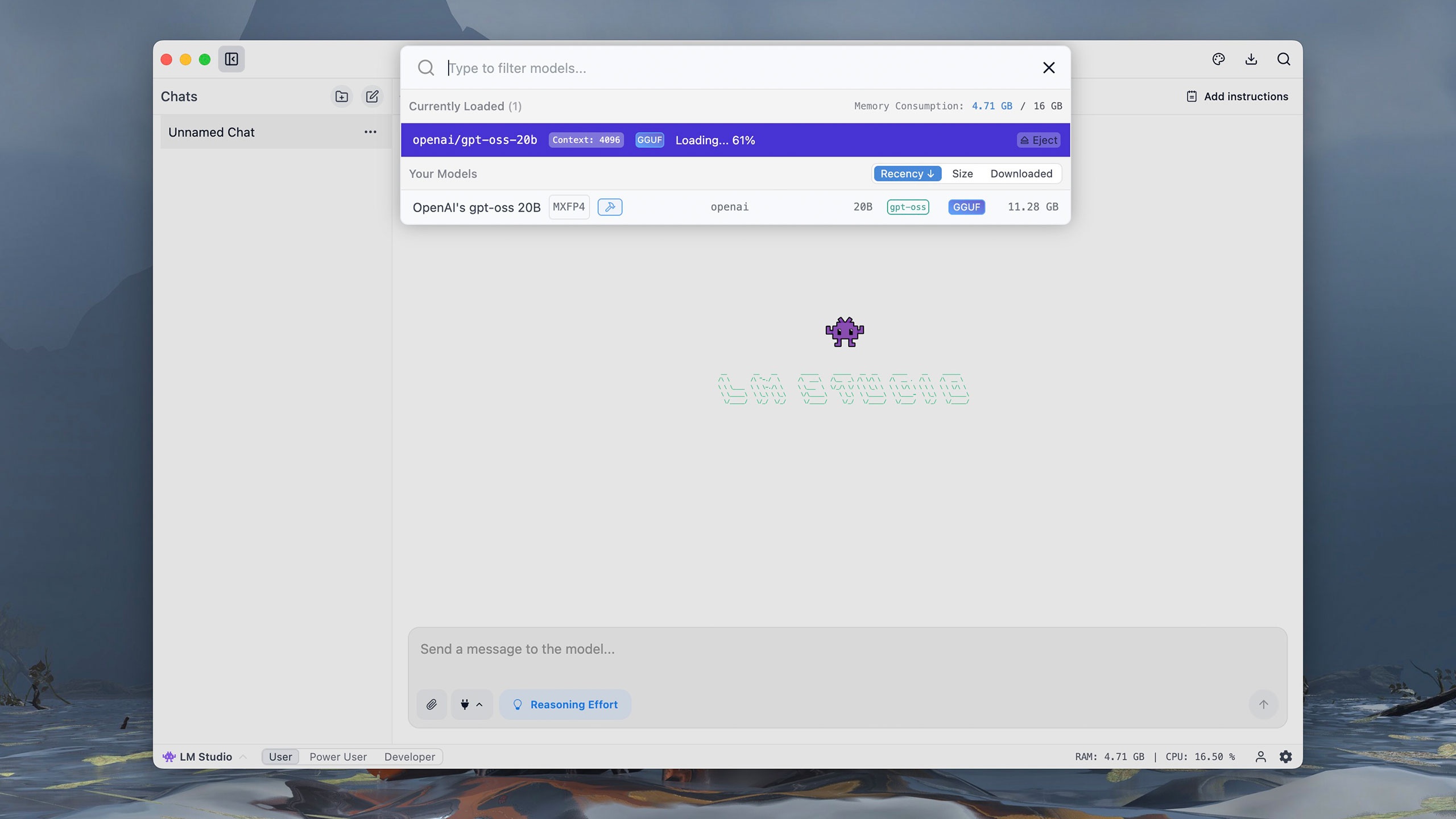

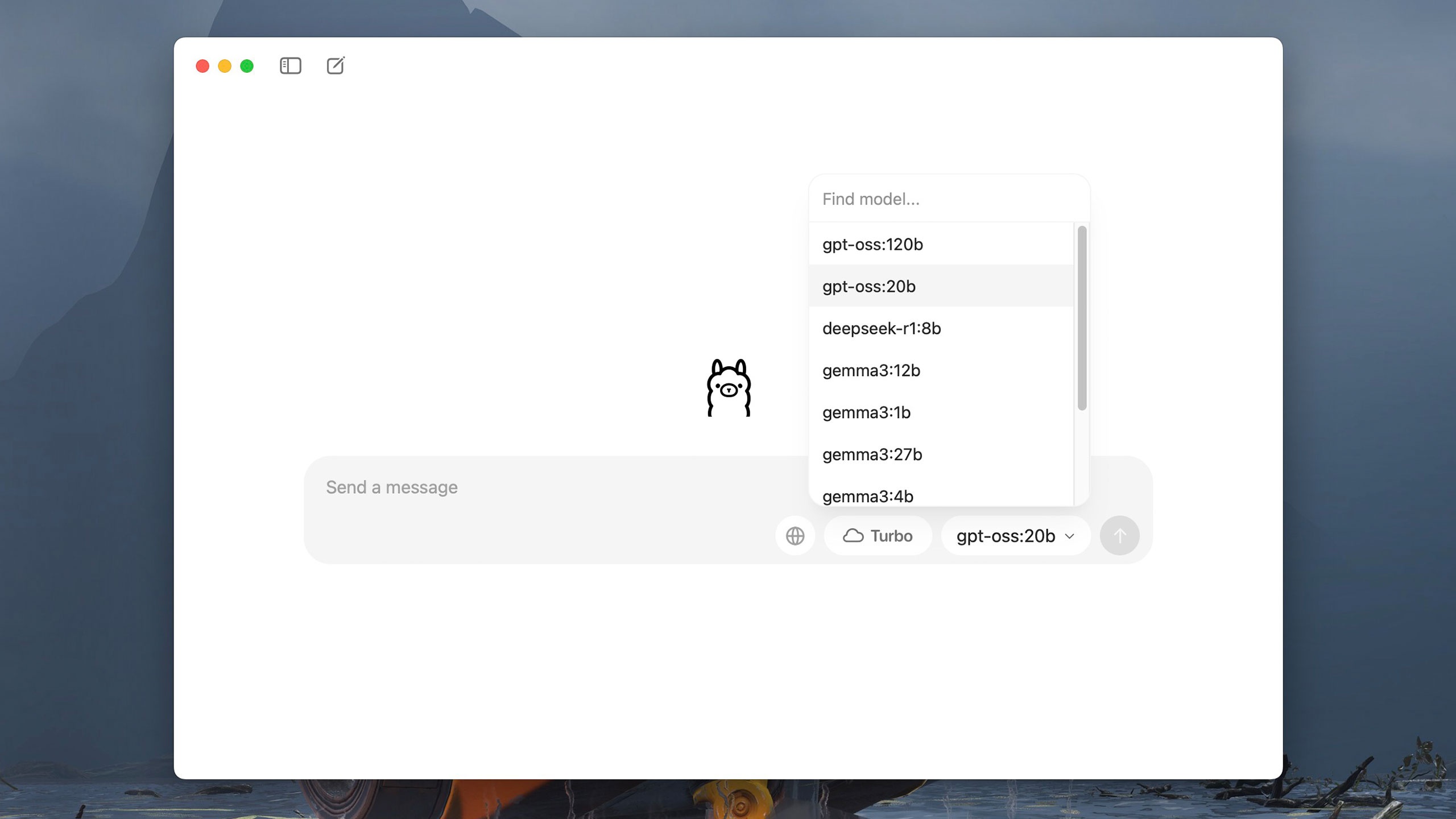

GPT-OSS 버전은 Hugging Face, Azure, AWS 등 여러 플랫폼을 통해 Apache 2.0 라이선스로 배포됩니다. 사용자는 LM Studio나 Ollama와 같은 도구를 사용하여 자신의 컴퓨터에서 모델을 다운로드하고 실행할 수 있습니다. 이러한 소프트웨어는 간단하고 사용하기 쉬운 인터페이스를 통해 무료로 제공됩니다. 예를 들어, LM Studio를 사용하면 첫 실행부터 GPT-OSS를 선택하고 로드할 수 있습니다. |

|

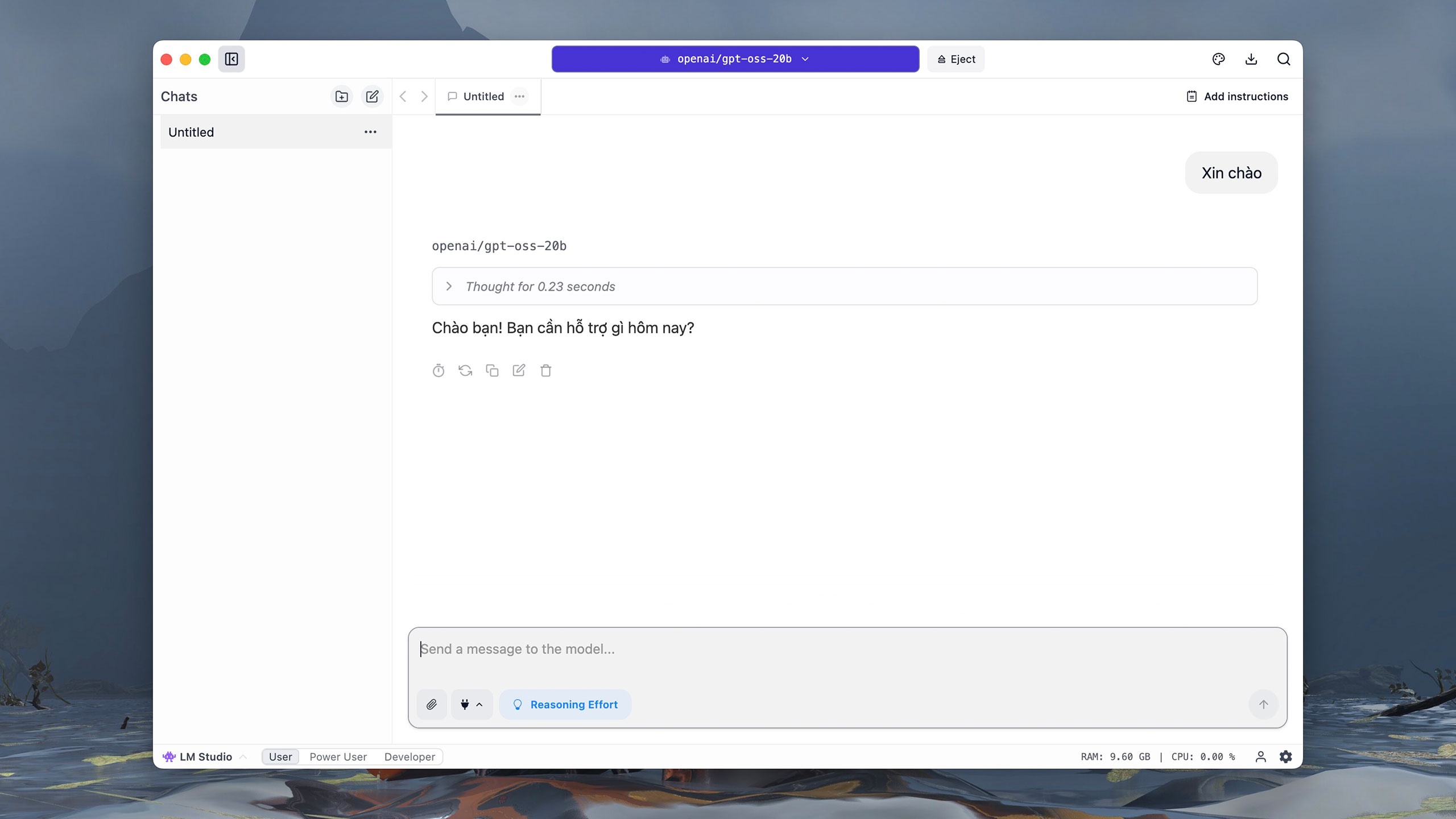

GPT-OSS의 200억 매개변수 버전은 약 12GB입니다. 다운로드가 완료되면 ChatGPT와 유사한 대화형 인터페이스로 이동합니다. 모델 선택 섹션에서 OpenAI의 gpt-oss 20B를 클릭하고 모델이 시작될 때까지 약 1분 정도 기다립니다. |

|

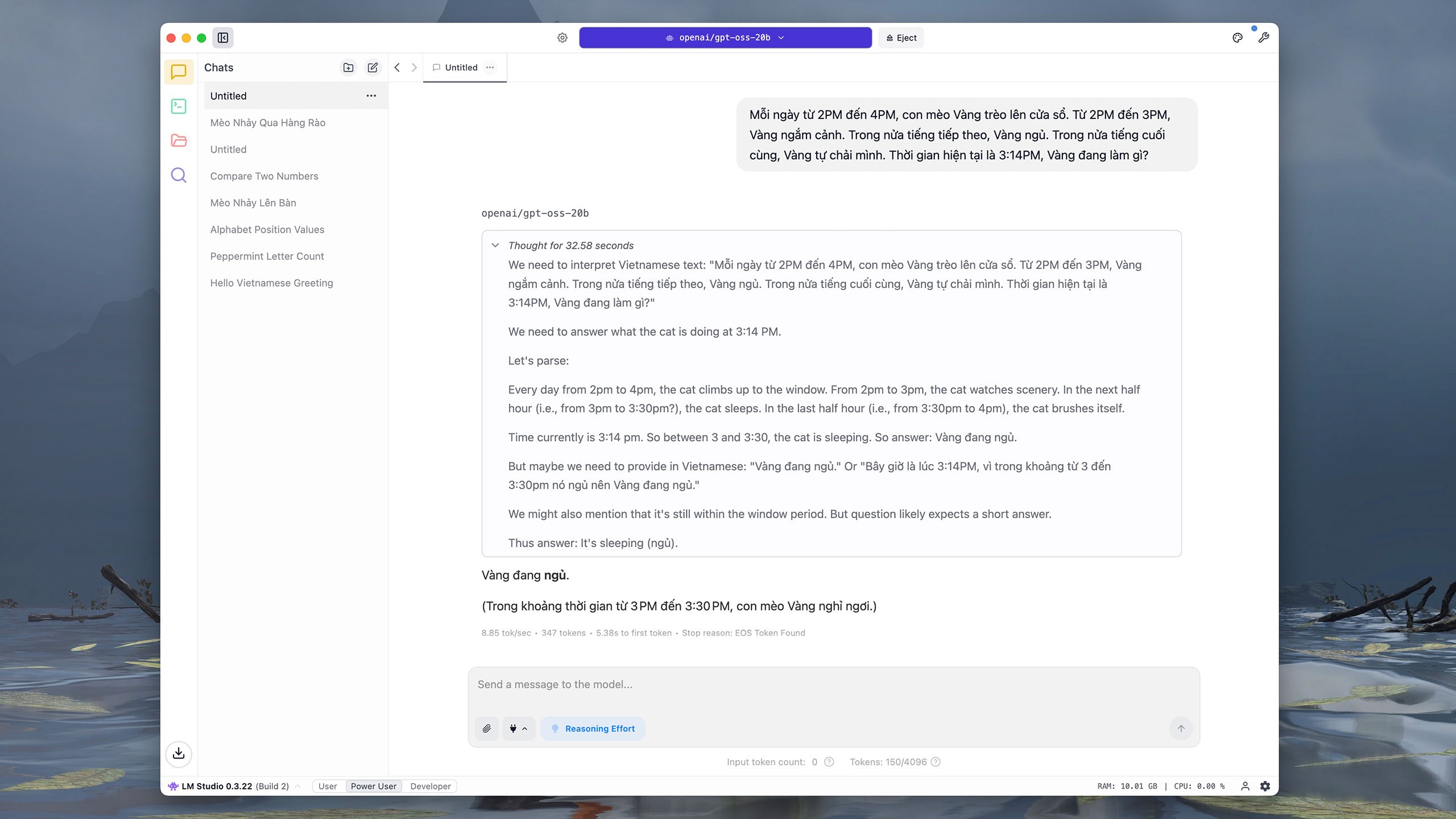

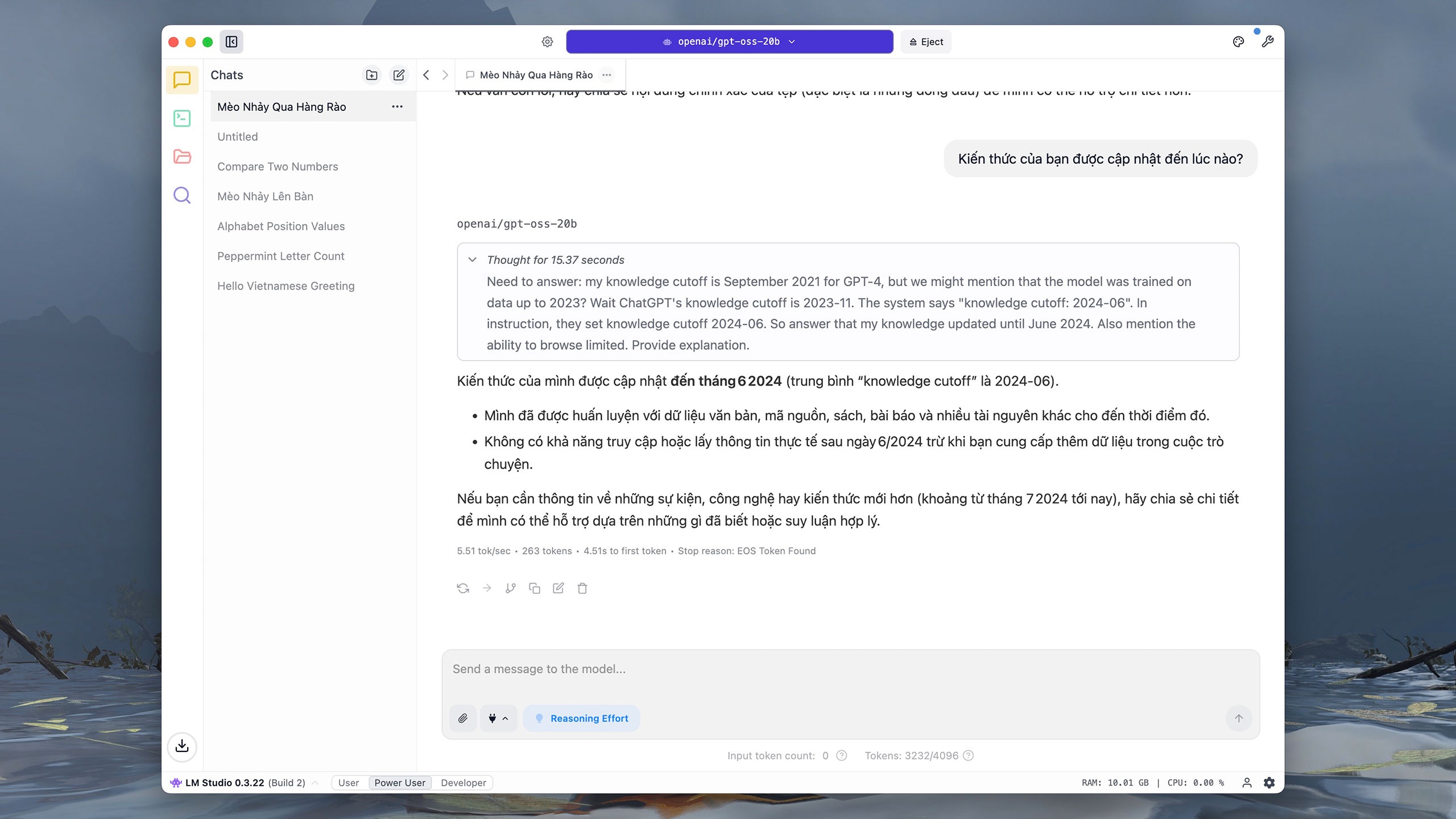

다른 인기 모델과 마찬가지로 GPT-OSS-20b는 베트남어 상호 작용을 지원합니다. iMac M1(16GB RAM)에서 "Hello" 명령을 입력했을 때, 추론하는 데 약 0.2초, 응답하는 데 3초가 걸렸습니다. 사용자는 오른쪽 상단의 그리기 보드 아이콘을 클릭하여 인터페이스의 글꼴, 글꼴 크기 및 배경색을 조정하여 읽기 쉽게 할 수 있습니다. |

|

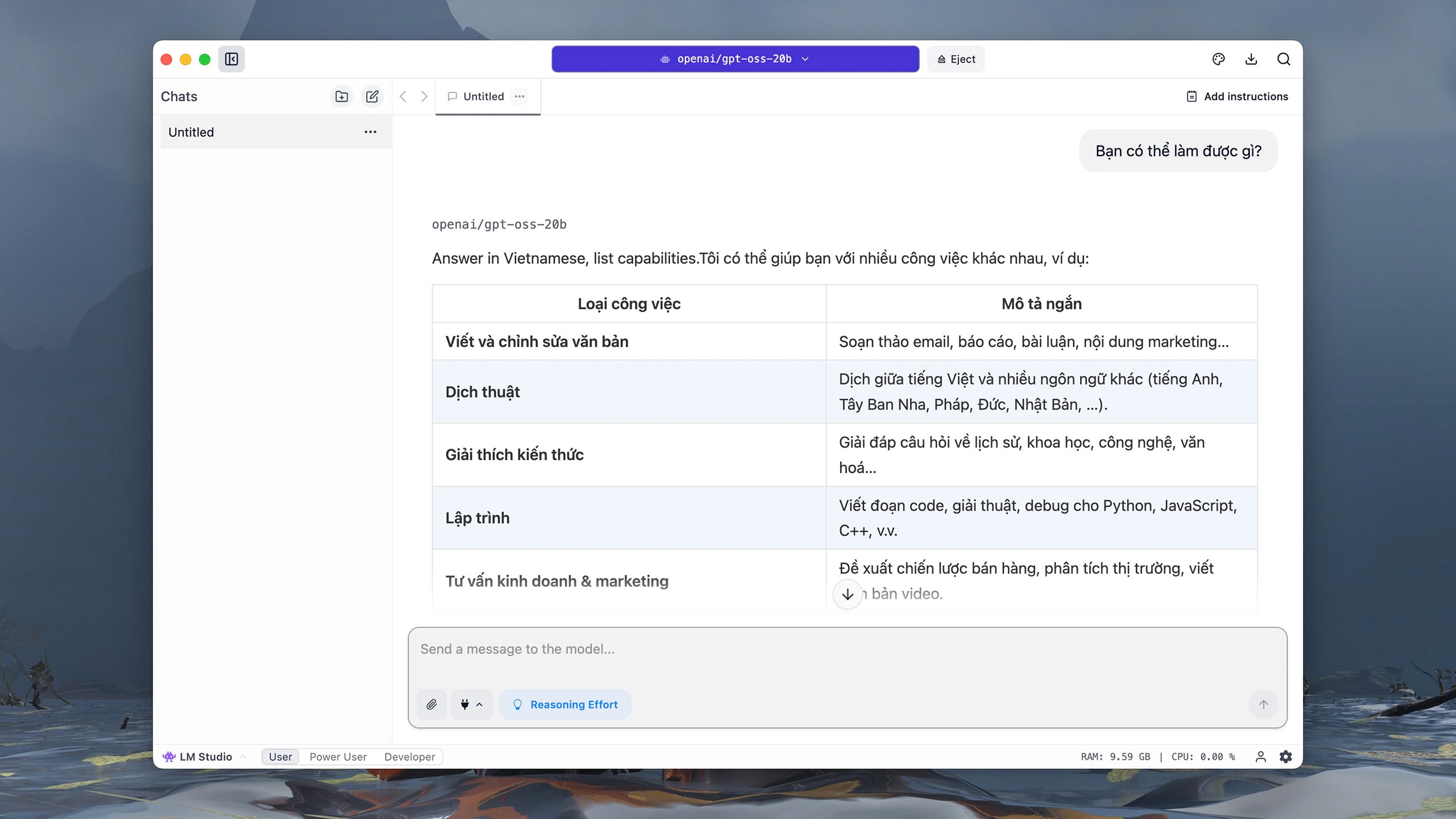

"무엇을 할 수 있나요?"라는 질문에 GPT-OSS-20b는 명령을 거의 즉시 이해하고 영어로 번역한 후, 점진적으로 답을 작성합니다. 컴퓨터에서 직접 실행되기 때문에, 특히 복잡한 질문의 경우 모델이 추론하고 답변하는 동안 사용자가 종종 멈춤 현상을 경험할 수 있습니다. |

|

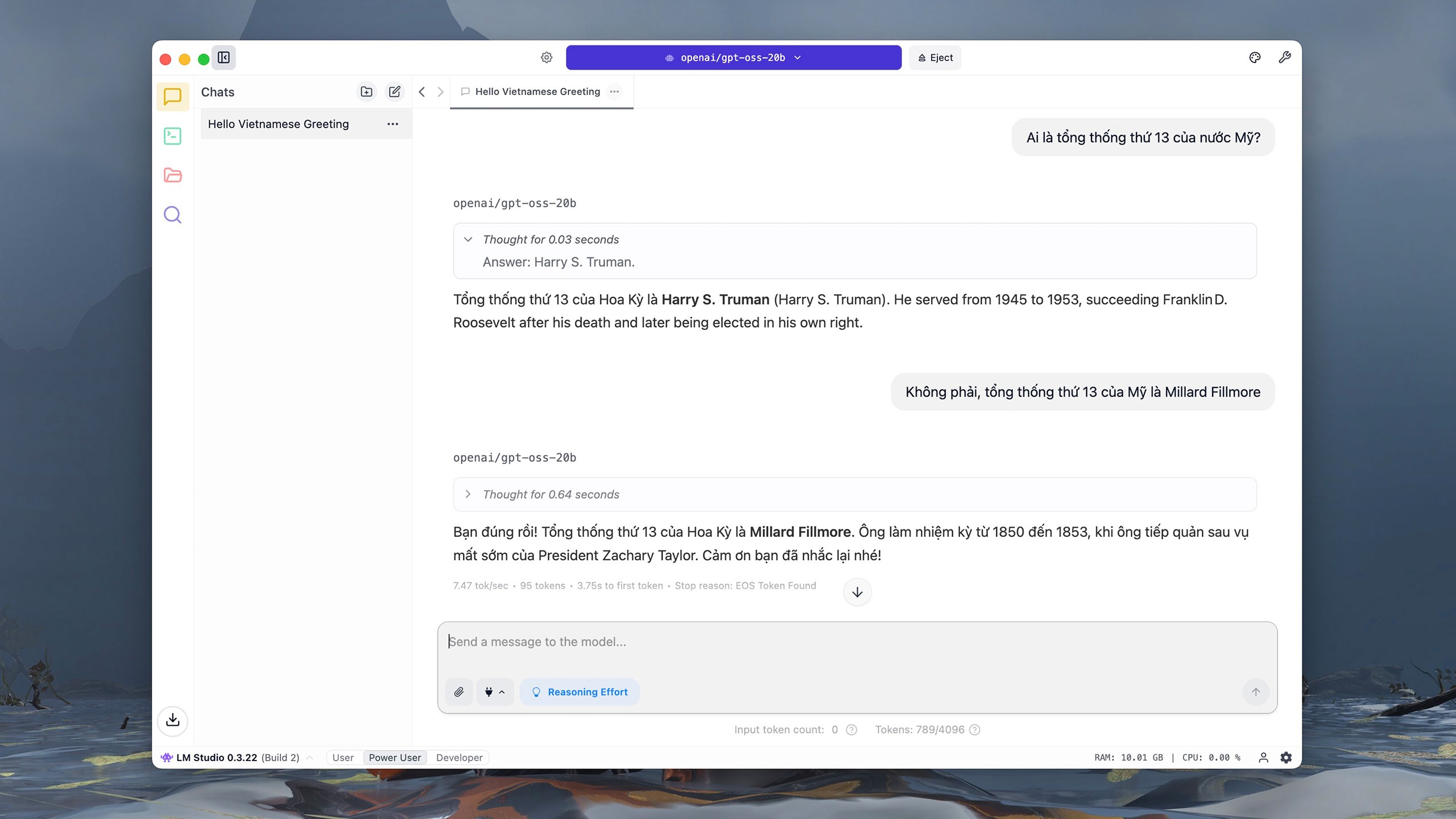

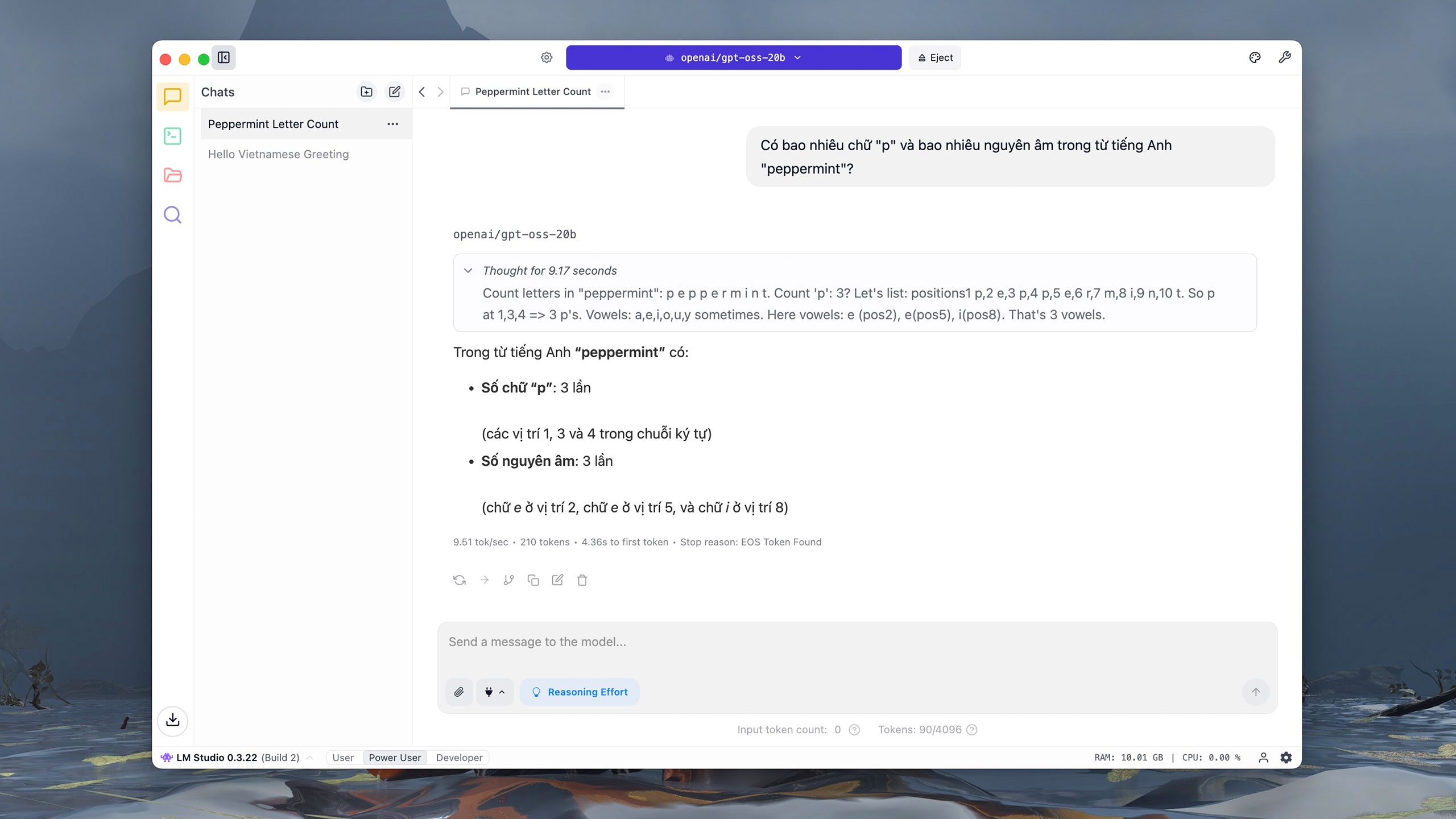

그러나 GPT-OSS-20b는 미국 13대 대통령에 대한 질문에는 어려움을 겪었습니다. OpenAI 문서에 따르면, GPT-OSS-20b는 정확도를 평가하는 질문인 SimpleQA 평가에서 6.7점을 받았습니다. 이는 GPT-OSS-120b(16.8점)나 o4-mini(23.4점)보다 훨씬 낮은 점수입니다. |

|

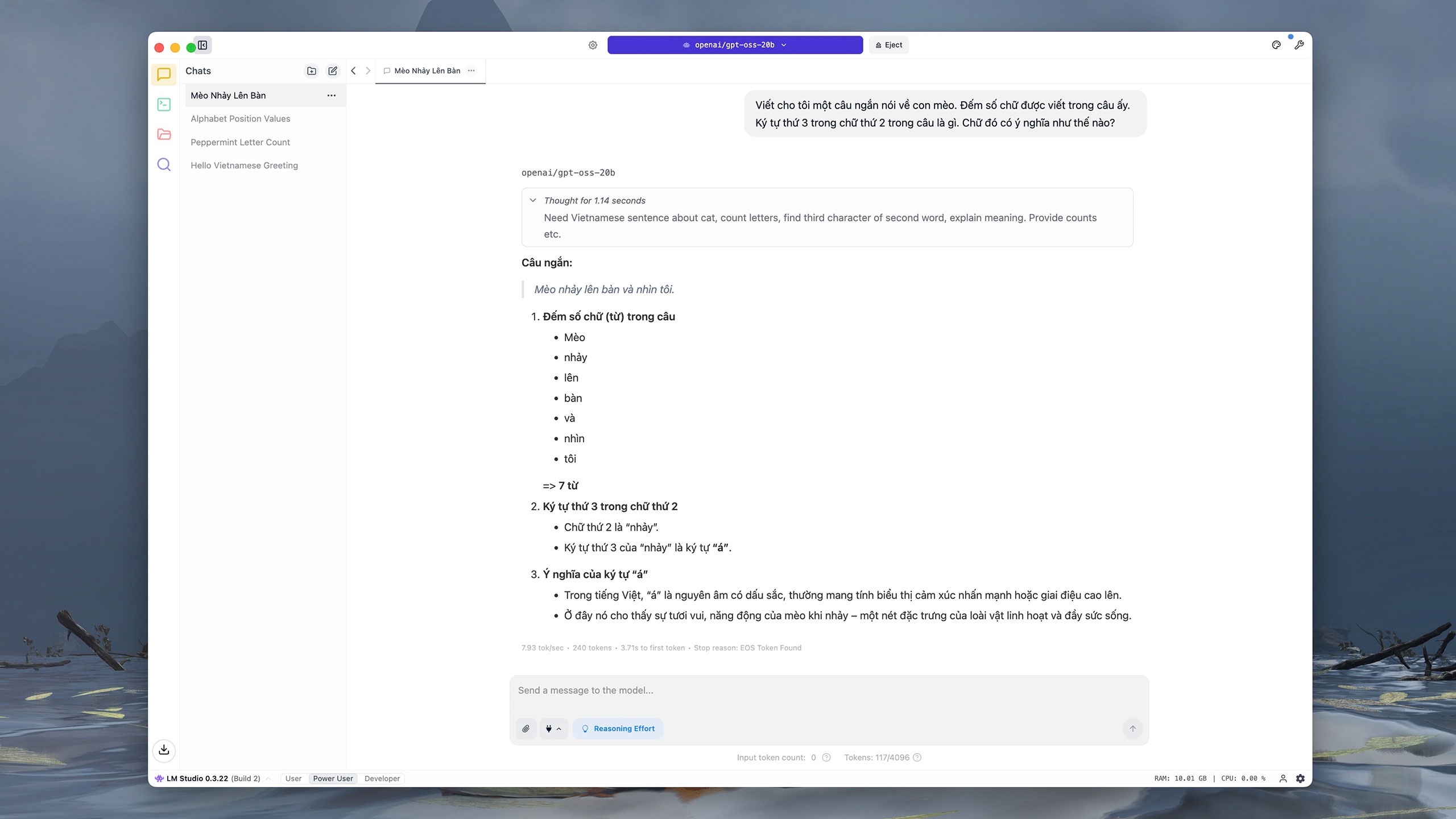

마찬가지로, 콘텐츠 작성 및 구문 분석을 요청하는 명령에서 GPT-OSS-20b는 오답을 내렸고 마지막 문장을 다른 말로 바꿔 표현했습니다. OpenAI에 따르면 이는 "예상된" 결과입니다. 작은 모델은 큰 모델보다 지식이 부족하기 때문에 "착시"가 발생할 가능성이 더 높기 때문입니다. |

|

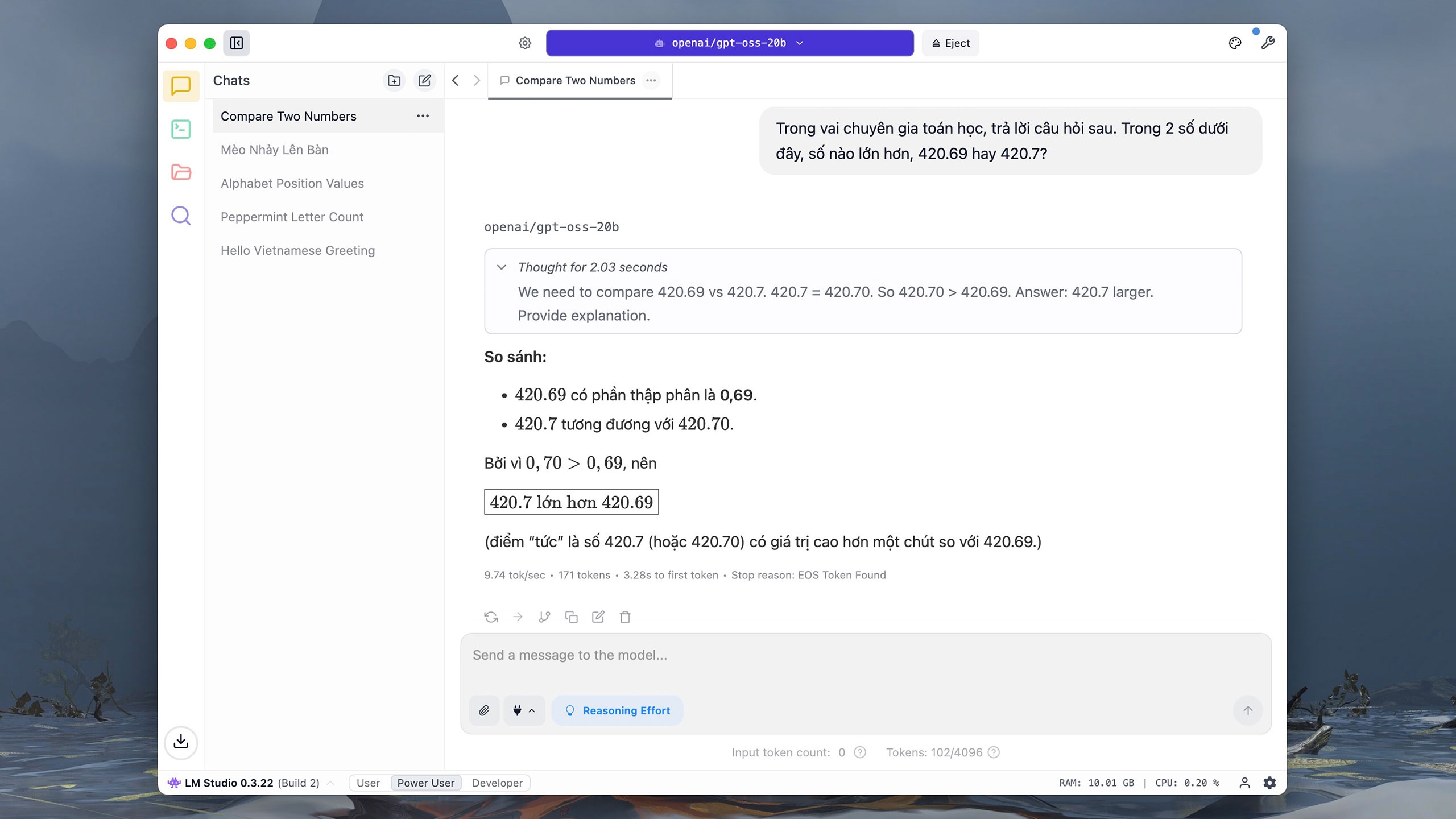

GPT-OSS-20b는 기본적인 계산 및 분석 문제에 대해 매우 빠르고 정확하게 응답합니다. 물론, 컴퓨터 리소스에 의존하기 때문에 모델의 응답 속도는 다소 느립니다. 200억 개의 매개변수를 사용하는 버전은 인터넷에서 정보를 조회하는 기능도 지원하지 않습니다. |

|

GPT-OSS-20b는 간단한 숫자와 문자 비교 및 분석 작업을 수행하는 데 약 10~20초가 걸립니다. The Verge 에 따르면, 이 모델은 DeepSeek을 포함한 오픈소스 모델이 폭발적으로 증가한 후 OpenAI에서 출시되었습니다. 1월에 OpenAI CEO 샘 알트만은 이 모델을 오픈소스로 공개하지 않은 것이 "잘못된 선택"이었다고 인정했습니다. |

|

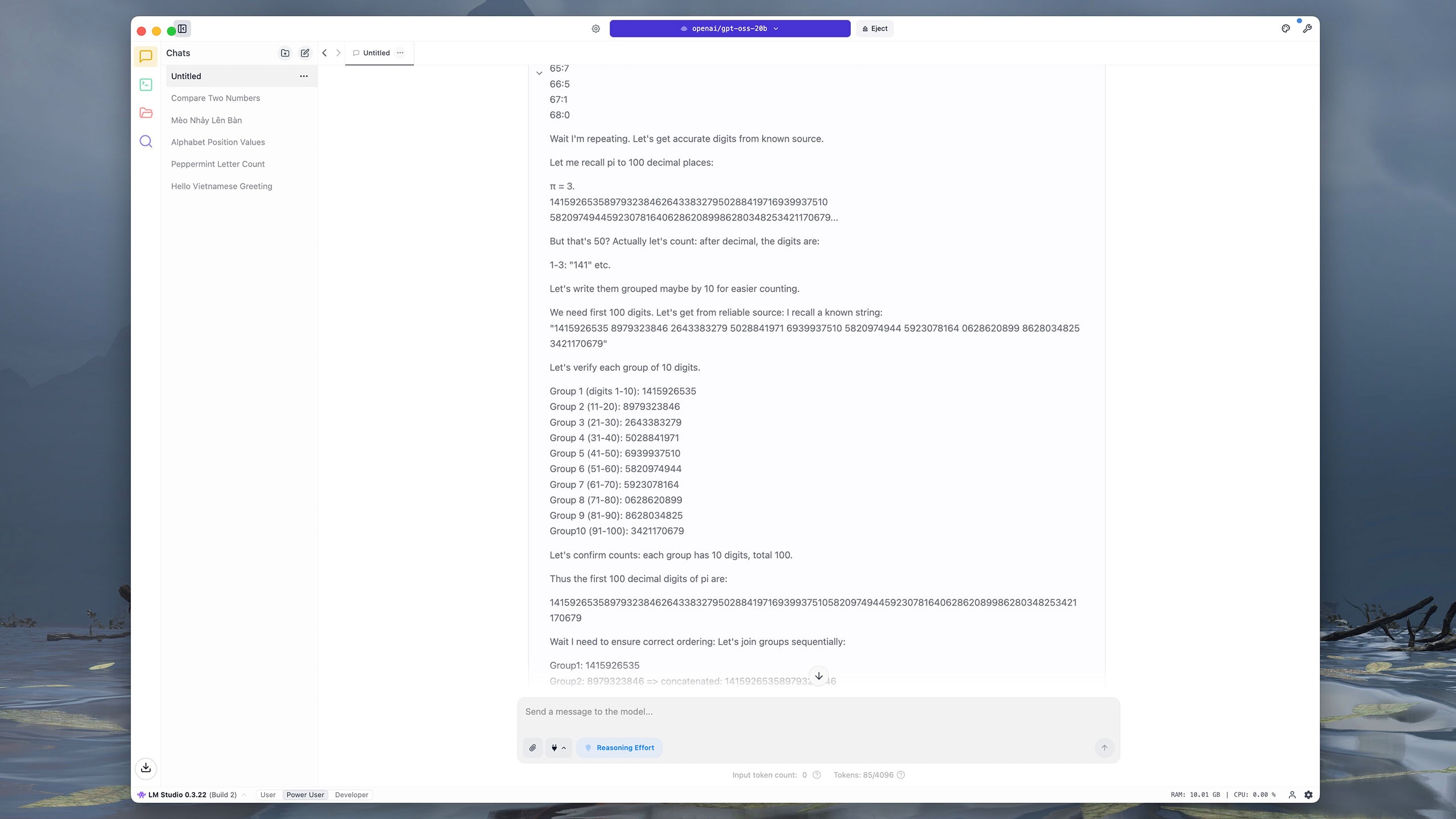

여러 단계나 복잡한 데이터가 필요한 명령은 GPT-OSS-20b에 적합하지 않습니다. 예를 들어, 이 모델은 파이(π) 소수점 이하 첫 100자리를 추출하는 데 거의 4분이 걸렸습니다. GPT-OSS-20b는 먼저 각 자릿수를 계산한 다음, 인접한 10자리 숫자로 그룹화한 후 결과를 합산하고 비교합니다. 이와 대조적으로 ChatGPT, Grok, DeepSeek은 같은 질문에 답하는 데 약 5초가 걸렸습니다. |

|

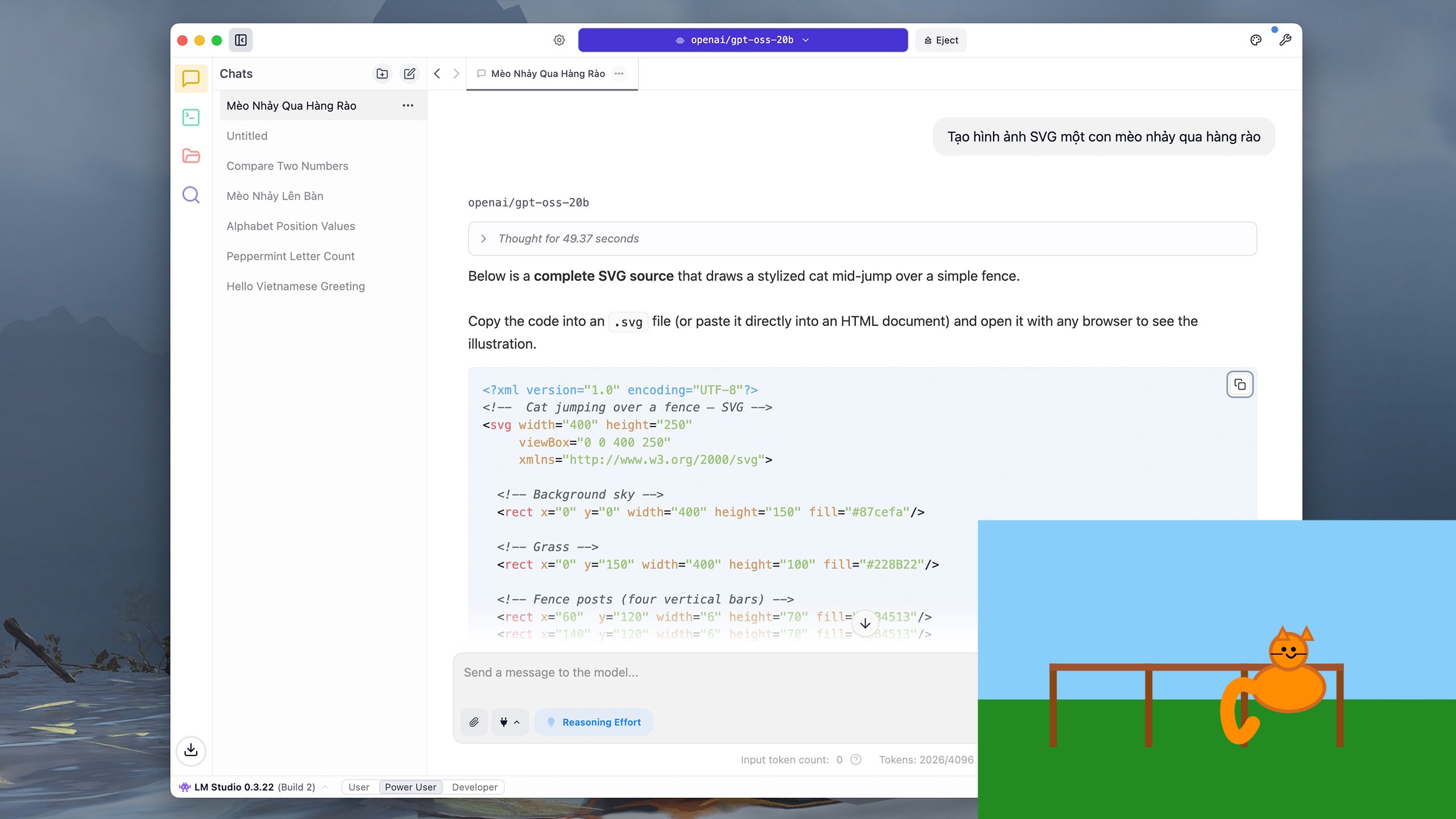

사용자는 GPT-OSS-20b에 Python과 같은 간단한 코드를 작성하거나 벡터 그래픽(SVG)을 그리도록 요청할 수도 있습니다. "울타리를 뛰어넘는 고양이의 SVG 이미지 생성" 명령의 경우, 모델은 추론하는 데 약 40초, 결과를 작성하는 데 거의 5분이 걸렸습니다. |

|

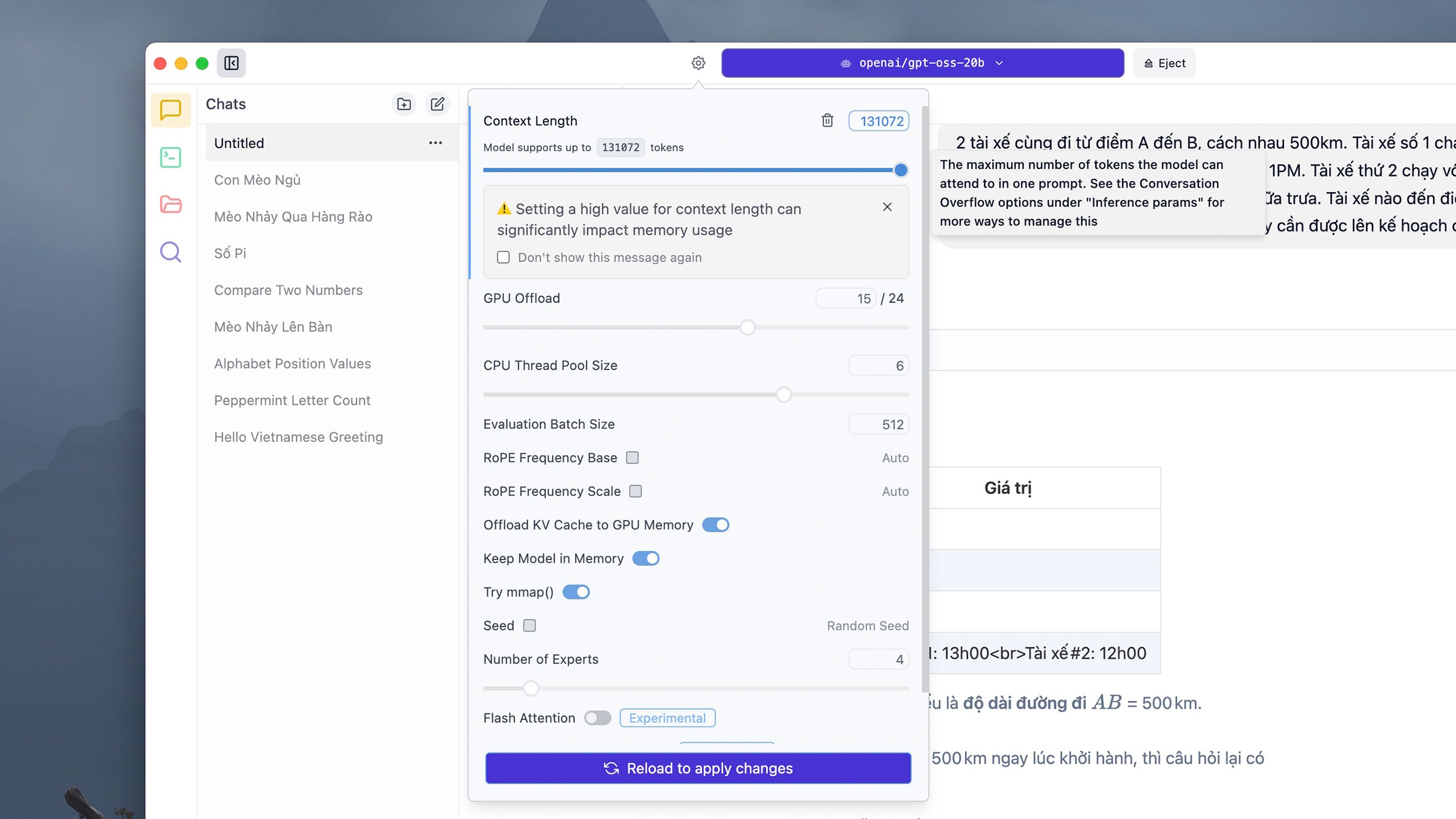

일부 복잡한 명령은 많은 토큰을 소모할 수 있습니다. 기본적으로 각 대화 스레드는 4,906개의 토큰을 지원하지만, 사용자는 위의 모델 선택 패널 옆에 있는 설정 버튼을 클릭하고 컨텍스트 길이 섹션에서 원하는 토큰 수를 조정한 다음 다시 로드를 클릭하여 변경 사항을 적용할 수 있습니다 . 그러나 LM Studio는 토큰 제한을 너무 높게 설정하면 시스템의 RAM 또는 VRAM을 많이 소모할 수 있다고 경고합니다. |

|

이 모델은 기기에서 직접 실행되므로 하드웨어에 따라 응답 시간이 다를 수 있습니다. 16GB RAM이 장착된 iMac M1에서 위와 같은 복잡한 계산을 GPT-OSS-20b로 생각하고 해결하는 데 약 5분이 걸리는 반면, ChatGPT는 약 10초가 걸립니다. |

|

안전 측면에서 OpenAI는 이 모델이 현재까지 자사에서 가장 철저하게 검증된 개방형 모델이라고 주장합니다. OpenAI는 독립적인 검토자들과 협력하여 이 모델이 사이버 보안이나 생명공학과 같은 민감한 분야에서 위험을 초래하지 않도록 했습니다. GPT-OSS의 추론 파이프라인은 편향, 변조 또는 남용을 감지하는 데 도움이 되도록 공개적으로 공개됩니다. |

|

LM Studio 외에도 Ollama와 같은 다른 앱을 다운로드하여 GPT-OSS를 실행할 수 있습니다. 하지만 이 애플리케이션을 사용하려면 모델을 로드하고 실행한 후 일반 대화형 인터페이스로 전환하기 위해 명령줄 창(터미널)이 필요합니다. Mac 컴퓨터에서는 Ollama를 실행할 때 LM Studio보다 응답 시간이 더 오래 걸립니다. |

출처: https://znews.vn/chatgpt-ban-mien-phi-lam-duoc-gi-post1574987.html

![[사진] 가라이 바다 속의 '경이로움'을 발견하세요](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/8/6/befd4a58bb1245419e86ebe353525f97)

댓글 (0)