ນັກຄົ້ນຄວ້າຢູ່ DeepSeek ໄດ້ປະກາດຮູບແບບທົດລອງໃຫມ່ທີ່ເອີ້ນວ່າ V3.2-exp, ອອກແບບມາເພື່ອຫຼຸດຜ່ອນຄ່າໃຊ້ຈ່າຍຂອງການ inference ຢ່າງຫຼວງຫຼາຍເມື່ອໃຊ້ໃນການດໍາເນີນງານໃນສະພາບການຍາວ.

DeepSeek ປະກາດຕົວແບບດັ່ງກ່າວໃນການໂພດໃນ Hugging Face, ແລະຍັງໄດ້ເຜີຍແຜ່ເອກະສານທາງວິຊາການທີ່ເຊື່ອມໂຍງໃນ GitHub.

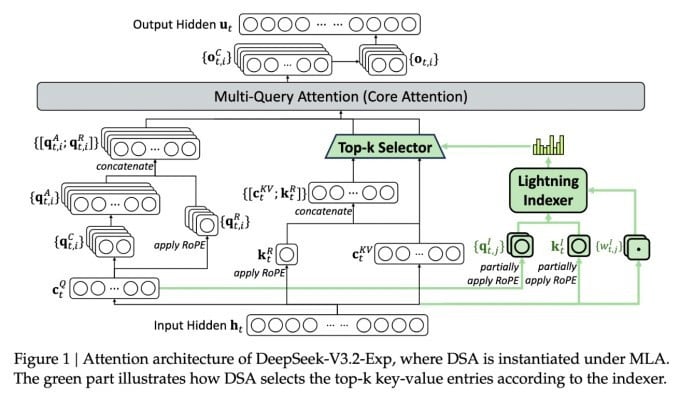

ລັກສະນະທີ່ສໍາຄັນທີ່ສຸດຂອງຮູບແບບໃຫມ່ທີ່ສັບສົນແມ່ນເອີ້ນວ່າ DeepSeek Sparse Attention. ໂດຍພື້ນຖານແລ້ວ, ລະບົບຈະໃຊ້ໂມດູນທີ່ເອີ້ນວ່າ "ຕົວດັດສະນີຟ້າຜ່າ" ເພື່ອຈັດລໍາດັບຄວາມສໍາຄັນຂອງຂໍ້ຄວາມສະເພາະຈາກປ່ອງຢ້ຽມສະພາບການ.

DeepSeek ປະກາດຮູບແບບ inference ທີ່ມີປະສິດທິພາບດ້ານຄ່າໃຊ້ຈ່າຍ.

ລະບົບແຍກຕ່າງຫາກທີ່ເອີ້ນວ່າ "ລະບົບການຄັດເລືອກ token ລະອຽດ" ຫຼັງຈາກນັ້ນເລືອກ tokens ສະເພາະຈາກ snippets ເຫຼົ່ານັ້ນເພື່ອໂຫລດເຂົ້າໄປໃນປ່ອງຢ້ຽມທີ່ຈໍາກັດຂອງໂມດູນ. ປະສົມປະສານ, ພວກເຂົາອະນຸຍາດໃຫ້ຕົວແບບ Sparse Attention ເຮັດວຽກຢູ່ໃນບໍລິບົດທີ່ຍາວນານທີ່ມີການໂຫຼດເຊີຟເວີຂ້ອນຂ້າງນ້ອຍ.

ສໍາລັບການດໍາເນີນງານໃນສະພາບການຍາວ, ຜົນປະໂຫຍດຂອງລະບົບແມ່ນມີຄວາມສໍາຄັນ. ການທົດສອບເບື້ອງຕົ້ນຂອງ DeepSeek ສະແດງໃຫ້ເຫັນວ່າຄ່າໃຊ້ຈ່າຍຂອງການເອີ້ນຟັງຊັນ inference ງ່າຍໆ (API) ສາມາດຫຼຸດລົງໄດ້ເຖິງເຄິ່ງຫນຶ່ງໃນສະຖານະການທີ່ຍາວນານ.

ການທົດສອບເພີ່ມເຕີມແມ່ນຈໍາເປັນເພື່ອສ້າງການປະເມີນທີ່ເຂັ້ມແຂງກວ່າ, ແຕ່ເນື່ອງຈາກຕົວແບບເປີດແລະສາມາດໃຊ້ໄດ້ຢ່າງເສລີໃນ Hugging Face, ມັນບໍ່ຄວນຈະດົນກ່ອນທີ່ການທົດສອບຂອງພາກສ່ວນທີສາມສາມາດປະເມີນການຮຽກຮ້ອງໃນເອກະສານ.

ບໍ່ເຫມືອນກັບຕົວແບບ AI Chatbot ອື່ນໆທີ່ບໍລິໂພກພະລັງງານຫຼາຍ, DeepSeek ໄປໃນທິດທາງຂອງການປະຫຍັດຄ່າໃຊ້ຈ່າຍຈາກການຝຶກອົບຮົມໄປສູ່ການດໍາເນີນງານ.

ຮູບແບບໃຫມ່ຂອງ DeepSeek ແມ່ນຫນຶ່ງໃນບັນດາຄວາມກ້າວຫນ້າທີ່ຜ່ານມາທີ່ແກ້ໄຂບັນຫາຂອງຄ່າໃຊ້ຈ່າຍ inference - ໂດຍພື້ນຖານແລ້ວ, ຄ່າໃຊ້ຈ່າຍຂອງເຄື່ອງແມ່ຂ່າຍຂອງການປະຕິບັດແບບຈໍາລອງ AI ທີ່ໄດ້ຮັບການຝຶກອົບຮົມກ່ອນ, ກົງກັນຂ້າມກັບຄ່າໃຊ້ຈ່າຍຂອງການຝຶກອົບຮົມມັນ.

ໃນກໍລະນີຂອງ DeepSeek, ນັກຄົ້ນຄວ້າໄດ້ຊອກຫາວິທີທີ່ຈະເຮັດໃຫ້ສະຖາປັດຕະຍະກໍາ transformer ພື້ນຖານມີປະສິດທິພາບຫຼາຍຂຶ້ນ - ແລະພົບວ່າມີການປັບປຸງທີ່ສໍາຄັນທີ່ຕ້ອງເຮັດ.

ອີງໃສ່ປະເທດຈີນ, DeepSeek ແມ່ນຕົວເລກທີ່ຜິດປົກກະຕິໃນຄວາມຢາກຮູ້ AI, ໂດຍສະເພາະແມ່ນຜູ້ທີ່ເຫັນວ່າການຄົ້ນຄວ້າ AI ເປັນການແຂ່ງຂັນລະຫວ່າງສະຫະລັດແລະຈີນ. ບໍລິສັດໄດ້ເຮັດການກະແຈກກະຈາຍໃນຕົ້ນປີນີ້ດ້ວຍຮູບແບບ R1 ຂອງຕົນ, ການຝຶກອົບຮົມຕົ້ນຕໍໂດຍການນໍາໃຊ້ການຮຽນຮູ້ເສີມດ້ວຍຄ່າໃຊ້ຈ່າຍຕ່ໍາກວ່າຄູ່ແຂ່ງຂອງສະຫະລັດ.

ຢ່າງໃດກໍຕາມ, ຮູບແບບດັ່ງກ່າວລົ້ມເຫລວທີ່ຈະເຮັດໃຫ້ເກີດການປະຕິວັດຢ່າງເຕັມທີ່ໃນການຝຶກອົບຮົມ AI ທີ່ບາງຄົນຄາດຄະເນ, ແລະບໍລິສັດໄດ້ຄ່ອຍໆຖອຍອອກຈາກຈຸດເດັ່ນໃນເດືອນຕໍ່ມາ.

ວິທີການໃຫມ່ "ຄວາມສົນໃຈເລັກນ້ອຍ" ບໍ່ຫນ້າຈະເຮັດໃຫ້ເກີດຄວາມໂກດແຄ້ນຫຼາຍເທົ່າກັບ R1 - ແຕ່ມັນຍັງສາມາດສອນຜູ້ໃຫ້ບໍລິການຂອງສະຫະລັດບາງເຄັດລັບທີ່ຕ້ອງການຫຼາຍເພື່ອຊ່ວຍຮັກສາຄ່າໃຊ້ຈ່າຍ inference ຕ່ໍາ.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

ທີ່ມາ: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[ຮູບພາບ] ນັກສຶກສາໂຮງຮຽນປະຖົມບິ່ງມິງມ່ວນຊື່ນໃນວັນບຸນເຕັມດວງ, ໄດ້ຮັບຄວາມເບີກບານມ່ວນຊື່ນໃນໄວເດັກ.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[ຮູບພາບ] ທ່ານນາຍົກລັດຖະມົນຕີ ຟ້າມມິງຈິ້ງ ເປັນປະທານກອງປະຊຸມຜັນຂະຫຍາຍການແກ້ໄຂຜົນຮ້າຍຢ້ອນຫຼັງຈາກພະຍຸເລກ 10.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

(0)