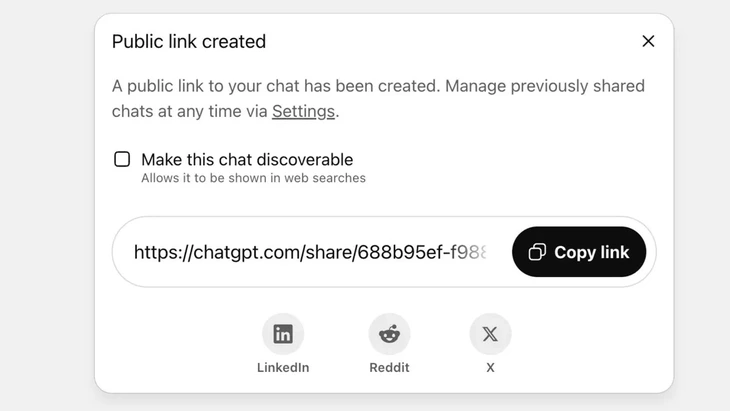

ຄຸນສົມບັດທີ່ຈະແບ່ງປັນການສົນທະນາຜ່ານລິ້ງສາທາລະນະໃນ ChatGPT - ຮູບພາບ: Techradar

ໃນປັດຈຸບັນ ChatGPT ບັນລຸຫຼາຍກວ່າ 2.5 ຕື້ຄໍາຖາມຈາກຜູ້ໃຊ້ທົ່ວໂລກທຸກໆມື້, ສະແດງໃຫ້ເຫັນຄວາມນິຍົມເພີ່ມຂຶ້ນຂອງ chatbot ນີ້.

ຢ່າງໃດກໍຕາມ, ເຄື່ອງມືນີ້ກໍາລັງປະເຊີນກັບຜົນຕອບແທນທີ່ເຂັ້ມແຂງຈາກຜູ້ໃຊ້, ຍ້ອນວ່າຄຸນນະສົມບັດ "ການແບ່ງປັນ" ໄດ້ເຮັດໃຫ້ການສົນທະນາຫລາຍພັນຄົນຮົ່ວຂໍ້ມູນທີ່ມີຄວາມອ່ອນໄຫວຕໍ່ Google ແລະບາງເຄື່ອງຈັກຊອກຫາໃນອິນເຕີເນັດ.

ຄວາມສ່ຽງດ້ານຄວາມປອດໄພສູງ

ທ່ານ ຫວູຫງອກເຊີນ, ຫົວໜ້າກົມເຕັກໂນໂລຊີຂອງສະມາຄົມຄວາມປອດໄພທາງໄຊເບີແຫ່ງຊາດ (NCA) ຕີລາຄາວ່າ, ເຫດການຂ້າງເທິງສະແດງໃຫ້ເຫັນຄວາມສ່ຽງດ້ານຄວາມປອດໄພສູງສຳລັບຜູ້ໃຊ້ ChatGPT.

"ເຫດການຂ້າງເທິງນີ້ບໍ່ຈໍາເປັນຕ້ອງມີຂໍ້ບົກພ່ອງທາງດ້ານເຕັກນິກເພາະມີການລິເລີ່ມທີ່ແນ່ນອນຂອງຜູ້ໃຊ້ໃນການກົດປຸ່ມແບ່ງປັນ. ຢ່າງໃດກໍຕາມ, ມັນສາມາດເວົ້າໄດ້ວ່າບັນຫາແມ່ນຢູ່ໃນການອອກແບບຂອງຜະລິດຕະພັນ AI chatbot, ເມື່ອມັນເຮັດໃຫ້ຜູ້ໃຊ້ສັບສົນແລະບໍ່ມີມາດຕະການເຕືອນທີ່ເຂັ້ມແຂງພຽງພໍກ່ຽວກັບຄວາມສ່ຽງຂອງຂໍ້ມູນສ່ວນບຸກຄົນທີ່ຈະຮົ່ວໄຫຼຖ້າຜູ້ໃຊ້ແບ່ງປັນ," ທ່ານ Vu Ngoc Son ວິເຄາະ.

ໃນ ChatGPT, ຄຸນນະສົມບັດນີ້ຖືກປະຕິບັດຫຼັງຈາກຜູ້ໃຊ້ເລືອກທີ່ຈະແບ່ງປັນການສົນທະນາຜ່ານການເຊື່ອມຕໍ່ສາທາລະນະ, ເນື້ອຫາຈະຖືກເກັບໄວ້ໃນເຄື່ອງແມ່ຂ່າຍຂອງ OpenAI ເປັນເວັບໄຊທ໌ສາທາລະນະ (chatgpt.com/share/...), ບໍ່ມີການເຂົ້າສູ່ລະບົບຫຼືລະຫັດຜ່ານເພື່ອເຂົ້າເຖິງ.

ຕົວກວາດເວັບຂອງ Google ຈະສະແກນ ແລະດັດສະນີໜ້າເຫຼົ່ານີ້ໂດຍອັດຕະໂນມັດ, ເຮັດໃຫ້ພວກມັນປາກົດໃນຜົນການຊອກຫາ, ລວມທັງຂໍ້ຄວາມທີ່ລະອຽດອ່ອນ, ຮູບພາບ ຫຼືຂໍ້ມູນການສົນທະນາ.

ຜູ້ໃຊ້ຫຼາຍຄົນບໍ່ຮູ້ເຖິງຄວາມສ່ຽງ, ຄິດວ່າພວກເຂົາແບ່ງປັນການສົນທະນາກັບຫມູ່ເພື່ອນຫຼືຜູ້ຕິດຕໍ່. ອັນນີ້ເຮັດໃຫ້ການສົນທະນານັບພັນໄດ້ຖືກເປີດເຜີຍ, ໃນບາງກໍລະນີມີຂໍ້ມູນສ່ວນຕົວທີ່ລະອຽດອ່ອນ.

ເຖິງແມ່ນວ່າ OpenAI ໄດ້ເອົາຄຸນສົມບັດນີ້ອອກຢ່າງໄວວາໃນທ້າຍເດືອນກໍລະກົດ 2025 ຫຼັງຈາກຊຸມຊົນ backlash, ມັນຍັງໃຊ້ເວລາໃນການປະສານງານກັບ Google ເພື່ອເອົາດັດສະນີເກົ່າອອກ. ໂດຍສະເພາະກັບລະບົບການເກັບຮັກສາທີ່ຊັບຊ້ອນ, ເຊິ່ງປະກອບມີເຄື່ອງແມ່ຂ່າຍຂອງ cache ຂອງ Google, ນີ້ບໍ່ສາມາດເຮັດໄດ້ຢ່າງໄວວາ.

ຢ່າປະຕິບັດ AI chatbots ເປັນ "ກ່ອງສີດໍາຄວາມປອດໄພ"

ຊ່ຽວຊານດ້ານຄວາມປອດໄພຂໍ້ມູນ ຫວູຫງອກເຊີນ, ຫົວໜ້າຂະແໜງເຕັກໂນໂລຊີ ສະມາຄົມຄວາມປອດໄພທາງໄຊເບີແຫ່ງຊາດ (NCA) - ພາບ: CHI HIEU

ການຮົ່ວໄຫລຂອງບັນທຶກການສົນທະນາຫລາຍພັນຄົນສາມາດສ້າງຄວາມສ່ຽງຕໍ່ຜູ້ໃຊ້ເຊັ່ນການເປີດເຜີຍຄວາມລັບສ່ວນຕົວແລະທຸລະກິດ; ຄວາມເສຍຫາຍຕໍ່ຊື່ສຽງ, ຄວາມສ່ຽງທາງດ້ານການເງິນຫຼືແມ້ກະທັ້ງອັນຕະລາຍດ້ານຄວາມປອດໄພເນື່ອງຈາກການເປີດເຜີຍທີ່ຢູ່ອາໃສ.

"Chatbots ທີ່ເປີດໃຊ້ AI ແມ່ນມີປະໂຫຍດແຕ່ບໍ່ແມ່ນ 'ກ່ອງດຳ', ເພາະວ່າຂໍ້ມູນທີ່ແບ່ງປັນສາມາດມີຢູ່ໃນເວັບຕະຫຼອດໄປຖ້າປະໄວ້ໂດຍບໍ່ໄດ້ເລືອກ.

ເຫດການຂ້າງເທິງນີ້ແມ່ນແນ່ນອນບົດຮຽນສໍາລັບທັງຜູ້ໃຫ້ບໍລິການແລະຜູ້ໃຊ້. ຜູ້ໃຫ້ບໍລິການ AI ອື່ນໆສາມາດຮຽນຮູ້ຈາກປະສົບການນີ້ແລະລັກສະນະການອອກແບບທີ່ມີຄໍາເຕືອນທີ່ຊັດເຈນແລະໂປ່ງໃສກວ່າ.

ພ້ອມກັນນັ້ນ, ຜູ້ຊົມໃຊ້ຍັງຈຳເປັນຕ້ອງມີການຈຳກັດຢ່າງຕັ້ງໜ້າໃນການປະຕິບັດການປະກາດທີ່ບໍ່ມີການຄວບຄຸມຂອງການລະບຸຕົວຕົນຫຼືຂໍ້ມູນສ່ວນຕົວຢູ່ໃນເວທີ AI,”, ນັກຊ່ຽວຊານດ້ານຄວາມປອດໄພ Vu Ngoc Son ແນະນຳ.

ອີງຕາມຜູ້ຊ່ຽວຊານດ້ານຄວາມປອດໄພຂອງຂໍ້ມູນ, ເຫດການຂ້າງເທິງສະແດງໃຫ້ເຫັນເຖິງຄວາມຕ້ອງການຂອງແລວທາງທາງດ້ານກົດຫມາຍແລະມາດຕະຖານຄວາມປອດໄພທາງອິນເຕີເນັດສໍາລັບ AI. ຜູ້ສະຫນອງແລະຜູ້ພັດທະນາ AI ຍັງຈໍາເປັນຕ້ອງອອກແບບລະບົບທີ່ຮັບປະກັນຄວາມປອດໄພ, ຫຼີກເວັ້ນຄວາມສ່ຽງຕໍ່ການຮົ່ວໄຫລຂອງຂໍ້ມູນເຊັ່ນ: ການຮົ່ວໄຫຼຜ່ານຊ່ອງໂຫວ່ທີ່ບໍ່ດີ; ຄວາມອ່ອນແອຂອງຊອບແວທີ່ນໍາໄປສູ່ການໂຈມຕີຖານຂໍ້ມູນ; ການຄວບຄຸມທີ່ບໍ່ດີນໍາໄປສູ່ການເປັນພິດ, ການລ່ວງລະເມີດເພື່ອຕອບຄໍາຖາມທີ່ບໍ່ຖືກຕ້ອງແລະບິດເບືອນ.

ຜູ້ໃຊ້ຍັງຕ້ອງຄວບຄຸມການແບ່ງປັນຂໍ້ມູນສ່ວນຕົວກັບ AI, ບໍ່ແມ່ນການແບ່ງປັນຂໍ້ມູນທີ່ລະອຽດອ່ອນ. ໃນກໍລະນີທີ່ຕ້ອງການຕົວຈິງ, ຄວນໃຊ້ໂຫມດທີ່ບໍ່ເປີດເຜີຍຊື່ຫຼືເຂົ້າລະຫັດຂໍ້ມູນຢ່າງຈິງຈັງເພື່ອຫຼີກເວັ້ນການເຊື່ອມຕໍ່ຂໍ້ມູນໂດຍກົງກັບບຸກຄົນສະເພາະ.

ທີ່ມາ: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![ການຫັນປ່ຽນ OCOP ດົງນາຍ: [ມາດຕາ 3] ເຊື່ອມໂຍງການທ່ອງທ່ຽວກັບການບໍລິໂພກຜະລິດຕະພັນ OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

(0)