Penyelidik di DeepSeek telah mengumumkan model eksperimen baharu yang dipanggil V3.2-exp, yang direka untuk mengurangkan kos inferens dengan ketara apabila digunakan dalam operasi konteks yang panjang.

DeepSeek mengumumkan model itu dalam siaran di Hugging Face, dan juga menyiarkan kertas akademik yang dipautkan di GitHub.

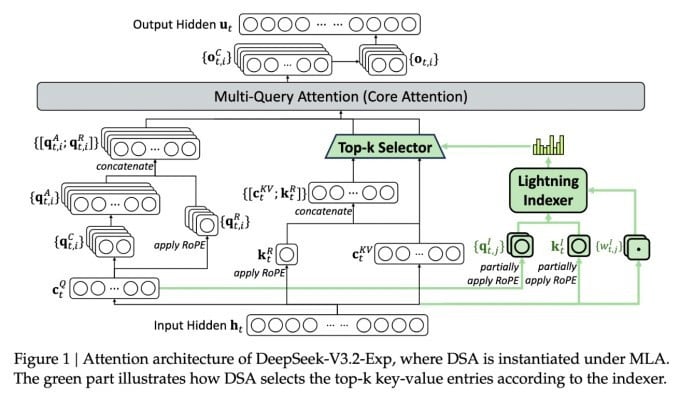

Ciri terpenting model baharu yang kompleks itu dipanggil DeepSeek Sparse Attention. Pada asasnya, sistem menggunakan modul yang dipanggil "pengindeks kilat" untuk mengutamakan petikan khusus daripada tetingkap konteks.

DeepSeek mengumumkan model inferens kos efektif.

Sistem berasingan yang dipanggil "sistem pemilihan token halus" kemudian memilih token tertentu daripada coretan tersebut untuk dimuatkan ke dalam tetingkap perhatian terhad modul. Digabungkan, mereka membenarkan model Sparse Attention beroperasi pada bahagian konteks yang panjang dengan beban pelayan yang agak kecil.

Untuk operasi konteks panjang, faedah sistem adalah penting. Ujian awal DeepSeek menunjukkan bahawa kos panggilan fungsi inferens mudah (API) boleh dikurangkan sehingga separuh dalam senario konteks panjang.

Ujian lanjut diperlukan untuk membina penilaian yang lebih mantap, tetapi memandangkan model itu terbuka dan tersedia secara bebas pada Wajah Memeluk, ia tidak sepatutnya lama sebelum ujian pihak ketiga boleh menilai tuntutan dalam kertas.

Tidak seperti model AI Chatbot lain yang menggunakan banyak tenaga, DeepSeek menuju ke arah penjimatan kos daripada latihan hingga operasi.

Model baharu DeepSeek ialah salah satu daripada siri penemuan baru-baru ini yang menangani masalah kos inferens—pada asasnya, kos pelayan untuk menjalankan model AI terlatih, berbanding kos melatihnya.

Dalam kes DeepSeek, para penyelidik sedang mencari cara untuk menjadikan seni bina pengubah asas lebih cekap—dan mendapati bahawa penambahbaikan yang ketara perlu dibuat.

Berpangkalan di China, DeepSeek adalah tokoh luar biasa dalam kegilaan AI, terutamanya bagi mereka yang melihat penyelidikan AI sebagai persaingan antara AS dan China. Syarikat itu membuat percikan awal tahun ini dengan model R1nya, dilatih terutamanya menggunakan pembelajaran pengukuhan pada kos yang jauh lebih rendah daripada pesaing AS.

Walau bagaimanapun, model itu gagal mencetuskan revolusi berskala penuh dalam latihan AI yang diramalkan oleh sesetengah pihak, dan syarikat itu perlahan-lahan berundur dari perhatian pada bulan-bulan berikutnya.

Pendekatan baru "perhatian jarang" tidak mungkin menyebabkan kemarahan sebanyak R1 - tetapi ia masih boleh mengajar pembekal perkhidmatan AS beberapa helah yang sangat diperlukan untuk membantu mengekalkan kos inferens yang rendah.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Sumber: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Foto] Pelajar Sekolah Rendah Binh Minh menikmati perayaan bulan purnama, menerima kegembiraan zaman kanak-kanak](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Foto] Perdana Menteri Pham Minh Chinh mempengerusikan mesyuarat untuk mengerahkan mengatasi akibat ribut No. 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

![[INFOGRAFIK] Mengimbas kembali masa-masa Kerajaan AS ditutup](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/3/c467276604584d2889c0d2d84fecd986)

Komen (0)