Hoe werken nep-AI-beelden?

AI is tegenwoordig overal – zelfs in oorlogen. Toepassingen van kunstmatige intelligentie zijn dit jaar zo sterk verbeterd dat bijna iedereen AI-generatoren kan gebruiken om beelden te creëren die er realistisch uitzien, althans op het eerste gezicht.

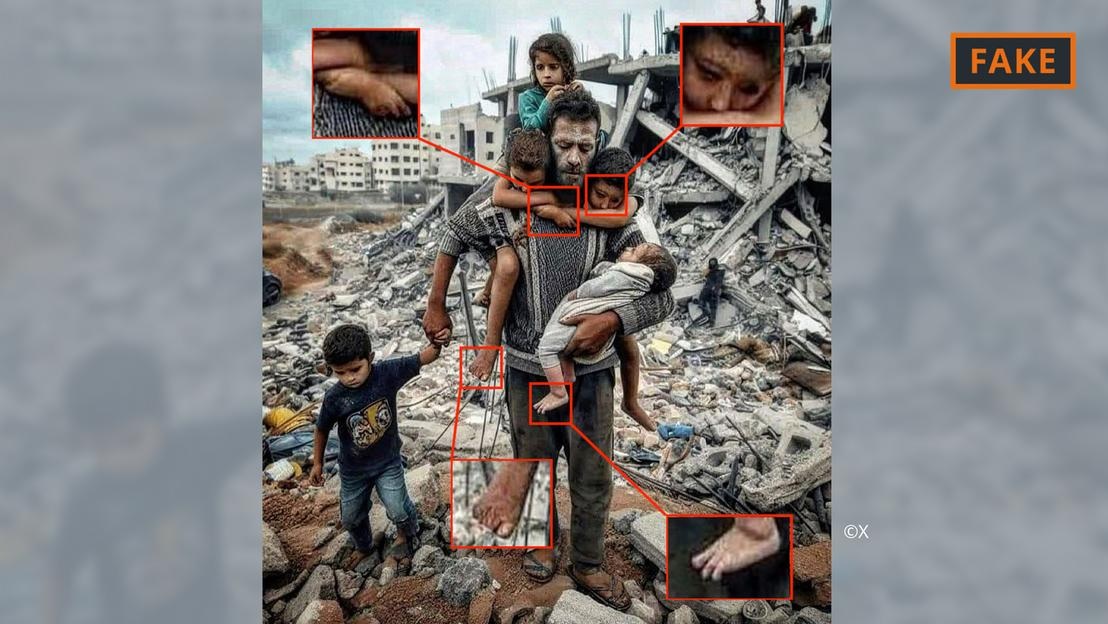

Een door AI gegenereerde, nepfoto van de oorlog in Gaza.

Gebruikers geven tools zoals Midjourney of Dall-E eenvoudigweg een paar prompts, inclusief specificaties en informatie, om dit te doen. De AI-tools zetten de tekstuele, of zelfs gesproken, prompts vervolgens om in afbeeldingen.

Dit proces van beeldgeneratie is gebaseerd op wat bekend staat als machine learning. Als een maker bijvoorbeeld een 70-jarige man op een fiets wil laten zien, doorzoekt hij zijn database om termen aan afbeeldingen te koppelen.

Op basis van de beschikbare informatie genereert het AI-algoritme een beeld van de oudere fietser. Door steeds meer input en technische updates zijn deze tools sterk verbeterd en leren ze voortdurend bij.

Dit alles wordt toegepast op afbeeldingen die verband houden met het conflict in het Midden-Oosten. In een conflict waar "de emoties zo hoog oplopen" heeft desinformatie, waaronder verspreiding via AI-beelden, een enorme impact, zegt AI-expert Hany Farid.

Farid, hoogleraar digitale analyse aan de Universiteit van Californië in Berkeley, zegt dat felle conflicten de ideale voedingsbodem vormen voor het creëren en verspreiden van nepcontent, en voor het aanwakkeren van emoties.

Soorten AI-beelden van de oorlog tussen Israël en Hamas

Met behulp van kunstmatige intelligentie gemaakte afbeeldingen en video's hebben geleid tot desinformatie over de oorlog in Oekraïne. Dat gebeurt nog steeds in de oorlog tussen Israël en Hamas.

Volgens experts vallen AI-beelden die op sociale media over oorlog circuleren vaak in twee categorieën. De ene richt zich op het lijden van mensen en wekt medeleven op. De andere is nep-AI die gebeurtenissen overdrijft en zo conflicten en escalerend geweld uitlokt.

Door AI gegenereerde nepfoto van vader en kind in het puin in Gaza.

De eerste categorie omvat bijvoorbeeld de foto hierboven van een vader en zijn vijf kinderen voor een puinhoop. Deze werd meerdere keren gedeeld op X (voorheen Twitter) en Instagram en honderdduizenden keren bekeken.

Deze afbeelding is door de community, in ieder geval op X, als nep gemarkeerd. Je herkent hem aan diverse fouten en inconsistenties die veel voorkomen bij AI-afbeeldingen (zie afbeelding hierboven).

Soortgelijke anomalieën zijn ook te zien in de nep-AI-afbeelding die viraal ging op X hieronder. De afbeelding toont een Palestijns gezin dat samen eet op de ruïnes.

Door AI gegenereerde nepfoto van Palestijnse partij.

Een andere afbeelding toont troepen die Israëlische vlaggen zwaaien terwijl ze door een nederzetting met gebombardeerde huizen rijden. Deze afbeelding valt in de tweede categorie en is bedoeld om haat en geweld aan te wakkeren.

Waar komen zulke AI-beelden vandaan?

De meeste door AI gegenereerde beelden van conflicten worden op socialemediaplatformen geplaatst, maar ze zijn ook beschikbaar op een aantal andere platforms en organisaties, en zelfs op sommige nieuwssites.

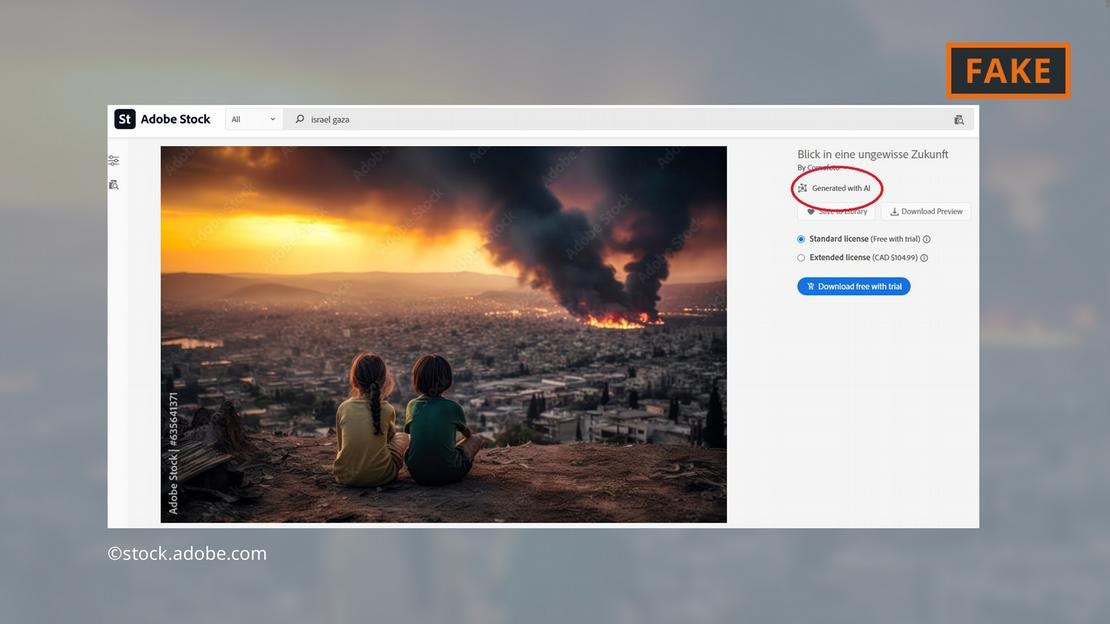

Softwarebedrijf Adobe heeft de krantenkoppen gehaald door voor het einde van 2022 AI-gegenereerde afbeeldingen toe te voegen aan zijn stockfoto-aanbod. Deze worden in de database als zodanig gelabeld.

Adobe biedt nu ook AI-afbeeldingen van de oorlog in het Midden-Oosten te koop aan, zoals explosies, protesterende mensen of rookpluimen achter de Al-Aqsa-moskee.

Adobe biedt door AI gegenereerde afbeeldingen van de gevechten in Gaza.

Critici vinden dit verontrustend, aangezien sommige sites de afbeeldingen blijven gebruiken zonder ze als AI-gegenereerd te labelen. De betreffende afbeelding verscheen bijvoorbeeld op de pagina 'Nieuws' zonder enige indicatie dat deze door AI was gegenereerd.

Zelfs de Onderzoeksdienst van het Europees Parlement, de wetenschappelijke tak van het Europees Parlement, illustreerde een online tekst over het conflict in het Midden-Oosten met een AI-afbeelding uit de Adobe-database – zonder deze te bestempelen als door AI gegenereerd.

Het European Digital Media Observatory dringt er bij journalisten en mediaprofessionals op aan uiterst voorzichtig te zijn met het gebruik van AI-beelden en raadt het gebruik ervan af, vooral bij verslaggeving over echte gebeurtenissen, zoals de oorlog in Gaza.

Hoe gevaarlijk zijn AI-beelden?

De virale AI-content en -beelden zullen gebruikers ongetwijfeld een ongemakkelijk gevoel bezorgen bij alles wat ze online tegenkomen. "Als we in een wereld terechtkomen waar afbeeldingen, audio en video gemanipuleerd kunnen worden , wordt alles verdacht", legt Farid, onderzoeker aan UC Berkeley, uit. "Dus verlies je het vertrouwen in alles, inclusief de waarheid."

Dat is precies wat er gebeurde in het volgende geval: een afbeelding van wat vermoedelijk het verkoolde lichaampje is van een Israëlische baby, werd op sociale media gedeeld door de Israëlische premier Benjamin Netanyahu en verschillende andere politici.

Een anti-Israël-influencer, Jackson Hinkle, beweerde later dat de afbeelding met behulp van kunstmatige intelligentie was gemaakt. Hinkle's verklaring werd meer dan 20 miljoen keer bekeken op sociale media en leidde tot een verhit debat op het platform.

Uiteindelijk verklaarden talloze organisaties en verificatietools dat de afbeelding echt was en Hinkle's bewering onjuist. Het is echter duidelijk dat geen enkele tool gebruikers gemakkelijk hun verloren vertrouwen kan terugwinnen!

Hoang Hai (volgens DW)

Bron

Reactie (0)