Hvis du noen gang har surfet på sosiale medier, er det stor sjanse for at du har kommet over bilder eller videoer laget av AI. Mange har blitt lurt, som den virale videoen av kaniner som hopper på trampoline. Men Sora – en søsterapp til ChatGPT utviklet av OpenAI – tar AI-video til et nytt nivå, noe som gjør det stadig mer presserende å oppdage falskt innhold.

AI-videoverktøy gjør det vanskeligere enn noensinne å identifisere ekte videoer. (Kilde: CNET)

Denne appen ble lansert i 2024 og nylig oppgradert med Sora 2, og har et grensesnitt som ligner på TikTok, der alle videoer er AI-generert. «Cameo»-funksjonen lar ekte mennesker settes inn i simulerte opptak, noe som skaper videoer som er skremmende realistiske.

Derfor frykter mange eksperter at Sora vil føre til spredning av deepfakes, som forvrenger informasjon og visker ut linjene mellom virkelighet og falskhet. Kjendiser er spesielt sårbare, noe som har ført til at organisasjoner som SAG-AFTRA har bedt OpenAI om å styrke beskyttelsen.

Å identifisere AI-generert innhold er en stor utfordring for både teknologiselskaper, sosiale medieplattformer og brukere. Men det finnes måter å gjenkjenne videoer laget med Sora.

Finn Sora-vannmerket

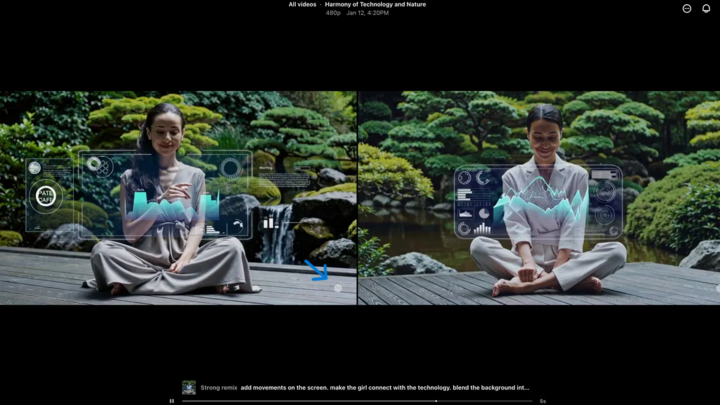

Sora-vannmerket (angitt med den blå pilen) er en markør som identifiserer verktøyet som ble brukt til å lage videoen. (Kilde: CNET)

Alle videoer som lages i Sora iOS-appen har et vannmerke når de lastes ned – den hvite Sora-logoen (skyikonet) beveger seg rundt kantene på videoen, på samme måte som vannmerket på TikTok.

Dette er en visuell måte å identifisere AI-generert innhold på. For eksempel legger Googles Gemini-modell «nano-banan» også automatisk til et vannmerke på bilder. Vannmerker er imidlertid ikke alltid pålitelige. Hvis vannmerket er statisk, kan det enkelt beskjæres. Selv dynamiske vannmerker som Soras kan fjernes ved hjelp av spesialiserte applikasjoner.

Da OpenAI-sjef Sam Altman ble spurt om dette, argumenterte han for at samfunnet må tilpasse seg realiteten at hvem som helst kan lage falske videoer. Før Sora fantes det aldri et verktøy som var så populært, tilgjengelig og som ikke krevde noen ferdigheter for å lage slike videoer. Hans perspektiv fremhever behovet for å stole på alternative verifiseringsmetoder.

Sjekk metadata

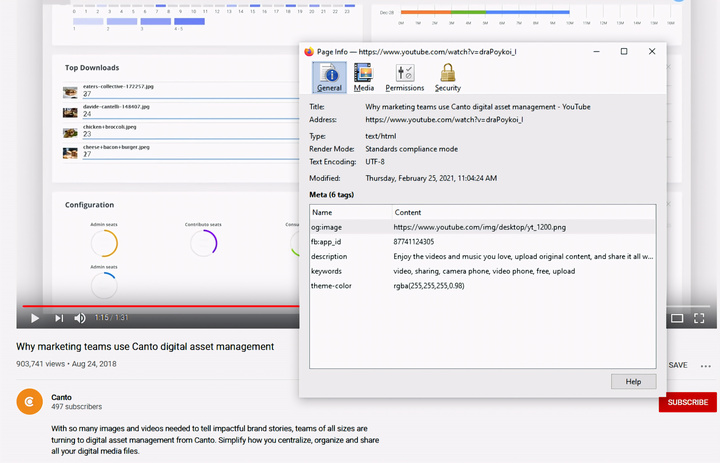

Sjekk av metadata – et avgjørende trinn for å avgjøre om en video ble laget av AI, som Sora. (Kilde: Canto)

Du tenker kanskje at det er for komplisert å sjekke metadata, men det er faktisk ganske enkelt og veldig effektivt.

Metadata er et sett med informasjon som automatisk legges til innhold når det opprettes, for eksempel kameratype, plassering, opptakstidspunkt og filnavn. Enten innholdet er menneskeskapt eller AI-generert, har det metadata. Med AI-generert innhold inkluderer metadata ofte kildehenvisningsinformasjon.

OpenAI er medlem av Coalition for Content Origin and Authenticity (C2PA), så Sora-videoer vil inneholde C2PA-metadata. Du kan bekrefte dette ved hjelp av verifiseringsverktøyet til Content Authenticity Initiative:

Slik sjekker du metadata:

- Besøk verify.contentauthenticity.org

- Last opp filen som skal kontrolleres.

- Trykk på «Åpne»

- Se informasjonen i tabellen til høyre.

Hvis videoen ble laget av AI, vil sammendraget tydelig angi dette. Når du sjekker Sora-videoer, vil du se linjen «publisert av OpenAI» og informasjon som bekrefter at videoen ble laget med AI. Alle Sora-videoer må ha denne informasjonen for å bekrefte opprinnelsen.

Kilde: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Bilde] Lekkede bilder før gallaen for Community Action Awards 2025.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765882828720_ndo_br_thiet-ke-chua-co-ten-45-png.webp&w=3840&q=75)

![[Foto] Statsminister Pham Minh Chinh mottar guvernøren i Tochigi-provinsen (Japan)](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765892133176_dsc-8082-6425-jpg.webp&w=3840&q=75)

![[Foto] Statsminister Pham Minh Chinh mottar Laos utdannings- og idrettsminister Thongsalith Mangnormek](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765876834721_dsc-7519-jpg.webp&w=3840&q=75)

![[Live] Galla for lokalsamfunnsaksjoner 2025](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F16%2F1765899631650_ndo_tr_z7334013144784-9f9fe10a6d63584c85aff40f2957c250-jpg.webp&w=3840&q=75)

![[Direkte] Avslutningsseremoni og prisutdeling for video-/klippkonkurransen «Imponerende Vietnam-turisme» 2025](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/12/17/1765974650260_z7273498850699-00d2fd6b0972cb39494cfa2559bf85ac-1765959338756946072104-627-0-1338-1138-crop-1765959347256801551121.jpeg)

Kommentar (0)