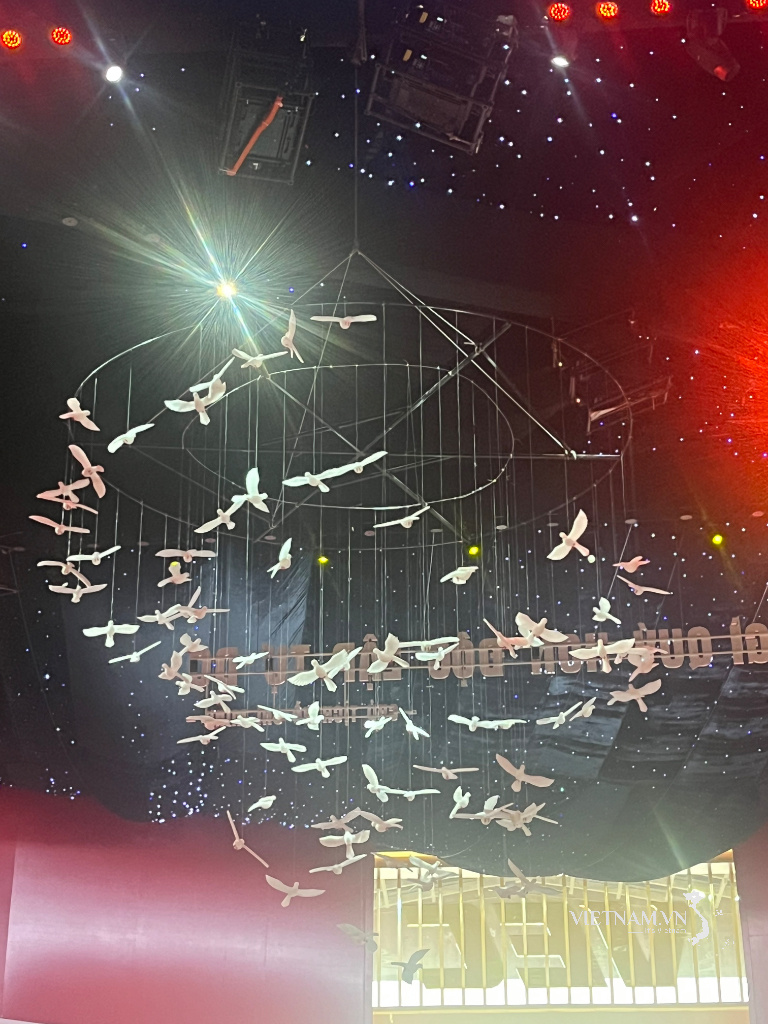

Prezentowane na Wystawie Noblowskiej, będącej częścią programu Dialogu Noblowskiego 2025 zorganizowanego przez Ambasadę Szwecji we współpracy z Uniwersytetem RMIT Wietnamu w Ho Chi Minh City, 15 września – Zdjęcie: THANH HIEP

Podczas Dialogu Noblowskiego 2025, zorganizowanego przez Ambasadę Szwecji we współpracy z Uniwersytetem RMIT w Wietnamie w Ho Chi Minh, 15 września międzynarodowi eksperci technologiczni przedstawili różne perspektywy dotyczące równoważenia innowacji w dziedzinie sztucznej inteligencji (AI) i odpowiedzialności wobec ludzkości.

Przemawiając na tym programie, profesor Virginia Dignum, specjalistka ds. sztucznej inteligencji z Uniwersytetu w Umeå w Szwecji, podkreśliła: „Tak jak Alfred Nobel martwił się wpływem nauki , my – osoby pracujące w dziedzinie sztucznej inteligencji – musimy zadać sobie pytanie: Jaki jest wpływ naszej pracy? Czy sztuczną inteligencję można wykorzystać w dobrym celu, dla dobra ludzkości?”

Potężna sztuczna inteligencja ma też silne uprzedzenia.

Pani Dignum opisuje tę technologię jako miecz obosieczny: sztuczna inteligencja rozwiązuje tyle samo problemów, ile sama stwarza. Choć oferuje bezprecedensowe możliwości, niesie ze sobą ryzyko podważenia samych fundamentów cywilizacji, która ją stworzyła.

Sama natura uzależnienia sztucznej inteligencji od danych ludzkich oznacza, że nigdy nie może być ona w pełni „neutralna”, jak wielu uważa. Za pozornie obiektywnymi systemami sztucznej inteligencji stoją miliony pracowników, którzy po cichu zbierają, przetwarzają i wprowadzają dane. Sztuczna inteligencja nie tworzy nowych danych; jedynie powtarza, a czasem wyolbrzymia, istniejące dane stworzone przez ludzi.

„Coraz potężniejsze algorytmy nie tylko zwiększają dokładność i szybkość działania sztucznej inteligencji, ale także wzmacniają istniejące uprzedzenia, wyrządzając ludziom jeszcze większą krzywdę” – ostrzegała profesor Dignum. Dlatego największym wyzwaniem dla współczesnego społeczeństwa nie jest kontrolowanie sztucznej inteligencji, ale odpowiedzialne nią zarządzanie. Podkreśliła, że odpowiedzialność nie leży po stronie sztucznej inteligencji, ale po stronie społeczeństwa, rządu i samej ludzkości.

„Nie możemy wybierać między innowacją a odpowiedzialnością etyczną. Zarządzanie na wszystkich szczeblach jest kamieniem milowym w rozwoju nauki i dobrobycie” – powiedziała.

Nikt nie zostaje w tyle.

Zgadzając się z argumentacją profesora Dignuma, dr Abdul Rohman, starszy wykładowca na Uniwersytecie RMIT w Wietnamie, zauważył, że obecny wyścig SI wciąż podchodzi do spraw z perspektywy skoncentrowanej na technologii, zapominając o tym, że SI powinna koncentrować się wokół ludzi.

To sprawia, że wielu twórców sztucznej inteligencji nie docenia znaczenia dogłębnego zrozumienia specyficznych doświadczeń życiowych użytkowników.

Pan Rohman podał przykład społeczności głuchych w Ho Chi Minh City, której słownictwo jest bardzo ograniczone ze względu na ograniczenia języka migowego.

Jednak projektowanie poleceń dla sztucznej inteligencji to umiejętność, która w dużej mierze opiera się na słownictwie lub głosie. To nieumyślnie wyklucza społeczność głuchych w szczególności, a w ogóle grupy wrażliwe, z postępu technologicznego.

„Jeśli chodzi o inkluzywne zarządzanie sztuczną inteligencją lub innowacje, które przynoszą korzyści wszystkim, pomija się dane osób spoza większości. Doświadczenia ze świata rzeczywistego nie są uwzględniane w innowacjach w dziedzinie sztucznej inteligencji” – powiedział Rohman.

Biorąc pod uwagę realia rozwoju sztucznej inteligencji, pan Rohman stwierdził, że Wietnam nadal musi „zlokalizować” modele sztucznej inteligencji, aby lepiej odpowiadały specyficznemu kontekstowi krajowemu.

Wietnam ma nie tylko obszary miejskie, takie jak Hanoi, Ho Chi Minh czy Da Nang, ale także regiony górskie, gdzie infrastruktura cyfrowa jest słabo rozwinięta. To tworzy lukę w dostępie do technologii cyfrowych .

„Jeśli nie zajmiemy się tymi konsekwencjami, grupy już znajdujące się w niekorzystnej sytuacji będą jeszcze bardziej spychane w cień przez sztuczną inteligencję. Problem jest jeszcze poważniejszy, jeśli ludzie wiedzą, jak korzystać ze sztucznej inteligencji, ale nie wiedzą, jak chronić się przed zagrożeniami. Możemy zbadać możliwość stworzenia zestawu narzędzi, który umożliwi równy dostęp do sztucznej inteligencji, jednocześnie chroniąc użytkowników. To obszar, w którym sektor prywatny, rząd i środowisko akademickie mogą ze sobą współpracować” – zasugerował.

Nowe podejście do edukacji w erze sztucznej inteligencji.

W obliczu fali ogromnych inwestycji w sprzęt i infrastrukturę AI, wielu ekspertów twierdzi, że kluczem do przywództwa nie jest technologia, ale ludzie. Aby zdominować AI, należy zacząć od edukacji.

SCMP zacytował dr. Jacka Ilmonena, eksperta w dziedzinie sztucznej inteligencji i analizy danych z Keiser University (USA), który podkreślił: „Kraj, który najlepiej wyposaży swoich obywateli w narzędzia do efektywnej współpracy ze sztuczną inteligencją, osiągnie pozycję lidera pod względem produktywności, innowacyjności i konkurencyjności”.

Wówczas siła kolektywu, wzmocniona przez sztuczną inteligencję, stanie się potężną przewagą strategiczną. W ogólnym rozrachunku dane i sprzęt to jedynie „amunicja”, a edukacja to „broń”.

Dr Rita Mokbel, prezes i dyrektor generalny Ericsson Vietnam, potwierdziła, że nowa sytuacja sprawia, że współpraca między rządem, środowiskiem akademickim i przemysłem jest jeszcze ważniejsza. Należy ją wdrożyć, zaczynając od integracji sztucznej inteligencji z programem nauczania.

„Z naszego doświadczenia, nie tylko w dziedzinie sztucznej inteligencji, ale także w transformacji cyfrowej, wynika, że gdy rząd przejmuje inicjatywę i łączy siły ze środowiskiem akademickim, sektorem prywatnym i publicznym, mogą dziać się cuda”.

Źródło: https://tuoitre.vn/ai-chon-doi-moi-hay-trach-nhiem-20250918075637729.htm

![[Zdjęcie] Żołnierze wracają do domu, aby świętować Tet (Księżycowy Nowy Rok) z mieszkańcami odległej gminy Yang Mao.](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2026/02/13/1770972833933_img-0360-8494-9922-jpg.webp)

Komentarz (0)