|

Chatbot OpenAI jest stale udoskonalany dzięki nowym technologiom. Zdjęcie: New York Times . |

We wrześniu 2024 r. OpenAI wprowadziło ChatGPT, wersję sztucznej inteligencji integrującą model o1, zdolną do rozumowania w zadaniach związanych z matematyką, naukami ścisłymi i programowaniem komputerowym.

W przeciwieństwie do poprzedniej wersji ChatGPT, nowa technologia będzie potrzebowała czasu na „przemyślenie” rozwiązań złożonych problemów przed udzieleniem odpowiedzi.

Po OpenAI wielu konkurentów, takich jak Google, Anthropic i DeepSeek, również wprowadziło podobne modele wnioskowania. Choć nie jest to technologia idealna, wciąż jest to udoskonalona wersja chatbota, której ufa wielu programistów.

Jak sztuczna inteligencja rozumuje

Zasadniczo rozumowanie oznacza, że chatboty mogą poświęcić więcej czasu na rozwiązywanie problemów zadawanych przez użytkowników.

„Rozumowanie to sposób, w jaki system wykonuje dodatkową pracę po otrzymaniu pytania” – powiedział Dan Klein, profesor informatyki na Uniwersytecie Kalifornijskim, w wywiadzie dla „New York Times” .

System logiczny może rozbić problem na mniejsze, pojedyncze kroki lub rozwiązać go metodą prób i błędów.

Po pierwszym uruchomieniu ChatGPT mógł natychmiast odpowiadać na pytania, wyodrębniając i syntetyzując informacje. W przeciwieństwie do tego, systemy rozumujące potrzebowały kilku sekund (a nawet minut) więcej, aby rozwiązać problem i udzielić odpowiedzi.

|

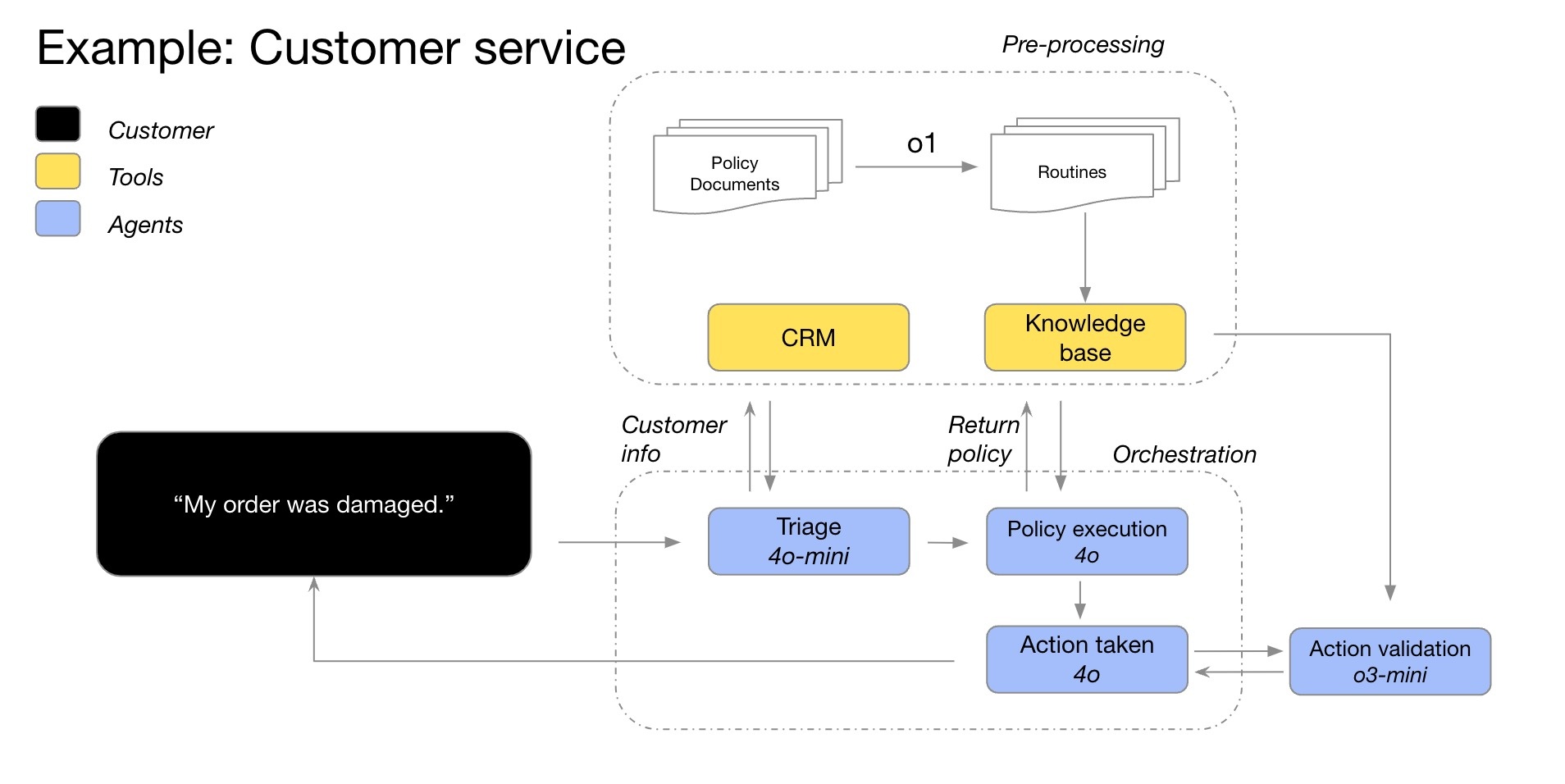

Przykład procesu wnioskowania modelu O1 w chatbocie obsługi klienta. Grafika: OpenAI . |

W niektórych przypadkach system wnioskowania zmienia podejście do problemu, stale ulepszając rozwiązanie. Dodatkowo model może testować wiele rozwiązań przed dokonaniem optymalnego wyboru lub sprawdzać poprawność poprzednich odpowiedzi.

Ogólnie rzecz biorąc, system rozumowania bierze pod uwagę wszystkie możliwe odpowiedzi na pytanie. Jest to podobne do sytuacji, gdy uczniowie szkoły podstawowej zapisują wiele opcji na papierze, zanim wybiorą najbardziej odpowiednie rozwiązanie zadania matematycznego.

Według „New York Timesa” sztuczna inteligencja jest obecnie zdolna do rozumowania na niemal każdy temat. Najskuteczniej sprawdzi się jednak w przypadku pytań związanych z matematyką, naukami ścisłymi i programowaniem.

W jaki sposób szkolony jest system teoretyczny?

W typowym chatbocie użytkownicy nadal mogą prosić o wyjaśnienia procesu lub weryfikować poprawność odpowiedzi. W rzeczywistości wiele zestawów danych szkoleniowych ChatGPT zawiera już procedury rozwiązywania problemów.

System rozumowania staje się jeszcze bardziej zaawansowany, gdy może wykonywać operacje bez udziału użytkownika. Ten proces jest bardziej złożony i rozległy. Firmy używają słowa „rozumowanie”, ponieważ system działa podobnie do ludzkiego myślenia.

Wiele firm, takich jak OpenAI, oczekuje, że systemy rozumowania będą najlepszym rozwiązaniem do ulepszania chatbotów dostępnych obecnie na rynku. Przez lata uważano, że chatboty działają lepiej, im więcej informacji są trenowane w internecie.

Do 2024 roku systemy sztucznej inteligencji zużyją niemal cały tekst dostępny w internecie. Oznacza to, że firmy muszą znaleźć nowe rozwiązania, aby ulepszyć chatboty, w tym systemy rozumowania.

|

Startup DeepSeek kiedyś wywołał sensację swoim modelem rozumowania, który charakteryzował się niższymi kosztami niż OpenAI. Zdjęcie: Bloomberg . |

Od zeszłego roku firmy takie jak OpenAI koncentrują się na technikach uczenia się przez wzmacnianie. Proces ten trwa zazwyczaj kilka miesięcy, w trakcie których sztuczna inteligencja uczy się zachowań metodą prób i błędów.

Na przykład, rozwiązując tysiące problemów, system może zidentyfikować optymalną metodę uzyskania poprawnej odpowiedzi. Na tej podstawie badacze opracowują zaawansowane mechanizmy sprzężenia zwrotnego, które pomagają systemowi odróżniać rozwiązania poprawne od niepoprawnych.

„To trochę jak tresura psa. Jeśli system działa dobrze, dajesz mu smakołyk. W przeciwnym razie mówisz: »Ten pies jest niegrzeczny«” – powiedział Jerry Tworek, badacz z OpenAI.

Czy sztuczna inteligencja jest przyszłością?

Według „New York Timesa” techniki uczenia się przez wzmacnianie są skuteczne w przypadku wymagań z matematyki, nauk ścisłych i programowania. Są to dziedziny, w których możliwe jest jednoznaczne zdefiniowanie poprawnych i niepoprawnych odpowiedzi.

Z drugiej strony, uczenie przez wzmacnianie jest nieskuteczne w pisaniu, filozofii czy etyce – dziedzinach, w których trudno odróżnić dobro od zła. Niemniej jednak naukowcy twierdzą, że ta technika nadal może poprawić wydajność sztucznej inteligencji, nawet w przypadku pytań niematematycznych.

„Systemy nauczą się ścieżek prowadzących do pozytywnych i negatywnych skutków” – powiedział Jared Kaplan, dyrektor naukowy w Anthropic.

|

Strona internetowa Anthropic, startupu będącego właścicielem modelu Claude AI. Zdjęcie: Bloomberg . |

Należy zauważyć, że uczenie przez wzmacnianie i systemy wnioskowania to dwa różne pojęcia. Dokładniej, uczenie przez wzmacnianie to metoda budowania systemów wnioskowania. Jest to ostatni etap szkolenia, który umożliwia chatbotom rozumowanie.

Ponieważ jest to wciąż stosunkowo nowa technologia, naukowcy nie są jeszcze pewni, czy rozumowanie chatbotów lub uczenie przez wzmacnianie (reinforcement learning) może pomóc sztucznej inteligencji myśleć jak ludzie. Należy zauważyć, że wiele obecnych trendów w uczeniu sztucznej inteligencji rozwija się bardzo szybko na początku, a następnie stopniowo zwalnia.

Co więcej, rozumowanie chatbota nadal może popełniać błędy. Bazując na prawdopodobieństwie, system wybierze proces, który najbardziej przypomina dane, które pozyskał, czy to z internetu, czy poprzez uczenie wzmacniające. W związku z tym chatboty nadal mogą wybierać niepoprawne lub nielogiczne rozwiązania.

Źródło: https://znews.vn/ai-ly-luan-nhu-the-nao-post1541477.html

Komentarz (0)