Jeśli kiedykolwiek przeglądałeś media społecznościowe, prawdopodobnie natknąłeś się na zdjęcia lub filmy stworzone przez sztuczną inteligencję. Wiele osób dało się nabrać, jak na przykład na viralowe wideo z królikami skaczącymi na trampolinie. Jednak Sora – siostrzana aplikacja ChatGPT opracowana przez OpenAI – przenosi wideo oparte na sztucznej inteligencji na nowy poziom, sprawiając, że wykrywanie fałszywych treści staje się coraz pilniejsze.

Narzędzia wideo oparte na sztucznej inteligencji sprawiają, że identyfikacja autentycznych filmów jest trudniejsza niż kiedykolwiek. (Źródło: CNET)

Aplikacja, wprowadzona na rynek w 2024 roku i niedawno ulepszona o Sora 2, ma interfejs podobny do TikToka, gdzie wszystkie filmy są generowane przez sztuczną inteligencję. Funkcja „cameo” pozwala na wstawianie prawdziwych osób do symulowanych ujęć, tworząc filmy o przerażającym realizmie.

W związku z tym wielu ekspertów obawia się, że Sora doprowadzi do rozprzestrzeniania się deepfake'ów, zniekształcając informacje i zacierając granice między rzeczywistością a fałszem. Szczególnie narażone są gwiazdy, co skłoniło organizacje takie jak SAG-AFTRA do apelu do OpenAI o wzmocnienie ochrony.

Identyfikacja treści generowanych przez sztuczną inteligencję to ogromne wyzwanie dla firm technologicznych, platform mediów społecznościowych i użytkowników. Istnieją jednak sposoby na rozpoznawanie filmów tworzonych za pomocą Sora.

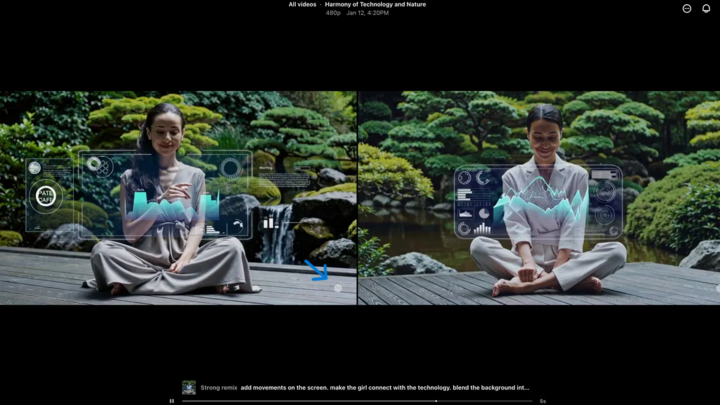

Znajdź znak wodny Sora

Znak wodny Sora (oznaczony niebieską strzałką) to znacznik identyfikujący narzędzie użyte do stworzenia filmu. (Źródło: CNET)

Każdy film stworzony w aplikacji Sora na iOS ma po pobraniu znak wodny – białe logo Sora (ikona chmury) porusza się wzdłuż krawędzi filmu, podobnie jak znak wodny TikToka.

To wizualny sposób identyfikacji treści generowanych przez sztuczną inteligencję. Na przykład model „nano-banana” Gemini firmy Google również automatycznie dodaje znak wodny do obrazów. Znaki wodne nie zawsze są jednak niezawodne. Jeśli znak wodny jest statyczny, można go łatwo wyciąć. Nawet dynamiczne znaki wodne, takie jak te w Sorze, można usunąć za pomocą specjalistycznych aplikacji.

Zapytany o to, prezes OpenAI, Sam Altman, argumentował, że społeczeństwo musi dostosować się do rzeczywistości, w której każdy może tworzyć fałszywe filmy. Przed Sorą nie istniało narzędzie, które byłoby tak popularne, dostępne i nie wymagałoby żadnych umiejętności do tworzenia takich filmów. Jego perspektywa podkreśla potrzebę polegania na alternatywnych metodach weryfikacji.

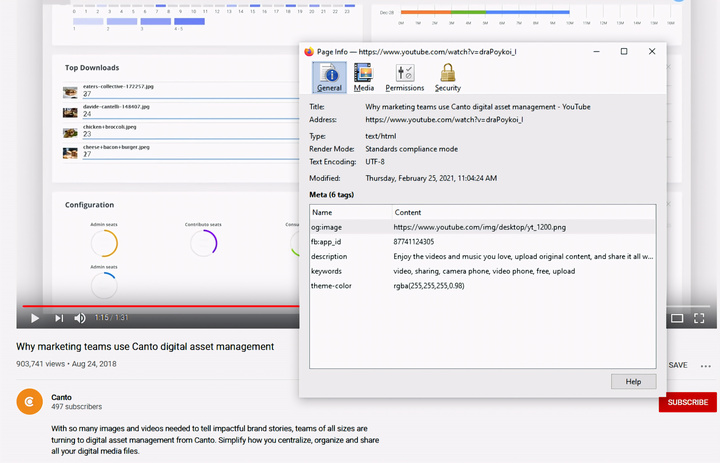

Sprawdź metadane

Sprawdzanie metadanych – kluczowy krok w ustaleniu, czy film został stworzony przez sztuczną inteligencję, taką jak Sora. (Źródło: Canto)

Można by pomyśleć, że sprawdzanie metadanych jest zbyt skomplikowane, ale tak naprawdę jest całkiem proste i bardzo skuteczne.

Metadane to zestaw informacji automatycznie dołączanych do treści w momencie ich tworzenia, takich jak typ kamery, lokalizacja, czas nagrania i nazwa pliku. Niezależnie od tego, czy treść jest generowana przez człowieka, czy przez sztuczną inteligencję, zawiera metadane. W przypadku treści generowanych przez sztuczną inteligencję metadane często zawierają informacje o źródle.

OpenAI jest członkiem Koalicji na rzecz Pochodzenia Treści i Autentyczności (C2PA), dlatego filmy Sora będą zawierać metadane C2PA. Możesz to zweryfikować za pomocą narzędzia weryfikacyjnego inicjatywy na rzecz autentyczności treści:

Jak sprawdzić metadane:

- Odwiedź verify.contentauthenticity.org

- Prześlij plik do sprawdzenia.

- Naciśnij „Otwórz”

- Zobacz informacje w tabeli po prawej stronie.

Jeśli film został stworzony przez sztuczną inteligencję, podsumowanie wyraźnie to zaznaczy. Podczas sprawdzania filmów Sora zobaczysz komunikat „opublikowano przez OpenAI” oraz informację potwierdzającą, że film został stworzony przy użyciu sztucznej inteligencji. Wszystkie filmy Sora muszą zawierać tę informację, aby zweryfikować ich pochodzenie.

Źródło: https://vtcnews.vn/cach-nhan-biet-video-that-hay-do-ai-tao-ar972891.html

![[Zdjęcie] Sekretarz generalny To Lam odwiedza przestrzeń wystawienniczą, w której prezentowane są książki, wystawy fotograficzne i osiągnięcia transformacji cyfrowej w dziennikarstwie.](/_next/image?url=https%3A%2F%2Fvphoto.vietnam.vn%2Fthumb%2F1200x675%2Fvietnam%2Fresource%2FIMAGE%2F2025%2F12%2F19%2F1766110879215_1766110240024-jpg.webp&w=3840&q=75)

Komentarz (0)