Pentru ca IA să devină cu adevărat o forță motrice pentru competitivitatea națională, cadrul juridic trebuie conceput atât pentru a controla riscurile, cât și pentru a promova inovația.

Nevoia unui cadru de guvernanță pentru IA

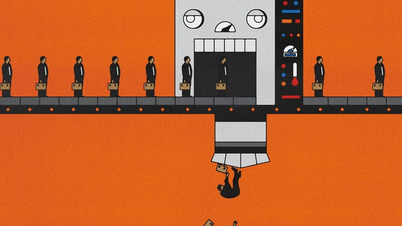

De la introducerea inteligenței artificiale (IA) în viață, granița dintre creativitatea umană și IA a devenit din ce în ce mai neclară, ceea ce face ca problema drepturilor de autor și a drepturilor de proprietate intelectuală să fie o nouă provocare juridică. Odată cu aceasta, construirea unui mecanism de gestionare a riscurilor în crearea și exploatarea produselor create de IA a devenit, de asemenea, urgentă, pentru a se asigura că tehnologia servește scopurilor corecte și intereselor umane.

Datele de antrenament ale inteligenței artificiale și problema drepturilor de autor

Una dintre problemele importante care trebuie reglementate prin lege este utilizarea datelor pentru antrenarea inteligenței artificiale. Aceasta este fundamentul sistemelor de inteligență artificială pentru a învăța, a procesa informații și a crea produse noi, dar este și sursa multor controverse atunci când datele de antrenament pot include opere literare, muzică , imagini, presă sau produse creative deținute de persoane fizice și organizații. Fără reglementări clare, această activitate poate duce cu ușurință la încălcarea drepturilor de autor, la încălcarea drepturilor creatorilor și poate cauza consecințe juridice și etice.

În ceea ce privește practica protecției drepturilor de autor, avocata Nguyen Thi Thu Hien, de la BIHACO Trading and Media Services Joint Stock Company, a declarat că, în prezent, multe sisteme de inteligență artificială sunt antrenate prin scanarea și copierea automată a datelor de pe internet, colectând milioane de lucrări fără permisiune sau fără plata autorilor. Au avut loc mai multe procese internaționale, când companiile de inteligență artificială au fost acuzate că au folosit ilegal datele autorilor pentru a antrena modele de inteligență artificială. În Vietnam, deși nu au existat procese, încălcările se produc pe scară largă.

Multe startup-uri au colectat conținut din articole, bloguri, cărți electronice și au construit chatbot-uri vietnameze fără permisiune, afectând drepturile autorului.

Multe startup-uri au colectat conținutul articolelor, blogurilor, cărților electronice și au construit chatboți vietnamezi fără permisiune, afectând drepturile autorilor. Un exemplu comun îl reprezintă chatboții care pot rezuma și reproduce conținutul operelor... astfel încât utilizatorii nu trebuie să cumpere cărți și ziare, ceea ce duce la pierderea veniturilor autorilor și la exploatarea operelor în mod necontrolat. O melodie poate fi folosită pentru a antrena inteligența artificială să compună muzică, din care inteligența artificială creează muzică de fundal gratuită care concurează cu muzica protejată prin drepturi de autor. Potrivit avocatei Nguyen Thi Thu Hien, actuala Lege a Proprietății Intelectuale nu este compatibilă cu provocarea reprezentată de inteligența artificială în problema drepturilor de autor ale inteligenței artificiale, riscul de litigii fiind foarte mare, așa că este nevoie de reglementări pentru protejarea drepturilor de autor, precum și pentru promovarea acestei noi tehnologii.

Maestrul Vuong Tuyet Linh de la Universitatea Bancară din Ho Chi Minh City a mai spus că explozia numărului de opere complexe create de inteligența artificială reprezintă o mare provocare pentru cadrul legal privind drepturile de autor. Prin urmare, este necesară o perspectivă profundă și academică asupra acestei probleme pentru a umple golul legal, asigurând armonia dintre tehnologie și lege.

În procesul de elaborare a Legii de modificare și completare a Legii privind proprietatea intelectuală, au existat opinii care au sugerat că exploatarea datelor protejate prin drepturi de autor și drepturi conexe pentru instruirea în domeniul inteligenței artificiale ar trebui permisă fără permisiune, iar acest caz se încadrează la limitarea și excepția de drepturi. De asemenea, au existat opinii conform cărora ar trebui solicitată permisiunea și efectuată plata atunci când datele protejate prin drepturi de autor sunt utilizate pentru instruirea în domeniul inteligenței artificiale. Cu toate acestea, dacă va fi implementată, problema ar fi: care unitate ar trebui să plătească taxa corespunzătoare, dezvoltatorul modelului de inteligență artificială, furnizorul aplicației sau utilizatorul final? Aceasta este o problemă dificilă care necesită coordonare și clarificare în mecanismul de gestionare al autorităților competente.

IA extinde creativitatea umană

Cea mai importantă parte a ciclului de viață al IA este modul în care aceasta este operată pentru a servi oamenii. Prin urmare, este nevoie de un coridor juridic care să ghideze guvernanța și dezvoltarea responsabilă a IA.

Potrivit experților, riscurile sistemelor de inteligență artificială nu se datorează doar erorilor tehnice, ci și utilizării și gestionării necontrolate. Un model de inteligență artificială poate crea erori de date, erori algoritmice și poate lua decizii automate care afectează sănătatea umană, ocuparea forței de muncă sau confidențialitatea. Atunci când sunt integrate în domenii precum finanțele, asistența medicală, educația sau mass-media, aceste riscuri pot crește de multe ori dacă nu sunt monitorizate din timp. Prin urmare, este necesar să se stabilească un mecanism de evaluare, clasificare și control al riscurilor pe parcursul întregului ciclu de viață al inteligenței artificiale, pentru a asigura siguranța socială și încrederea utilizatorilor.

De fapt, viteza de aplicare a inteligenței artificiale în Vietnam se dezvoltă foarte rapid, demonstrând nevoia urgentă de o direcție clară și un cadru de guvernanță. În 2024, aproximativ 47.000 de întreprinderi vietnameze vor începe să aplice inteligența artificială, echivalentul a peste 5 întreprinderi pe oră, aducând numărul total de întreprinderi care aplică inteligența artificială la aproape 170.000, reprezentând aproximativ 18% din numărul total de întreprinderi din țară. În același timp, piața chatbot-urilor vietnameze prezintă, de asemenea, un potențial și o creștere puternică. În 2024, valoarea pieței chatbot-urilor a atins aproximativ 31,2 milioane USD și se preconizează că va crește la 207,1 milioane USD până în 2033, cu o rată compusă de creștere (CAGR) de 18,5%. Atunci când întreprinderile intră pentru prima dată în domeniul inteligenței artificiale, acestea încep adesea cu chatbot-uri sau instrumente interactive inteligente.

De fapt, viteza de aplicare a inteligenței artificiale în Vietnam se produce foarte rapid, demonstrând nevoia urgentă de o direcție clară și un cadru de guvernanță.

Prin urmare, potrivit dnei Tran Vu Ha Minh (FPT Software Company), statul ar trebui să emită în curând linii directoare specifice privind implementarea chatbot-urilor și a instrumentelor de bază ale inteligenței artificiale pentru a respecta cerințele privind transparența, protecția datelor și responsabilitatea. Pentru proiectele cu risc ridicat sau cheie, ar trebui să existe politici și standarde detaliate, astfel încât întreprinderile să le poată implementa cu încredere, fără a-și face griji cu privire la barierele juridice sau tehnice.

Proiectul de Lege privind Inteligența Artificială a stipulat o serie de obligații pentru părțile care furnizează și implementează sisteme de IA cu risc ridicat, cum ar fi menținerea unui sistem de gestionare a riscurilor pe tot parcursul ciclului de viață al sistemului, efectuarea unei monitorizări continue și reevaluarea nivelului de risc al sistemului, precum și existența unui mecanism tehnic pentru înregistrarea automată a jurnalelor de activitate. Atunci când apare un incident, autoritatea competentă solicită furnizorului sau implementării să furnizeze jurnalele de activitate pentru a determina cauza, a stabili responsabilitatea și a servi drept bază pentru despăgubirea daunelor.

Potrivit avocatei Nguyen Tuan Linh, de la firma internațională de avocatură BMVN, este necesar să se clasifice riscurile în funcție de scopul utilizării, nu să fie asociate cu tehnologia subiacentă. Evaluarea riscurilor ar trebui să se bazeze pe criterii clare, obiective și în conformitate cu standardele internaționale; dacă se dau definiții prea largi cu privire la clasificarea riscurilor, acest lucru poate împiedica dezvoltarea tehnologiilor de inteligență artificială care nu sunt susceptibile de a provoca daune.

(Va fi continuat)

Sursă: https://nhandan.vn/bao-ve-ban-quyen-trong-ky-nguyen-ai-bai-1-post921923.html

![[Foto] Prim-ministrul Pham Minh Chinh participă la Forumul anual de afaceri din Vietnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762780307172_dsc-1710-jpg.webp)

![[Foto] Prim-ministrul Pham Minh Chinh participă la Congresul de Emulație Patriotică al Ministerului Afacerilor Externe pentru perioada 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762762603245_dsc-1428-jpg.webp)

![Tranziția Dong Nai OCOP: [Articolul 3] Legarea turismului cu consumul de produse OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Comentariu (0)