Cum funcționează imaginile false cu inteligență artificială?

IA este peste tot în zilele noastre – chiar și în război. Aplicațiile inteligenței artificiale s-au îmbunătățit atât de mult anul acesta încât aproape oricine poate folosi generatoare de IA pentru a crea imagini care arată realist, cel puțin la prima vedere.

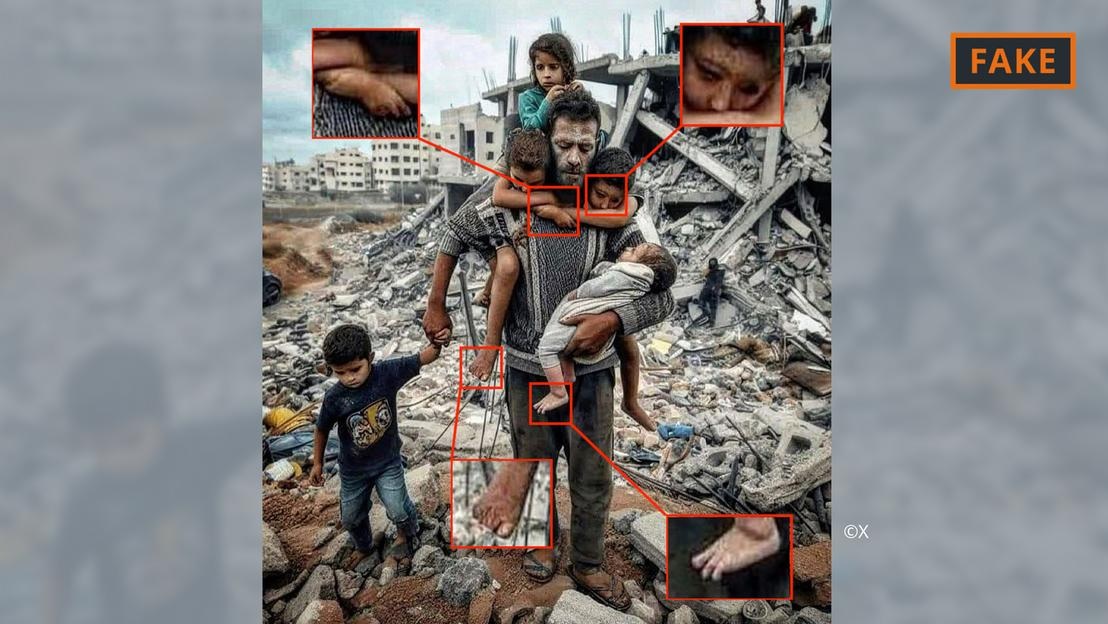

O fotografie falsă a războiului din Gaza, generată de inteligența artificială.

Utilizatorii pur și simplu furnizează instrumente precum Midjourney sau Dall-E cu câteva instrucțiuni, inclusiv specificații și informații, pentru a face acest lucru. Instrumentele de inteligență artificială convertesc apoi instrucțiunile textuale sau chiar vocale în imagini.

Acest proces de generare a imaginilor se bazează pe ceea ce se numește învățare automată. De exemplu, dacă un creator solicită să arate un bărbat de 70 de ani mergând pe bicicletă, acesta va căuta în baza sa de date pentru a potrivi termenii cu imaginile.

Pe baza informațiilor disponibile, algoritmul de inteligență artificială va genera o imagine a ciclistului în vârstă. Cu tot mai multe informații și actualizări tehnice, aceste instrumente s-au îmbunătățit considerabil și sunt în continuă dezvoltare.

Toate acestea sunt aplicate imaginilor legate de conflictul din Orientul Mijlociu. Într-un conflict în care „emoțiile sunt atât de puternice”, dezinformarea, inclusiv răspândirea prin intermediul imaginilor cu inteligență artificială, are un impact uriaș, spune expertul în inteligență artificială Hany Farid.

Farid, profesor de analiză digitală la Universitatea din California, Berkeley, a declarat că luptele aprige sunt terenul perfect pentru crearea și diseminarea de conținut fals, precum și pentru alimentarea emoțiilor.

Tipuri de imagini cu inteligență artificială ale războiului Israel-Hamas

Imaginile și videoclipurile create cu ajutorul inteligenței artificiale au alimentat dezinformarea legată de războiul din Ucraina, iar acest lucru continuă să se întâmple și în războiul dintre Israel și Hamas.

Potrivit experților, imaginile despre război realizate cu inteligență artificială care circulă pe rețelele de socializare se împart adesea în două categorii. Una se concentrează pe suferința oamenilor și evocă simpatie. Cealaltă este reprezentată de inteligența artificială falsă, care exagerează evenimentele, incitând astfel la conflicte și escaladând violența.

Fotografie falsă, generată de inteligența artificială, cu un tată și un copil în dărâmăturile din Gaza.

De exemplu, prima categorie include fotografia de mai sus, cu un tată și cei cinci copii ai săi în fața unui morman de moloz. A fost distribuită de mai multe ori pe X (fostul Twitter) și Instagram și vizualizată de sute de mii de ori.

Această imagine a fost semnalată de comunitate, cel puțin pe X, ca fiind falsă. Poate fi recunoscută după diverse erori și inconsecvențe comune imaginilor realizate cu inteligență artificială (vezi imaginea de mai sus).

Anomalii similare pot fi observate și în imaginea falsă realizată de inteligența artificială, devenită virală pe X, de mai jos, care pretinde că arată o familie palestiniană mâncând împreună pe ruine.

Fotografie falsă a unui partid palestinian, generată de inteligența artificială.

Între timp, o altă imagine care înfățișează soldați fluturând steaguri israeliene în timp ce trec printr-o așezare plină de case bombardate se încadrează în a doua categorie, menită să incite la ură și violență.

De unde provin astfel de imagini realizate de inteligența artificială?

Majoritatea imaginilor conflictuale generate de inteligența artificială sunt postate pe platformele de socializare, dar sunt disponibile și pe o serie de alte platforme și organizații și chiar pe unele site-uri de știri.

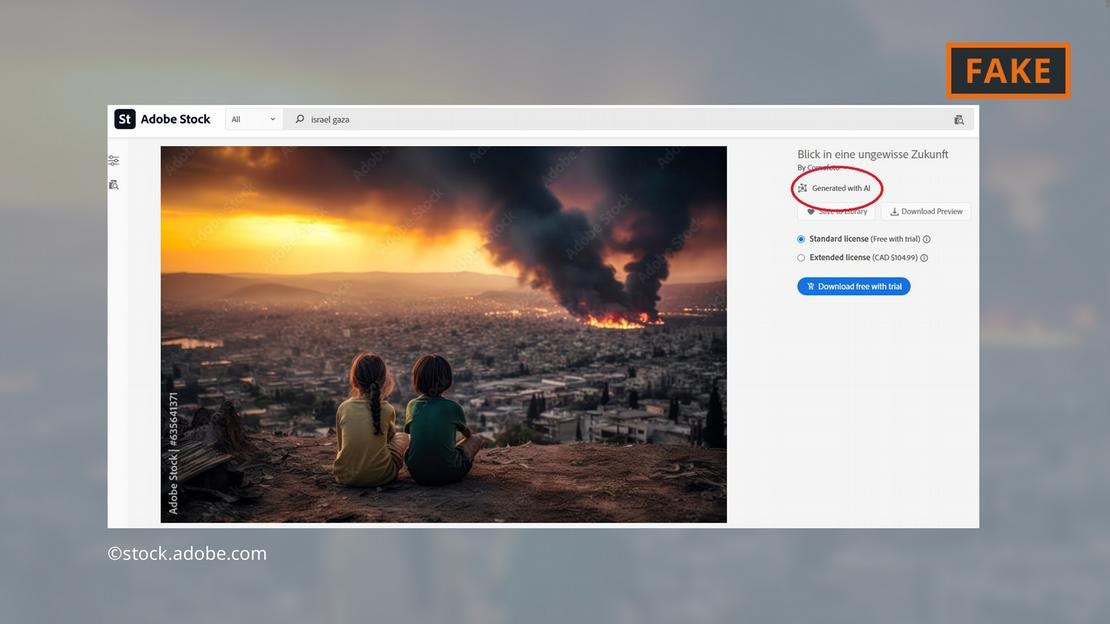

Compania de software Adobe a făcut furori prin adăugarea de imagini generate de inteligență artificială la gama sa de fotografii de stoc până la sfârșitul anului 2022. Acestea vor fi etichetate corespunzător în baza de date.

Adobe oferă acum spre vânzare și imagini realizate cu inteligență artificială din războiul din Orientul Mijlociu — cum ar fi explozii, oameni care protestează sau nori de fum în spatele Moscheii Al-Aqsa.

Adobe oferă imagini generate de inteligența artificială ale luptelor din Gaza.

Criticii au considerat acest lucru îngrijorător, deoarece unele site-uri au continuat să utilizeze imaginile fără a le eticheta ca fiind generate de inteligența artificială. Imaginea în cauză, de exemplu, a apărut pe pagina „Newsbreak” fără nicio indicație că ar fi fost generată de inteligența artificială.

Chiar și Serviciul de Cercetare al Parlamentului European, ramura științifică a Parlamentului European, a ilustrat un text online despre conflictul din Orientul Mijlociu cu o imagine generată de inteligența artificială din baza de date Adobe — fără a o eticheta ca fiind generată de inteligența artificială.

Observatorul European al Media Digitală îndeamnă jurnaliștii și profesioniștii din mass-media să fie extrem de atenți atunci când utilizează imagini bazate pe inteligență artificială, sfătuind împotriva utilizării acestora, în special atunci când relatează despre evenimente din viața reală, cum ar fi războiul din Gaza.

Cât de periculoase sunt imaginile realizate cu inteligență artificială?

Conținutul și imaginile virale generate de inteligența artificială vor crea cu siguranță neliniște utilizatorilor în legătură cu tot ceea ce întâlnesc online. „Dacă intrăm în această lume în care imaginile, sunetul și videoclipurile pot fi manipulate , totul devine suspect”, explică cercetătorul Farid de la UC Berkeley. „Așadar, pierdem încrederea în orice, inclusiv în adevăr.”

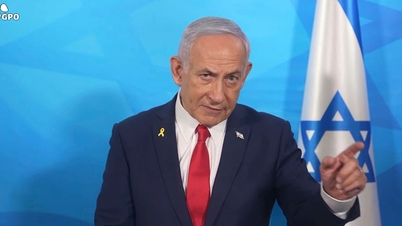

Exact asta s-a întâmplat în următorul caz: o imagine cu ceea ce se crede a fi cadavrul carbonizat al unui bebeluș israelian a fost distribuită pe rețelele de socializare de către prim-ministrul israelian Benjamin Netanyahu și alți câțiva politicieni.

Un influencer anti-Israel, Jackson Hinkle, a susținut ulterior că imaginea a fost creată folosind inteligența artificială. Declarația lui Hinkle a fost vizualizată de peste 20 de milioane de ori pe rețelele de socializare și a dus la dezbateri aprinse pe platformă.

În cele din urmă, numeroase organizații și instrumente de verificare au declarat că imaginea era reală, iar afirmația lui Hinkle era falsă. Cu toate acestea, este clar că niciun instrument nu poate ajuta utilizatorii să-și recâștige cu ușurință încrederea pierdută!

Hoang Hai (conform DW)

Sursă

![[Foto] Prim-ministrul Pham Minh Chinh inspectează și coordonează lucrările de depășire a consecințelor inundațiilor de după furtuna din Thai Nguyen](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/08/1759930075451_dsc-9441-jpg.webp)

![[Foto] Prim-ministrul Pham Minh Chinh participă la Congresul Mondial al Federației Internaționale a Asociațiilor de Expeditori de Mărfuri și Transport - FIATA](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/08/1759936077106_dsc-0434-jpg.webp)

Comentariu (0)