(CLO) Instrumentul de conversie a vorbirii în text Whisper de la OpenAI este promovat ca fiind „robust și precis la nivel aproape uman”, dar are un dezavantaj major: este predispus la fabricarea de fragmente de text sau chiar propoziții întregi!

Unele dintre textele pe care le fabrică, cunoscute în industrie drept halucinante, pot include comentarii rasiale, violență și chiar tratamente medicale imaginare, spun experții.

Experții spun că astfel de invenții sunt grave, deoarece Whisper este utilizat în multe industrii din întreaga lume pentru a traduce și transcrie interviuri, a genera text și a subtitra videoclipuri.

Mai îngrijorător este faptul că centrele medicale folosesc instrumente bazate pe Whisper pentru a înregistra consultațiile dintre pacienți și medici, în ciuda avertismentului OpenAI că instrumentul nu ar trebui utilizat în „zone cu risc ridicat”.

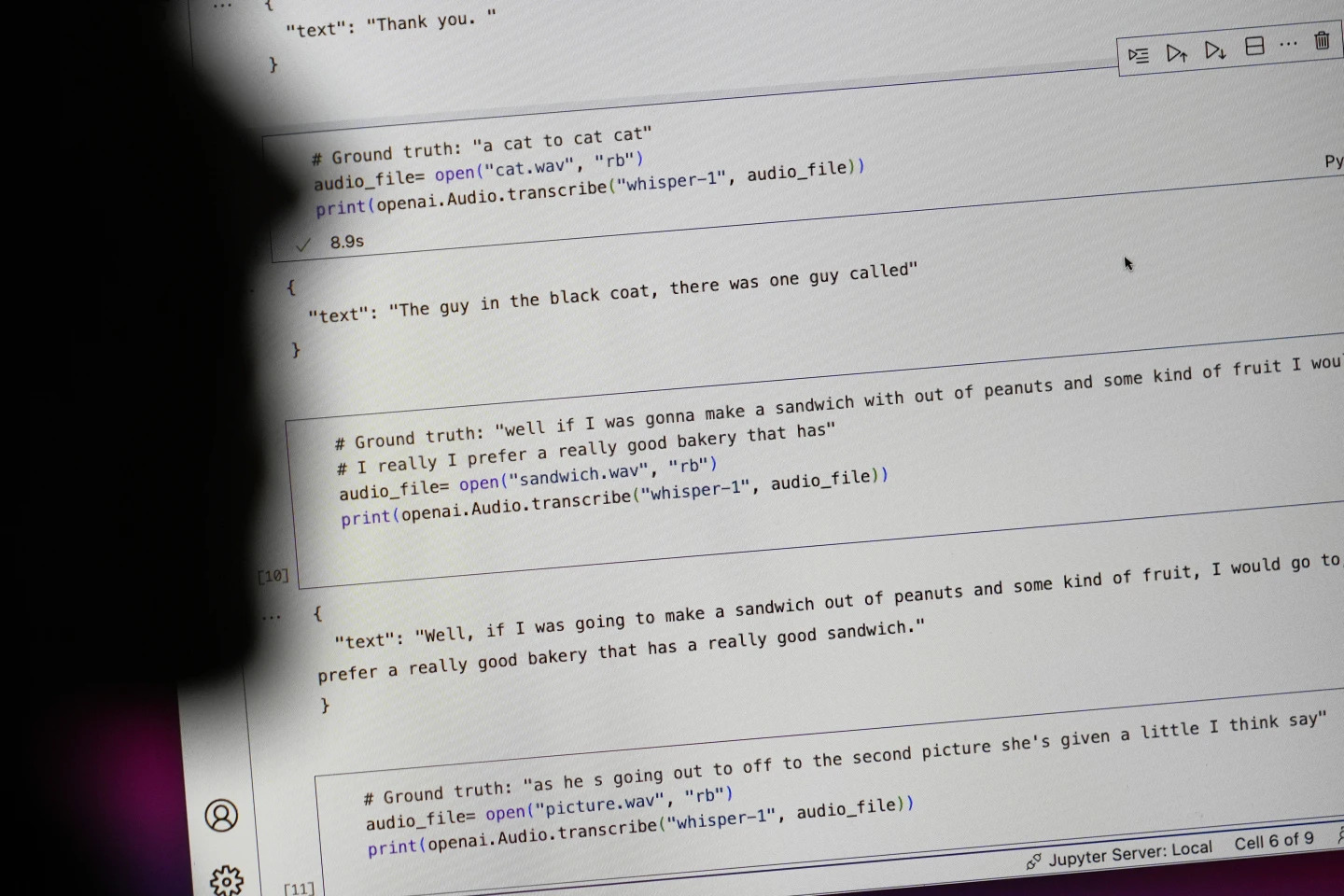

Propozițiile care încep cu „#Adevărul de la bază” sunt ceea ce a fost spus de fapt, propozițiile care încep cu „#text” sunt ceea ce a transcris Whisper. Foto: AP

Cercetătorii și inginerii spun că Whisper produce frecvent halucinații în timpul utilizării. De exemplu, un cercetător de la Universitatea din Michigan a declarat că a găsit halucinații în opt din zece înregistrări pe care le-a examinat.

Un inginer de la începuturile programului de învățare automată a descoperit manipulări în aproximativ jumătate din cele peste 100 de ore de transcrieri Whisper pe care le-a analizat. Un al treilea dezvoltator a declarat că a găsit halucinații în aproape fiecare dintre cele 26.000 de transcrieri create cu Whisper.

Iluzia persistă chiar și în mostre audio scurte și bine înregistrate. Un studiu recent realizat de informaticieni a descoperit 187 de distorsiuni în peste 13.000 de clipuri audio clare pe care le-au examinat.

Această tendință ar duce la zeci de mii de erori în milioane de înregistrări, au spus cercetătorii.

Astfel de greșeli pot avea „consecințe foarte grave”, mai ales într-un mediu spitalicesc, a declarat Alondra Nelson, profesoară la Școala de Științe Sociale din cadrul Institutului pentru Studii Avansate.

„Nimeni nu vrea să fie diagnosticat greșit. Trebuie să existe o barieră mai mare”, a spus Nelson.

Profesoarele Allison Koenecke de la Universitatea Cornell și Mona Sloane de la Universitatea din Virginia au examinat mii de fragmente scurte pe care le-au recuperat de la TalkBank, o arhivă de cercetare găzduită la Universitatea Carnegie Mellon. Ele au stabilit că aproape 40% dintre halucinații erau dăunătoare sau tulburătoare, deoarece vorbitorul putea fi înțeles greșit sau reprezentat greșit.

Într-o înregistrare, un vorbitor a descris „alte două fete și o femeie”, dar Whisper a inventat comentarii rasiale suplimentare, adăugând „alte două fete și o femeie, ăăă, care era de culoare”.

Într-o altă transcriere, Whisper a inventat un medicament inexistent numit „antibiotice cu activitate crescută”.

Deși majoritatea dezvoltatorilor recunosc că instrumentele de transcriere pot face greșeli de ortografie sau alte erori, inginerii și cercetătorii spun că nu au văzut niciodată un instrument de transcriere bazat pe inteligență artificială la fel de halucinogen precum Whisper.

Instrumentul este integrat în mai multe versiuni ale chatbot-ului emblematic al OpenAI, ChatGPT, și este un serviciu integrat în platforma de cloud computing a Oracle și Microsoft, deservind mii de companii din întreaga lume. De asemenea, este utilizat pentru a transcrie și traduce text în multe limbi.

Ngoc Anh (conform AP)

Sursă: https://www.congluan.vn/cong-cu-chuyen-giong-noi-thanh-van-ban-ai-cung-co-the-xuyen-tac-post319008.html

![[Foto] Prim-ministrul Pham Minh Chinh participă la Congresul de Emulație Patriotică al Ministerului Afacerilor Externe pentru perioada 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762762603245_dsc-1428-jpg.webp)

![[Foto] Prim-ministrul Pham Minh Chinh participă la Forumul anual de afaceri din Vietnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762780307172_dsc-1710-jpg.webp)

![Tranziția Dong Nai OCOP: [Articolul 3] Legarea turismului cu consumul de produse OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Comentariu (0)