Un grup de experți internaționali proeminenți s-a întâlnit săptămâna trecută la Beijing, unde a identificat „linii roșii” în dezvoltarea inteligenței artificiale, inclusiv crearea de arme biologice și efectuarea de atacuri cibernetice.

Într-o declarație emisă la câteva zile după întâlnire, cadrele universitare au avertizat că este necesară o abordare comună a siguranței inteligenței artificiale pentru a preveni „riscuri catastrofale sau chiar existențiale pentru umanitate în timpul vieții noastre”.

„În culmea Războiului Rece, cooperarea internațională între guverne și știință a contribuit la prevenirea catastrofei nucleare. Omenirea trebuie să lucreze din nou împreună pentru a preveni catastrofa care ar putea apărea din cauza unei tehnologii fără precedent”, se arată în declarație.

Experții de la Dialogul Internațional privind Siguranța Inteligenței Artificiale (IA) de la Beijing au identificat „linii roșii” în dezvoltarea IA. Foto: FT

Printre semnatari se numără Geoffrey Hinton și Yoshua Bengio, adesea descriși drept „părinții” inteligenței artificiale; Stuart Russell, profesor de informatică la Universitatea din California; și Andrew Yao, unul dintre cei mai proeminenți informaticieni din China.

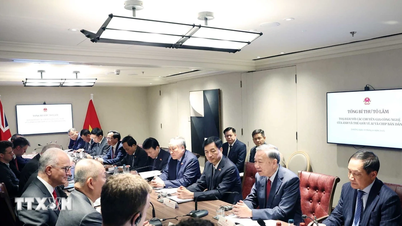

Declarația vine după Dialogul Internațional privind Siguranța Inteligenței Artificiale (IA) de săptămâna trecută de la Beijing, o întâlnire la care au participat oficiali ai guvernului chinez pentru a-și exprima aprobarea față de forum și rezultatele acestuia.

Președintele american Joe Biden și președintele chinez Xi Jinping s-au întâlnit în noiembrie anul trecut și au discutat despre siguranța inteligenței artificiale, convenind să inițieze un dialog pe această temă. Companiile globale de inteligență artificială de top s-au întâlnit, de asemenea, în privat cu experți chinezi în domeniul inteligenței artificiale în ultimele luni.

În noiembrie 2023, 28 de țări, inclusiv China, și companii de top din domeniul inteligenței artificiale au convenit asupra unui angajament amplu de a colabora pentru a aborda riscurile existențiale care decurg din inteligența artificială avansată, în cadrul summitului privind siguranța inteligenței artificiale susținut de cancelarul britanic Rishi Sunak.

Săptămâna trecută, la Beijing, experții au discutat despre amenințările asociate cu dezvoltarea „Inteligenței Artificiale Generale – AGI”, sau a sistemelor de IA egale sau superioare celor umane.

„Punctul central al discuției a fost reprezentat de liniile roșii pe care niciun sistem puternic de inteligență artificială nu ar trebui să le depășească și pe care guvernele din întreaga lume ar trebui să le impună în dezvoltarea și implementarea inteligenței artificiale”, a declarat Bengio.

Aceste linii roșii ar garanta că „niciun sistem de inteligență artificială nu se poate reproduce sau îmbunătăți fără consimțământul și sprijinul explicit al oamenilor” sau „nu poate întreprinde acțiuni care îi sporesc în mod nejustificat puterea și influența”.

Oamenii de știință au adăugat că niciun sistem nu ar „spori semnificativ capacitatea actorilor de a proiecta arme de distrugere în masă, de a încălca convenția privind armele biologice sau chimice” sau de a „efectua automat atacuri cibernetice care duc la pierderi financiare grave sau daune echivalente”.

Hoang Hai (conform FT)

Sursă

![[Foto] Prim-ministrul Pham Minh Chinh participă la Forumul anual de afaceri din Vietnam](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762780307172_dsc-1710-jpg.webp)

![[Foto] Prim-ministrul Pham Minh Chinh participă la Congresul de Emulație Patriotică al Ministerului Afacerilor Externe pentru perioada 2025-2030](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/11/10/1762762603245_dsc-1428-jpg.webp)

![Tranziția Dong Nai OCOP: [Articolul 3] Legarea turismului cu consumul de produse OCOP](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/11/10/1762739199309_1324-2740-7_n-162543_981.jpeg)

Comentariu (0)